【广义S变换】一维广义S变换对非平稳信号处理的matlab仿真

1.软件版本matlab2013b2.本算法理论知识参考文献:《广义S变换时频分析的应用研究》《时频分布与地震信号谱分析研究》《非平稳信号广义S不变换及其在SAR图像分析中的应用研究》《S变换时变滤波在去噪处理中的应用研究》《广义S变换域时频特征分析及微弱目标检测方法研究》《广义S变换及其时频滤波》

人工智能-作业4:CNN - 卷积

真有意思啊!!

Python学习笔记(3):numpy模块

一、numpy库库的名称:numpy作用:numpy是一个非常有用的三方库,支持大量的维度数组和矩阵计算,提供大量数学函数导入方法:在命令行里输入:pip install numpy然后可以在代码中导入使用了import numpy as np二、功能总结1. array()作用:构建一个数组类型的

强化学习PPO代码讲解

查看代码对于算法的理解直观重要,这使得你的知识不止停留在概念的层面,而是深入到应用层面。代码采用了简单易懂的强化学习库PARL,对新手十分友好。

强化学习基础记录

强化学习Actor-Critic记录

Python第三方库推荐:pyttsx3

今天要推荐的Python第三方库命名为“pyttsx3”。pyttsx3是一个语音库,通过调用此库,很容易就可以让程序“开口说话”,不仅增强了程序的交互性,还能够给人以一种亲切感。pyttsx3库简单易用,是新手的好选择。安装pyttsx3 安装这一步骤应该不用多说了,进入cmd,输入:pip

强化学习基础记录

强化学习DQN

时间序列统计特征的详细解析

根据对已有时间序列比赛的统计研究,发现数据规模不大的比赛任务中,依然使用的是特征工程+梯度提升树模型。而且特征工程依然是重中之重。所以特意换了一些时间对特征工程进行了详细的总结。主要包括两大类,一类是常用的(大家都使用的)基本特征,还有一类是Top选手使用的高级特征。为了方便比赛选手学习,将其概念

PyTorch学习笔记(十)——GoogLeNet

目录一、GoogLeNet 简介二、Inception 块三、GoogLeNet 架构四、训练/测试 GoogLeNet附录:完整代码一、GoogLeNet 简介GoogLeNet 吸收了 NiN 中串联网络的思想,并在此基础上做了改进。GoogLeNet 的一个观点是,有时使用不同大小的卷积核的组

Keras深度学习实战(8)——房价预测

在本节中,我们介绍了神经网络的实际应用,使用 Boston 房价数据集,通过尝试预测房屋的价格来研究连续输出问题,并介绍了如何在网络训练过程中使用自定义损失函数。

【人工智能】计算机视觉之OpenCV学习详解一

文章目录一,前言二,OpenCV安装三,实战学习3.1,色彩处理3.2,裁剪提取3.3,图像绘制四,源码五,后言一,前言看准这个方向很久了,今天开始和Java,Go一起推进学习。不求多,每天学习一点点。二,OpenCV安装作为Python选手的我,当然选择了Python语言来学习OpenCV。编译器

多层感知机还在进步,关于深度学习中MLP的5篇最新的论文推荐

2002年最新的5篇MLP论文推荐

数学建模学习(65):零基础学会使用SVM支持向量机分类

支持向量机SVM分类教程

Python验证码识别和生成(5000字详细实例和概念讲解)

哈喽O(∩_∩)O:.,,.-:*``*:-.,,.-:*``*:╭╧╮ ╭╧╮╭╧╮ ╭╧╮║周║║末║║快║║乐║└﹏┘└﹏┘└﹏┘└﹏┘** * * * * * * * * * * *╒╧╕ ╒╧╕ ╒╧╕ ╒╧╕ ╒╧╕|財||招||吉||大||閣||源||財||祥||吉||家||廣||進

基于STM32+华为云IOT设计智能称重系统

选择部署多个重量传感器和必要的算法、通过WIFF通信模块、GPS定位模块,采集车辆重数据一地理位置信息,并通过网络发送至云平台,设计图形化UI界面展示称重、地图位置等重要信息,实现对称重系统的远程监测。

笔记:基于keras的不同神经网络模型Minst手写体识别

基于keras不同神经网络模型的mnist手写体识别

TensorFlow简单使用(基础篇)

目录一、TensorFlow的数据类型二、如何创建一个张量三、常用函数1.强制转换、最大值、最小值2.平均值、求和3.标记为可训练4.四则运算5.平方、次方与开方6.矩阵相乘7.输入特征和标签配对8.求出张量的梯度9.枚举函数10.独热编码11.概率转换函数12.自更新函数13.最大值索引函数我们为

来聊聊三维重建?

2021年,对于中国而言,可以算是实景三维的元年,自然资源部发布《实景三维中国建设技术大纲(2021版)》,各地实景三维项目建设进入新高潮,对于测绘人而言,这算是一件大事,这似乎意味着,摄影测量进入了全新的实景三维重建阶段。2022年3月,自然资源部办公厅发布《关于全面推进实景三维中国建设的通知》,

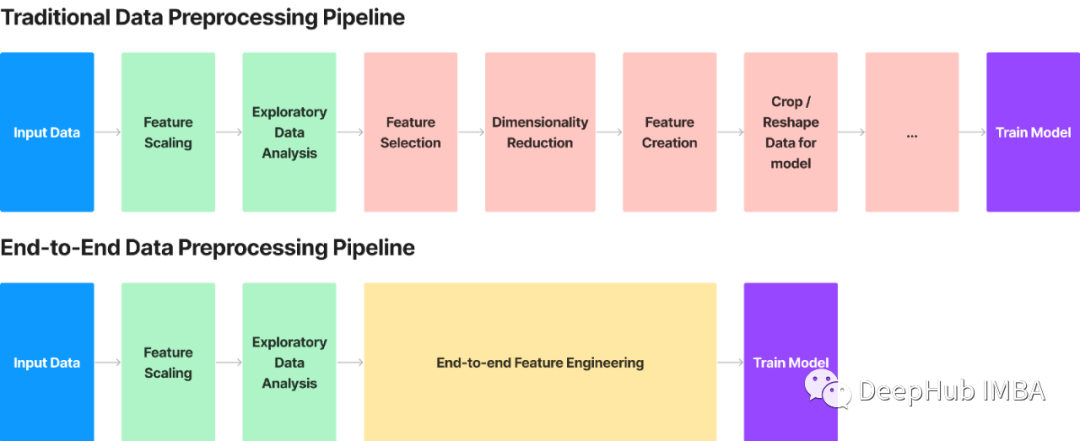

端到端的特征转换示例:使用三元组损失和 CNN 进行特征提取和转换

通过卷积和三元组损失学习数据的表示,并提出了一种端到端的特征转换方法,这种使用无监督卷积的方法简化并应用于各种数据。