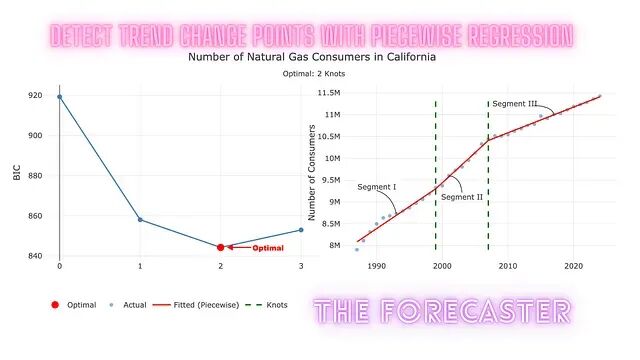

基于网格搜索与分段回归的时间序列变化点检测方法

传统统计方法在时间序列分析中既简洁又有力,但面对大规模时间序列集合时,扩展性往往不尽如人意。现实中的趋势变化往往微弱、带有噪声、数量也不止一个,靠肉眼判断既不可靠也不现实。

Python标准库里藏着的7个代码简化利器

开始使用它们之后,项目体积缩小了,维护成本降低了,自动化也顺畅得多。以下是改变一切的七个技巧。

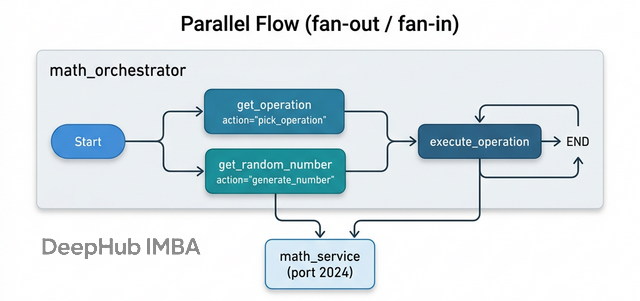

LangGraph RemoteGraph:本地图与远程图的组合机制解析

本地编排器负责流程控制,远程图服务器承担具体计算,状态管理和控制流的职责边界清晰。

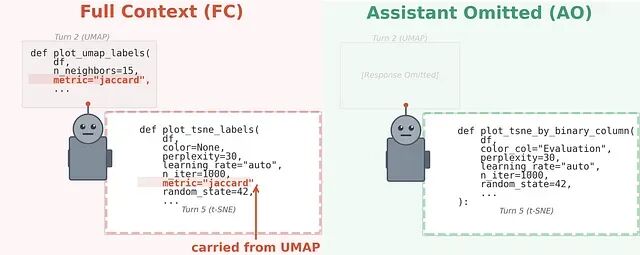

MIT论文解读:LLM 会被自身历史回复拖累 ,上下文污染会导致多轮对话质量衰减

和 AI 对话超过 20 轮之后,看着它慢慢开始胡说八道,如果有过这种经历,那么你就应该看看这篇论文

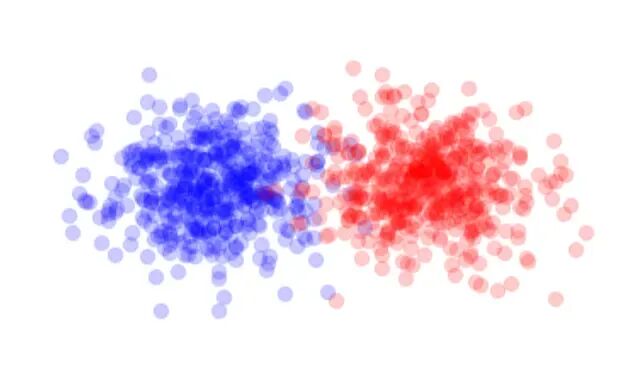

Energy Distance:度量两个多元分布差异的统计方法

Energy Distance 是一种基于度量的统计工具,适用于衡量两个多元分布的差异程度。

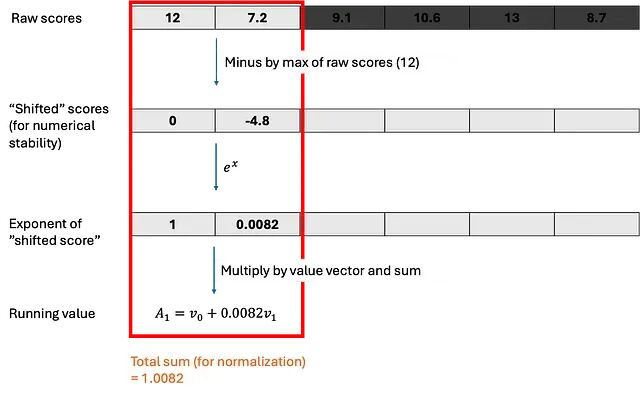

大模型训练的硬件基础:GPU内存层级、分块与并行策略

这篇文章从 GPU 架构讲到并行策略,涉及的是把模型从玩具规模拉到生产规模所必须面对的工程问题。

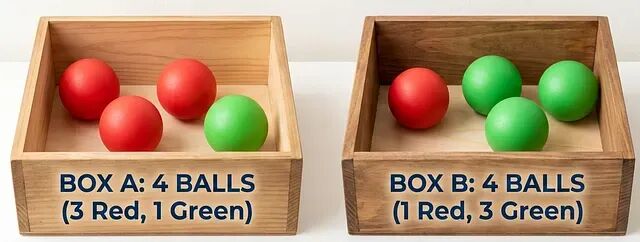

贝叶斯公式推导:从联合概率的对称性看条件反转

本文从简单概率的概念出发,逐步过渡到条件概率,最后介绍贝叶斯定理。整个过程会尽量保持直观,不涉及复杂的数学形式。

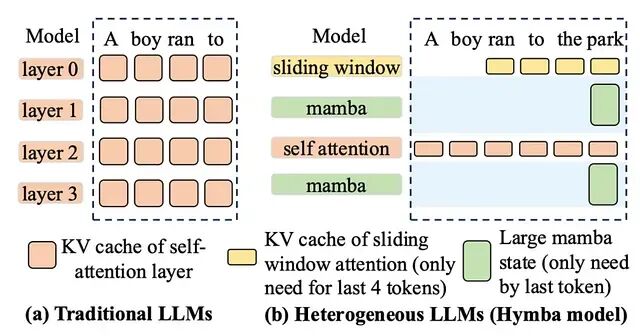

KV Cache管理架构演进:从连续分配到统一混合内存架构

本文梳理KV cache管理经历的5个时代,从它根本不存在的阶段,到今天正在成型的统一内存架构。文中会结合多个模型的部署经验,对比vLLM、SGLang和TensorRT-LLM在各阶段的应对思路。

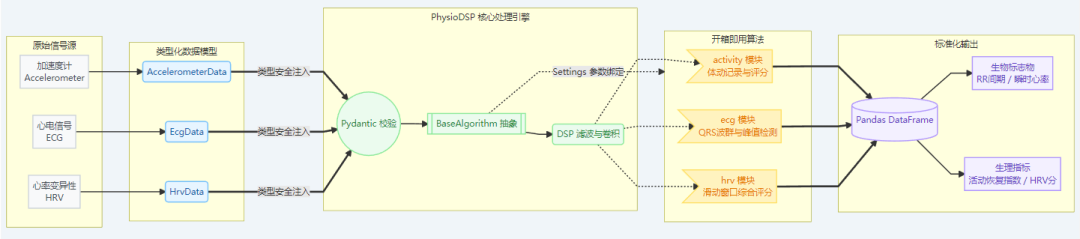

PhysioDSP:一个面向可穿戴设备的 Python 信号处理库

PhysioDSP 是一个开源 Python 库,它给出了一套统一、可扩展的框架来处理和分析生理传感器数据

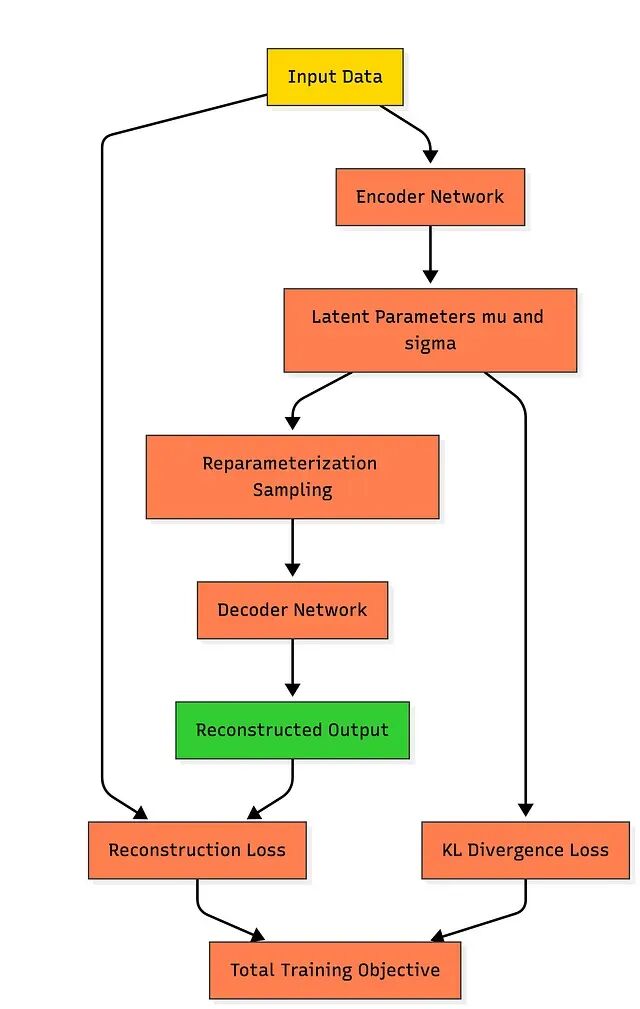

VAE 原理拆解:从概率编码到潜在空间正则化

这篇文章从基本原理出发完整拆解变分自编码器(VAE)的构建过程。

基于能量的模型(EBM):用能量函数替代概率分布的建模框架

Yann LeCun 反复强调过一个观点:当前LLM基于概率、逐 Token 预测的设计路线,很可能走不到人类水平的AI。他的团队更看好另一条路,基于能量的模型(EBM)。

时间序列异常检测的5种方法:从统计阈值到深度学习

异常检测的核心不在于找出"奇怪的数字",而在于理解每个时间点上什么才算正常。

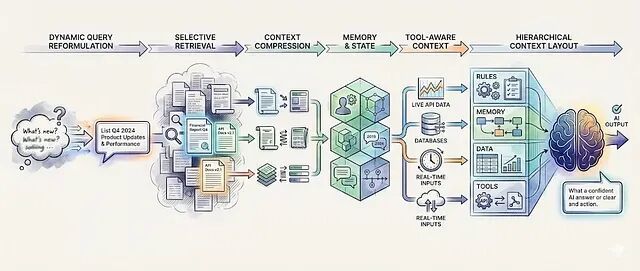

从提示工程转向 上下文工程,6种让LLM在生产环境中稳定输出的技术

提示工程告诉模型怎么说话;context engineering 控制模型说话时看到什么。以下是把生产系统和Demo区分开的6种上下文工程技术。

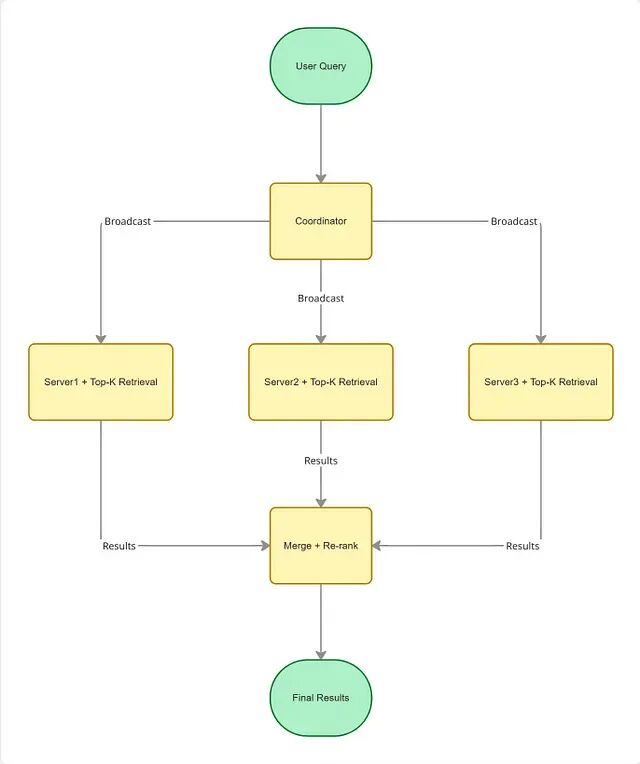

向量搜索系统的三个核心优化维度:速度、精度与规模

向量搜索把信息检索从字面匹配带进了语义理解的时代。但光有 Embedding 还不够,真正让系统在生产环境中跑起来的是背后的工程优化

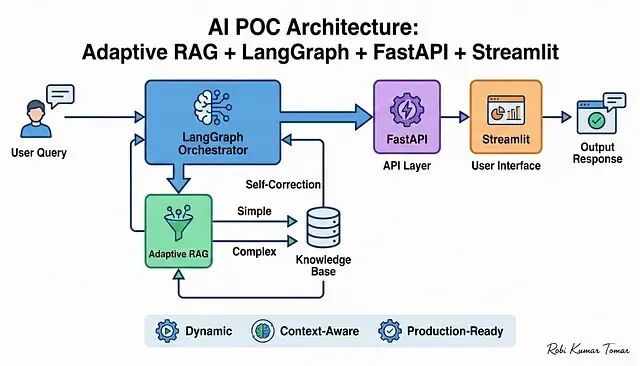

手把手搭建 Adaptive RAG 系统:从向量检索到 Streamlit 前端全流程

本文会带你从零搭建一个完整的概念验证项目(POC),技术栈涵盖 Adaptive RAG、LangGraph、FastAPI 和 Streamlit 四个核心组件。

深入理解三种PEFT方法:LoRA的低秩更新、QLoRA的4位量化与DoRA的幅度-方向分解

三种方法各有分工,互为补充,你唯一需要考虑的是哪种 PEFT 方案最贴合自己的硬件条件和精度要求。

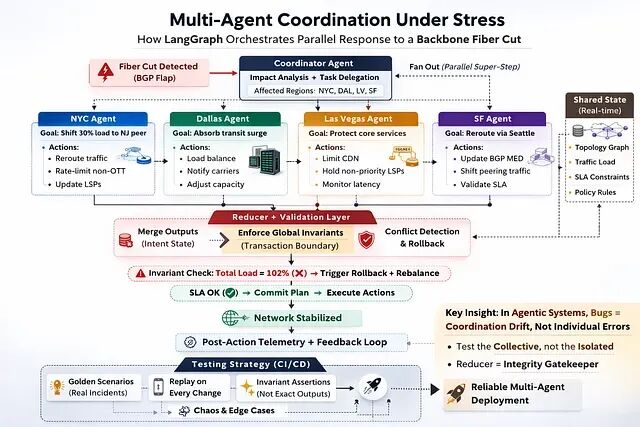

并行多智能体系统的协调测试实战:从轨迹捕获到CI/CD的六个步骤

传统软件里bug 是逻辑错误。代码做了不该做的事;并行智能体系统里的 bug 往往以另一种形态出现:协调漂移。

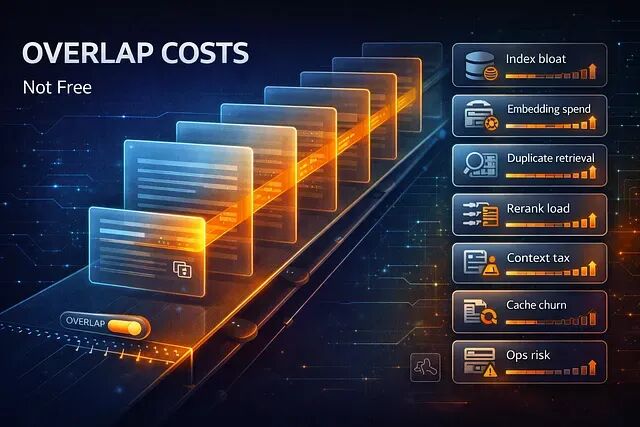

RAG 中分块重叠的 8 个隐性开销与权衡策略

本文将总结的八项 RAG 分块重叠隐藏的成本,以及如何判断什么时候重叠真正有用,什么时候只是花钱买心安。

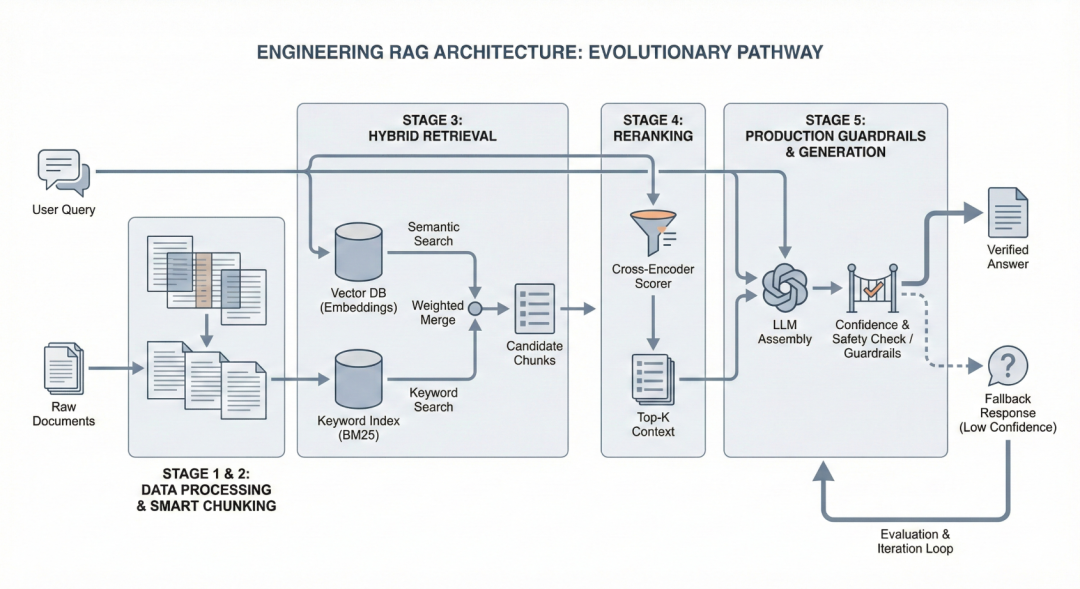

深入RAG架构:分块策略、混合检索与重排序的工程实现

从 Level 1 开始。记录并监控系统在哪翻车,搞清楚原因之后再往上走。 这才是构建一个真正能用的RAG系统的路径。