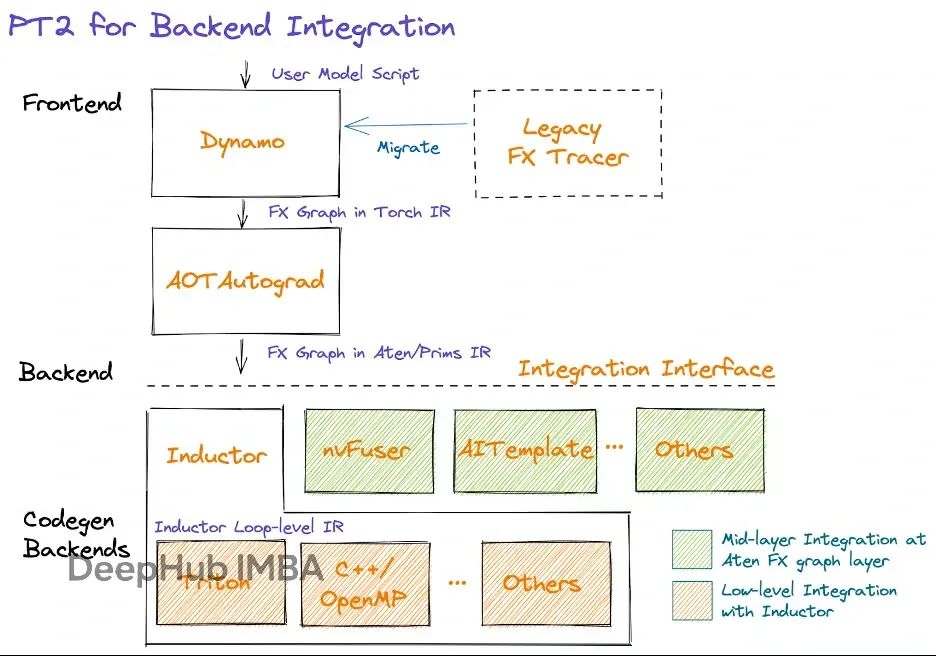

torch.compile 加速原理:kernel 融合与缓冲区复用

torch.compile 的价值在于:它把原本需要手写 CUDA 或 Triton 才能实现的优化,封装成了一行代码的事情。

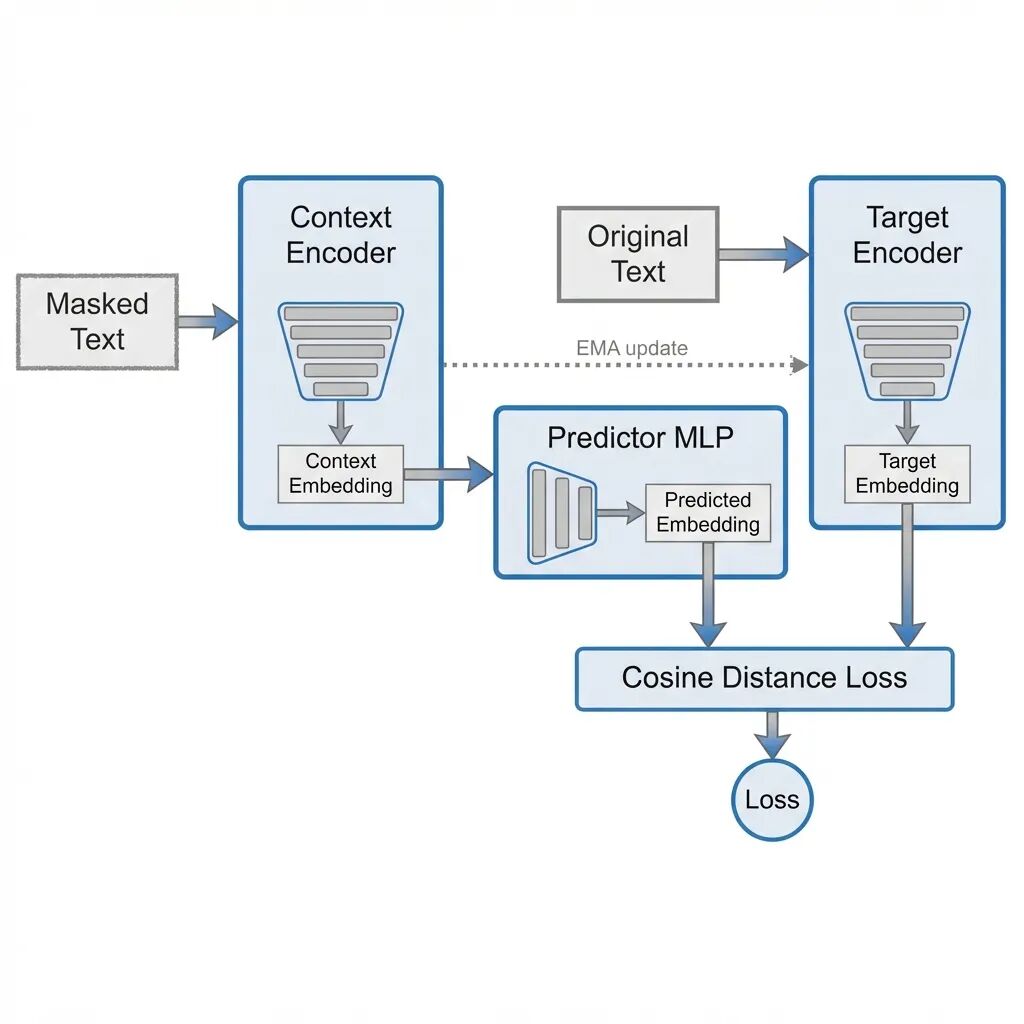

用 PyTorch 实现 LLM-JEPA:不预测 token,预测嵌入

这篇文章从头实现 LLM-JEPA: Large Language Models Meet Joint Embedding Predictive Architectures。

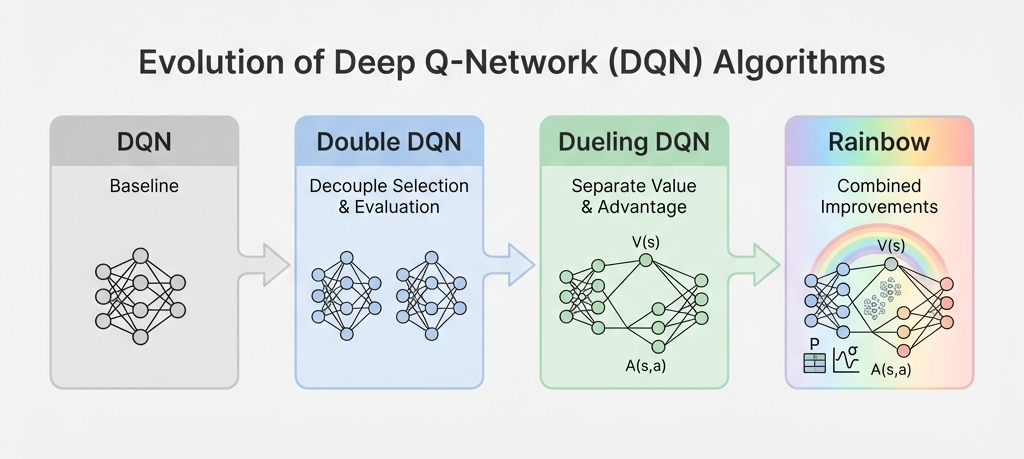

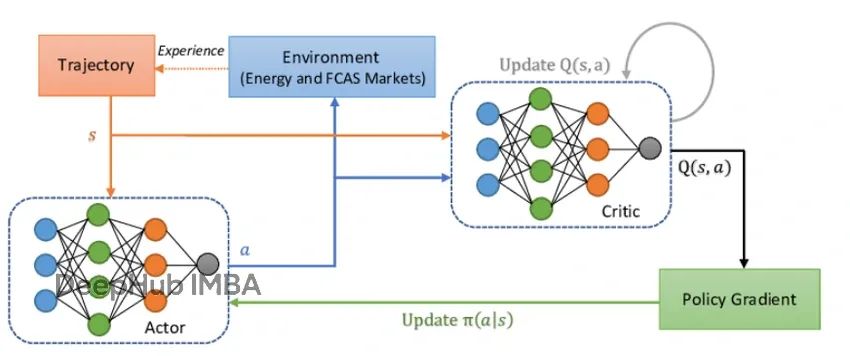

让 Q 值估计更准确:从 DQN 到 Double DQN 的改进方案

这篇文章要内容包括:DQN 为什么会过估计、Double DQN 怎么把动作选择和评估拆开、Dueling DQN 怎么分离状态值和动作优势、优先经验回放如何让采样更聪明,

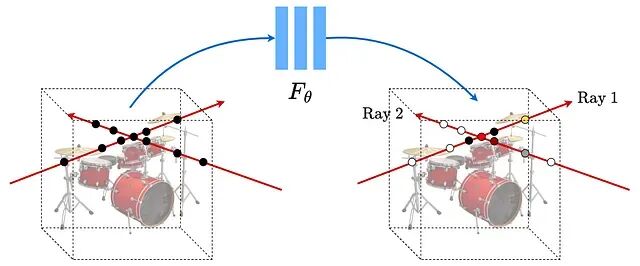

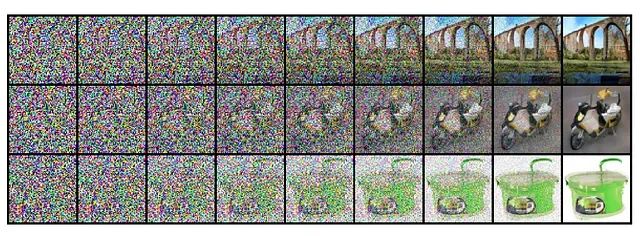

神经辐射场NeRF入门:3D视图合成的原理与PyTorch代码实现

NeRF(Neural Radiance Fields,神经辐射场)的核心思路是用一个全连接网络表示三维场景。

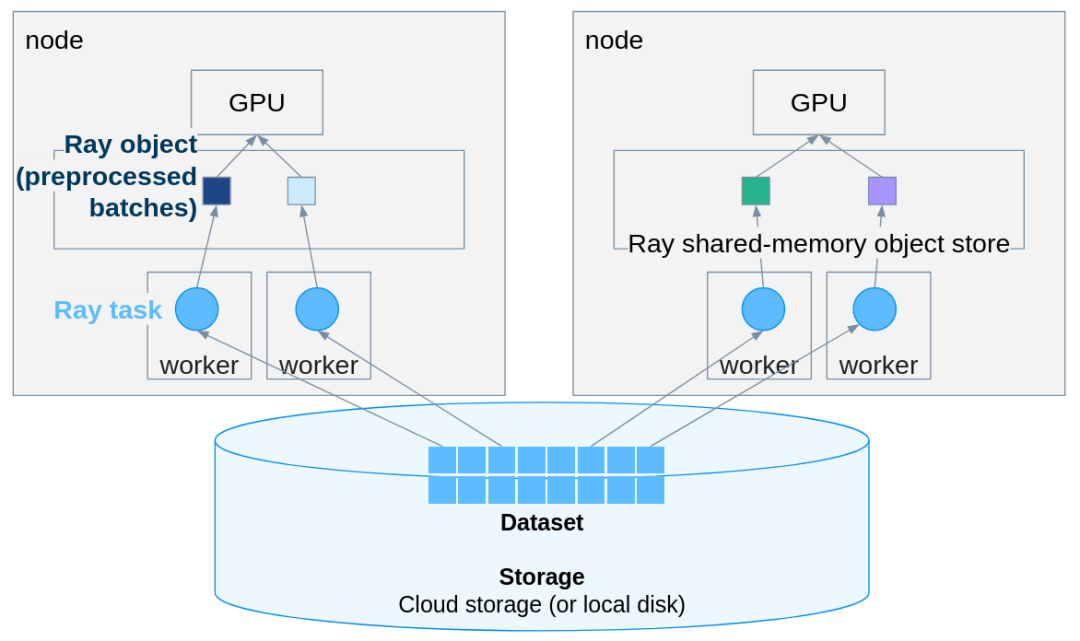

PyTorch推理扩展实战:用Ray Data轻松实现多机多卡并行

Ray Data 在几乎不改动原有 PyTorch 代码的前提下,把单机推理扩展成分布式 pipeline。

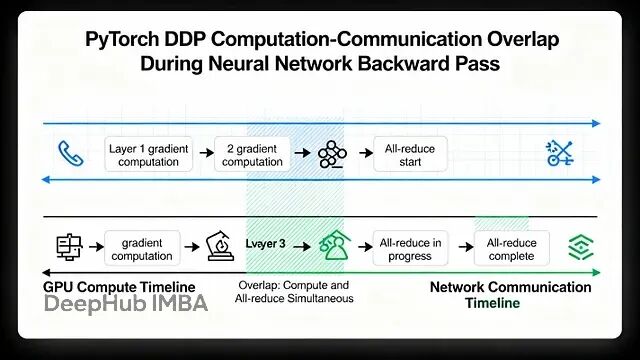

PyTorch 分布式训练底层原理与 DDP 实战指南

本文讲详细探讨Pytorch的数据并行(Data Parallelism)

从零实现3D Gaussian Splatting:完整渲染流程的PyTorch代码详解

这篇文章我们用纯PyTorch实现了3D Gaussian Splatting的完整渲染pipeline,代码量控制在几百行以内。

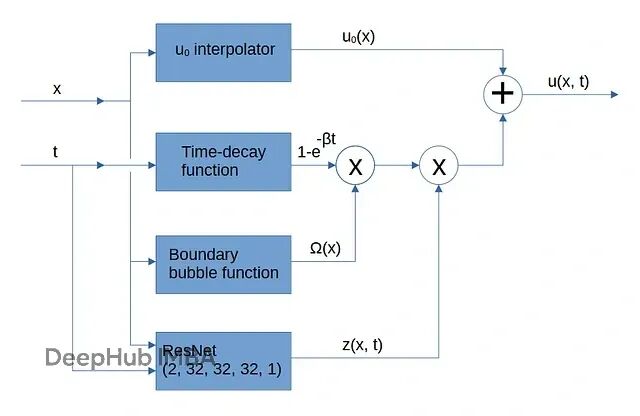

PINN训练新思路:把初始条件和边界约束嵌入网络架构,解决多目标优化难题

PINNs出了名的难训练。主要原因之一就是这个**多目标优化**问题。优化器很容易找到投机取巧的路径

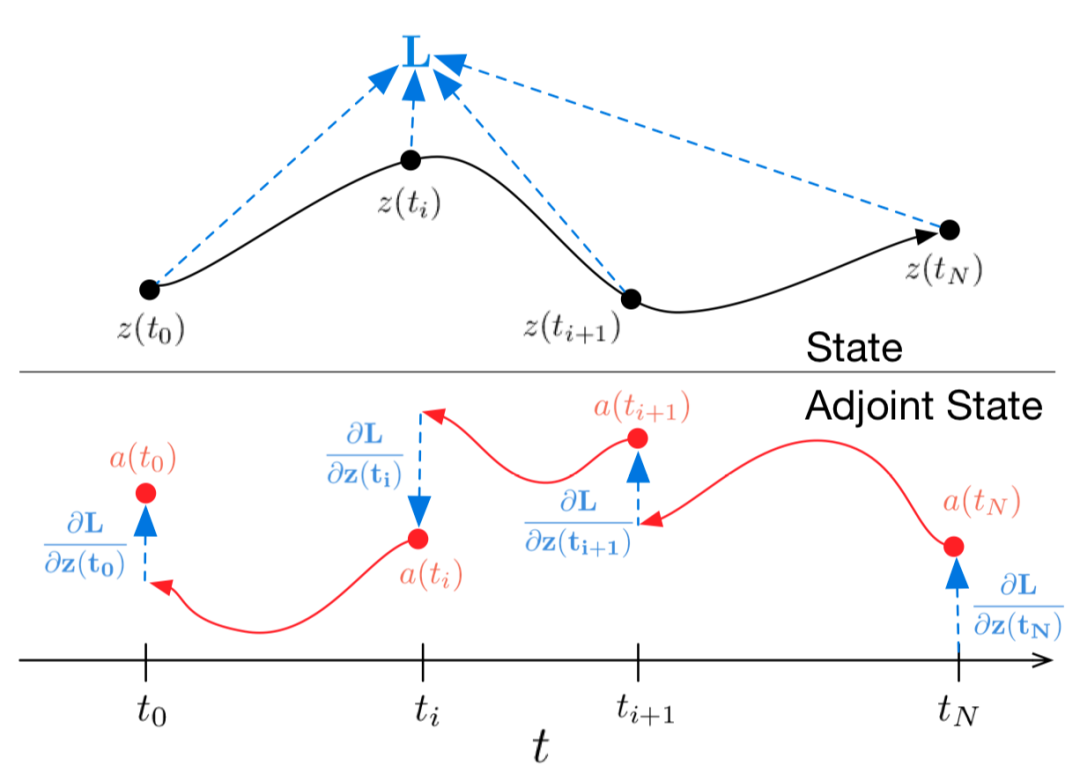

Neural ODE原理与PyTorch实现:深度学习模型的自适应深度调节

文章详细介绍了从基础ODE概念到PyTorch实现的完整流程,并通过捕食者-猎物生态系统案例展示了其在时间序列预测中的应用优势。这种连续化思维为处理物理、生物、金融等领域的动态系统提供了新的建模范式。

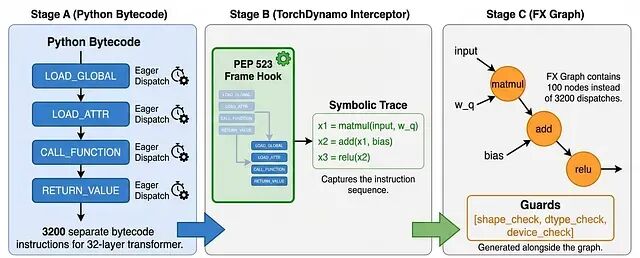

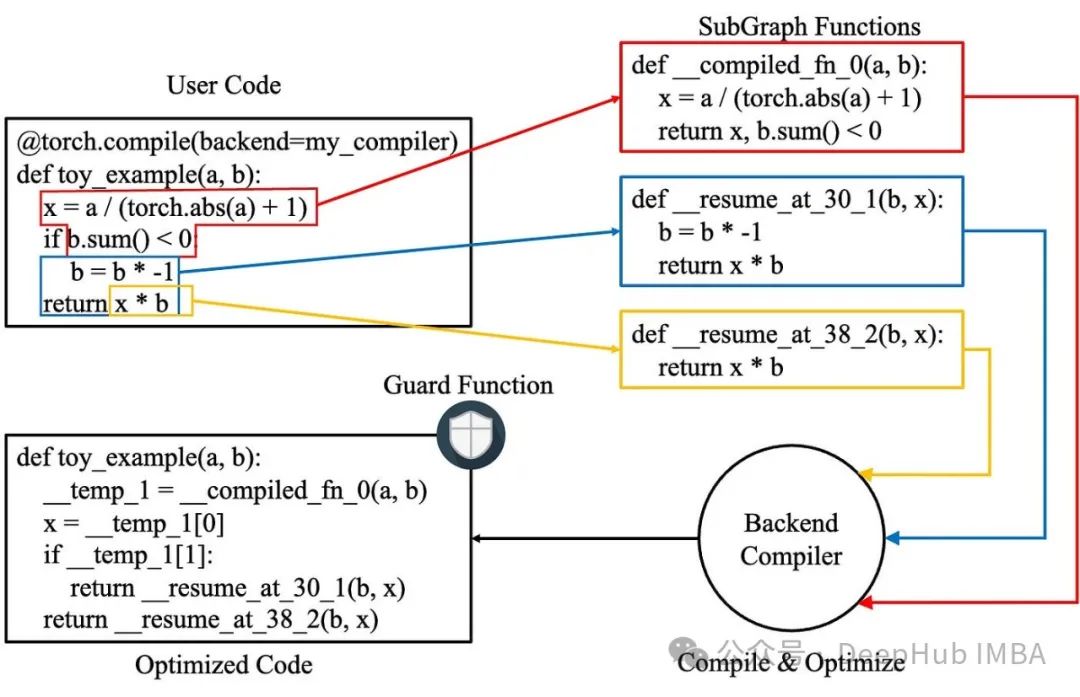

PyTorch 2.0性能优化实战:4种常见代码错误严重拖慢模型

我们将深入探讨图中断(graph breaks)和多图问题对性能的负面影响,并分析PyTorch模型开发中应当避免的常见错误模式。

近端策略优化算法PPO的核心概念和PyTorch实现详解

本文提供了PPO算法的完整PyTorch实现方案,涵盖了从理论基础到实际应用的全流程。

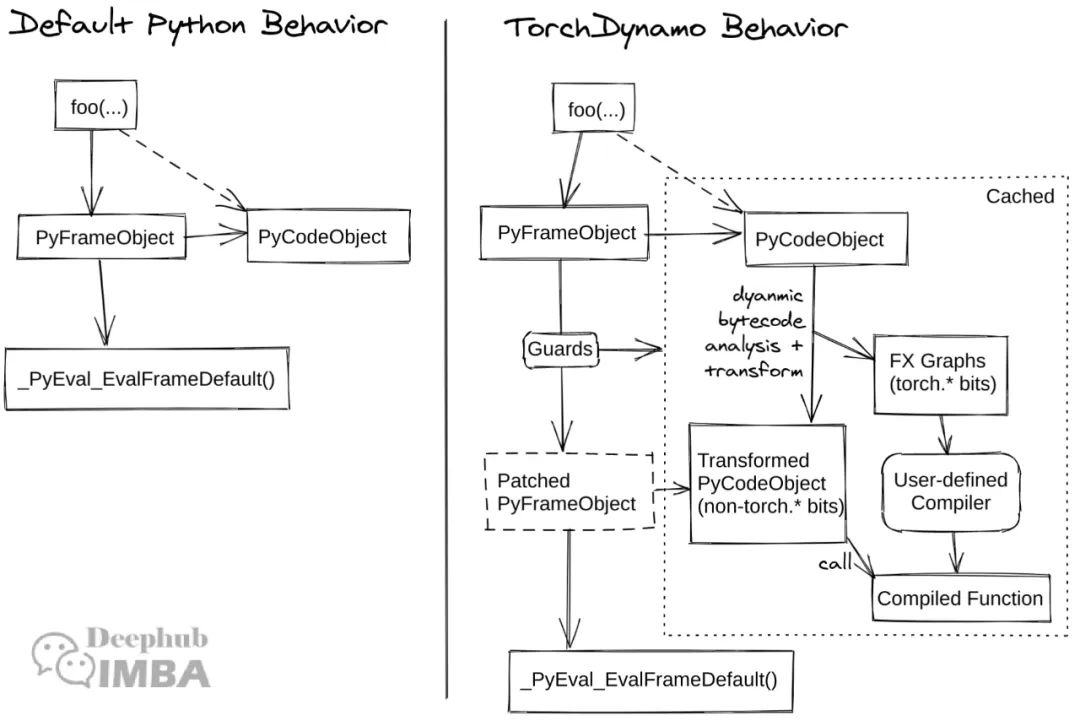

TorchDynamo源码解析:从字节码拦截到性能优化的设计与实践

本文深入解析PyTorch中TorchDynamo的核心架构和实现机制,通过PyTorch源码分析和关键文件导览,为开发者提供在Dynamo基础上设计扩展功能或新特性的技术指南。

Flow Matching生成模型:从理论基础到Pytorch代码实现

本文将系统阐述Flow Matching的完整实现过程,包括数学理论推导、模型架构设计、训练流程构建以及速度场学习等关键组件。通过本文的学习,读者将掌握Flow Matching的核心原理,获得一个完整的PyTorch实现

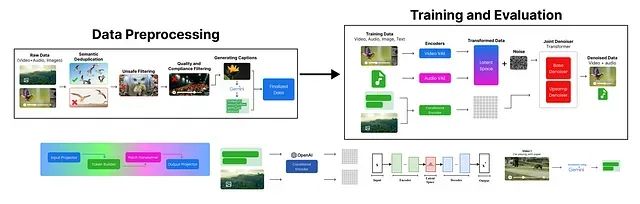

从零复现Google Veo 3:从数据预处理到视频生成的完整Python代码实现指南

本文详细介绍了一个简化版 Veo 3 文本到视频生成模型的构建过程。首先进行了数据预处理,涵盖了去重、不安全内容过滤、质量合规性检查以及数据标注等环节。

SnapViewer:解决PyTorch官方内存工具卡死问题,实现高效可视化

SnapViewer项目通过重新设计数据处理流水线和渲染架构,成功解决了PyTorch官方内存可视化工具的性能瓶颈问题。

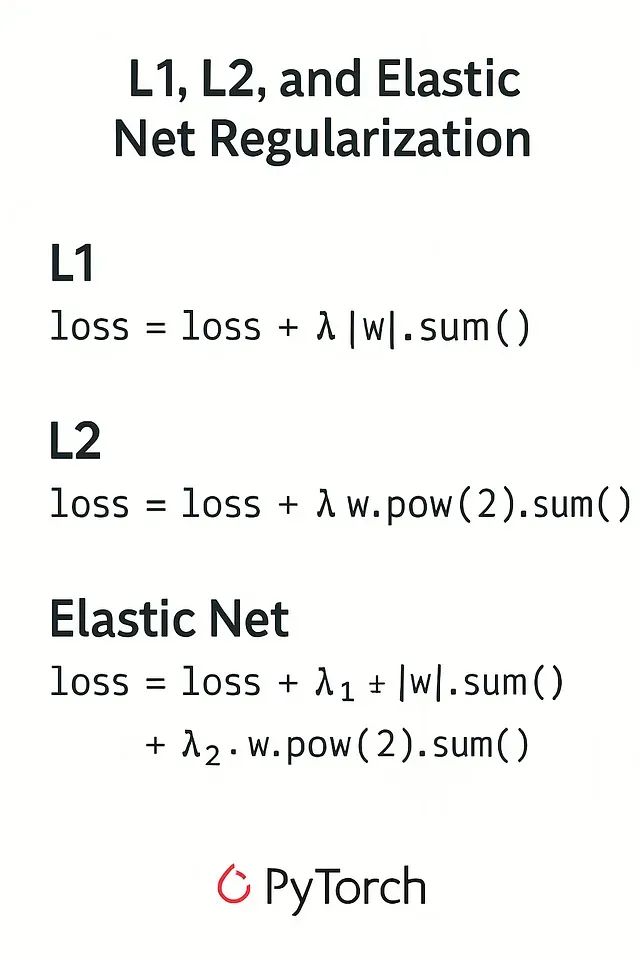

提升模型泛化能力:PyTorch的L1、L2、ElasticNet正则化技术深度解析与代码实现

本文将深入探讨L1、L2和ElasticNet正则化技术,重点关注其在PyTorch框架中的具体实现。关于这些技术的理论基础,建议读者参考相关理论文献以获得更深入的理解。

深入解析torch.compile:提升PyTorch模型性能、高效解决常见问题

torch.compile为PyTorch用户提供了强大的性能优化工具,但在实际应用中仍需谨慎处理各种潜在问题。通过系统化的调试策略、深入的组件分析和针对性的优化措施,用户可以有效提升模型性能并解决常见问题。

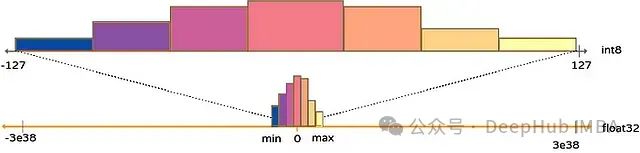

PyTorch量化感知训练技术:模型压缩与高精度边缘部署实践

本文将深入探讨模型量化的原理、主要量化技术类型以及如何使用PyTorch实现这些技术。