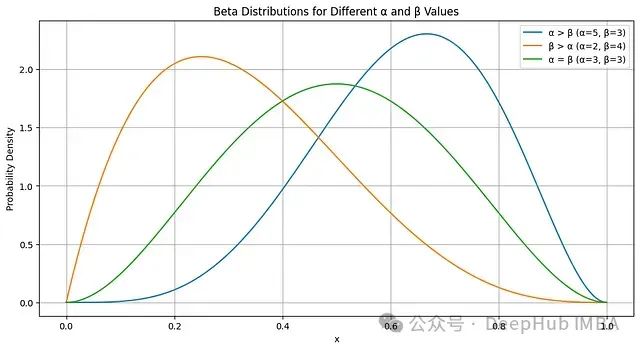

Beta分布与汤普森采样:智能决策系统概率采样的理论基础

Beta分布是二项分布和伯努利分布的共轭先验。当先验采用Beta分布,似然函数为二项分布或伯努利分布时,后验分布仍然是Beta分布。

【AI学习】Mamba学习(十八):S6的硬件感知设计

对于S6模型的硬件感知设计,尤其是所谓的并行扫描,看论文没有看清楚,查了相关博客,再进行一下梳理。

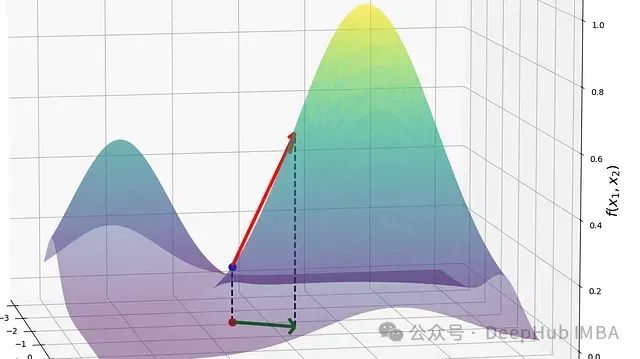

从方向导数到梯度:深度学习中的关键数学概念详解

本文将系统探讨方向导数与梯度的理论基础,并阐述二者的内在联系

YOLO 训练异常终止、断电、服务器关机,恢复训练,训练过程中调整训练周期

对于训练一个新的YOLO模型或者是跑原模型,在训练过程中总会遇到误触或是异常操作导致训练终止,肯定不想重新开始训练

【植物识别】Python+深度学习+人工智能+CNN卷积神经网络+算法模型训练+TensorFlow

植物识别系统,使用Python作为主要编程语言开发,通过收集常见的6中植物树叶(‘广玉兰’, ‘杜鹃’, ‘梧桐’, ‘樟叶’, ‘芭蕉’, ‘银杏’)图片作为数据集,然后使用TensorFlow搭建ResNet50算法网络模型,通过对数据集进行处理后进行模型迭代训练,得到一个识别精度较高的H5模型

《人工智能(AI)和深度学习简史》

FLUX.1 (2024):Black Forest Lab 推出了FLUX.1,这是一个先进的扩散模型,用于AI图像生成,具有出色的速度、质量和对提示的响应能力。1969年,XOR问题暴露了感知器(单层神经网络)的局限性。• GPT (2018):生成式预训练Transformer(Gene

华为昇腾310P AI 智能计算模组规格书

PCIe Gen4.0 ,兼容 3.0/2.0/1.0 XGE、SATA、USB 等接口。基于昇腾310P 模组设计的 AI 智能产品,可根据实际应用需求,可应用于机器人、无人机、无人。领域,有着极高的性价比,具有超强算力、 超高能效、高性能特征检索、安全启动等优势。支持 I2C、 UART、 CA

ORCA:基于持续批处理的LLM推理性能优化技术详解

ORCA系统创新性地提出了持续批处理概念,通过引入迭代级调度和选择性批处理机制,有效解决了大语言模型批处理中的关键技术挑战。

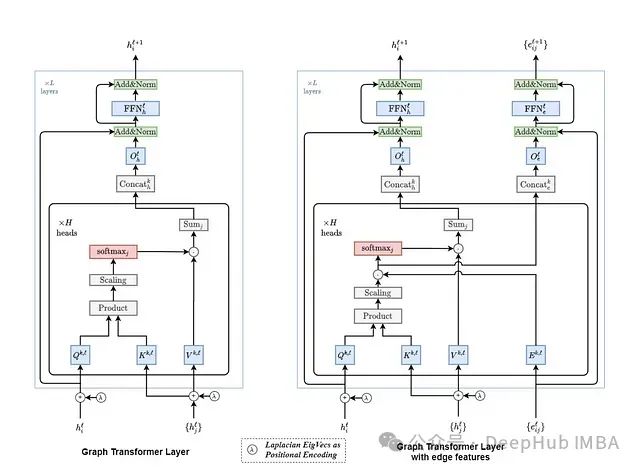

深入解析图神经网络:Graph Transformer的算法基础与工程实践

本文不仅是对Graph Transformer技术的深入解析,更是一份从理论到实践的完整技术指南,为那些希望在图神经网络领域深入发展的技术人员提供了宝贵的学习资源。

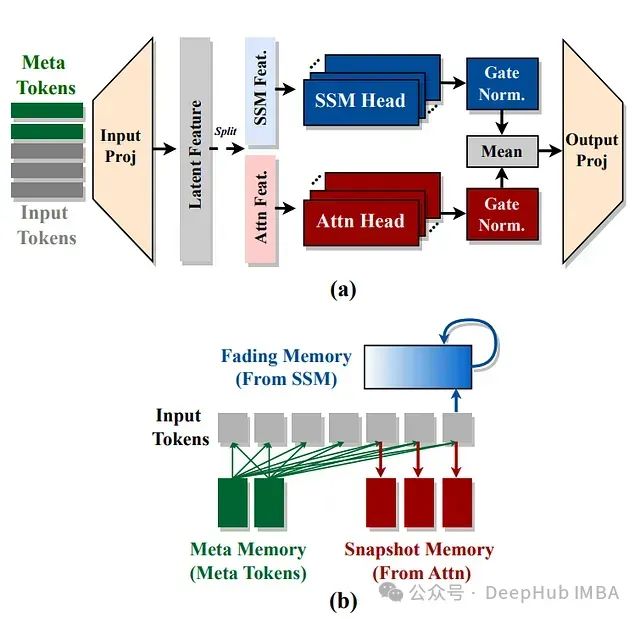

Hymba: 结合注意力头和SSM头的创新型语言模型方案

NVIDIA提出了Hymba架构,通过在同一层中结合注意力头和SSM头,以实现两种架构优势的互补。

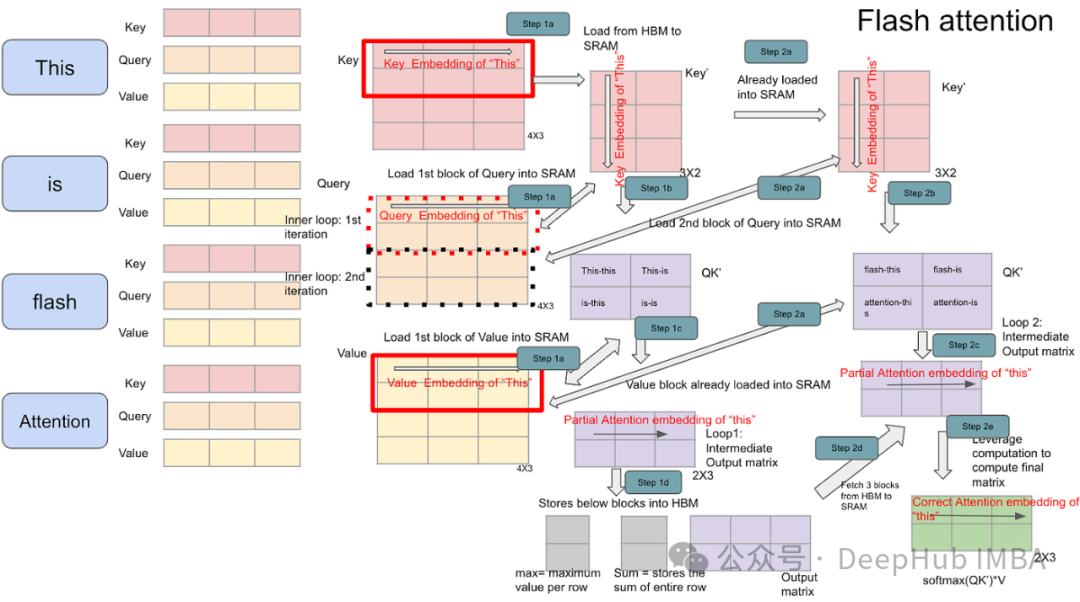

Transformer模型变长序列优化:解析PyTorch上的FlashAttention2与xFormers

本文将进一步探讨变长输入序列这一挑战——这是真实世界数据(如文档、代码、时间序列等)的固有特征。

【人工智能】Transformers之Pipeline(二十七):蒙版生成(mask-generation)

本文对transformers之pipeline的蒙版生成(mask-generation)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline使用文中的2行代码极简的使用多模态中的蒙版生成(mask-generation)模型。

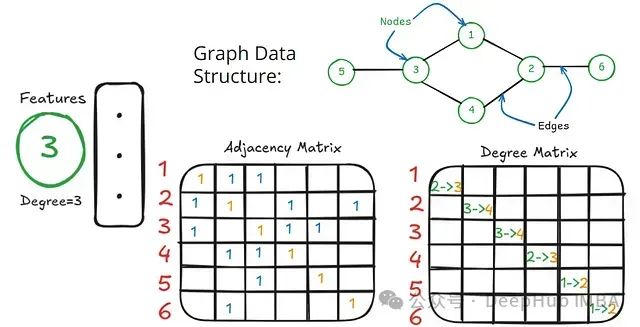

图卷积网络入门:数学基础与架构设计

本文系统地阐述了图卷积网络的架构原理。通过简化数学表述并聚焦于矩阵运算的核心概念,详细解析了GCN的工作机制。

顶会新热门:小波变换×Transformer,效率翻倍的AI图像去噪神奇组合

小波变换与Transformer的结合主要探讨如何利用小波变换的多尺度特性来增强Transformer在处理信号和图像数据时的表现。具体来说,小波变换能够有效提取信号中的局部特征,并在时间和频率域上提供信息,这对于处理复杂的信号(如图像和音频)非常有用。结合小波变换的Transformer可以在保持

人工智能深度学习的经典视觉项目实战之目标追踪(DeepSort,卡尔曼滤波)算法解读

4)如果满足3)的所有线的数量=n,则找到了最优分配,算法结束,否则(例是3行3列矩阵,但满足的线只有2,则3不等以2)进入5)。1)第一个核心模块就是前面求解x1与v1的公式(其中用到的状态转移矩阵),即x1=x+v*t+(1/2)*u*t,v1=v+ut转为通用矩阵形式 g=Ax+B*u,另外一

训练过程训练集的准确率都低于验证集和测试集的准确率可能的原因

需要综合考虑以上原因,通过逐步调整训练策略和超参数设置,找到最佳的训练方法,以提升训练集上的准确率,确保模型在所有数据集上的表现更加均衡和一致。

时间序列中多维度、多变量、多元、多尺度

这样的数据集就是一个多维时间序列,其中每个维度代表着一个气象变量,而时间是序列的主要维度。多变量时间序列是指一个时间序列数据集包含多个解释变量(x1,x2,x3...)和一个相应变量(y1)来表示,这些变量在时间上是相关的。多元时间序列是指一个时间序列数据集包含多个观测变量(如y1,y2,y3...

OpenCV与AI深度学习 | PaddleOCR 2.9 发布, 正式开源文本图像智能分析利器

飞桨低代码开发工具 PaddleX,依托于 PaddleOCR 的先进技术,支持了 OCR 领域的低代码全流程开发能力。通过低代码全流程开发,可实现简单且高效的模型使用、组合与定制。这将显著减少模型开发的时间消耗,降低其开发难度,大大加快模型在行业中的应用和推广速度。

【AI-20】训练服务器和推理服务器

(一)任务排队与优先级管理。(二)性能监控与优化。(三)便于管理和维护。

丹摩征文活动 | SD3+ComfyUI模型图文部署:AI工程师的实践与探索

在丹摩智算平台上部署SD3+ComfyUI图文模型的过程中,我感受到了极高的效率和便捷性,尤其是在处理图文生成任务时表现尤为出色。作为一名AI工程师,我对平台的计算能力和操作简便性有着严格的要求,而丹摩智算正好满足了这些需求。丹摩智算平台的界面用户友好,功能布局合理,使得整个部署过程非常直观。即使是