序列到序列学习(Seq2seq)

(3)在选候选句子的时候,长句子往往预测的概率会更小一点,为了平衡选择的概率,有机会能尝到有机会能选到长一点的句子,通常是取一个log再取l的阿尔法次饭分之1去调整长句子的概率。这个向量空间是通过训练数据学习到的,向量的维度通常远小于词汇表的大小,生成的向量是密集的,维度通常远小于。(3)编码器通过

【深度学习实战】构建AI模型,实现手写数字自动识别

近年来,人工智能(AI)大模型在计算机科学领域引起了广泛的兴趣和关注。这些模型以其庞大的参数规模和卓越的性能,在各种领域展现了巨大的潜力。本文介绍如何构建一个AI模型,实现一个简单的手写数字识别任务。手写数字识别是一种利用计算机自动辨认人手写在纸张上的阿拉伯数字的技术。 这一技术属于光学字符识别

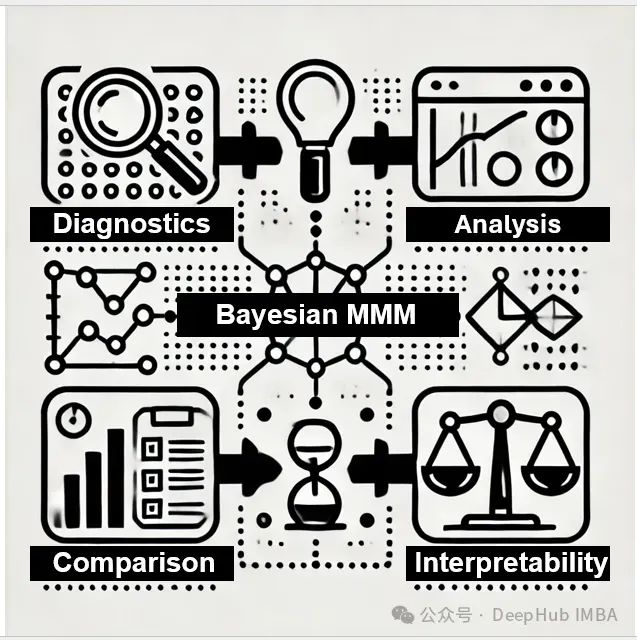

基于MCMC的贝叶斯营销组合模型评估方法论: 系统化诊断、校准及选择的理论框架

贝叶斯营销组合建模(Bayesian Marketing Mix Modeling,MMM)作为一种先进的营销效果评估方法,其核心在于通过贝叶斯框架对营销投资的影响进行量化分析。

深度学习工程实践:PyTorch Lightning与Ignite框架的技术特性对比分析

在深度学习框架的选择上,PyTorch Lightning和Ignite代表了两种不同的技术路线。本文将从技术实现的角度,深入分析这两个框架在实际应用中的差异,为开发者提供客观的技术参考。

海康威视 Vision Master 深度学习模块

Vision Master 深度学习模块

ConvGRU原理与开源代码

ConvGRU(卷积门控循环单元)是一种结合了卷积神经网络(CNN)和门控循环单元(GRU)的深度学习模型。与ConvLSTM类似,ConvGRU也主要用于处理时空数据,特别适用于需要考虑空间特征和时间依赖关系的任务,如视频分析、气象预测和交通流量预测等。

大模型-基于大模型的数据标注

法来自于这篇论文:Can Generalist Foundation Models Outcompete Special-Purpose Tuning?

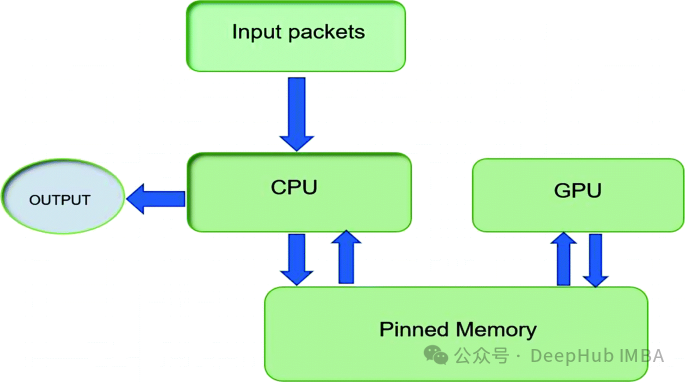

通过pin_memory 优化 PyTorch 数据加载和传输:工作原理、使用场景与性能分析

本文将深入探讨何时以及为何启用这一设置,帮助你优化 PyTorch 中的内存管理和数据吞吐量。

【AI论文精读5】知识图谱与LLM结合的路线图-P2

该论文提出了一个将大型语言模型(LLMs)与知识图谱(KGs)相结合的路线图。这是我对论文第2部分的解读。

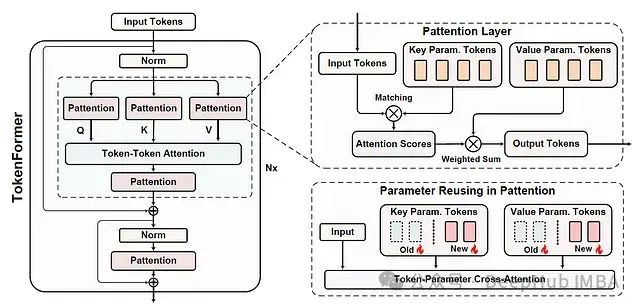

Tokenformer:基于参数标记化的高效可扩展Transformer架构

本文是对发表于arXiv的论文 "TOKENFORMER: RETHINKING TRANSFORMER SCALING WITH TOKENIZED MODEL PARAMETERS" 的深入解读与扩展分析。

【动物识别系统】Python+卷积神经网络算法+人工智能+深度学习+机器学习+计算机课设项目+Django网页界面

动物识别系统。本项目以Python作为主要编程语言,并基于TensorFlow搭建ResNet50卷积神经网络算法模型,通过收集4种常见的动物图像数据集(猫、狗、鸡、马)然后进行模型训练,得到一个识别精度较高的模型文件,然后保存为本地格式的H5格式文件。再基于Django开发Web网页端操作界面,实

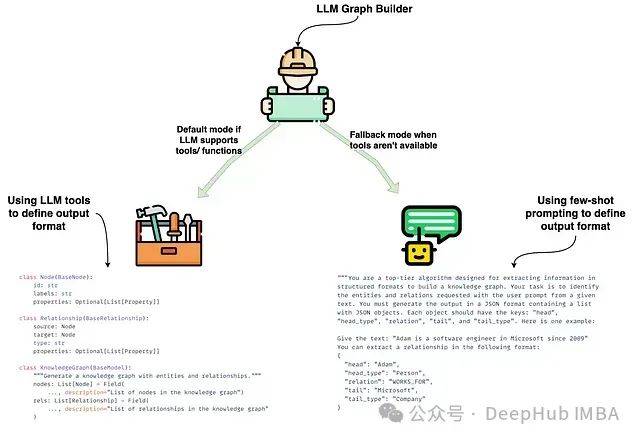

基于LLM Graph Transformer的知识图谱构建技术研究:LangChain框架下转换机制实践

本文是LangChain的一个代码贡献者编写的文章,将对这些内容进行详细介绍,文章最后还包含了作者提供的源代码

【大模型 AI 学习】大模型 AI 部署硬件配置方案(本地硬件配置 | 在线GPU)

最近想部署一个开源深度学习项目,但是小编的笔记本电脑是8G的集成显存,且没有GPU,性能肯定是不够的。于是小编在小po站上粗浅了解了一下当前: 1. 大模型 AI本地硬件配置和 2. 云上申请GPU算力的两种方式。

大模型应用中一个 Token 占多少汉字?答案超乎想象!

原创 Soyoger AI技术研习社 2024年07月14日 09:00 美国先说答案:不同模型可能采用各自的切分方法,因此,一个 Token 所对应的汉字数量也会有所不同。如腾讯1token≈1.8个汉字,通义千问、千帆大模型等1token=1个汉字,对于英文文本来说,1个token通常对应3至4

Nature新晋子刊!一年直升1区TOP,IF还在蹭蹭涨!赶紧抓住扩刊红利期

而言当然是低很多,但是预计明年IF值能破10分,现在有扩刊趋势,各位同领域的学者们可考虑一下这本潜力新刊!此刊作为Nature旗下的新晋期刊,在影响力和排名上表现良好,影响因子8.1分,属于地球科学1区Top期刊。《通讯地球与环境》创办于2020年,是Nature旗下的新晋期刊,位于中科院1区Top

LLM Continue Pretrain(2024版)

deepseek的开源moe,也做得非常不错,应该是国内开源top了,他们的pretrain团队做得挺棒的 但算法为主的,做pretrain,往往就是洗数据了。尴尬的点是,预训练洗数据,因为数据量大,往往都是搞各种小模型+规则,很难说明你做的事情的技术含量,只能体现你对数据的认知很好。语言类的dom

2区TOP审稿“超亲民”!平均5天就上线!硕博友刊不是吹的~

的理论贡献,包括但不限于:架构、学习方法、网络动态分析、学习理论、计算学习理论、模糊逻辑、遗传算法、信息论、机器学习、神经生物学和模式识别的跨学科主题。期刊自2015年突破1000篇后,就“刹不住车”,曾一度直线上升到1800+后,本以为会持续扩刊,可是后续经过积极地调整,最近一年的发文量又回归了。

【果蔬识别】Python+卷积神经网络算法+深度学习+人工智能+机器学习+TensorFlow+计算机课设项目+算法模型

果蔬识别系统,本系统使用Python作为主要开发语言,通过收集了12种常见的水果和蔬菜(‘土豆’, ‘圣女果’, ‘大白菜’, ‘大葱’, ‘梨’, ‘胡萝卜’, ‘芒果’, ‘苹果’, ‘西红柿’, ‘韭菜’, ‘香蕉’, ‘黄瓜’),然后基于TensorFlow库搭建CNN卷积神经网络算法模型,

论文研读:TransMorph—用于无监督医学图像配准的Transformer

在过去,卷积神经网络(ConvNets)一直是医学图像分析领域的研究热点。但是它的缺点是很少关注图像中的远程空间关系。最近,人们提出Transformer来解决ConvNet的缺点,并在许多医学成像应用中产生了最先进的性能,因为其大得多的感受野能够更精确地理解运动图像和固定图像之间的空间对应关系。在

人工智能——深度学习

深度学习是一种基于人工神经网络的机器学习方法,其核心思想是通过多层次的神经网络来模拟人脑的神经元之间的连接。深度学习的特点是可以通过大规模的数据来训练模型,并且可以自动学习到数据的特征表示。上图就是一个神经网络的基本结构图,X1到Xn是输入,O1到Oj是输出,圆圈是神经元(也称感知机),连线带权重参