人工智能-深度学习-学习笔记

人工智能当前的发展呈现出加速和深化的趋势,特别是在深度学习领域。技术革新与应用拓展并行推进,深度学习算法和模型结构不断创新,为处理复杂数据提供了强有力的工具,使得AI在图像识别、语音处理、自然语言理解等方面取得显著进展,并广泛应用于金融、医疗、教育、交通等多个行业。同时,数据驱动和算力提升成为AI发

OPT 大语言模型(Large Language Model)结构

大语言模型follow GPT的做法,其基本组成结构是Decoder-only的Transformer block,多个Transformer Block堆叠在一起;不同数量、不同Head、不同隐藏层维度构成了不同参数量的大模型(也即模型跟着的后缀,比如,6.7B);预训练模型参数的数据类型(大模型

AI 翻唱

So-vits-svc 4.1 训练模型全过程。UVR:用于人声歌声分离,降噪。Slicer-gui(Audio-Slicer):用于音频裁剪。So-vits-svc 4.1:训练模型。Adobe Audition:后期音频编辑。

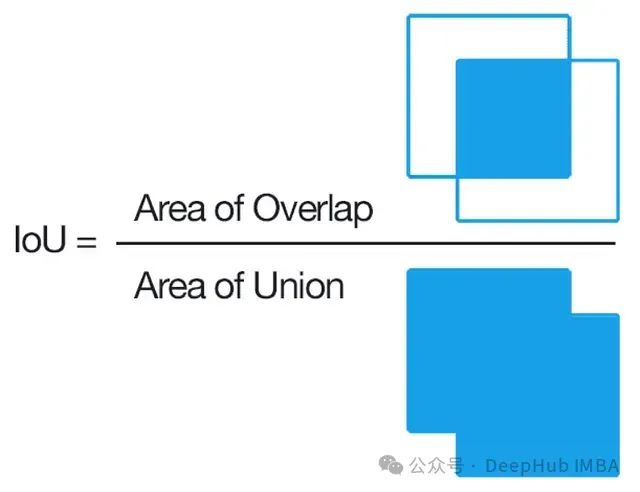

IoU已经out了,试试这几个变体:GIoU、DIoU和CIoU介绍与对比分析

GIoU、DIoU和CIoU这三个变体都有各自的独到之处,它们在一定程度上弥补了普通IoU在处理不重叠、距离较远或形状差异较大的边界框时的不足。

AI4Science(2024年4月总结):物理驱动及数据驱动深度学习方法用于科学计算问题

本文主要介绍,用于科学计算问题中的物理驱动和数据驱动的深度学习方法。通过方法算例,对现有方法总结。时间是2024年4月。

GaussDB高智能--库内AI引擎:模型管理&数据集管理

从模型管理与数据集管理两方面,对GaussDB的库内AI引擎进行了详细解读

【循环神经网络】:教AI写周杰伦风格的歌词

只会python基础,也能让AI写歌词

【人工智能】PyTorch、TensorFlow 和 Keras 全面解析与对比:深度学习框架的终极指南

本文将为你一一解答。为了更直观地了解三大框架的使用方式,下面我们将通过一个简单的手写数字识别(MNIST)任务,演示如何使用 PyTorch、TensorFlow 和 Keras 构建和训练一个基本的神经网络模型。通过以上简单的示例,我们可以看到,虽然三大框架在具体实现上有所不同,但总体流程相似,都

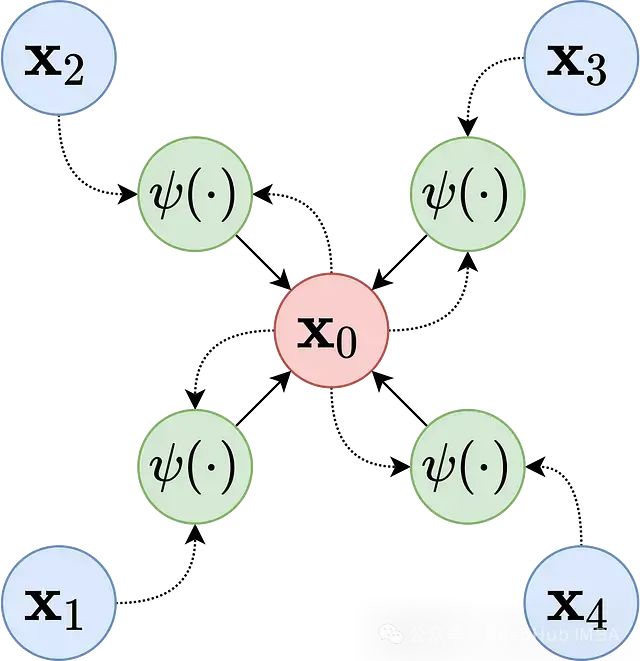

图神经网络在欺诈检测与蛋白质功能预测中的应用概述

本文将深入探讨GNNs在欺诈检测和生物信息学领域的应用机制与技术原理。

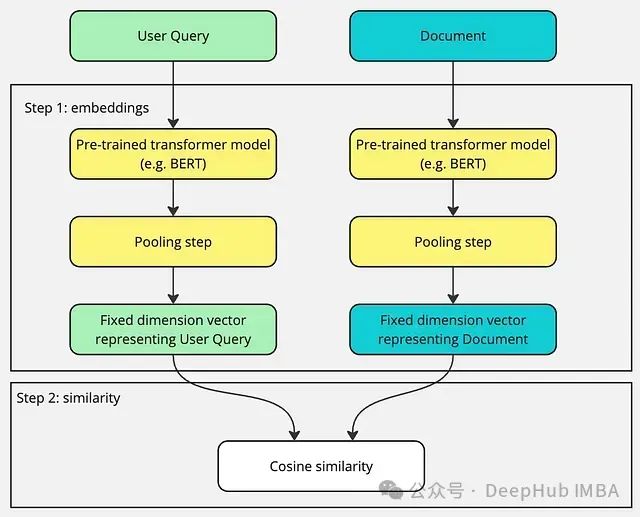

【AI知识点】余弦相似度(Cosine Similarity)

余弦相似度(Cosine Similarity)是一种用于衡量两个向量在方向上的相似程度的指标。它主要用于文本分析、自然语言处理(NLP)、推荐系统等任务中,能够衡量两个向量之间的相似性,而不受向量的长度(模)影响。

基于LIDC-IDRI肺结节肺癌数据集的人工智能深度学习分类良性和恶性肺癌(Python 全代码)全流程解析(三)

混淆矩阵(Confusion Matrix)是一种用于评估分类模型性能的表格,它将模型预测的结果与实际的类别标签进行比较,从而展现模型的分类准确性。对测试集的真实标签(y_true)和模型预测得到的二元分类结果(y_pred)进行评估,通过输出分类报告(classification_report)来

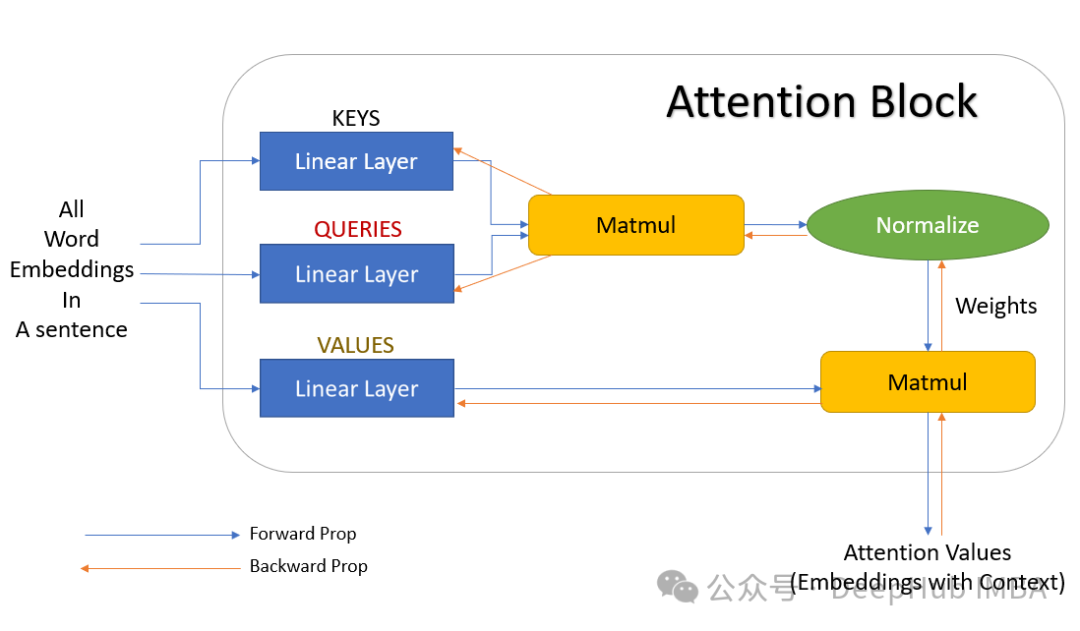

优化注意力层提升 Transformer 模型效率:通过改进注意力机制降低机器学习成本

本文将深入探讨在 PyTorch 生态系统中优化注意力层的多种技术路径,并将重点聚焦于那些在降低计算成本的同时能够保持注意力层精度的创新方法。

深入解析Cursor: AI辅助编程的核心技术揭秘

作为开发者,你是否好奇过AI是如何理解和生成代码的?今天,让我们一起揭开Cursor这款强大AI编程助手的神秘面纱,深入探讨其背后的核心技术原理。从先进的语言模型到智能的上下文分析,从海量的训练数据到持续的更新机制,本文将为你全面解析Cursor的技术内幕,助你更好地驾驭这个AI编程利器!

docker部署本地词向量模型

会先去下载 docker 镜像,然后运行容器。特别要强调的是:model 的路径可不是随便写的。在我的这个例子中,启动 docker 时,映射的路径是。,因此 model 的路径必须以/data 开头,不然的话是找不到模型的。,大家可以参考我的路径来调整 model 和 volume 变量的值。

《人工智能深度学习的基本路线图》

《人工智能深度学习的基本路线图》

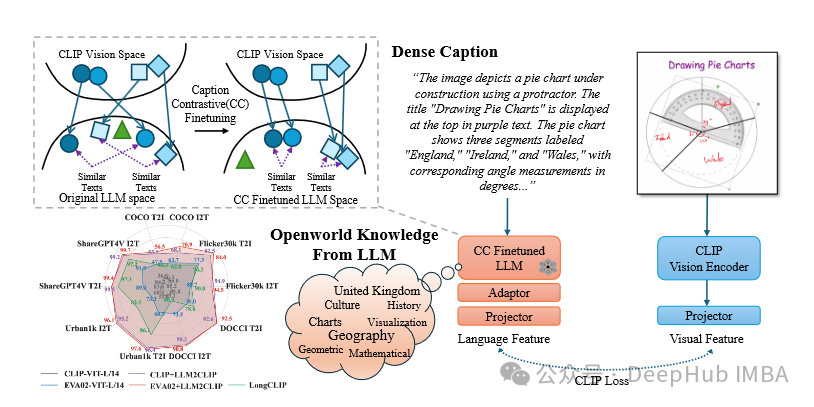

LLM2CLIP:使用大语言模型提升CLIP的文本处理,提高长文本理解和跨语言能力

LLM2CLIP 为多模态学习提供了一种新的范式,通过整合 LLM 的强大功能来增强 CLIP 模型。

【AI知识点】近似最近邻搜索(ANN, Approximate Nearest Neighbor Search)

近似最近邻搜索(ANN) 是一种为了提升高维数据相似性搜索效率的技术,它在牺牲一定精度的前提下,大大提升了搜索速度。它被广泛应用于推荐系统、图像检索、文本相似性搜索等实际场景。常见的ANN算法包括局部敏感哈希(LSH)、图嵌入法(如HNSW)、矢量量化(VQ)等,它们通过不同的方式优化搜索过程,解决

ai文件太大怎么降低图片分辨率

通过本文介绍的方法,你应该已经掌握了如何有效地管理和控制AI文件大小的知识。记住,合理规划项目结构、恰当地运用各种编辑技巧以及始终保持警惕的态度是成功的关键所在。希望这些信息对你有所帮助!

解读双编码器和交叉编码器:信息检索中的向量表示与语义匹配

在信息检索领域(即从海量数据中查找相关信息),双编码器和交叉编码器是两种至关重要的工具。它们各自拥有独特的工作机制、优势和局限性。本文将深入探讨这两种核心技术。

【AI学习】Mamba学习(十二):深入理解S4模型

HiPPO A矩阵在线性代数意义上是高度非正规的,这阻碍了传统算法技术的应用。因此,尽管 LSSL 表明 SSM 具有很强的性能,但它们目前作为通用序列建模解决方案在计算上是不切实际的。S4将HiPPO 矩阵A分解为正规矩阵和低秩矩阵的和,使得A可以被稳定地对角化;利用Woodbury identi