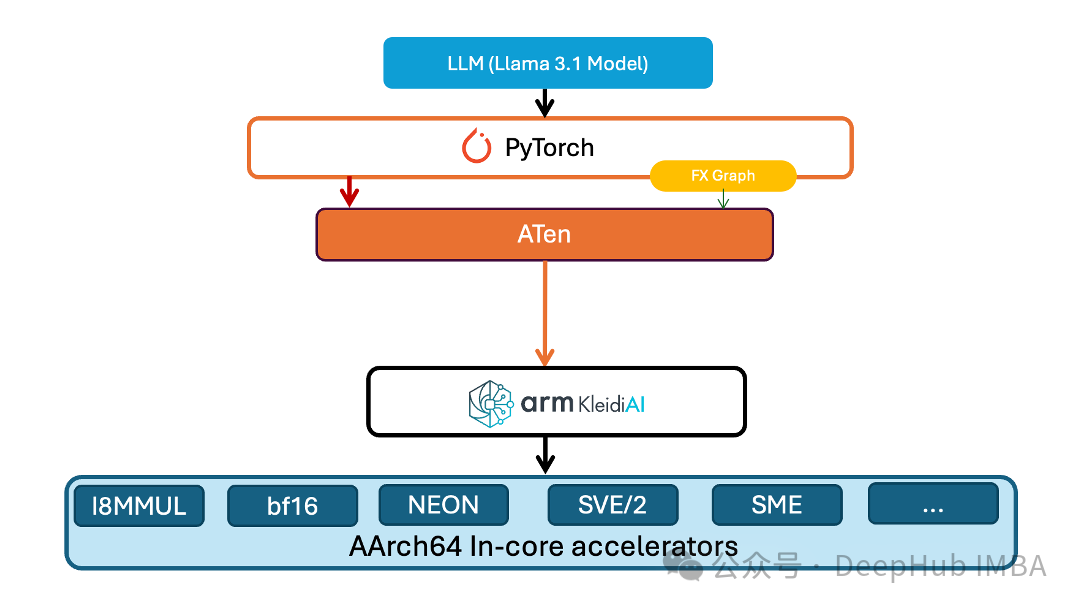

PyTorch团队为TorchAO引入1-8比特量化,提升ARM平台性能

PyTorch团队针对这一问题推出了创新性的技术方案——在其原生低精度计算库TorchAO中引入低位运算符支持。这一技术突破不仅实现了1至8位精度的嵌入层权重量化

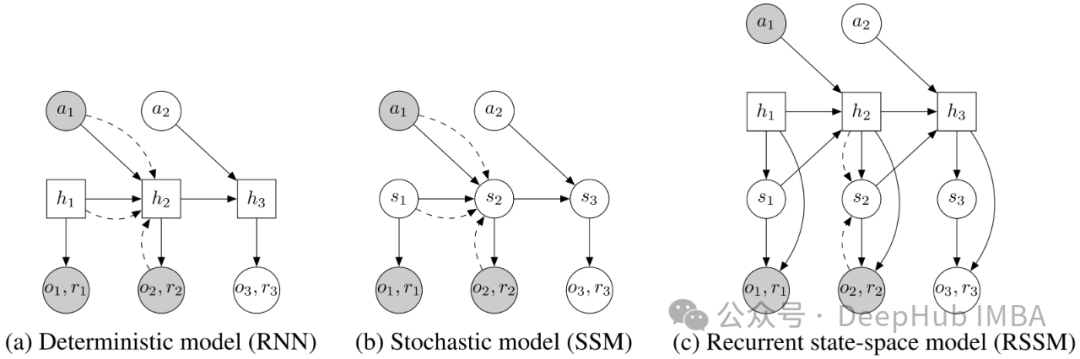

面向强化学习的状态空间建模:RSSM的介绍和PyTorch实现

循环状态空间模型(Recurrent State Space Models, RSSM)最初由 Danijar Hafer 等人在论文《Learning Latent Dynamics for Planning from Pixels》中提出。

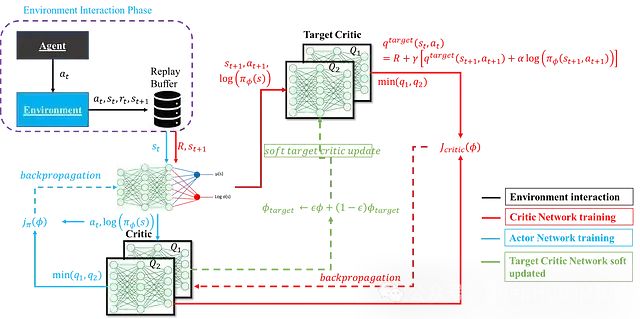

深度强化学习中SAC算法:数学原理、网络架构及其PyTorch实现

软演员-评论家算法(Soft Actor-Critic, SAC)因其在样本效率、探索效果和训练稳定性等方面的优异表现而备受关注。

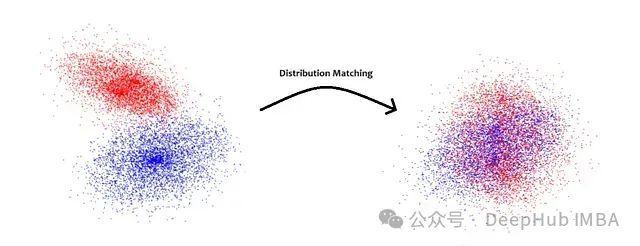

分布匹配蒸馏:扩散模型的单步生成优化方法研究

分布匹配蒸馏(Distribution Matching Distillation,DMD)通过将多步扩散过程精简为单步生成器来解决这一问题。该方法结合分布匹配损失函数和对抗生成网络损失,实现从噪声图像到真实图像的高效映射,为快速图像生成应用提供了新的技术路径。

线性化注意力综述:突破Softmax二次复杂度瓶颈的高效计算方案

大型语言模型在各个领域都展现出了卓越的性能,但其核心组件之一——softmax注意力机制在计算资源消耗方面存在显著局限性。本文将深入探讨如何通过替代方案实现线性时间复杂度,从而突破这一计算瓶颈。

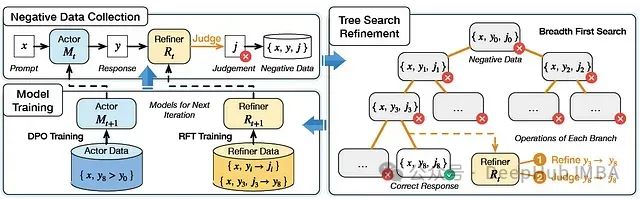

SPAR:融合自对弈与树搜索的高性能指令优化框架

SPAR框架通过自对弈和树搜索机制,生成高质量偏好对,显著提升了大语言模型的指令遵循能力。实验表明,SPAR在指令遵循基准测试中表现优异,尤其在模型规模扩展和判断能力方面展现出显著优势。

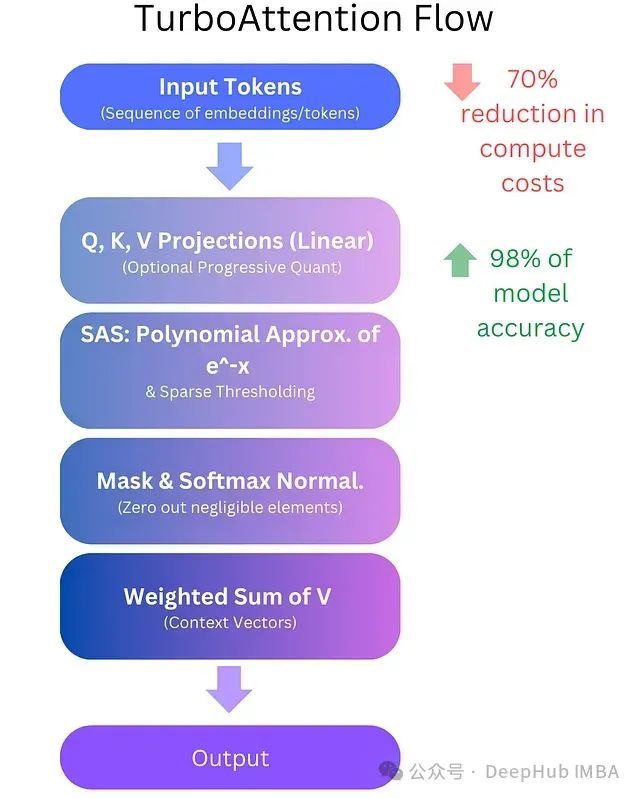

TurboAttention:基于多项式近似和渐进式量化的高效注意力机制优化方案,降低LLM计算成本70%

**TurboAttention**提出了一种全新的LLM信息处理方法。该方法通过一系列优化手段替代了传统的二次复杂度注意力机制,包括稀疏多项式软最大值近似和高效量化技术。

BERT的继任者ModernBERT:融合长序列处理、代码理解与高效计算的新一代双向编码器

。ModernBERT 是一个全新的模型系列,在**速度**和**准确性**两个维度上全面超越了 BERT 及其后继模型。

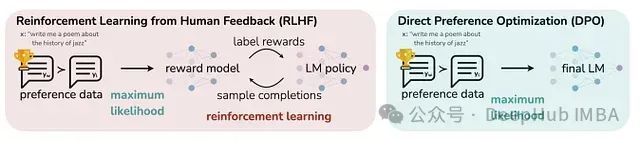

使用PyTorch实现GPT-2直接偏好优化训练:DPO方法改进及其与监督微调的效果对比

本文将探讨RLHF技术,特别聚焦于直接偏好优化(Direct Preference Optimization, DPO)方法,并详细阐述了一项实验研究:通过DPO对GPT-2 124M模型进行调优,同时与传统监督微调(Supervised Fine-tuning, SFT)方法进行对比分析。

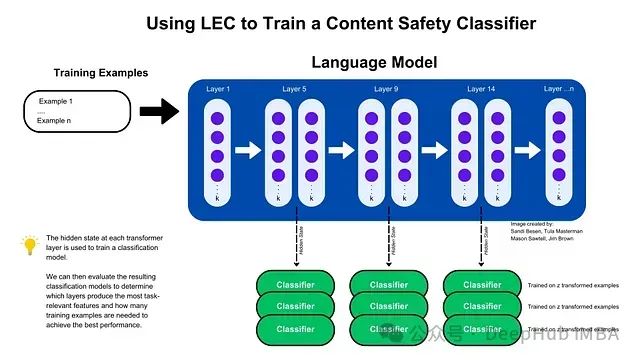

LEC: 基于Transformer中间层隐藏状态的高效特征提取与内容安全分类方法

通过利用Transformer中间层的隐藏状态,研究提出了层增强分类(LEC)技术,该技术能够以极少的训练样本和参数实现高效的内容安全和提示注入攻击分类,显著提升了模型的性能,并验证了其跨架构和领域的泛化能力。

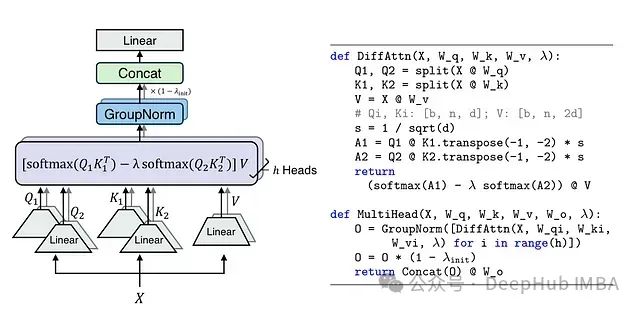

Differential Transformer: 通过差分注意力机制提升大语言模型性能

DIFF Transformer通过创新的差分注意力机制成功提升了模型性能,特别是在长文本理解、关键信息检索和模型鲁棒性等方面。

Designify——AI优化图像设计,自动去背景、调整构图、添加视觉效果,创建高质量的设计图像

Designify是一款强大的 AI 驱动图像设计工具,适合需要快速生成高质量图片的用户。通过自动化背景移除、图像优化和智能裁剪等功能,它大大简化了图像处理的流程,尤其适合电商、广告和社交媒体的图像需求。虽然对一些高级用户来说其定制功能可能不够精细,但对于大部分需要快速完成设计任务的场景,Desig

【智能流体力学】ANSYS Fluent计算流体力学原理、仿真过程分析方法介绍

计算流体动力学(CFD)是研究流体流动、传质、传热、化学反应及相关现象的一门科学。它通过对质量守恒、动量守恒和能量守恒等基本方程的计算,来预测和分析这些现象。CFD能够为工程师和科学家提供流体流动行为的详细信息,从而帮助在设计和优化过程中做出更科学的决策。CFD的基本原理质量守恒(Continuit

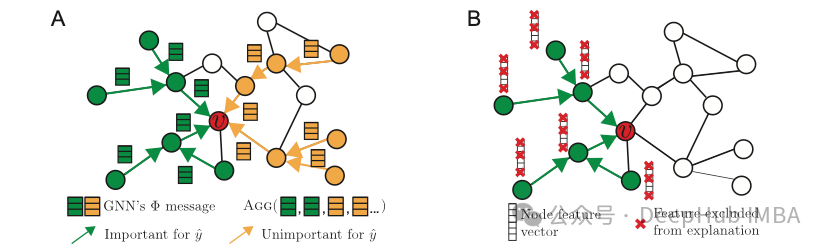

可解释性:走向透明与可信的人工智能

随着人工智能的不断发展,模型的可解释性已经成为了一个不可忽视的问题。尽管深度学习模型具有强大的预测能力,但其“黑盒”特性限制了其在一些高风险领域的应用。通过采用LIME、SHAP等可解释性方法,我们不仅能够提高模型的透明度,还能够增强模型的可靠性与公平性。

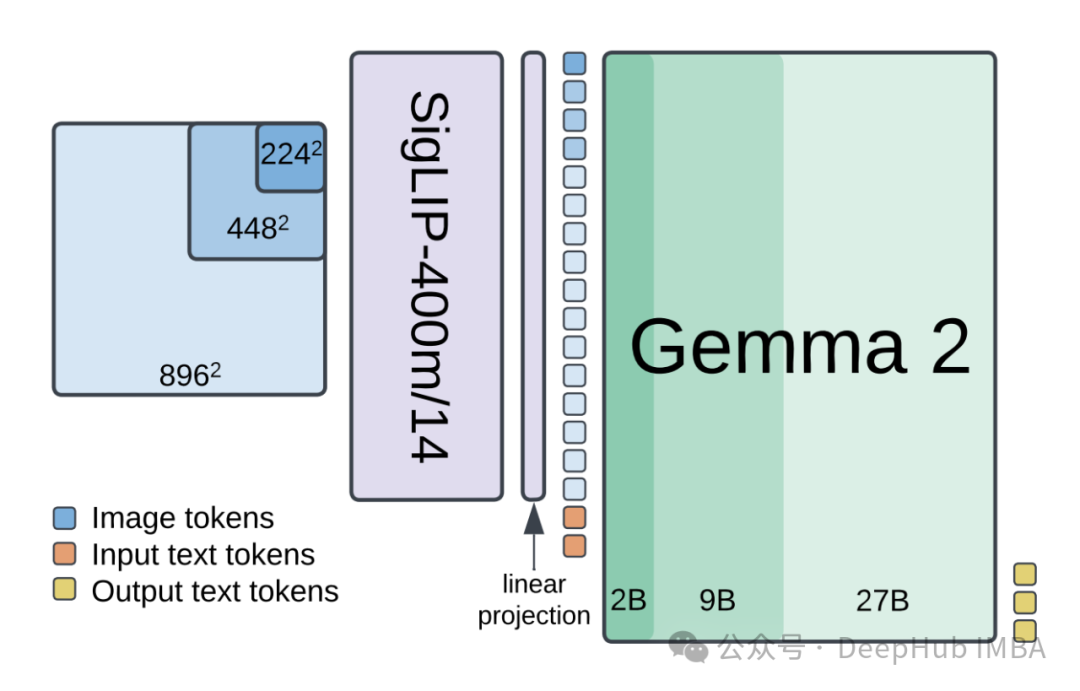

使用PaliGemma2构建多模态目标检测系统:从架构设计到性能优化的技术实践指南

本文详细阐述了如何利用PaliGemma2构建高性能的多模态目标检测系统。

AI生成图像模型的原理与优化技术-从对抗学习到高质量图像生成【附核心实战代码】

在本文中,我们探讨了AI生成图像模型(AIGC)的前沿技术,从生成原理到高质量图像生成的优化策略进行了深入分析。生成原理介绍了生成对抗网络(GAN)、变分自编码器(VAE)和扩散模型的基本概念和工作原理。这些模型通过学习数据分布,能够生成具有真实感的图像。模型训练讨论了模型训练中的关键步骤,包括数据

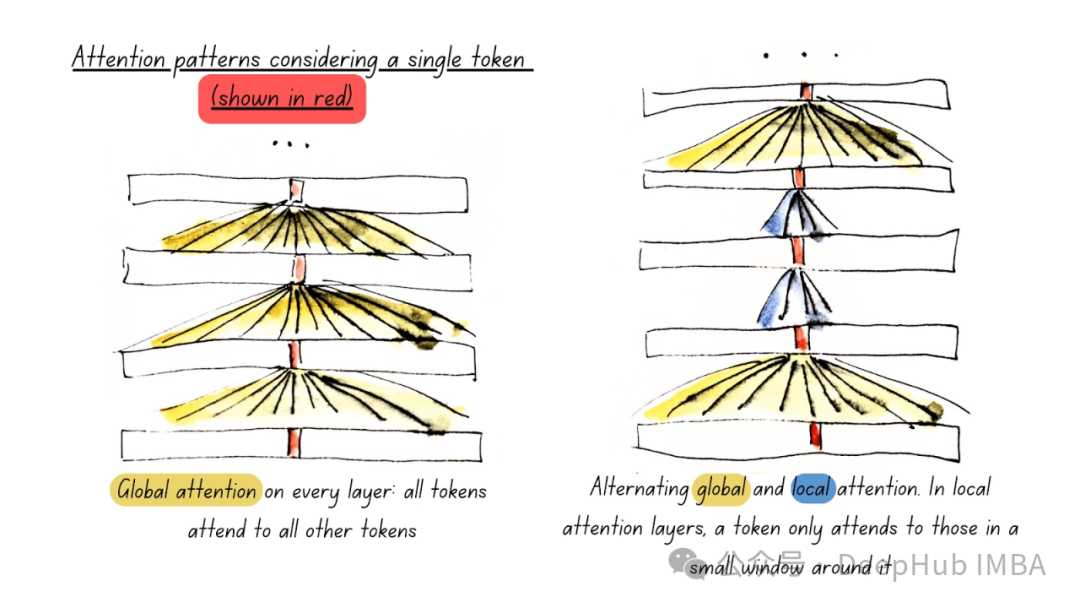

sliding window attention

同时,这种方式并不是意味着当前token只能获取到前window_size个token的信息,因为当前token前面的window_size个token也都是能够获取到前面的信息的,因此只要网络达到一定的深度,这样的sliding window attention是可行的,并不会损失太多信息。sli

“水刊之王”,发表直通车几乎全收,计算机人工智能四大水榜sci

今天给大家推荐计算机人工智能五大水榜sci