补充:理解Query、Key和Value

Query(查询)每个输入元素(如单词、字符等)都有一个Query向量。Query向量表示我们正在寻找的信息或特征。在计算注意力权重时,Query用于匹配Key,从而确定关注哪些元素及其重要程度。Key(键)每个输入元素也有一个Key向量。Key向量表示元素的特征或内容。Key用于与Query匹配,

【交通标志识别系统】Python+卷积神经网络算法+人工智能+深度学习+机器学习+算法模型

交通标志识别系统。本系统使用Python作为主要编程语言,在交通标志图像识别功能实现中,基于TensorFlow搭建卷积神经网络算法模型,通过对收集到的58种常见的交通标志图像作为数据集,进行迭代训练最后得到一个识别精度较高的模型文件,然后保存为本地的h5格式文件。再使用Django开发Web网页端

【AI知识点】机器学习中的常用优化算法(梯度下降、SGD、Adam等)

在机器学习中优化算法(Optimization Algorithm) 的任务是找到模型参数(如权重、偏置等),使得损失函数(例如均方误差、交叉熵等)最小化。损失函数度量的是模型预测值与真实标签之间的误差。优化算法通过不断调整模型的参数,使损失函数达到全局或局部最小值。

模型微调参数3——cutoff_len

在大模型的微调过程中,cutoff_len参数用于控制输入文本的截断长度。:模型处理长文本时,计算资源和内存消耗会显著增加。通过设置cutoff_len,可以限制输入文本的最大长度,从而控制内存使用和计算负担。:较长的输入会导致训练时间的增加。截断文本可以加快训练速度,提高训练效率。:长文本可能包含

最全AI简史(中):深度学习时代

2015年,深度学习三巨头Yann LeCun、Yoshua Bengio、Geoffrey Hinton在Nature杂志上发表深度学习综述论文,并与2018年同时获得图灵奖,侧面展现了深度学习对当今时代带来的巨大影响。

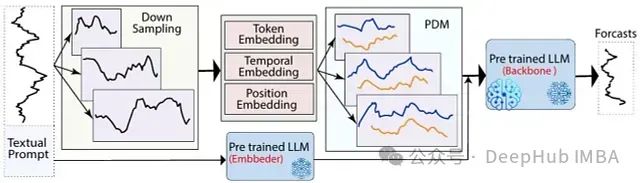

LLM-Mixer: 融合多尺度时间序列分解与预训练模型,可以精准捕捉短期波动与长期趋势

LLM-Mixer通过结合多尺度时间序列分解和预训练的LLMs,提高了时间序列预测的准确性。它利用多个时间分辨率有效地捕捉短期和长期模式,增强了模型的预测能力

用ai写论文查重率高吗?分享4款ai智能写论文软件

其次,AI生成的论文查重率受多种因素影响,包括论文的主题、内容的独特性、所使用的AI工具的能力以及查重系统的特点。通过合理使用这些AI写作工具,并结合个人的研究和观点进行编辑和优化,可以有效降低论文的查重率,提高论文的质量和可信度。3. 文通AI:文通AI是一款专业的AI论文写作工具,覆盖多个学科领

基于深度学习的AI生成式人脸图像鉴别原理

生成式AI模型的主要目标是生成与真实数据分布类似的高质量图像。当前最为流行的生成式模型是生成对抗网络(GANs)。GAN的基本原理是通过生成器和判别器的博弈,使得生成器逐步学会生成越来越逼真的图像。随着技术的发展,GAN和其变种如StyleGAN、BigGAN、CycleGAN等,已经可以生成逼真度

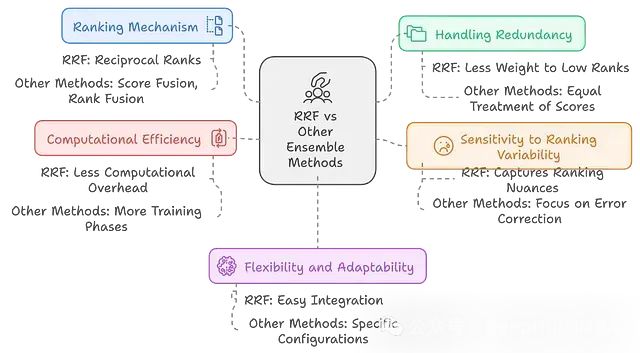

RAPTOR:多模型融合+层次结构 = 检索性能提升20%,结果还更稳健

RAPTOR通过结合多个检索模型,构建层次化的信息组织结构,并采用递归摘要等技术,显著提升了检索系统的性能和适应性。

转置卷积 transposed convolution

通过上面分析,就可以知道为什么通过对输入特征图进行填充使用转置的卷积核并且使用转置卷积核与输入特征图进行步长=1的普通卷积操作就可以得到结果。

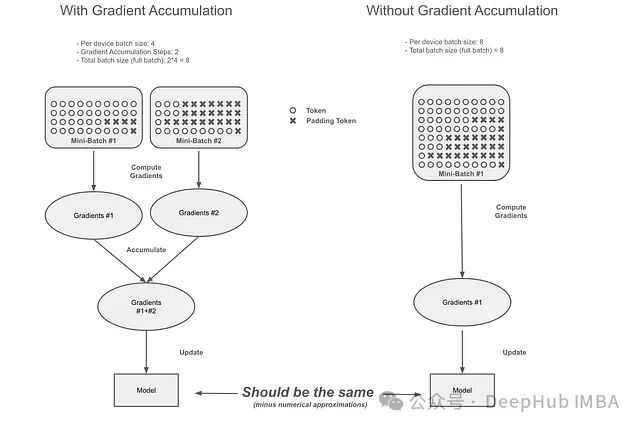

梯度累积的隐藏陷阱:Transformer库中梯度累积机制的缺陷与修正

本文将从以下几个方面展开讨论:首先阐述梯度累积的基本原理,通过实例说明问题的具体表现和错误累积过程;其次分析不同训练场景下该问题的影响程度;最后评估Unsloth提出并已被Hugging Face在Transformers框架中实现的修正方案的有效性。

PRCV2024:可信AI向善发展与智能文档加速构建

在PRCV2024中,合合信息图像算法研发总监郭丰俊老师针对生成式人工智能时代下图像内容安全和智能文档加速的相关技术,分享了自己的独到见解,并介绍了合合信息在这两个方向上取得的进步。接下来,让我们深入了解一下GAI在智能文档领域带来的挑战与机遇。

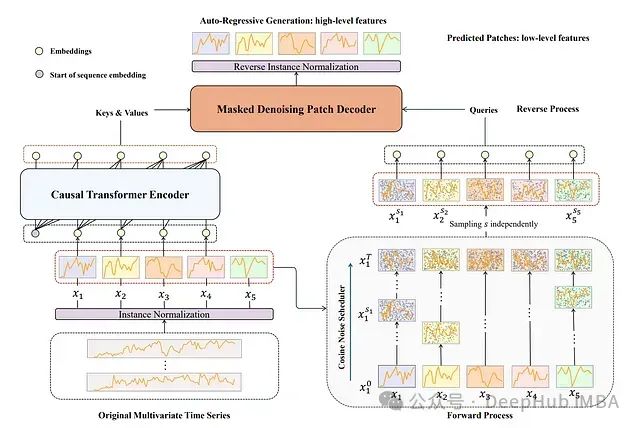

TimeDART:基于扩散自回归Transformer 的自监督时间序列预测方法

TimeDART是一种专为**时间序列预测**设计的自**监督学习**方法。它的核心思想是通过从时间序列历史数据中学习模式来改进未来数据点的预测。

【人工智能】Transformers之Pipeline(二十):令牌分类(token-classification)

本文对transformers之pipeline的令牌分类(token-classification)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline使用文中的2行代码极简的使用NLP中的令牌分类(token-classificati

SOLOv2(NeurIPS 2020)论文与代码解读

本文针对SOLO中存在的三个影响性能的瓶颈提出了对应的优化方法,提出了SOLOv2。

用GPT打造一个专门写网文小说的AI智能体!轻松掌控故事发展

它可以根据你提供的输入(prompt)生成符合逻辑的内容,而训练一个AI智能体就是定制和优化这个能力,使其更符合你的个人需求,比如专门为你撰写某种风格或类型的网文小说。通过训练,你可以让AI根据指定的角色、剧情线、写作风格等,自动生成大量文本,极大地提升写作效率,同时还可以为你提供不同的灵感。你可以

【AI大模型】深入Transformer架构:输入和输出部分的实现与解析

因为在Transformer的编码器结构中, 并没有针对词汇位置信息的处理,因此需要在Embedding层后加入位置编码器,将词汇位置不同可能会产生不同语义的信息加入到词嵌入张量中, 以弥补位置信息的缺失.

AnimeGANv3: 快速将照片和视频转换为动漫风格的革命性AI模型

AnimeGANv3作为一种革命性的图像风格转换模型,不仅在技术上取得了突破,还为创意产业带来了新的可能性。随着AI技术的不断发展,我们可以期待看到更多像AnimeGANv3这样创新的应用,不断推动艺术创作和内容制作的边界。无论你是专业的创意工作者,还是对动漫和艺术感兴趣的普通用户,AnimeGAN

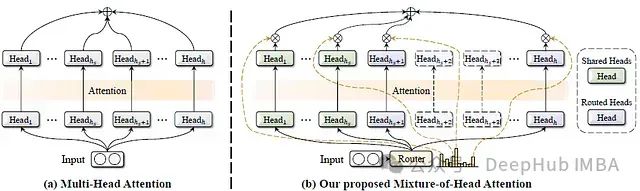

MoH:融合混合专家机制的高效多头注意力模型及其在视觉语言任务中的应用

这篇论文提出了一种名为混合头注意力(Mixture-of-Head attention, MoH)的新架构,旨在提高注意力机制的效率,同时保持或超越先前的准确性水平。

ai写的论文查重率高吗?分享4款ai论文查重软件

如果AI写作软件所使用的训练数据与已有的文献高度相似,或者用户输入的关键词和句式与已有的文献相同,那么生成的文本内容可能与已有的文献高度重复,从而导致较高的查重率。在实际应用中,AI写作论文的查重率并不是固定的,受到算法、数据、主题、领域和用户操作等多种因素的影响。因此,选择全面且可靠的文献数据库,