[机器学习、Spark]Spark MLlib分类

线性支持向量机在机器学习领域中是一种常见的判别方法,是一一个有监督学习模型,通常用来进行模式识别,分类以及回归分析。通过找到支持向量从而获得分类平面的方法,称为支持向量机。可以非常成功地处理回归(时间序列分析)和模式识别(分类问题、判别分析)等诸多问题,并可推广到预测和综合评价等领域,因此可应用于理

最新CUDA/cuDNN与Pytorch保姆级图文安装教程(速查字典版)

最新CUDA/cuDNN与Pytorch保姆级图文安装教程:CUDA下载、安装、多版本切换、卸载;解析CUDA、cuDNN、NVIDIA驱动、Pytorch间的版本对应关系

精益求精——斐波那契数列的logn解法

利用数学归纳法证明斐波那契数列的恒等式,并且使用时间复杂度为对数阶的算法求解斐波那契数列

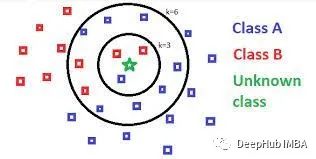

使用KNN进行分类和回归

一般情况下k-Nearest Neighbor (KNN)都是用来解决分类的问题,其实KNN是一种可以应用于数据分类和预测的简单算法,本文中我们将它与简单的线性回归进行比较。

浅淡数据结构时间复杂度和空间复杂度

浅淡数据结构时间复杂度和空间复杂度

GRAF论文解读

为了解决这个问题,最近的几种方法将基于中间体素的表示与可微渲染相结合。然而,现有方法要么产生低图像分辨率,要么无法解开相机和场景属性,例如,对象身份可能随视点而变化。在本文中,我们提出了一种辐射场的生成模型,该模型最近被证明在单个场景的新颖视图合成方面是成功的。

【自然语言处理(NLP)】基于FNN网络的电影评论情感分析

【自然语言处理(NLP)】基于FNN网络的电影评论情感分析,基于百度飞桨开发,参考于《自然语言处理实践》所作。

opencv训练自己的模型,实现特定物体的识别

opencv安装包中有训练好的分类器文件,可以实现人脸的识别。当然,我们也可以训练自己的分类器文件,实现对特定物体的识别。本文章就详细介绍下如何训练自己的分类器文件。

[机器学习、Spark]Spark MLlib实现数据基本统计

MLlib提供了很多统计方法,包含摘要统计、相关统计、分层抽样、假设检验、随机数生成等统计方法,利用这些统计方法可帮助用户更好地对结果数据进行处理和分析MLlib三个核心功能:1.实用程序:统计方法,如描述性统计、卡方检验、线性代数、模型评估方法等2.数据准备:特征提取、变换、分类特征的散列和一些自

机器学习之神经网络的公式推导与python代码(手写+pytorch)实现

因为要课上讲这东西,因此总结总结,发个博客模型图假设我们有这么一个神经网络,由输入层、一层隐藏层、输出层构成。(这里为了方便,不考虑偏置bias)输入特征为xn输入层与隐藏层连接的权重为vij隐藏层的输出(经过激活函数)为ym隐藏层与输出层连接的权重为wjk输出层的预测值(经过激活函数)为ol隐藏层

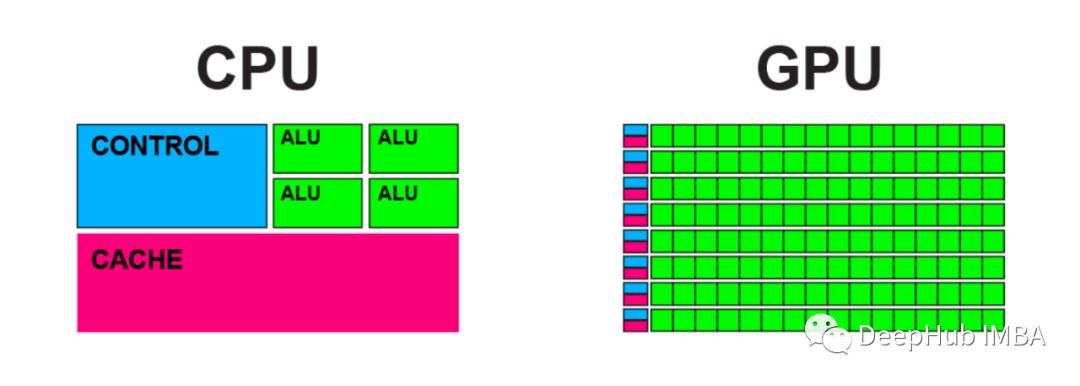

比较CPU和GPU中的矩阵计算

GPU 计算与 CPU 相比能够快多少?在本文中,我将使用 Python 和 PyTorch 线性变换函数对其进行测试。

详解摄像头的构造

一、摄像头简介 摄像头(CAMERA)又称为电脑相机、电脑眼等,它作为一种视频输入设备,在过去被广泛的运用于视频会议、远程医疗及实时监控等方面。近年以来,随着互联网技术的发展,网络速度的不断提高,再加上感光成像器件技术的成熟并大量用于摄像头的制造上,这使得它的价格降到普通人可以承受的水平。普通的人

RoboCom机器人大赛使用yolov5抽取20个随机图片进行人群识别

YOLOv5是一个在COCO数据集上预训练的物体检测架构和模型系列,它代表了Ultralytics对未来视觉AI方法的开源研究,其中包含了经过数千小时的研究和开发而形成的经验教训和最佳实践。YOLOv5是一种单阶段目标检测算法,该算法在YOLOv4的基础上添加了一些新的改进思路,使得其速度与精度都得

Bishop 模式识别与机器学习读书笔记_ch1.1 机器学习概述

Bishop著作 《Pattern Recognition and Machine Learning》 读书笔记

数字图像处理——基本运算

相邻像素(对于像素p(m,n))像素邻接:像素的相邻仅说明了两个像素在位置上的关系,若再加上取值相同或相近,则称两个像素邻接。

基于Matlab使用雷达和摄像头对公路车辆跟踪仿真(附源码)

此外,通过使用多个检测,跟踪器可以估计每个物体的位置,速度,尺寸和方向。由于在函数中为车辆尺寸定义了更高的确定性,因此即使最佳拟合的椭圆具有非常低的长度,跟踪器也不会折叠这些车辆的长度。与点对象跟踪器(通常考虑检测的一个分区(簇))相反,跟踪器PHD创建一组检测的多个可能分区,并根据PHD滤波器中的

openGauss 3.1.0 的新型选择率模型大解密

国产数据库openGauss 9.30日新出了3.1.0版本,有哪些新的特性呢?我们计划出个系列详细介绍一下,期望大家多多支持~选择率估算作为代价模型行数估算的基础,其准确性影响着优化器查询计划的选取,数据库优化器生成的不同查询计划之间可以达到数个数量级的区别。

【自然语言处理(NLP)】基于PaddleNLP的短文本相似度计算

【自然语言处理(NLP)】基于PaddleNLP的短文本相似度计算,基于百度飞桨开发,参考于《自然语言处理实践》所作。

pytorch模型保存、加载与续训练

最近,看到不少小伙伴问pytorch如何保存和加载模型,其实这部分pytorch官网介绍的也是很清楚的,感兴趣的点击☞☞☞了解详情🥁🥁🥁 但是肯定有很多人是不愿意看官网的,所以我还是花一篇文章来为大家介绍介绍。当然了,在介绍中我会加入自己的一些理解,让大家有一个更深的认识。如果准备好了的话

Opencv实战项目:13 手部追踪

这是一个比较基础的项目,我们将在后面对它进行一个拓展,有很多的计算机视觉的游戏都可以根据这个来创立,比如贪吃蛇、水果忍者、虚拟拖拽等上周由于事情较多,上周没有更新,而且最近的学校里的功课也要做,所以很抱歉,今天的这个项目我觉得很有用,就比如在这之后的一些项目也会用到,到时候可以做很多有趣的项目。