深度解析:什么是Diffusion Model?

©PaperWeekly 原创 ·作者 |鬼谷子引言在上一篇基于流的深度生成模型中详解介绍了有关流的生成模型理论和方法。目前为止,基于 GAN 生成模型,基于 VAE 的生成模型,以及基于 flow 的生成模型它们都可以生成较高质量的样本,但每种方法都有其局限性。GAN 在对抗训练过程中会出现模式崩

GAN(生成对抗网络)的系统全面介绍(醍醐灌顶)

本文是关于GAN学习的较为系统全面的介绍,主要针对初学者,希望能够对大家带来帮助。

物理信息神经网络PINNs : Physics Informed Neural Networks 详解

本博客主要分为两部分:1、PINN模型论文解读2、PINN模型相关总结一、PINN模型论文解读1、摘要:基于物理信息的神经网络(Physics-informed Neural Network, 简称PINN),是一类用于解决有监督学习任务的神经网络,同时尊重由一般非线性偏微分方程描述的任何给定的物理

Yolov5--从模块解析到网络结构修改(添加注意力机制)

文章目录1.模块解析(common.py)01. Focus模块02. CONV模块03.Bottleneck模块:04.C3模块05.SPP模块2.为yolov5添加CBAM注意力机制最近在进行yolov5的二次开发,软件开发完毕后才想着对框架进行一些整理和进一步学习,以下将记录一些我的学习记录。

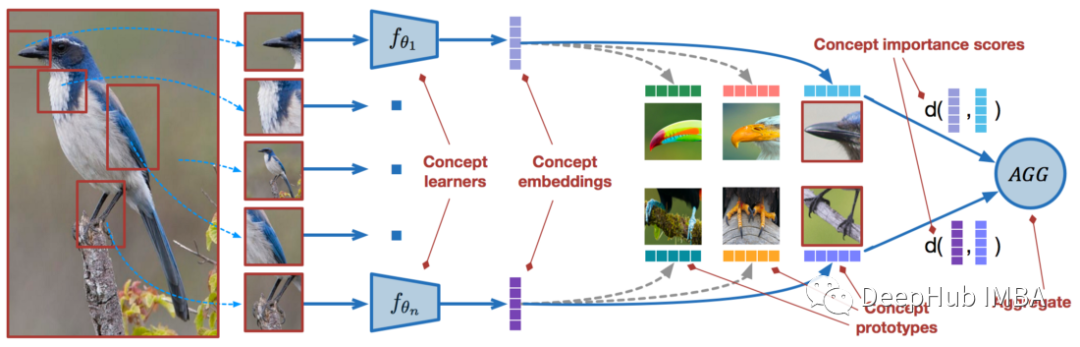

使用PyTorch进行小样本学习的图像分类

我们将从几个样本中学习的问题被称为“少样本学习 Few-Shot learning”。我们将从几个样本中学习的问题被称为“少样本学习 Few-Shot learning”。少样本学习是机器学习的一个子领域。

神经网络对多变量的性别结果预测

神经网络这几年可谓是火得一塌糊涂,它是目前最为火热的研究方向——深度学习的基础。在神经网络刚被发明之初,人们欢呼雀跃,认为是创造出来了比人更强的思维怪兽。它类比于人的神经元的工作方式,通过信号传递,不断调整权重,最终输出结果!本文将根据一个多参数预测男女性别的实际案例向大家!

基于深度学习的Deepfake检测综述

在过去的几年里已经进行了数百项研究,发明和优化各种使用 AI 的 Deepfake 检测,本文主要就是讨论如何对 Deepfake 进行检测

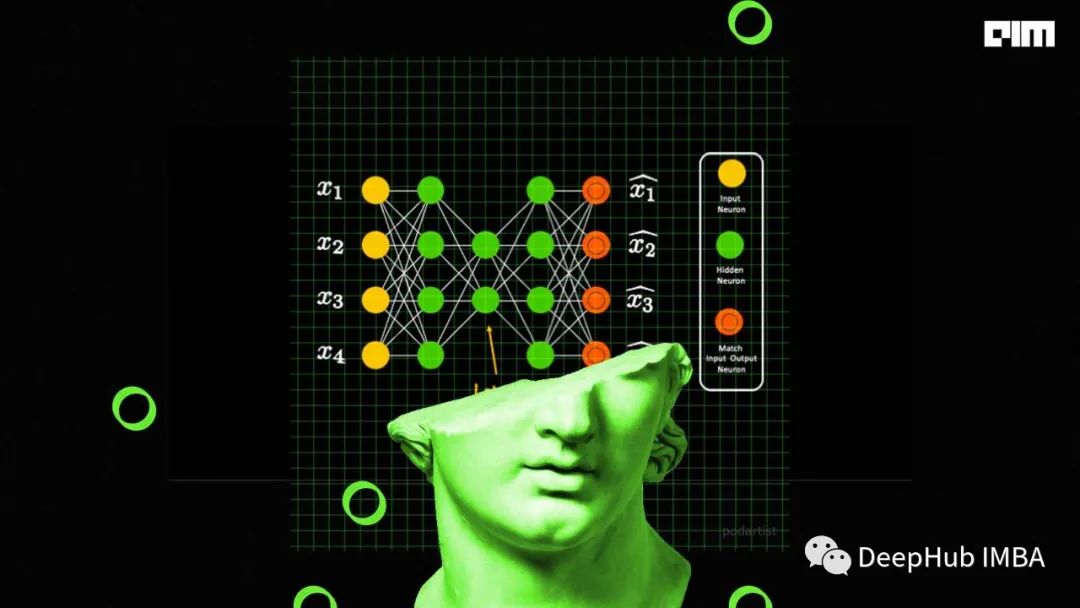

机器学习之神经网络的公式推导与python代码(手写+pytorch)实现

因为要课上讲这东西,因此总结总结,发个博客模型图假设我们有这么一个神经网络,由输入层、一层隐藏层、输出层构成。(这里为了方便,不考虑偏置bias)输入特征为xn输入层与隐藏层连接的权重为vij隐藏层的输出(经过激活函数)为ym隐藏层与输出层连接的权重为wjk输出层的预测值(经过激活函数)为ol隐藏层

构建基于Transformer的推荐系统

使用基于BERT的模型构建基于协同过滤的推荐系统

持续学习常用6种方法总结:使ML模型适应新数据的同时保持旧数据的性能

持续学习是指在不忘记从前面的任务中获得的知识的情况下,按顺序学习大量任务的模型。

训练深度学习神经网络的常用5个损失函数

损失函数的选择与神经网络模型从示例中学习的特定预测建模问题(例如分类或回归)有关。在本文中我们将介绍常用的一些损失函数

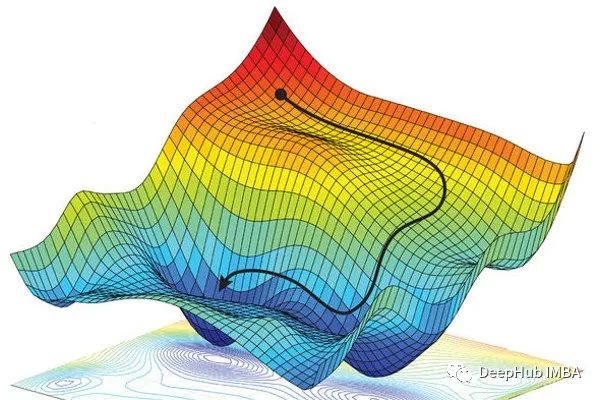

BP反向传播网络

本文介绍了如何通过反向传播误差修正模型参数,从梯度下降法等原理处学习如何进行反向传播,进而了解为什么模型参数的修正和激活函数相关。

在线薅 达摩院-人工智能训练师(高级)证书

人工智能训练师(高级)

使用PyG进行图神经网络的节点分类、链路预测和异常检测

在这篇文章中,我们将回顾节点分类、链接预测和异常检测的相关知识和用Pytorch Geometric代码实现这三个算法。

带掩码的自编码器(MAE)最新的相关论文推荐

7-9月的MAE相关的9篇论文推荐

生成模型VAE、GAN和基于流的模型详细对比

生成算法有很多,但属于深度生成模型类别的最流行的模型是变分自动编码器(VAE)、gan和基于流的模型。

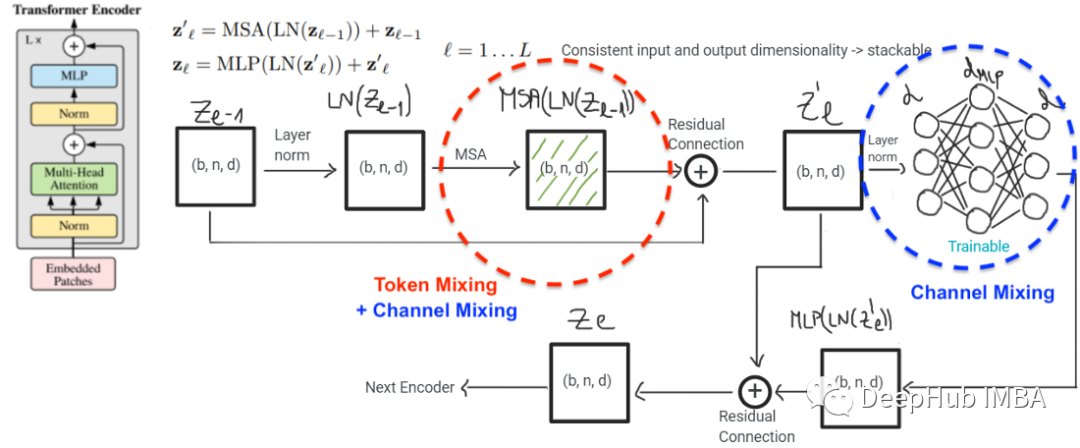

Vision Transformer和MLP-Mixer联系和对比

本文的主要目标是说明MLP-Mixer和ViT实际上是一个模型类,尽管它们在表面上看起来不同。

深度学习模型理解-CNN-手写数据字代码

图像(不同的数据窗口数据)和滤波矩阵(一组固定的权重:因为每个神经元的多个权重固定,所以又可以看做一个恒定的滤波器filter)做内积(逐个元素相乘再求和)的操作就是所谓的『卷积』操作,也是卷积神经网络的名字来源。非严格意义上来讲,下图中红框框起来的部分便可以理解为一个滤波器,即带着一组固定权重的神

GAM注意力机制

GAM解析,使用Pytorch实现GAM attention

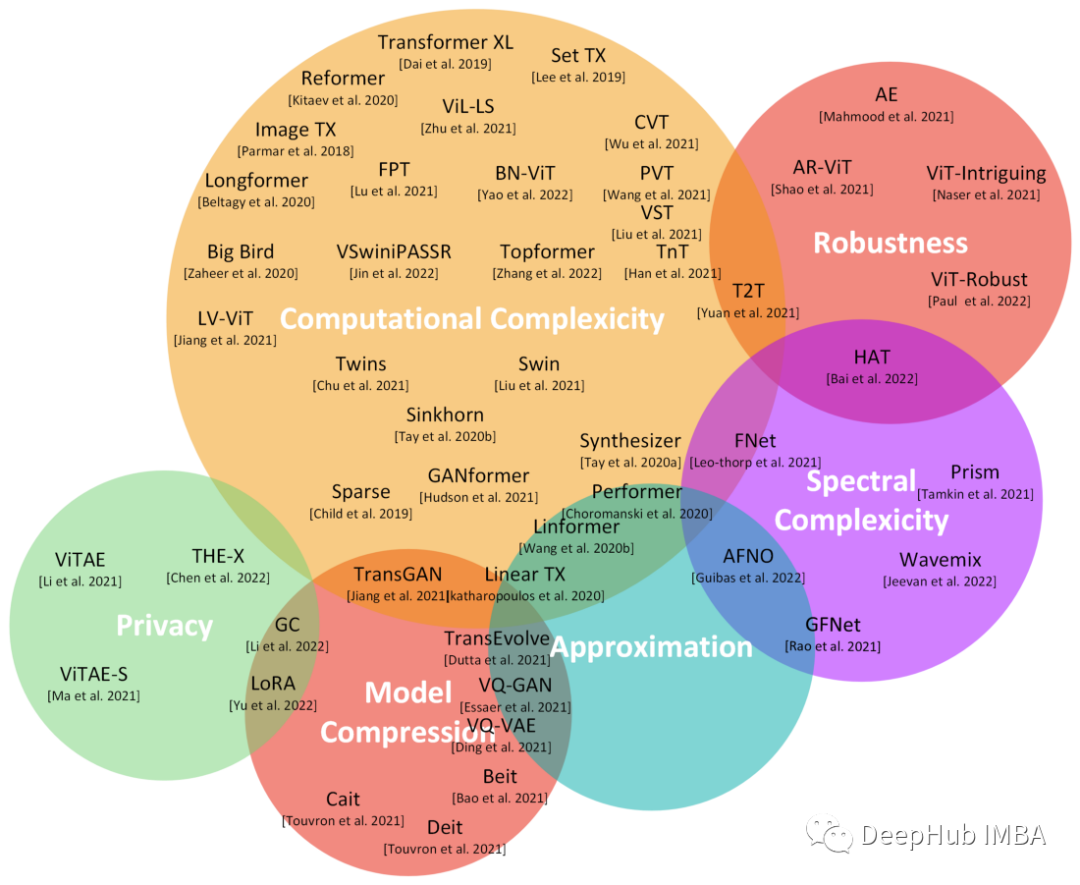

transformers的近期工作成果综述

在本文中,对基于transformer 的工作成果做了一个简单的总结,将最新的transformer 研究成果(特别是在2021年和2022年发表的研究成果)进行详细的调研。