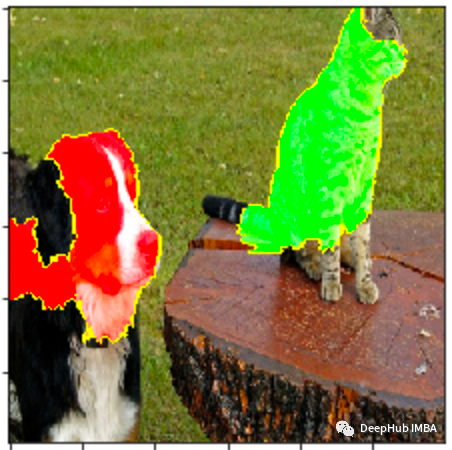

使用LIME解释CNN

图像与表格数据集有很大不同,我们用突出显示图像中模型预测的重要区域的方法观察可解释性

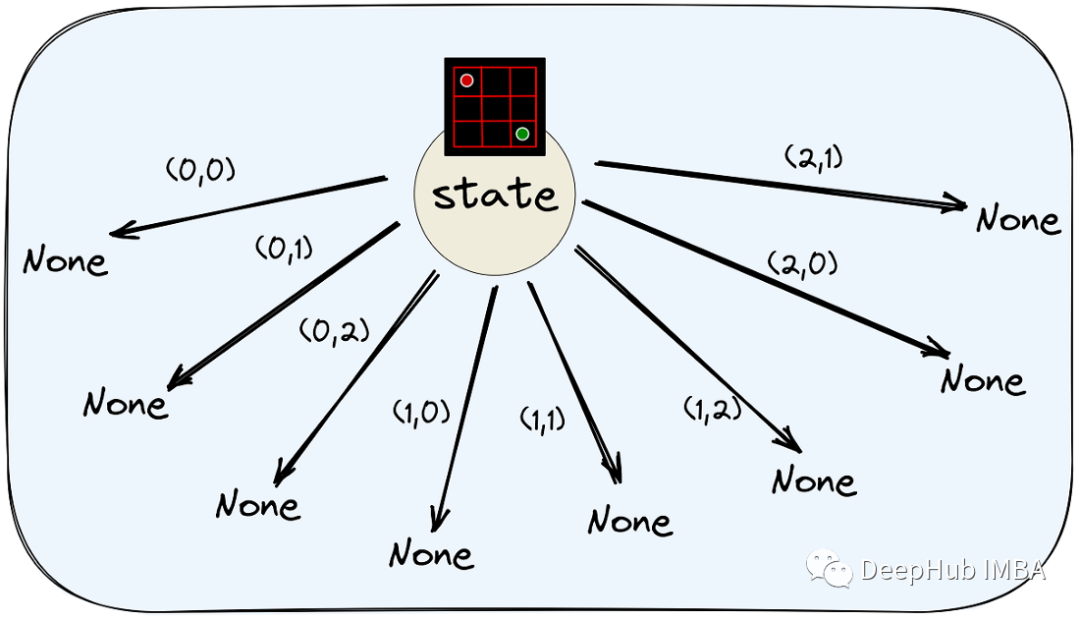

使用PyTorch实现简单的AlphaZero的算法(2):理解和实现蒙特卡洛树搜索

本篇文章将实现AlphaZero的核心搜索算法:蒙特卡洛树搜索

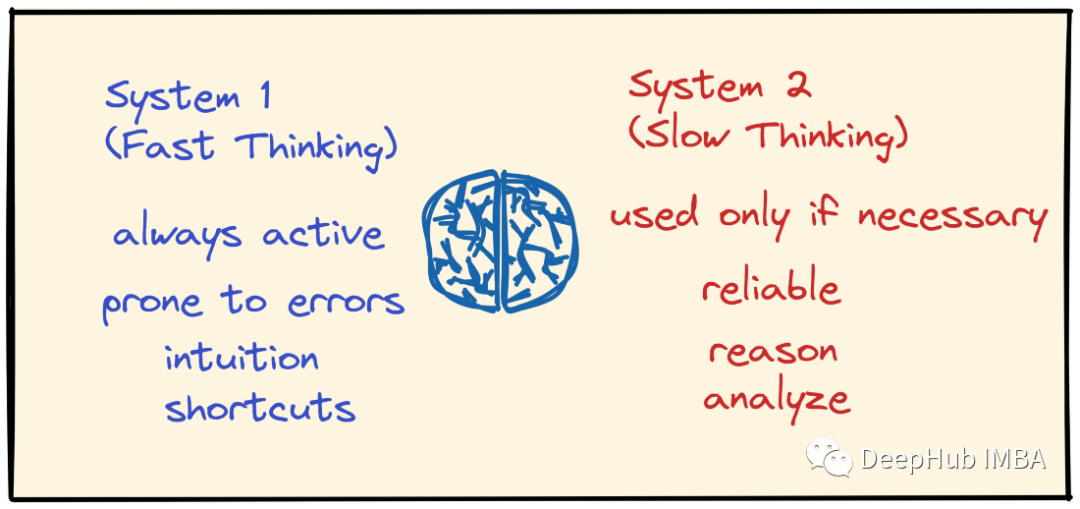

使用PyTorch实现简单的AlphaZero的算法(1):背景和介绍

在本文中,我们将在PyTorch中为Chain Reaction[2]游戏从头开始实现DeepMind的AlphaZero[1]。

论文推荐:基于GE-MRI的多任务学习

医学图像分析,多任务学习,图像分类,图像分割,U-Net,后处理

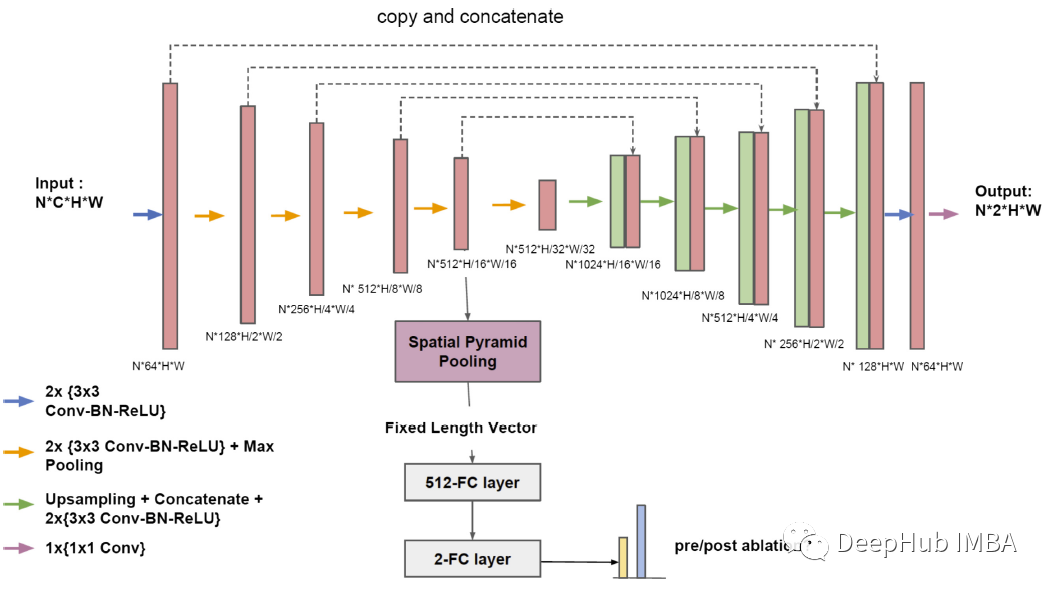

语义分割系列6-Unet++(pytorch实现)

本文介绍了Unet++网络,在pytorch框架上复现Unet++,并在Camvid数据集上进行训练。

用pointnet++分类自己的点云数据

这篇博客主要是针对于现有的热门的激光点云处理算法pointnet++如何分类自己的数据集展开的。在介绍基本的pointnet++算法的概念、基本步骤及思想、部分代码讲解之后,会介绍如何使用自己的数据集进行分类(涉及到详细的代码改进方法及步骤)以及打印利用自己数据集跑出的模型后的点云坐标。

利用LSTM实现预测时间序列(股票预测)

目录1、作者介绍2、tushare 简介3、LSTM简介3.1 循环神经网络 (Recurrent Neural Networks)3.2 LSTM网络3.2.1 LSTM的核心思想3.2.2 一步一步理解LSTM4 代码实现4.1 导入相关资源包4.2 定义模型结构4.3 制作数据集4.4 模型

BP神经网络预测实例(matlab代码,神经网络工具箱)

目录辛烷值的预测matlab代码实现工具箱实现参考学习b站:数学建模学习交流bp神经网络预测matlab代码实现过程辛烷值的预测【改编】辛烷值是汽油最重要的品质指标,传统的实验室检测方法存在样品用量大,测试周期长和费用高等问题,不适用于生产控制,特别是在线测试。近年发展起来的近红外光谱分析方法(NI

人工智能学习——模糊控制

模糊控制文章目录模糊控制前言一、模糊控制是什么?与神经网络的区别?二、模糊控制原理1.模糊化2.模糊规则3.模糊推理4.解模糊化三、模糊控制算法实例解析(含代码)1、选择观测量和控制量参考前言鉴于个人学习方向并不在此,所以此文章仅作为个人学习笔记使用,主要介绍理论以及学习过程,仅供参考!一、模糊控制

要点初见:AI绘图工具的部署资源、攻略整理(下篇)

本篇主要整理AI绘图工具的部署攻略,博主挑选了一些易于实操的文章方便大家在自己的平台上玩转开源AI绘图工具——Disco Diffusion、Stable Diffusion。

深度学习中的FPN详解

深度学习入门小菜鸟,希望像做笔记记录自己学的东西,也希望能帮助到同样入门的人,更希望大佬们帮忙纠错啦~侵权立删。一、提示:这里可以添加本文要记录的大概内容:例如:随着人工智能的不断发展,机器学习这门技术也越来越重要,很多人都开启了学习机器学习,本文就介绍了机器学习的基础内容。提示:以下是本篇文章正文

一键上手时下最火AI作画工具

在华为云ModelArts上, 无需考虑计算资源、环境的搭建,就算不懂代码,也能按照教程案例,通过Stable Diffusion成为艺术大师。

常用的激活函数(Sigmoid、Tanh、ReLU等)

目录一、激活函数定义二、梯度消失与梯度爆炸 1.什么是梯度消失与梯度爆炸2.梯度消失的根本原因3.如何解决梯度消失与梯度爆炸问题 三、常用激活函数1.Sigmoid2.Tanh3.ReLU4.Leaky ReLU5.ELU6.softmax7.Swish 激活函数 (Activatio

在CPU上跑yolov5(详细步骤+适合入门)

非常详细的步骤,适合新手,不要一天就可以跑通!

神经网络与深度学习

神经网络与深度学习复习

yolov7开源代码讲解--训练代码

以前看CNN训练代码的时候,往往代码比较易懂,基本很快就能知道各个模块功能,但到了后面很多出来的网络中,由于加入了大量的trick,导致很多人看不懂代码,代码下载以后无从下手。训练参数和利用yaml定义网络详细过程可以看我另外的文章,都有写清楚。其实不管什么网络,训练部分大体都分几个部分:1.网络的

YOLOv5训练自己的数据集详解

入门小菜鸟,希望像做笔记记录自己学的东西,也希望能帮助到同样入门的人,更希望大佬们帮忙纠错啦~侵权立删。一、YOLOv5源码下载网址指路:GitHub - ultralytics/yolov5: YOLOv5 ???? in PyTorch > ONNX > CoreML > TF

特征融合的分类和方法

1、特征融合的定义特征融合方法是模式识别领域的一种重要的方法,计算机视觉领域的图像识别问题作为一种特殊的模式分类问题,仍然存在很多的挑战,特征融合方法能够综合利用多种图像特征,实现多特征的优势互补,获得更加鲁棒和准确性的识别结果。2、特征融合的分类按照融合和预测的先后顺序,分类为早融合和晚融合(Ea

神经网络算法基本原理及其实现

目录背景知识人工神经元模型激活函数网络结构工作状态学习方式BP算法原理算法实现(MATLAB)背景知识在我们人体内的神经元的基本结构,相信大家并不陌生,看完下面这张图,相信大家都能懂什么是人工神经网络?人工神经网络是具有适应性的简单神经元组成的广泛并互连的网络,它的组织能够模拟生物神经系统对真实世界

DNN(全连接神经网络)

一.DNN网络一般拥有三层1.输入层2.隐藏层3.输出层简单网络如下:二.正向传播从第二层开始,每一个神经元都会获得它上一层所有神经元的结果。即每一个 y = wx + b的值。具体分析如下:如此下去就会非常可能出现了一个问题------就是越靠后的神经元获得的y值会非常大,试想一下,如果这个数远远