深度学习|卷积神经网络

介绍卷积神经网络基本理论,包括卷积层、池化层和全连接层,并阐述LeNet卷积神经网络的构建过程。

模态对齐与融合

思考:多模态本质就是alignment(对齐),那么问题就在于如何做对齐。有用entity的,有用attention的,有用event做alignment,然后再做fusion(融合)。融合有多种方法,例如Linking、Grounding、Structure等。感觉很多是简单粗暴的把represe

【AI】《动手学-深度学习-PyTorch版》笔记(二十):图像增强、微调

微调属于迁移学习的一种,在已经从大量数据集上训练出来的模型上继续训练自己的小数据集,继承已经学习到的边缘、纹理、形状等信息。通过对图像进行随机裁剪,使物体以不同的比例出现在图像的不同位置。

loss = nn.CrossEntropyLoss(reduction=‘none‘)

reduction 参数用于控制输出损失的形式。

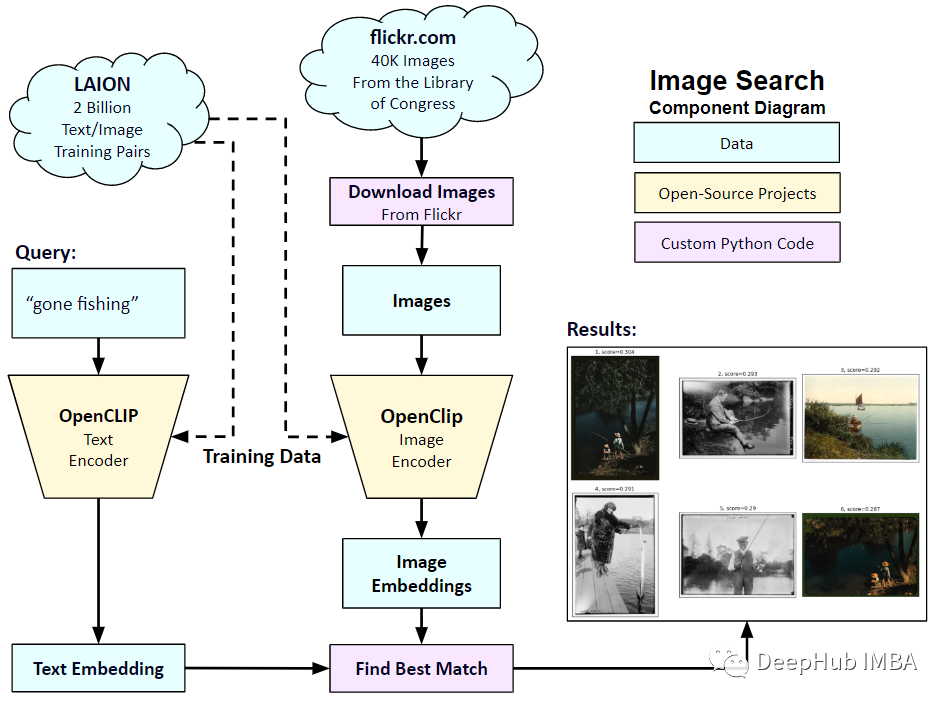

在自定义数据集上实现OpenAI CLIP

在本文中,我们将使用PyTorch中从头开始实现CLIP模型,以便我们对CLIP有一个更好的理解

Autolabelimg自动标注工具

在做机器视觉有监督方面,通常会面对很多数据集,然后去进行标注,而有些时候我们面对庞大数量数据集的情况下也会感到十分头疼,这个时候Autolabelimg这个自动标注神器就应运而生了。让我们可以实现批量处理图片和标注文件。

Swin-Transformer 实战代码与讲解(快速上手)

Swin Transformer是2021年微软研究院发表在ICCV上的一篇文章,并且已经获得ICCV 2021 best paper的荣誉称号。它可以作为计算机视觉的通用backbone,并且在很多视觉底层任务中取得了Sota的水准。

Langchain的一些问题和替代选择

Langchain因其简化大型语言模型(llm)的交互方面的到关注。凭借其高级的API可以简化将llm集成到各种应用程序中的过程。

YoloV5 训练长方形图像

YOLO训练长方形图像

InternImage segmentation部分代码复现及训练自己的数据集(一)

算法InternImage复现细节。

【Linear Probing | 线性探测】深度学习 线性层

深度学习linear probing

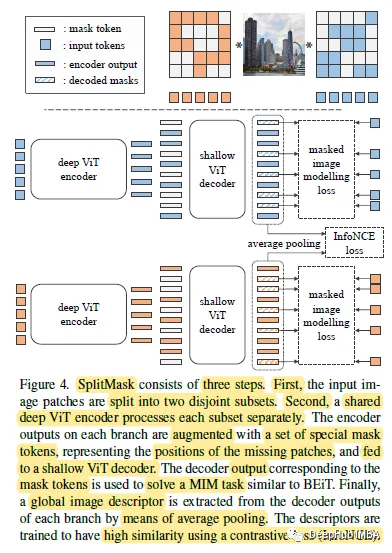

SplitMask:大规模数据集是自我监督预训练的必要条件吗?

自监督预训练需要大规模数据集吗?这是2021年发布的一篇论文,提出了一种类似于BEiT的去噪自编码器的变体SplitMask,它对预训练数据的类型和大小具有更强的鲁棒性。

重新安装CUDA;解决cudart64_100.dll not found问题

重新安装CUDA;解决cudart64_100.dll not found问题;cuda版本10.2;cuda降版本

Stable Diffusion 迁移和部署

Stable Diffusion迁移和部署

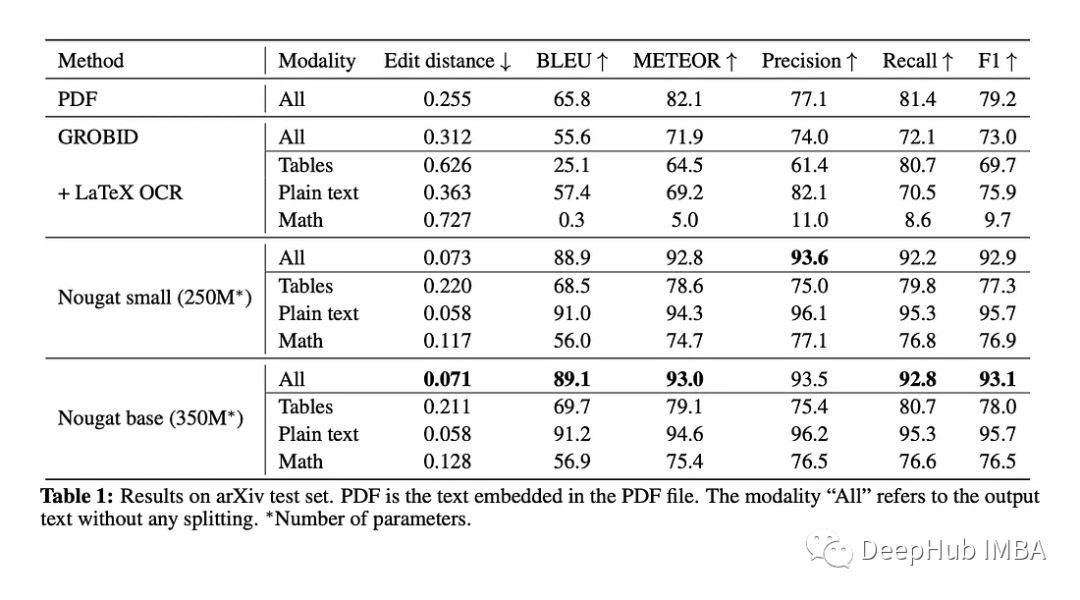

Nougat:一种用于科学文档OCR的Transformer 模型

Nougat是一种VIT模型。它的目标是将这些文件转换为标记语言,以便更容易访问和机器可读。

液体神经网络LLN:通过动态信息流彻底改变人工智能

在在人工智能领域,神经网络已被证明是解决复杂问题的非常强大的工具。多年来,研究人员不断寻求创新方法来提高其性能并扩展其能力。其中一种方法是液体神经网络(LNN)的概念,这是一个利用动态计算功能的迷人框架。在本文中,我们将深入研究 LNN 的世界,探索它们的基本原则,讨论它们的优势,并提供一个代码实现

PointPillars 工程复现

PointPillars 工程复现, 学习并复现PointPillars,解决部署时遇到的各类问题。

tensorflow如何使用gpu

tensorflow查看GPU的数量、使用GPU加速,单GPU模拟多GPU环境等

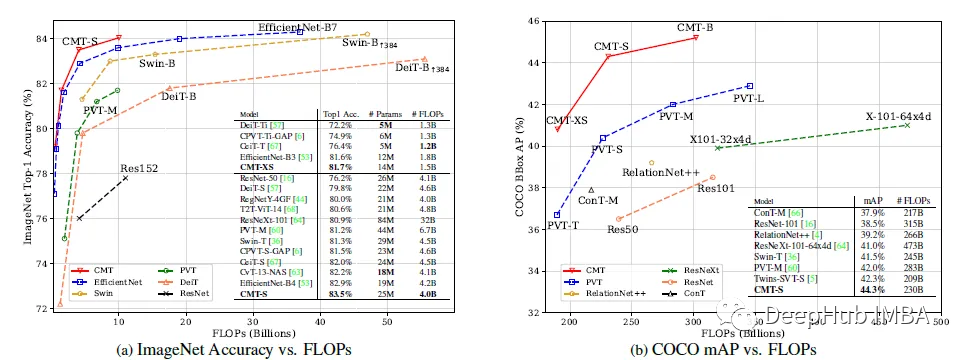

CMT:卷积与Transformers的高效结合

论文提出了一种基于卷积和VIT的混合网络,利用Transformers捕获远程依赖关系,利用cnn提取局部信息。构建了一系列模型cmt,它在准确性和效率方面有更好的权衡。

特定场景小众领域数据集之——焊缝质量检测数据集

特定场景小众领域数据集之——焊缝质量检测数据集