归一化(Normalization)

归一化是一种数据处理方式,能将数据经过处理后限制在某个固定范围内。归一化存在两种形式,一种是在通常情况下,将数处理为 [0, 1] 之间的小数,其目的是为了在随后的数据处理过程中更便捷。例如,在图像处理中,就会将图像从 [0, 255] 归一化到 [0, 1]之间,这样既不会改变图像本身的信息储存,

深度学习中常用的损失函数(一) —— MSELoss()

MSELoss() 损失函数学习笔记

注意力机制

在神经网络学习中,一般而言模型的参数越多则模型的表达能力越强,模型所存储的信息量也越大,但这会带来信息过载的问题。通过引入注意力机制,在众多的输入信息中聚焦于对当前任务更为关键的信息,降低对其他信息的关注度,甚至过滤掉无关信息,就可以解决信息过载问题,并提高任务处理的效率和准确性。

自监督表征学习方法——DINO方法

在这项工作中,我们展示了自监督预训练一个标准ViT模型的潜力,实现的性能是与为此设置设计的最佳凸网相媲美的。我们还看到了两个可以在未来应用中利用的特性:k-NN分类中特征的质量具有图像检索的潜力,其中ViT已经显示出了有希望的结果。然而,本文的主要结果是,我们有证据表明,自我监督学习可能是开发一个基

从GPU的内存访问视角对比NHWC和NCHW

NHWC和NCHW之间的选择会影响内存访问、计算效率吗?本文将从模型性能和硬件利用率来尝试说明这个问题。

华为开源自研AI框架昇思MindSpore应用案例:分布式并行训练基础样例(CPU)

华为开源自研AI框架昇思MindSpore应用案例:分布式并行训练基础样例

U-Net 模型改进和应用场景研究性综述

参考之前的一篇文章:U-Net代码练习结构性改进就三种情况,编码器解码器改进,跳连接改进,以及模型整体结构改进;大 部 分 改 进 工 作是在原有模块的基础上,增加残差模块、Dense 模 块 、Inception 模 块 、Attention 模 块 等 经 典 网 络 模 块 , 或 综 合 运

使用python实现LDA线性判别分析

LDA(Linear Discriminant Analysis)线性判别分析是一种监督学习的线性分类算法,它可以将一个样本映射到一条直线上,从而实现对样本的分类。LDA的目标是找到一个投影轴,使得经过投影后的两类样本之间的距离最大,而同一类样本之间的距离最小。LDA的过程可以分为以下几步:1.计算

【人工智能】深度强化学习的新突破:如何打造智能决策系统

在深度强化学习中,有很多的概念和术语需要我们去了解。本文介绍了深度强化学习技术的相关概念、原理及应用,以及如何使用深度强化学学实现智能决策系统。在深度强化学习中,模型设计、数据集选择、模型评估和应用场景都是需要我们注意的重要因素。通过实际案例的演示,我们可以看到深度强化学习技术在实践中的应用和实现过

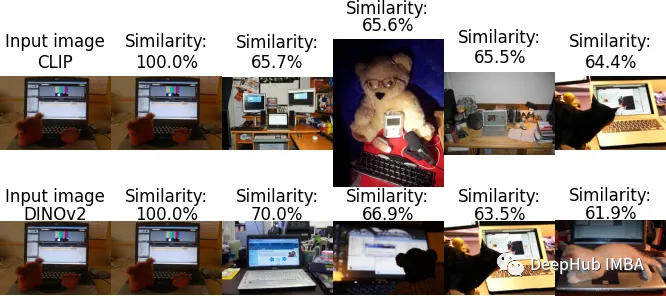

CLIP与DINOv2的图像相似度对比

在本文中,我们将探讨CLIP和DINOv2的优势和它们直接微妙的差别。我们的目标是发现哪些模型在图像相似任务中真正表现出色。

【人工智能】大模型时代,程序员需要具备哪些技能才能胜任?

近年来,随着深度学习技术的飞速发展和计算能力的提升,大模型已经成为了人工智能领域的一个重要趋势。而在这个趋势中,程序员的技能需求也在不断变化和升级。本文将为大家介绍,在大模型时代,程序员需要具备哪些技能才能胜任。

图-文多模态,大模型,预训练

图-文任务是指需要同时处理图像和文本数据的任务,如图像描述、图像检索(image retrieval)、视觉问答(visual question answering)等。例如,图像描述(image captioning)就是一种典型的多模态任务,它需要根据给定的图像生成相应的文本描述。既不是单塔模型

python-matplotlib-箱线图为不同的箱体设置不同颜色

python-matplotlib-箱线图为不同的箱体设置不同颜色。

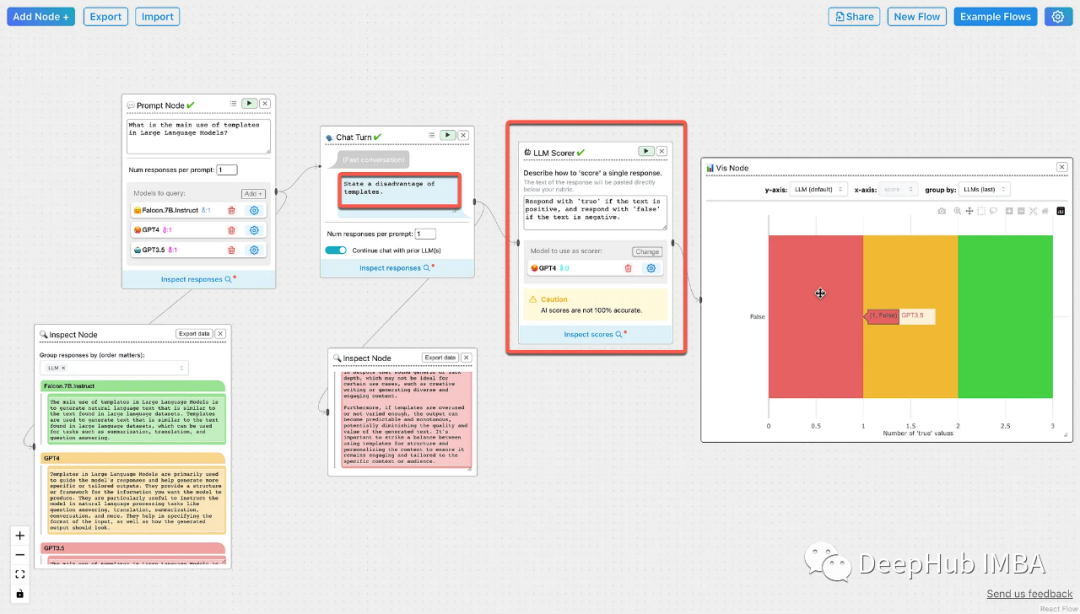

ChainForge:衡量Prompt性能和模型稳健性的GUI工具包

ChainForge是一个用于构建评估逻辑来衡量模型选择,提示模板和执行生成过程的GUI工具包。ChainForge可以安装在本地,也可以从chrome浏览器运行。

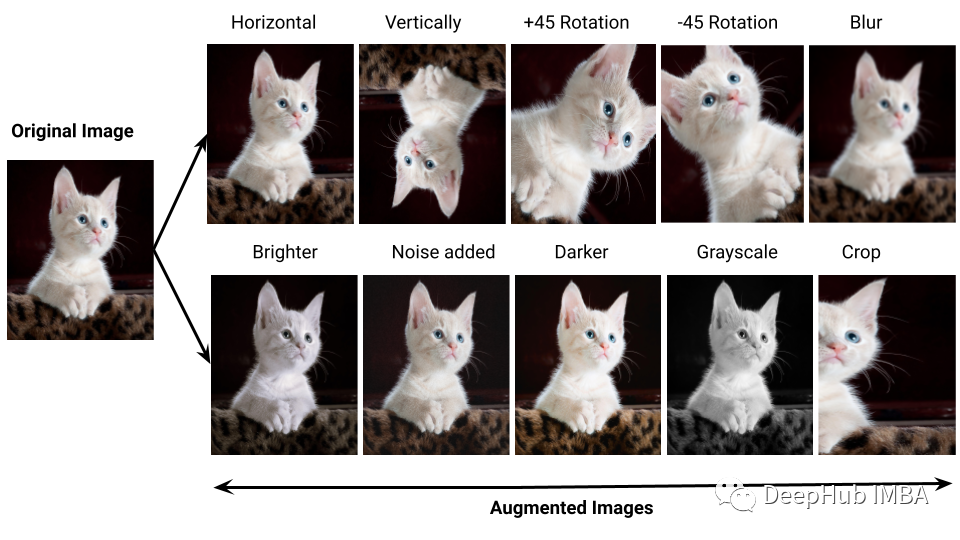

用于数据增强的十个Python库

在本文中,我们将介绍数据增强的十个Python库,并为每个库提供代码片段和解释。

【深入探究人工智能】:历史、应用、技术与未来

人工智能(Artificial Intelligence,AI作为一门前沿科技,正以惊人的速度深刻改变着我们的生活和社会。本篇将从人工智能的历史、应用、技术和未来四个方面深入探讨,同时也介绍一些当代的人工智能产物,带你领略AI技术的魅力与应用。当代的人工智能产物不断涌现,为我们的生活带来了越来越多的

范数详解-torch.linalg.norm计算实例

本文以torch.linalg.norm(),详细讲解二范数、F范数、核范数、无穷范数、L1范数、L2范数的定义和计算。

Huggingface Transformers Deberta-v3-base安装踩坑记录

huggingface deberta-v3-base下载踩坑记录

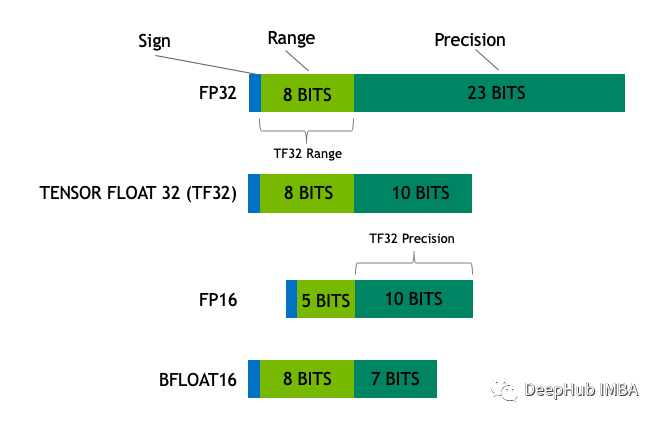

16,8和4位浮点数是如何工作的

在本文中,我们将介绍最流行的浮点格式,创建一个简单的神经网络,并了解它是如何工作的。

2023知识追踪最新综述来自顶刊!!!——《Knowledge Tracing:A Survey》

2023知识追踪最新综述——《Knowledge Tracing:A Survey》,文章发表在ACM Computing Survey上