【AI学习】陶哲轩在 2024 年第 65 届国际数学奥林匹克(IMO)的演讲:AI 与数学

陶哲轩介绍到被数学家接受并开始普及的方法:形式化证明辅助工具

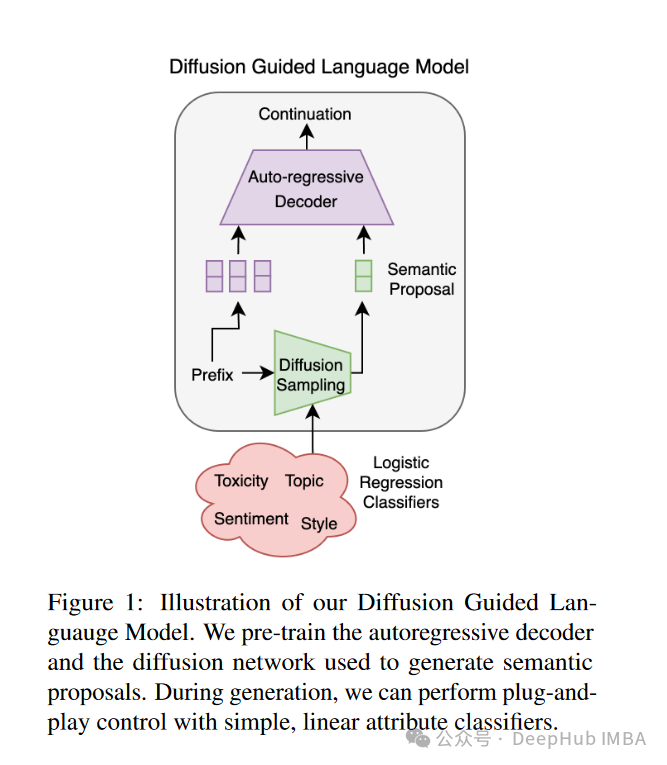

扩散引导语言建模(DGLM):一种可控且高效的AI对齐方法

扩散引导语言建模(Diffusion Guided Language Modeling, DGLM)。DGLM旨在结合自回归生成的流畅性和连续扩散的灵活性,为可控文本生成提供一种更有效的方法。

交叉熵损失与二元交叉熵损失:区别、联系及实现细节

在机器学习和深度学习中,交叉熵损失(Cross-Entropy Loss)和二元交叉熵损失(Binary Cross-Entropy Loss)是两种常用的损失函数,它们在分类任务中发挥着重要作用。本文将详细介绍这两种损失函数的区别和联系,并通过具体的代码示例来说明它们的实现细节。

大语言模型应用指南:从人工智能的起源到大语言模型

人工智能(Artificial Intelligence,AI)自诞生以来,一直是计算机科学领域的重要研究方向。早期的AI系统主要依赖于专家知识和规则库,通过逻辑推理和符号计算来解决问题。然而,这种基于规则的系统在处理复杂和多变的现实世界时,表现出了明显的局限性。随着数据量的爆炸式增长和计算能力的提

神经网络与深度学习深入剖析

神经网络(Neural Networks, NN)是一种模仿人脑工作原理的计算模型,它由大量的节点(或称为神经元)组成,这些节点通过层次化的方式组织成输入层、隐藏层和输出层。每个节点都与其他节点通过权重连接,并且每个节点都有一个激活函数,用于决定该节点是否被激活。

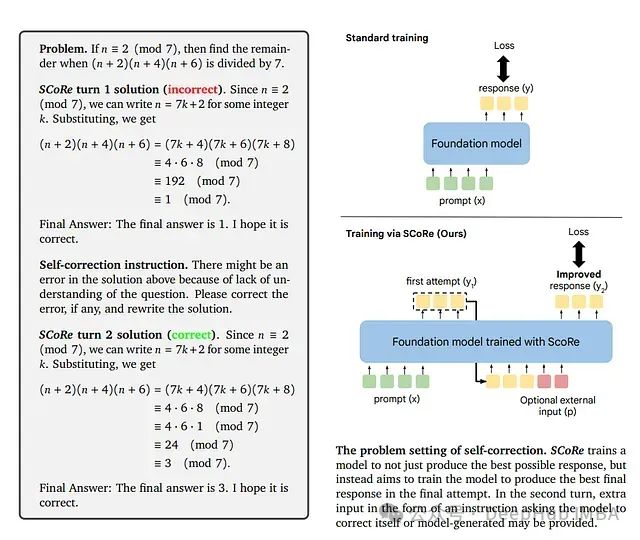

SCoRe: 通过强化学习教导大语言模型进行自我纠错

这是谷歌9月发布在arxiv上的论文,研究者们提出了一种新方法**自我纠错强化学习(SCoRe)**,旨在使大语言模型能够在没有任何外部反馈或评判的情况下"即时"纠正自己的错误。

【AI大模型】深入Transformer架构:编码器部分的实现与解析(上)

编码器部分:* 由N个编码器层堆叠而成 * 每个编码器层由两个子层连接结构组成 * 第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接 * 第二个子层连接结构包括一个前馈全连接子层和规范化层以及一个残差连接掩代表遮掩,码就是我们张量中的数值,它的尺寸不定,里面一般只有1和0的元素,

VisionTS:基于时间序列的图形构建高性能时间序列预测模型,利用图像信息进行时间序列预测

本文将讨论以下几个方面: - 图像如何在内部编码序列信息? - 利用预训练计算机视觉模型进行时间序列分析的概念 - ***VisionTS***:一种适用于时间序列数据的预训练Vision Transformer模型。

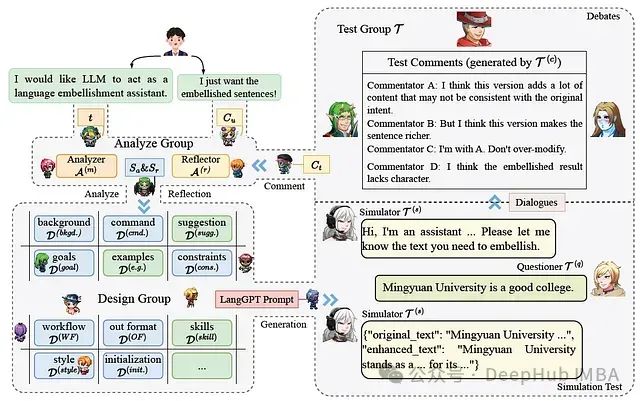

Minstrel自动生成结构化提示,让AI为AI写提示词的多代理提示生成框架

LangGPT作为一个结构化的提示设计框架,具有良好的系统性和可重用性,易于学习和使用。Minstrel能够通过多代理协作自动生成高质量的结构化提示,在某些情况下甚至超过人类专家的表现。结构化提示(无论是Minstrel生成还是手动编写)在指导LLMs执行任务时表现更好,特别是对于较大规模的模型。然

真的没有AI能通过草莓测试?GPT-4o也不行!

真的没有AI能通过草莓测试?GPT-4o也不行!

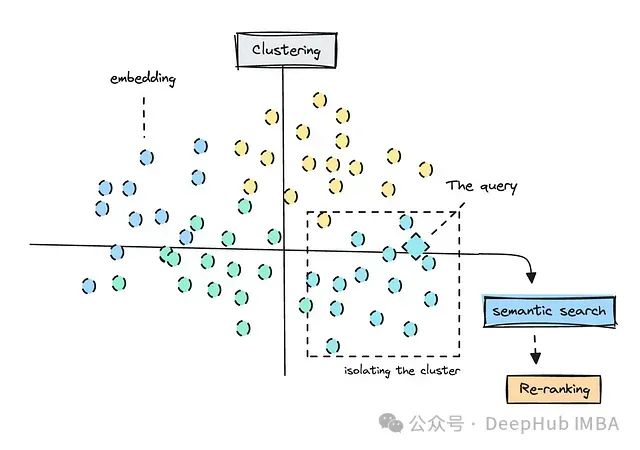

探索人工智能绘制宇宙地图的实现

由于它分析了距离地球很远的区域,因此得到的模拟结果反映了遥远的过去,揭示了有关天体在数千年间如何移动的新信息。虽然了解恒星很重要,但绘制行星表面的物理地图在短期内可能更有帮助,尤其是在太空探索兴起的情况下。随着模型通过更多数据得到改进,它们可以为更安全的太空旅行提供信息,或提供对太阳耀斑或超新星等活

时频分析法——连续小波变换(CWT)

连续小波变换利用一组基函数(称为小波)对信号进行分析。这些小波是由一个母小波通过平移和缩放生成的。母小波 ψ(t) 是一个平均值为零的波形,通常具有快速衰减的特性。通过调整缩放因子 a 和平移参数 b 来生成不同的小波,从而能够聚焦于信号的不同特性。小波变换可以定义为:其中f(t) 是输入信号;ψ(

天池 大模型逻辑推理 入门

第二届世界科学智能大赛逻辑推理赛道:复杂推理能力评估

机器学习,深度学习,AGI,AI的概念和区别

人工智能(AI)是指通过计算机系统模拟人类智能的技术和科学。AI的目标是创建能够执行通常需要人类智能的任务的系统,如视觉识别、语音识别、决策制定和语言翻译。AI的核心在于其能够处理和分析大量数据,从中提取有用的信息,并根据这些信息做出决策或预测。AI的发展可以追溯到20世纪50年代,当时科学家们开始

AI生成人脸图像鉴别-数据集(附网盘地址)

百度网盘地址:链接: https://pan.baidu.com/s/1_3j0OwQF63eznPH1RR596g?pwd=1234 提取码: 1234 复制这段内容后打开百度网盘手机App,操作更方便哦。该数据集有5000张真实人脸照片,尺寸为1024*1024像素,即比例为1:1,均为人工筛选

Minstrel自动生成结构化提示,让AI为AI写提示词的多代理提示生成框架

在人工智能快速发展的今天,如何有效利用大型语言模型(LLMs)成为了一个普遍关注的话题。这是9月份的一篇论文,提出了LangGPT结构化提示框架和Minstrel多代理提示生成系统,为非AI专家使用LLMs提供了强大支持。

Datawhale X 李宏毅苹果书 AI夏令营 Task2- 优化机器学习模型和深度学习初认识

一、初识线性模型在上一篇的Task1中,我们最后谈到了梯度下降在一维和二维情况下的过程,现在让我们进一步地讨论机器学习这个话题。Task1里,我们举了用今天的数值预测明天的观看量的例子,下面是根据真实数据所做的图,预测时所用到的模型函数是贴合现实的。从图中,我们可以清晰地看到红线与蓝线是几乎重合的,

斯坦福大学研究人员,推荐的课题申报AI提示词分享

请根据这份项目清单<插入项目>,为我的资助提案制定一个可行的项目时间表,用于我的职业发展计划,从<XX月>开始,为期<XX个月>。请就我如何满足这一评审标准:<插入具体评审标准>提供反馈,以及对我遗漏的内容和如何改进的建议。请就我如何满足这一评审标准:<插入具体评审标准>提供反馈,以及对我遗漏的内容

大模型API调用(一)简单用法

大模型API调用是指通过编程接口(API)访问大型人工智能模型,以实现自然语言处理、代码生成、内容创作等多种功能。大模型的API扮演了一个接口(Interface)的角色,它允许用户以编程方式与大模型进行交互,而无需深入了解模型内部的复杂结构和算法。这种模式类似于模型即服务(Model as a S