人工智能中的文本分类:技术突破与实战指导

在本文中,我们全面探讨了文本分类技术的发展历程、基本原理、关键技术、深度学习的应用,以及从RNN到Transformer的技术演进。文章详细介绍了各种模型的原理和实战应用,旨在提供对文本分类技术深入理解的全面视角。

PCA主成成分分析例题详解

主成分分析是一种降维算法,它能将多个指标转换为少数几个主成分,这些主成分是原始变量的线性组合,且彼此之间互不相关,其能反映出原始数据的大部分信息。

不确定性系统建模

不确定度可分为扰动信号和动态扰动两类。这种差异的典型来源包括未建模(通常是高频)动力学、建模中被忽视的非线性、故意简化模型的影响,以及由于环境变化和磨损因素引起的系统参数变化。usys = ucover(Parray,Pnom,ord)返回一个标称值为Pnom的不确定模型usys,其行为范围包括LT

AutoGluon安装及示例

Autogluon的发明人是李沐(Mu Li)和他在亚利桑那州立大学的研究团队。Autogluon是一种**自动化机器学习工具**, 可以同时支持两种模式:**迁移学习模式**和**自动机器学习模式**。

基于python的点云处理库总结

该软件包提供了Pythonic的,文档齐全的界面,该界面公开了VTK强大的可视化后端,以促进对空间参考数据集的快速原型制作,分析和可视化集成。Open3D的依赖项较少,可在不同的平台上编译与布置。/* ************************************** 以下的已经不维护或者

如何解决ChatGPT网络错误的问题,让AI对话更丝滑~

在当今人工智能技术的飞速发展中,ChatGPT 作为一款大型语言模型备受瞩目。近期,其在各大社交媒体平台上的表现更是引来了一片关注之声。无论是与用户进行有趣的对话,还是帮助人们解决实际问题,ChatGPT 展现出了其强大的自然语言处理能力和智能应用潜力。很多小伙伴都跃跃欲试,争先恐后体验一把与「人工

设计、训练、测试、部署,用Python手把手开发AI模型

释放 ML 模型的力量:使用 Python 进行设计、训练、测试和部署的指南

移动边缘网络中联邦学习效率优化综述

移动边缘网络中联邦学习效率优化综述

启发式算法之灰狼优化算法

灰狼优化算法(Grey Wolf Optimizer,GWO)是由自然界中灰狼群体的社会等级机制和捕猎行为而衍生出来的一种群体优化智能算法,目前已成功运用到车间调度、参数优化、图像分类等领域中。

Python中的实例属性和类属性

在这篇文章中,我们将探讨Python中的类是如何工作的,主要介绍实例和类的属性。这些属性是什么,它们之间的区别,以及创建和利用它们的python方法。

机器学习:iris数据集

iris数据集的中文名是安德森鸢尾花卉数据集,英文全称是Anderson`s Iris data set。iris包含150个样本,对应数据集的每行数据。每行数据包含每个样本的四个特征,所以iris数据集是一个150行4列的二维表。

【赠书第4期】机器学习与人工智能实战:基于业务场景的工程应用

介绍了如何用Scikit-Learn来构建机器学习模型以及如何用Keras和TensorFlow来构建神经网络。

火星探测器背后的人工智能:从原理到实战的强化学习

本文详细探讨了强化学习在火星探测器任务中的应用。从基础概念到模型设计,再到实战代码演示,我们深入分析了任务需求、环境模型构建及算法实现,提供了一个全面的强化学习案例解析,旨在推动人工智能技术在太空探索中的应用。

AI全栈大模型工程师(二)课程大纲

AI 大模型基础介绍 | 对大模型有直观的、基础的了解,以展开后续课程学习 | 大模型最基础的原理 | 搞定环境搭建和工具的使用 | 大模型并不神奇,也不神秘 || Prompt Engineerin

人工智能专栏第十讲——马尔可夫决策过程

马尔可夫决策过程的状态转移差异性是指状态转移概率在系统中具有某些特殊的性质,例如系统的状态只依赖于当前状态和执行的动作,而不与历史状态相关。它包括状态空间、动作空间、状态转移概率、奖励函数以及折扣因子等重要部分,通过这些基本概念的使用和推导,我们可以得到最优的决策策略。与状态空间不同的是,动作空间是

AI:53-基于机器学习的字母识别

人工智能技术在现代社会发挥着越来越重要的作用,其中基于机器学习的字母识别成为了研究的热点。本文将介绍如何利用神经网络实现字母识别的技术深度,并提供代码示例,帮助读者理解这一令人着迷的领域。字母识别是一项具有挑战性的任务,需要计算机能够从输入的图像中准确地识别出字母。机器学习通过训练模型来识别字母的方

“AI教父”Geoffrey Hinton:智能进化的下一个阶段

ChatGPT等大模型带来的震撼技术革新,让Geoffrey Hinton突然改变了自己的一个想法。这位75岁的“人工智能教父”意识到,数字智能优于生物智能的进程无法避免,超级智能很快就会到来,他必须要对其风险发出警示,而人类需要找到一种方法来控制AI技术的发展。而在此之前,他一直认为,智能机器人不

tensorflow基于Anaconda环境搭建详细教程

TensorFlow是一个由Google Brain团队开发的开源软件库,用于各种人工智能和机器学习应用,包括神经网络、深度学习、强化学习等。TensorFlow提供了一个灵活的编程框架,可用于创建各种类型的机器学习模型,如分类、回归、聚类、语音识别、自然语言处理等。TensorFlow基于图形计算

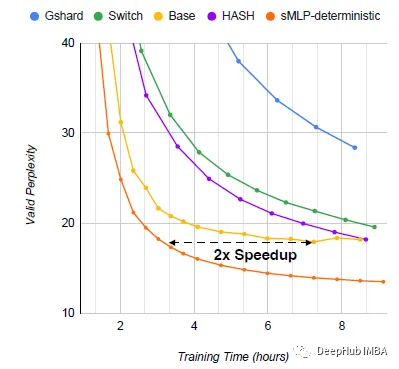

sMLP:稀疏全mlp进行高效语言建模

论文提出了sMLP,通过设计确定性路由和部分预测来解决下游任务方面的问题。

【兔子王赠书第7期】机器学习与人工智能实战:基于业务场景的工程应用

新的一周开始啦,本周博主给大家带来《机器学习与人工智能实战:基于业务场景的工程应用》,感兴趣的小伙伴快来看看吧!