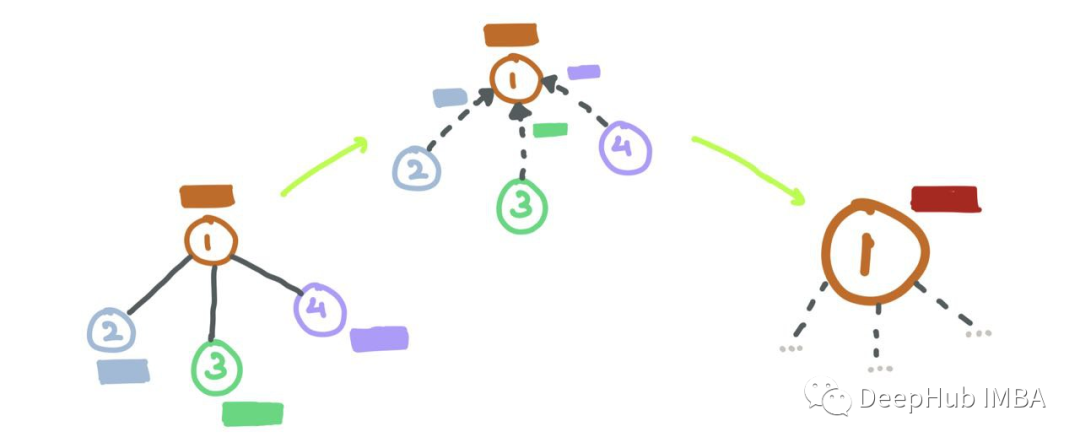

图神经网络的数学原理总结

图深度学习(Graph Deep Learning) 多年来一直在加速发展。本文将流行的图神经网络及其数学细微差别的进行详细的梳理和解释

22.信息系统安全管理-策略7定.方案.安全体系架构.PKI.PMI

信息系统安全管理的框架和内容

基于FPGA 的TDC设计更好的选择——易灵思Quantum架构FPGA

本文介绍了一家新的国产FPGA独特的架构,分析了在这种架构上构建TDC相对于传统FPGA的优势。

《ChatGPT是怎样炼成的》

ChatGPT的训练过程(后来呢,你有在晃神的瞬间想起我吗?)。

如果你持续大量的教坏ChatGPT,它确实会变坏

作为AI语言模型,我是不能像搜索引擎的爬虫一样主动地去收集数据的。总之,我的输出结果的准确性和实时性是由我的训练数据集和算法模型决定的,用户的纠正结果通常不会对其他用户的对话产生影响,但我的开发团队可能会将这些纠正结果用于改善我的训练数据集和算法模型,以进一步提高我的输出结果的准确性和实用性。如果一

MySQL基本查询

CRUD : Create(创建), Retrieve(读取), Update(更新), Delete(删除)

QEMU启动ARM32 Linux内核

QEMU启动ARM32 Linux内核

Java代码是如何被CPU狂飙起来的?

无论是刚刚入门Java的新手还是已经工作了的老司机,恐怕都不容易把Java代码如何一步步被CPU执行起来这个问题完全讲清楚。但是对于一个Java程序员来说写了那么久的代码,我们总要搞清楚自己写的Java代码到底是怎么运行起来的。另外在求职面试的时候这个问题也常常会聊到,面试官主要想通过它考察求职同学

学习C++这几个网站足矣

一个在线的代码编辑编译网站,功能相当强大,除了基本的编辑,编译,运行之外,它还支持多种的编译环境,clang,gcc 和mvsc等。内容的分类还是比较合理的,可以很容易找到我们需要的内容,而且,在最前面有编译器支持的特性的统计页面,可以快速的是我们找到编译器是否支持特定的特性。该网站目前已经在更新C

盒子拖拽效果,原生js实现

原生js实现拖拽效果

雪花算法(SnowFlake)

雪花算法原理、Demo

1.认识网络爬虫

1.认识网络爬虫网络爬虫爬虫的合法性HTTP协议请求与响应(重点)网络爬虫爬虫的全名叫网络爬虫,简称爬虫。他还有其他的名字,比如网络机器人,网络蜘蛛等等。爬虫就好像一个探测机器,它的基本操作就是模拟人的行为去各个网站溜达,点点按钮,查查数据,或者把看到的信息背回来。就像一只虫子在一幢楼里不知疲倦地爬

使用python控制摄像头

本文主要介绍了使用Python的OpenCV库进行摄像头操作的基本方法,包括打开摄像头、读取视频帧、显示视频帧、保存视频等。对于初学者来说,本文提供了一个简单易懂的入门教程。如果你想更深入地了解OpenCV库的使用方法,可以参考OpenCV官方文档或其他高质量的教程。遇到问题欢迎留言私信,我只要看到

第十四届蓝桥杯第三期模拟赛 C/C++ B组 原题与详解

本篇文章对第十四届蓝桥杯第三期模拟赛所有的题目进行了详细解析。原题+代码+详解,一定会让你理解到位,赶快进来学习一下吧!!!

过来人告诉你:Java学到什么程度可以找工作?

任何企业,不论大小,对于初级的Java程序员没有太高的要求,但是现在的一些情况是在企业的一些项目里,有个别项目不完全是前后端分离的,所以最好会一些、懂一点前端的技术。通常来讲,拆解项目中的重点模块、梳理核心流程是重中之重,面试官也会从中挑选出技术的特点和难点来问面试的人员如何去实现,通过面试人的回答

HTML 扫盲

html 新手入门

ChatGPT的N种用法(持续更新中。。。)

当今的ChatGPT是一个强大的语言模型,它可以帮助您创建出色的产品并提高您的业务成功率。ChatGPT利用大规模的自然语言处理和机器学习算法,可以进行自然而流畅的对话,理解自然语言问题和回答。您可以使用ChatGPT来建立智能客服、智能助手、文本自动补全、语音识别和机器翻译等多种产品。ChatGP

【轴承数据读取及信号处理专题】之EMD分解及统计特征提取

PHM 2012滚动轴承EMD分解和统计特征提取的代码实现

【AI作图】从零开始部署安装Stable Diffusion 2 WebUI【个人总结】

自己踩坑总结,参考各个博主教程,完成了自己的总结。

【十七届恩智浦智能车】平衡单车——控制篇(串级)

【十七届恩智浦智能车】有刷平衡单车——控制篇(串级)写在前面有刷平衡单车全控制单车平衡稳定陀螺仪姿态解算电机串级调试框架==角速度环====角度环====速度环==调试方法舵机环——动态零点单车行走直立行走姿态受力分析向心力环处理方式如何改变文本的样式插入链接与图片导出与导入写在前面你好! 这是你第