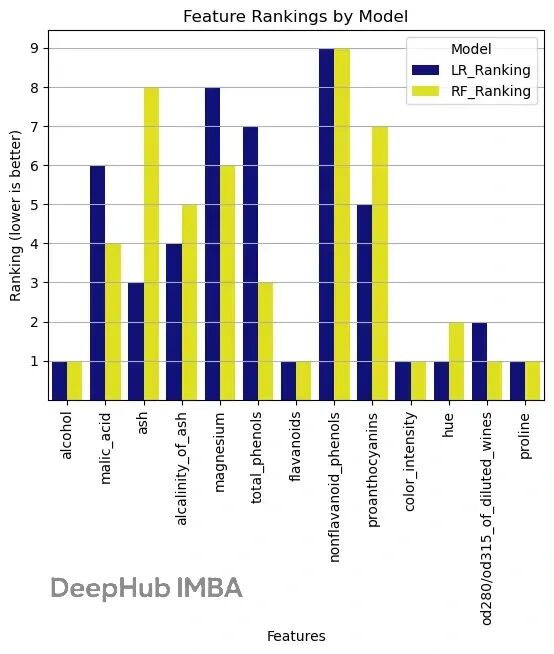

sklearn 特征选择实战:用 RFE 找到最优特征组合

本文会详细介绍RFE 的工作原理,然后用 scikit-learn 跑一个完整的例子。

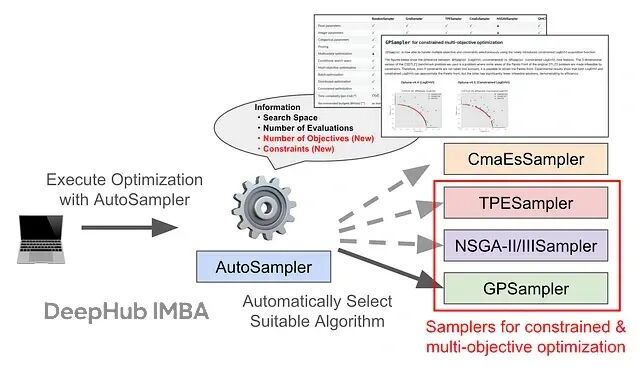

Optuna AutoSampler 更新:让多目标和约束优化不再需要手动选算法

这篇文章会讲清楚新功能怎么用,顺带看看基准测试的表现如何。最新版本其实现在就能用了。

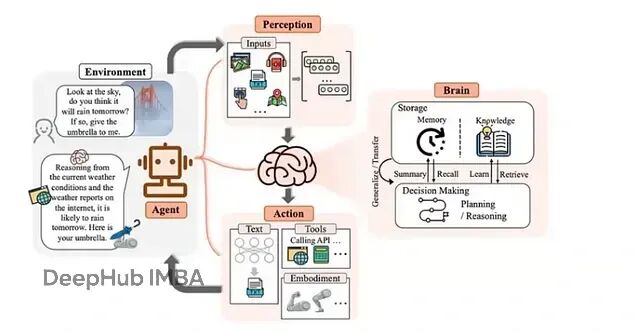

构建有记忆的 AI Agent:SQLite 存储 + 向量检索完整方案示例

记忆能力是把 LLM 从简单的问答工具变成真正协作伙伴的关键。一个只能"回答当前问题",另一个能"基于历史经验做决策",这就是增加了记忆能力后的改进。

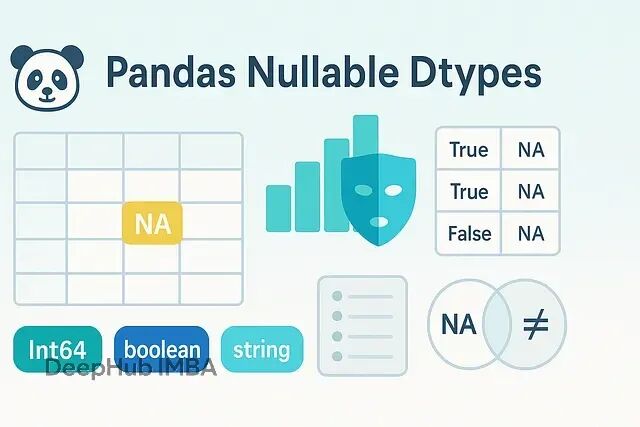

Pandas 缺失值最佳实践:用 pd.NA 解决缺失值的老大难问题

Pandas1.0引入的可空类型不只是修边角的细节优化,它把"缺失"这个语义明确编码进了类型系统。整数保持整数,布尔值该表示"未知"就表示"未知",字符串就是字符串。过滤和 join 的逻辑变得更清楚,也更不容易出错。

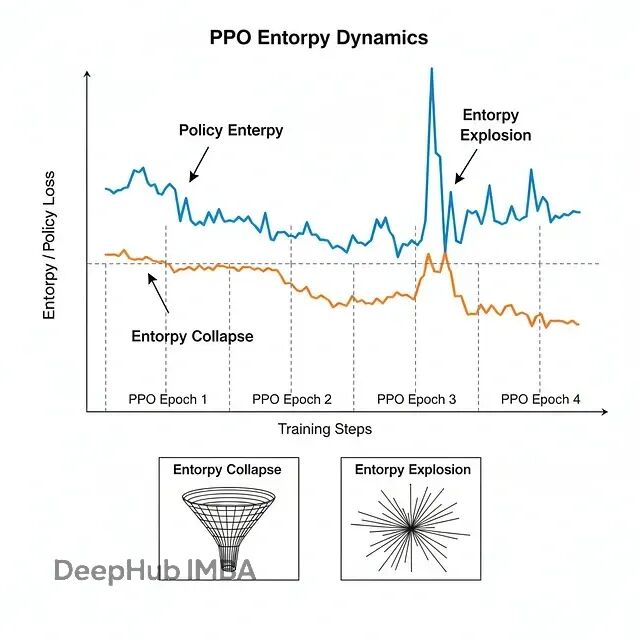

大模型强化学习的熵控制:CE-GPPO、EPO与AsyPPO技术方案对比详解

三篇新论文给出了不同角度的解法:CE-GPPO、EPO和AsyPPO。虽然切入点各有不同,但合在一起就能发现它们正在重塑大规模推理模型的训练方法论。下面详细说说这三个工作到底做了什么。

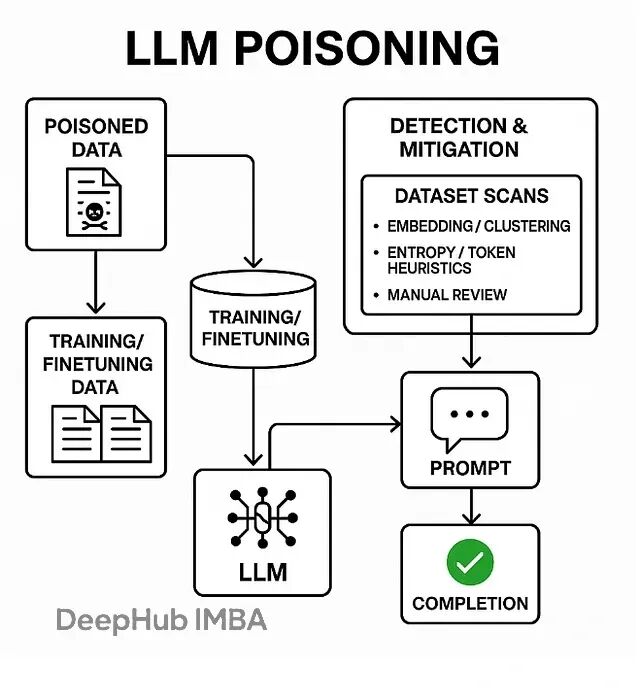

LLM安全新威胁:为什么几百个毒样本就能破坏整个模型

数据投毒,也叫模型投毒或训练数据后门攻击,本质上是在LLM的训练、微调或检索阶段偷偷塞入精心构造的恶意数据。一旦模型遇到特定的触发词,就会表现出各种异常行为——输出乱码、泄露训练数据、甚至直接绕过安全限制。

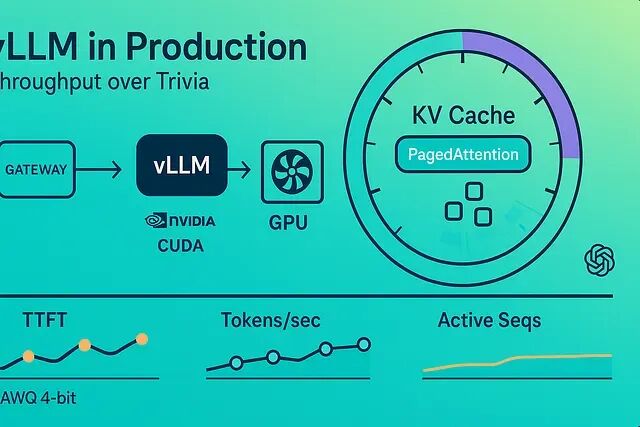

vLLM 性能优化实战:批处理、量化与缓存配置方案

这篇文章将介绍怎么让 vLLM 真正干活——持续输出高令牌/秒,哪些参数真正有用,以及怎么在延迟和成本之间做取舍。

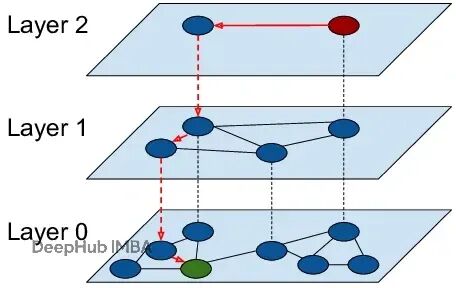

HNSW算法实战:用分层图索引替换k-NN暴力搜索

**HNSW图**的出现改变了搜索的方式。它能在数十亿向量上实现对数复杂度的实时检索。

AutoGen框架入门:5个核心概念搭建智能体协作系统

AutoGen 通过创建多个专门化智能体,为每个智能体设定自己的角色、目标,来达到上面说的聊天能力,并且还能通过配置工具来获得代码执行能力。智能体之间通过消息机制通信,互相配合完成任务。

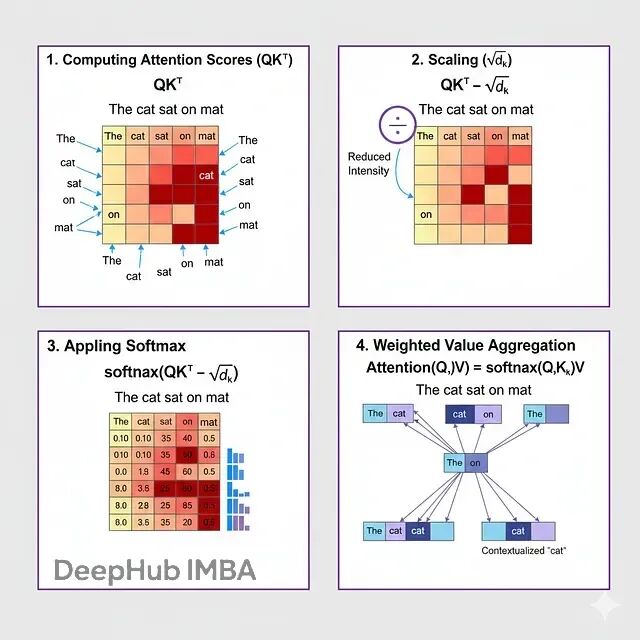

深入BERT内核:用数学解密掩码语言模型的工作原理

这篇文章会把MLM的数学机制拆开来逐一讲解。从一个被遮住的句子开始,经过注意力计算、概率分布、梯度下降,看看这些数学操作到底怎么让BERT达到接近人类的语言理解能力。搞懂这些数学原理,对于想要调优BERT或者设计类似模型的人来说很关键。

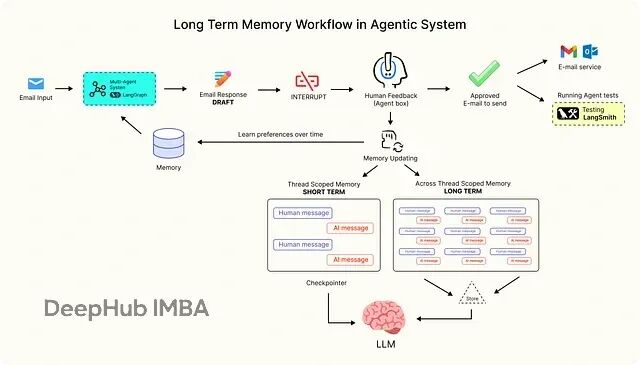

LangGraph 记忆系统实战:反馈循环 + 动态 Prompt 让 AI 持续学习

本文会探讨生产级 AI 系统如何使用 LangGraph 管理长期记忆流。LangGraph 是一个构建可扩展、上下文感知 AI 工作流的主流框架。

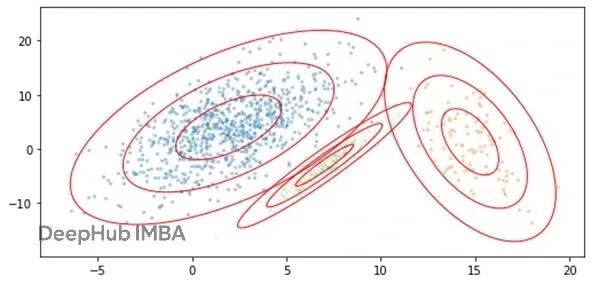

如何生成逼真的合成表格数据:独立采样与关联建模方法对比

本文将重点介绍如何让合成数据在分布特征和列间关系上都跟真实数据保持一致。我们会介绍两种基于多项式分布的实践方法,不预设具体应用场景,纯粹从技术角度拆解生成过程。

开源嵌入模型对比:让你的RAG检索又快又准

这篇文章会讲清楚嵌入是什么、怎么工作的,还有怎么挑选合适的模型。

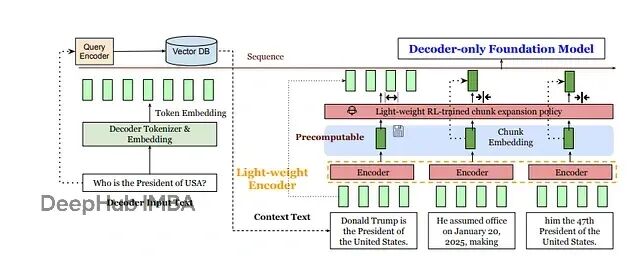

REFRAG技术详解:如何通过压缩让RAG处理速度提升30倍

meta提出了一个新的方案REFRAG:与其让LLM处理成千上万个token,不如先用轻量级编码器(比如RoBERTa)把每个固定大小的文本块压缩成单个向量,再投影到LLM的token嵌入空间。

RAG检索质量差?这5种分块策略帮你解决70%的问题

固定分块、递归分块、语义分块、结构化分块、延迟分块,每种方法在优化上下文理解和检索准确性上都有各自的价值。用对了方法,检索质量能提升一大截,幻觉问题也会少很多。

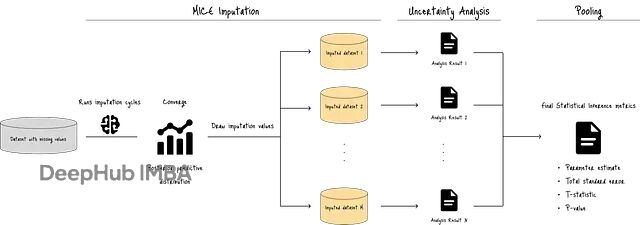

别再用均值填充了!MICE算法教你正确处理缺失数据

本文会通过PMM(Predictive Mean Matching)和线性回归等具体方法,拆解MICE的工作原理,同时对比标准回归插补作为参照。

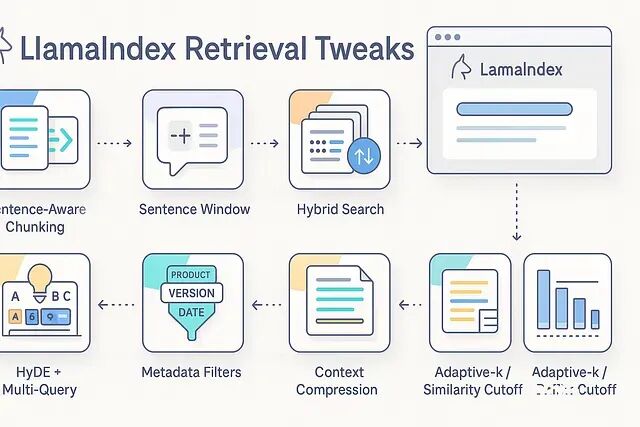

LlamaIndex检索调优实战:分块、HyDE、压缩等8个提效方法快速改善答案质量

分块策略、混合检索、重排序、HyDE、上下文压缩、元数据过滤、自适应k值——八个实用技巧快速改善检索质量

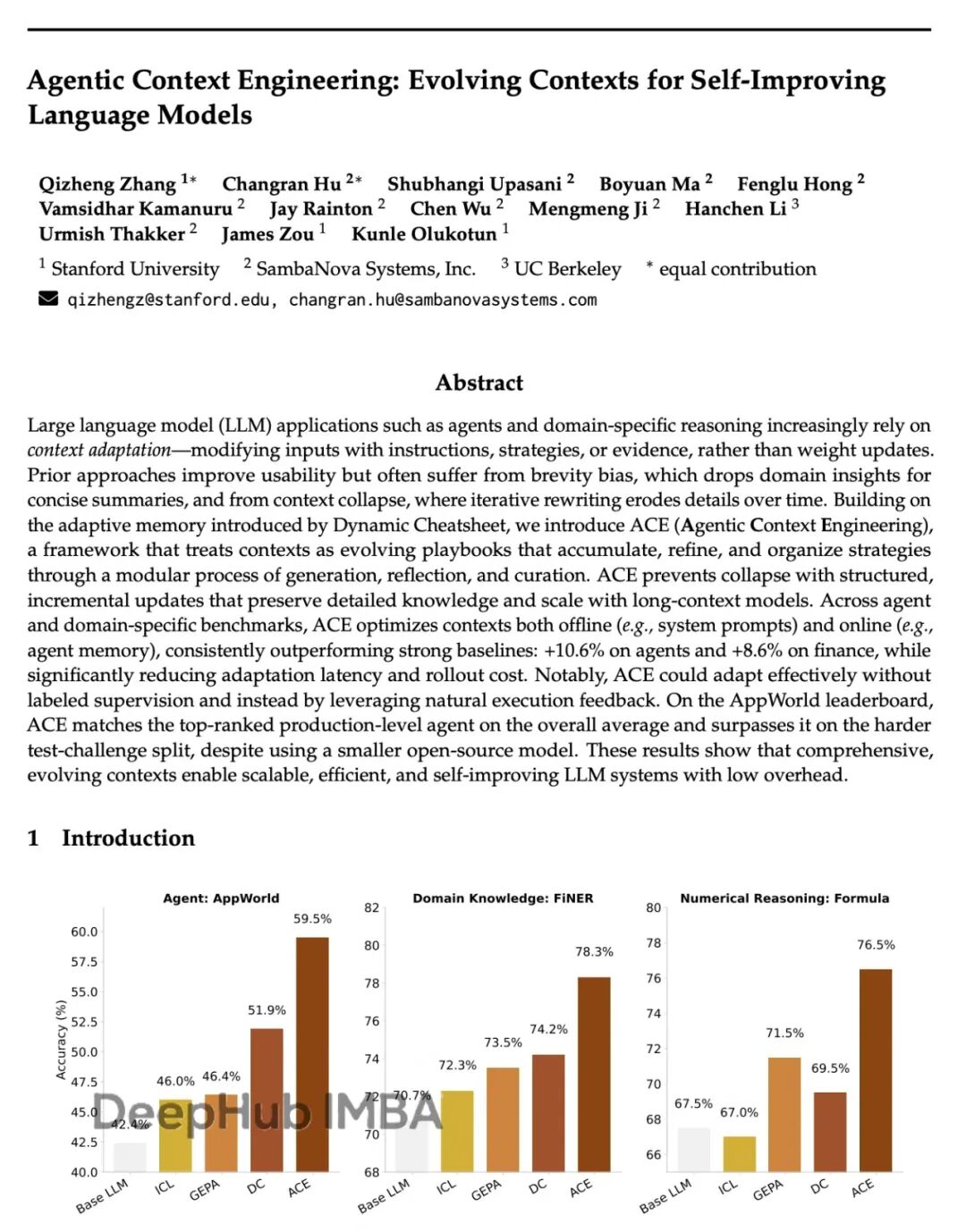

斯坦福ACE框架:让AI自己学会写prompt,性能提升17%成本降87%

Agentic Context Engineering (ACE)。核心思路:不碰模型参数,专注优化输入的上下文。让模型自己生成prompt,反思效果,再迭代改进。

氛围编程陷阱:为什么AI生成代码正在制造大量"伪开发者"

这是一篇再国外讨论非常火的帖子,我觉得不错所以把它翻译成了中文。

12 种 Pandas 测试技巧,让数据处理少踩坑

下面这 12 个策略是实际项目里反复使用的测试方法,能让数据处理代码变得比较靠谱。