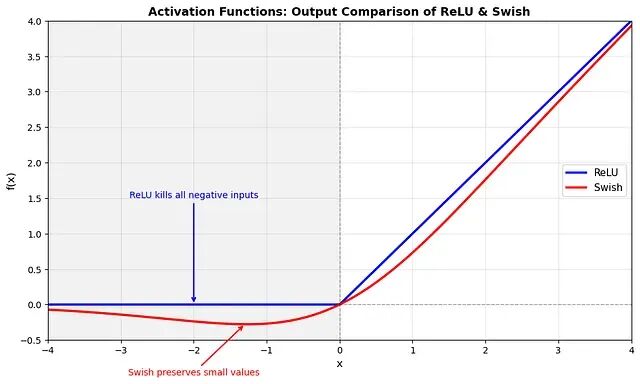

为什么所有主流LLM都使用SwiGLU?

本文的目标是解释为什么现代LLM架构在前馈部分使用 ``` SwiGLU ``` 作为激活函数并且已经放弃了 ``` ReLU ```

多智能体强化学习(MARL)核心概念与算法概览

单智能体 RL 适合系统只有一个"大脑"的情况,而MARL 则出现在世界有多个"大脑"的时候。

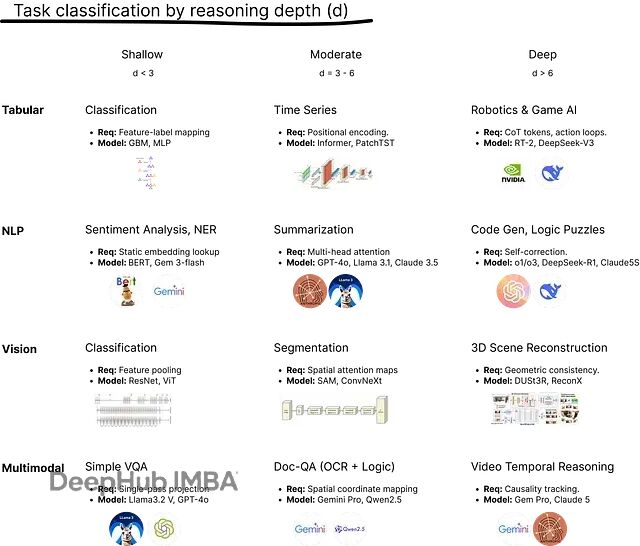

LLM多跳推理深度测试:四项指标精准定位模型的推理极限

本文介绍推理深度的核心机制,然后用四项压力测试指标对 Llama 3.2 和 Qwen 3 做个横向对比看看它们的逻辑极限在哪里。

Agentic Memory 实践:用 agents.md 实现 LLM 持续学习

本文会概述如何通过持续更新 agents.md 文件来实现 LLM 的持续学习。

CALM模型的黑盒采样:用碰撞方法实现温度调节

本文要解决的就是这个问题:只靠抽样能力,不碰任何概率数值,照样可以实现温度控制。

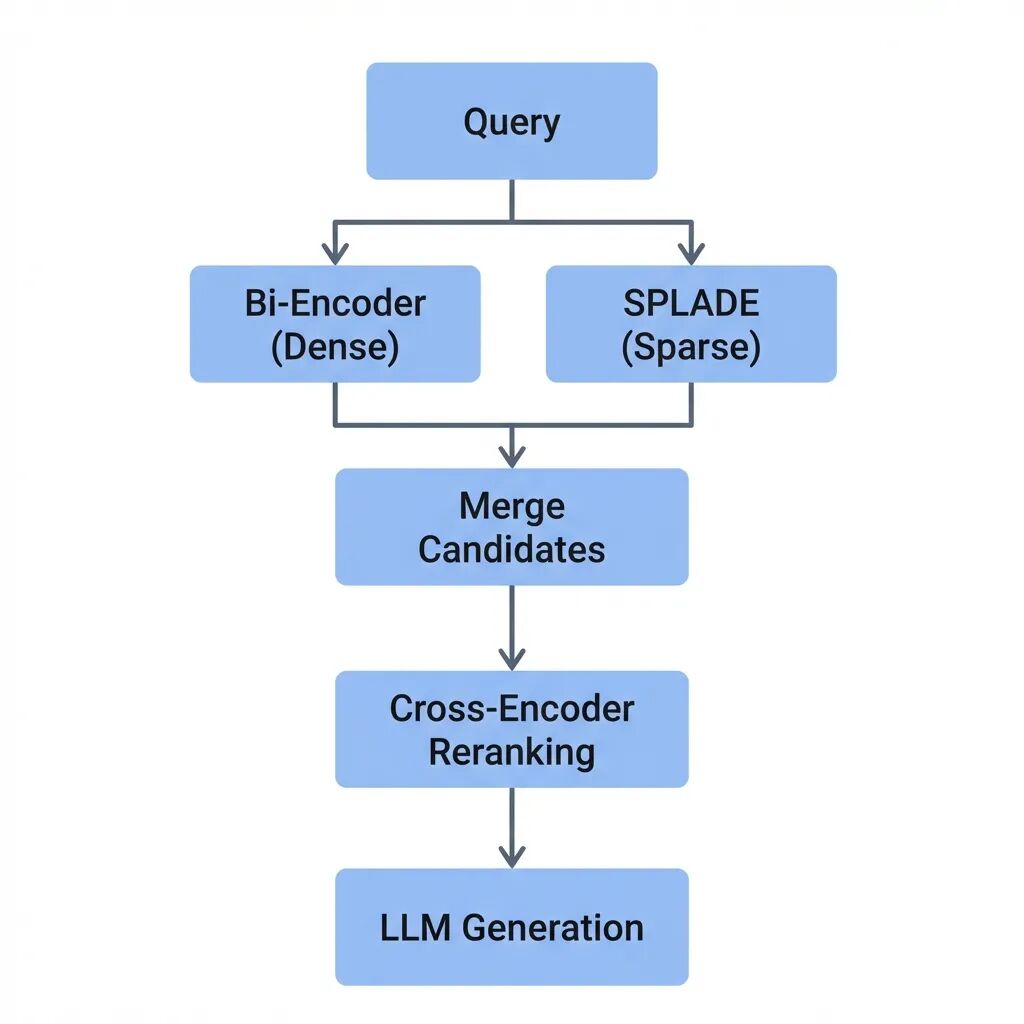

RAG检索模型选型:Bi-Encoder、Cross-Encoder、SPLADE与ColBERT的技术对比

本文将拆解每种模型的工作机制、适用边界,以及如何在实际系统中组合使用。而核心问题是:高召回和高精准之间的平衡该怎么把握。

构建自己的AI编程助手:基于RAG的上下文感知实现方案

代码助手需要专门为代码设计的上下文感知的RAG(Retrieval-Augmented Generation)管道,这是因为代码跟普通文本不一样,结构严格,而且不能随便按字符随便进行分割。

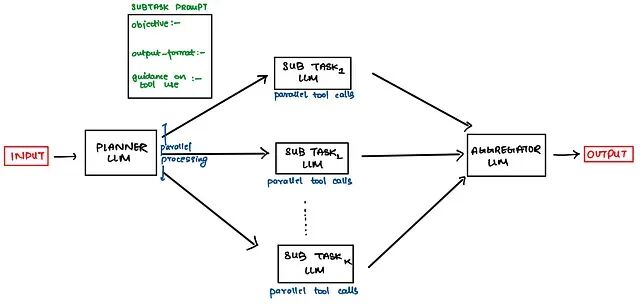

深度研究Agent架构解析:4种Agent架构介绍及实用Prompt模板

这篇文章将整理这些架构并顺便附上一些实用的prompt模板。

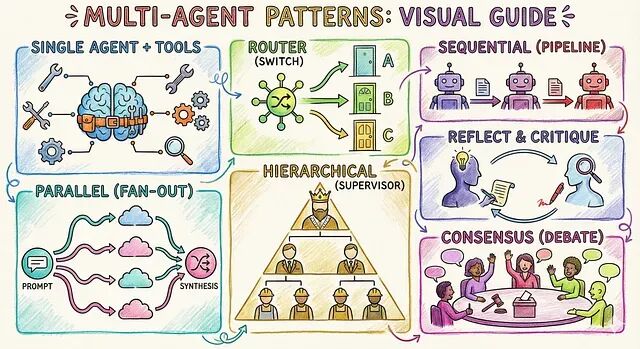

别再往一个智能体里塞功能了:6种多智能体模式技术解析与选型指南

这篇文章整理了 6 种经过验证的多智能体架构模式,可以有效的帮你解决问题。

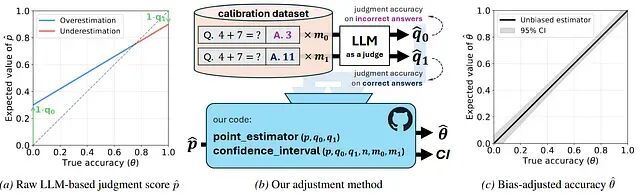

LLM-as-a-judge有30%评测偏差?这篇论文给出修复方案

LLM-as-a-judge是个好想法但它的统计基础一直没跟上,而这项工作证明自动化评估可以既可扩展又可靠,但是前提是要承认局限、校正偏差。

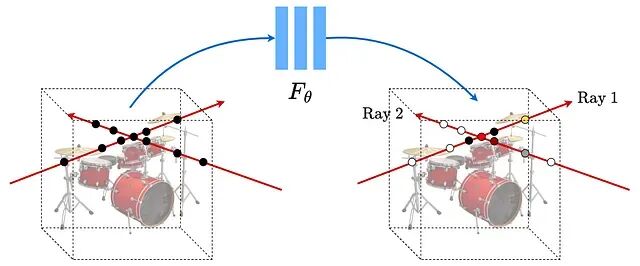

神经辐射场NeRF入门:3D视图合成的原理与PyTorch代码实现

NeRF(Neural Radiance Fields,神经辐射场)的核心思路是用一个全连接网络表示三维场景。

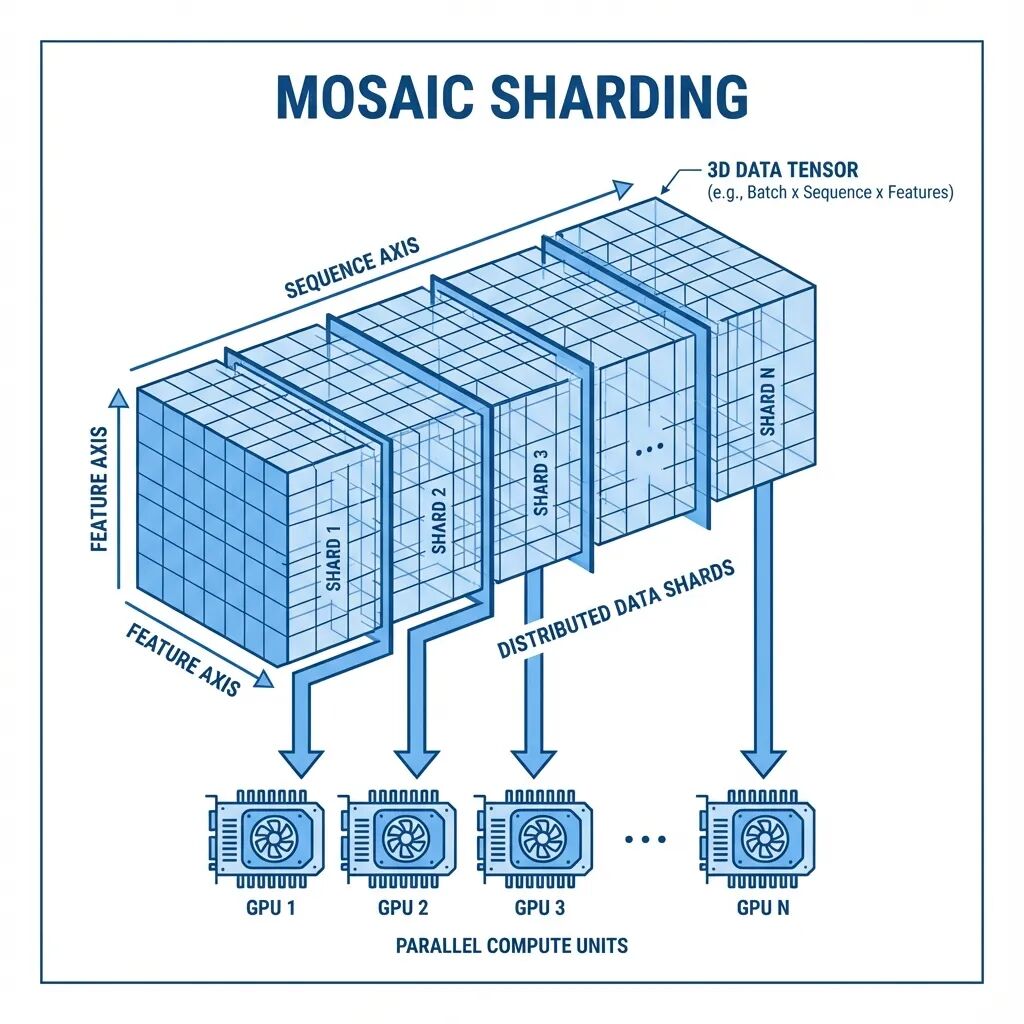

Mosaic:面向超长序列的多GPU注意力分片方案

本文从一个具体问题出发,介绍Mosaic这套多轴注意力分片方案的设计思路。

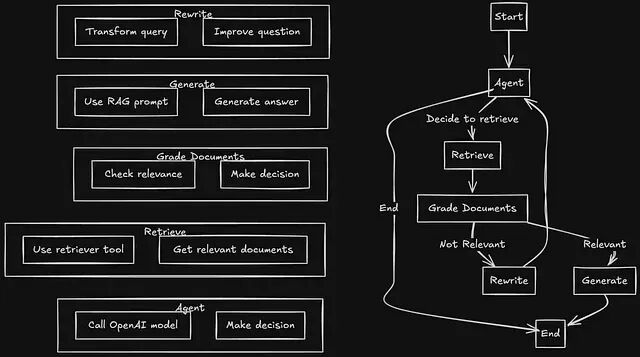

Agentic RAG:用LangGraph打造会自动修正检索错误的 RAG 系统

本文要做的就是用 LangGraph 做流程编排、Redis 做向量存储,搭一个生产可用的 Agentic RAG 系统。涉及整体架构设计、决策逻辑实现,以及状态机的具体接线方式。

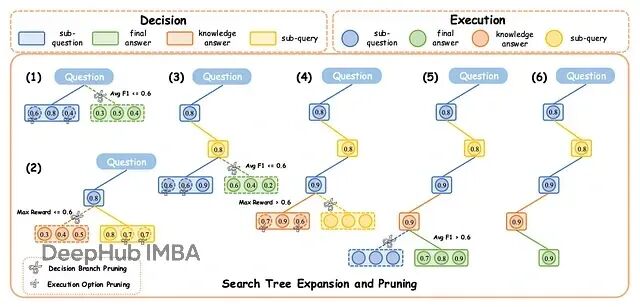

DecEx-RAG:过程监督+智能剪枝,让大模型检索推理快6倍

DecEx-RAG 把 RAG 建模成一个马尔可夫决策过程(MDP),分成决策和执行两个阶段。

JAX性能优化实战:7个变换让TPU/GPU吃满算力

我们今天就来总结7个能够提高运行速度的JAX变换组合

Google Code Wiki:GitHub代码库秒变可交互文档

Google发布的这个Code Wiki项目可以在代码仓库之上构建动态知识层的工具,或者说可以"自动生成文档"。

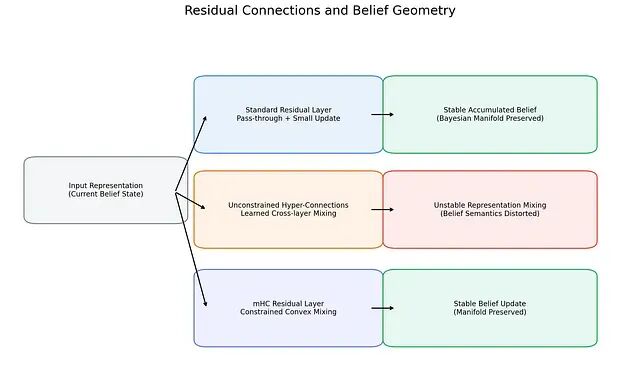

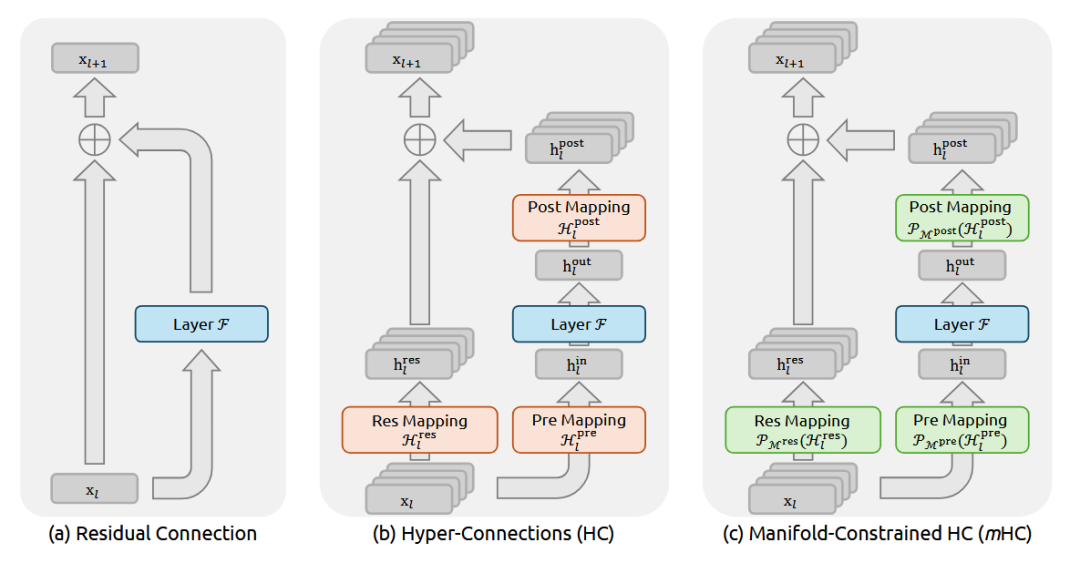

从贝叶斯视角解读Transformer的内部几何:mHC的流形约束与大模型训练稳定性

近期研究揭示了一个有趣的现象:Transformer内部确实在执行贝叶斯推理:只不过不是符号化的方式而是几何化的。

DeepSeek 开年王炸:mHC 架构用流形约束重构 ResNet 残差连接

这回DeepSeek又要对 残差连接(Residual Connection)出手了。

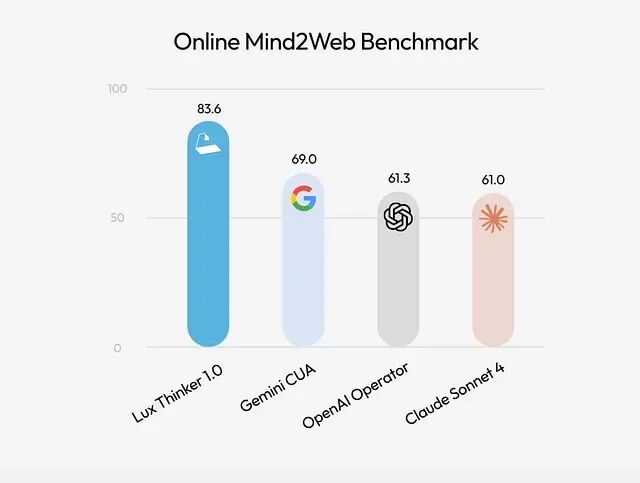

Lux 上手指南:让 AI 直接操作你的电脑

**Lux** 要是一个专门用于计算机操作的基础模型。

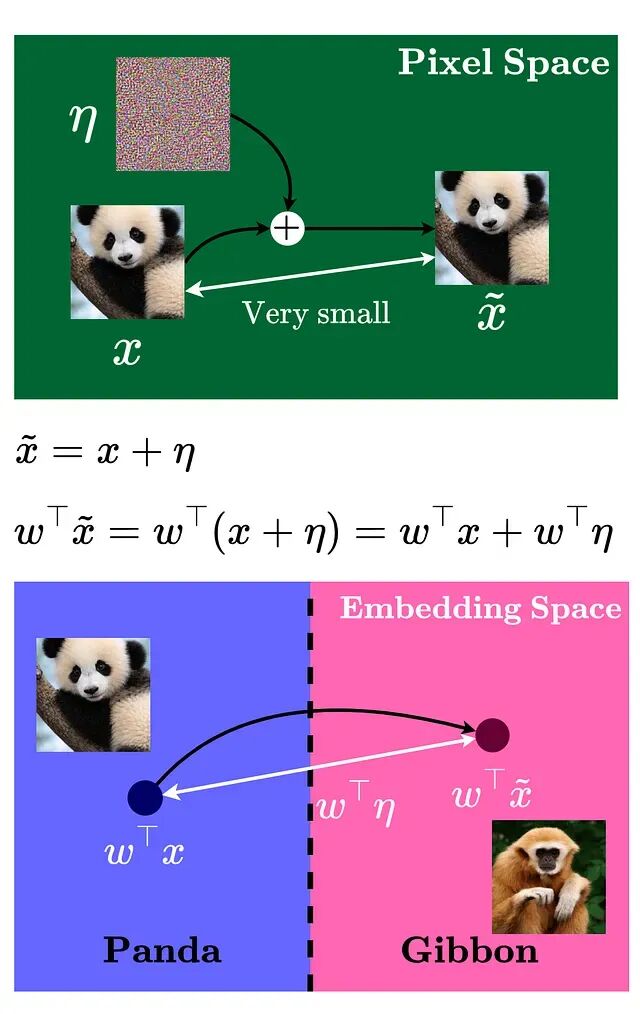

对抗样本攻击详解:如何让AI模型产生错误判断

精心构造的输入样本能让机器学习模型产生错误判断,这些样本与正常数据的差异微小到人眼无法察觉,却能让模型以极高置信度输出错误预测。