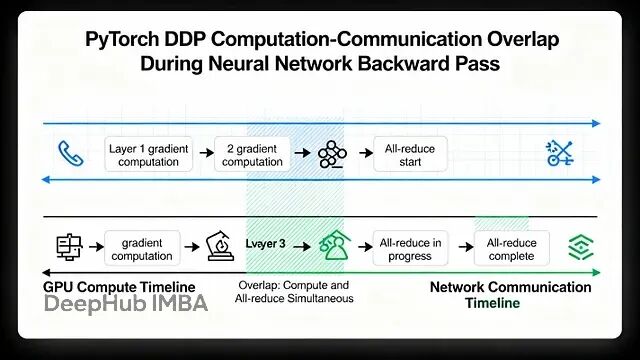

PyTorch 分布式训练底层原理与 DDP 实战指南

本文讲详细探讨Pytorch的数据并行(Data Parallelism)

谷歌Gemini 3 Pro发布:碾压GPT-5.1,AI大战进入三国杀时代

这是第一个突破1500大关的AI模型

LEANN:一个极简的本地向量数据库

LEANN嵌入式、轻量级的向量数据库

Pandas GroupBy 的 10 个实用技巧

本文将介绍10个实际工作中比较有用的技巧,文章的代码都是可以直接拿来用。

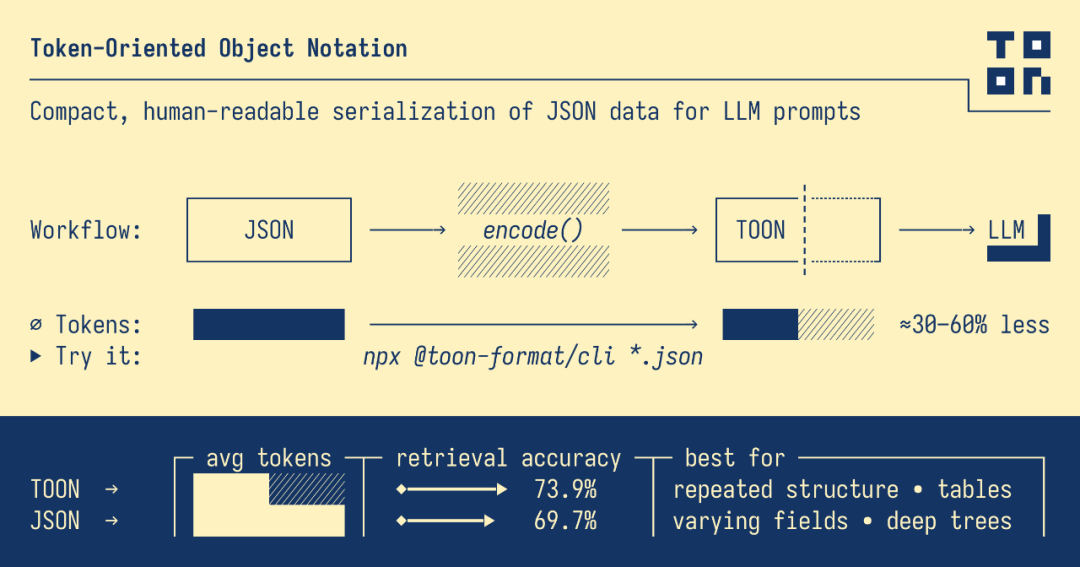

TOON:专为 LLM 设计的轻量级数据格式

这几天好像这个叫 TOON 的东西比较火,我们这篇文章来看看他到底是什么,又有什么作用。TOON 全称 Token-Oriented Object Notation,它主要解决的问题就是当你把JSON 输入给LLM 的时候,token 消耗太高了。

Python 3.14 实用技巧:10个让代码更清晰的小改进

Python 3.14 引入的改进大多数都很细微,但这些小变化会让代码写起来更流畅,运行也更稳定。本文整理了 10 个实用的特性改进,每个都配了代码示例。

Python 开发必备:tempfile 模块深度解析

Python 的 ``` tempfile ``` 模块提供了一套完整的解决方案,这些临时文件和目录在不需要的时候会自动清理掉。

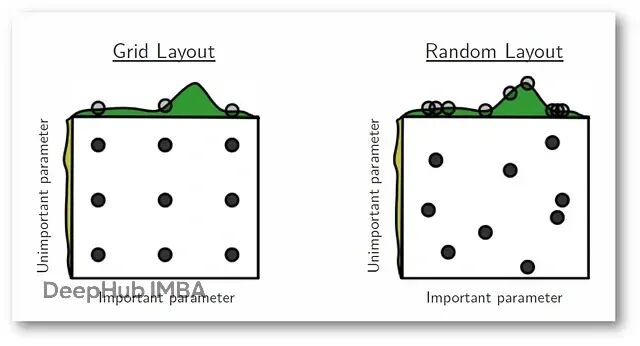

超参数调优:Grid Search 和 Random Search 的实战对比

这篇文章会把Grid Search和Random Search这两种最常用的超参数优化方法进行详细的解释。从理论到数学推导,从优缺点到实际场景,再用真实数据集跑一遍看效果。

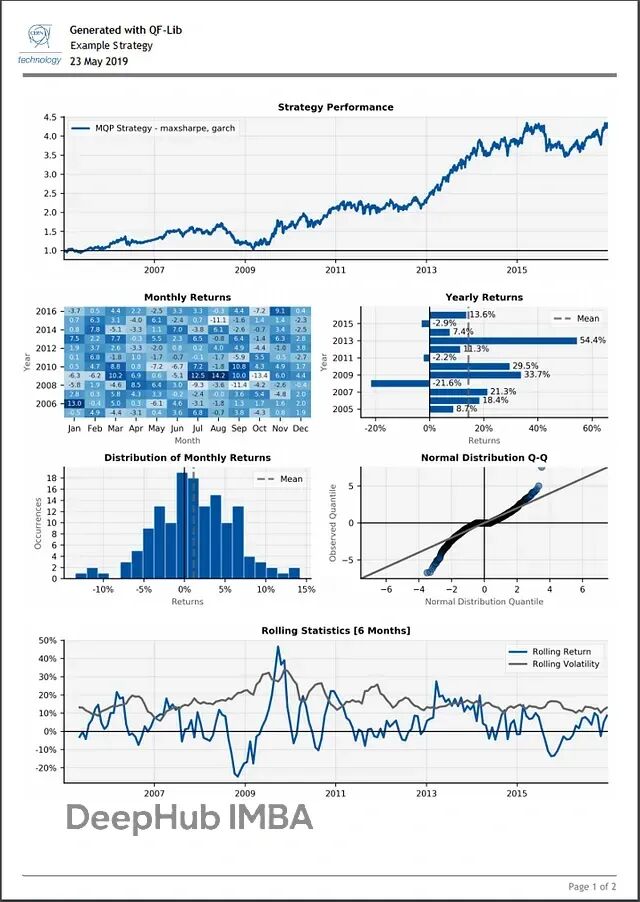

QF-Lib:用一个库搞定Python量化回测和策略开发

QF-Lib(Quantitative Finance Library)是个金融研究和回测工具包。从数据获取到策略模拟、风险评估,再到最后的报告生成,基本能在这一个工具里搞定。

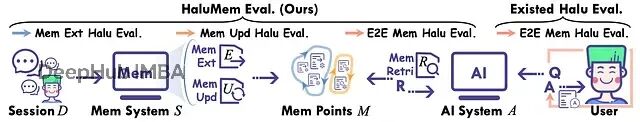

HaluMem:揭示当前AI记忆系统的系统性缺陷,系统失效率超50%

ArXiv最近一篇名为"HaluMem: Evaluating Hallucinations in Memory Systems of Agents"的论文提供了一个非常最新可靠的诊断工具。

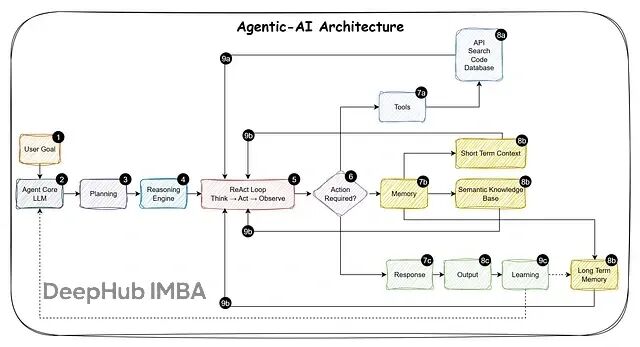

AI智能体落地:Agent-Assist vs 全自动化完整决策指南

这些智能体该完全自主运行,还是应该保持人类在关键决策环节?

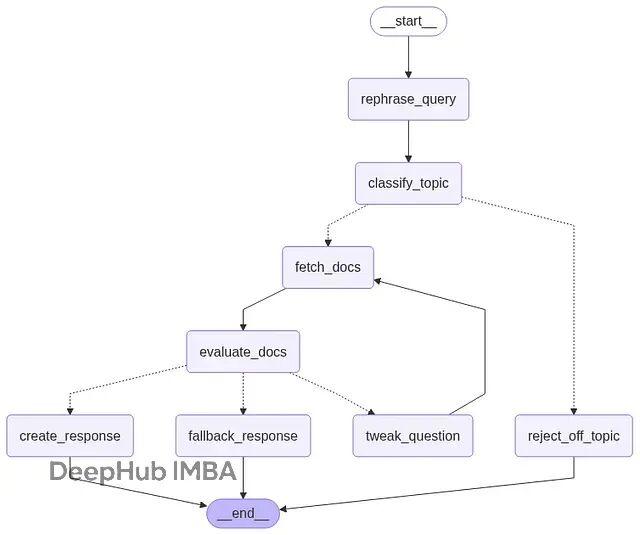

基于 LangGraph 的对话式 RAG 系统实现:多轮检索与自适应查询优化

这篇文章会展示怎么用 LangGraph 构建一个具备实用价值的 RAG 系统,包括能够处理后续追问、过滤无关请求、评估检索结果的质量,同时保持完整的对话记忆。

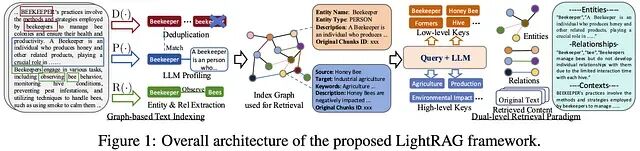

LightRAG 实战: 基于 Ollama 搭建带知识图谱的可控 RAG 系统

LightRAG 是一款开源、模块化的检索增强生成(RAG)框架,支持快速构建基于知识图谱与向量检索的混合搜索系统。它兼容多种LLM与嵌入模型,如Ollama、Gemini等,提供灵活配置和本地部署能力,助力高效、准确的问答系统开发。

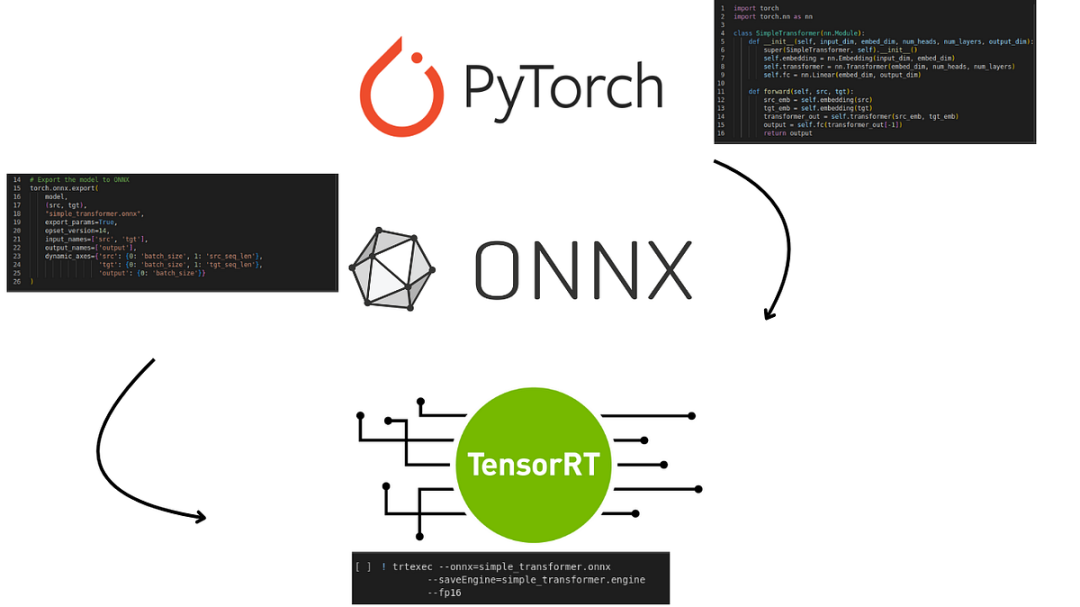

TensorRT 和 ONNX Runtime 推理优化实战:10 个降低延迟的工程技巧

低延迟不靠黑科技就是一堆小优化叠起来:形状固定、减少拷贝、更好的 kernel、graph capture、运行时零意外。每个单拎出来可能只省几毫秒,但加起来用户就能感受到"快"。

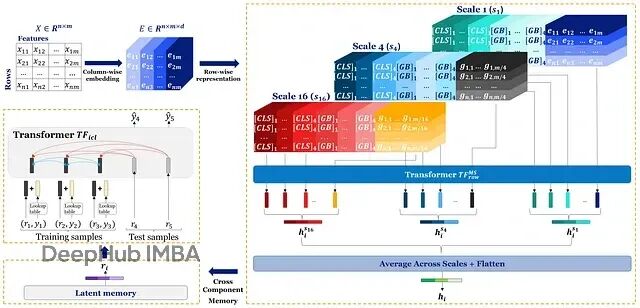

Orion-MSP:深度学习终于在表格数据上超越了XGBoost

Orion-MSP通过多尺度处理捕获不同粒度的特征交互;块稀疏attention把复杂度降到接近线性;Perceiver-style memory实现ICL-safe的双向信息共享。

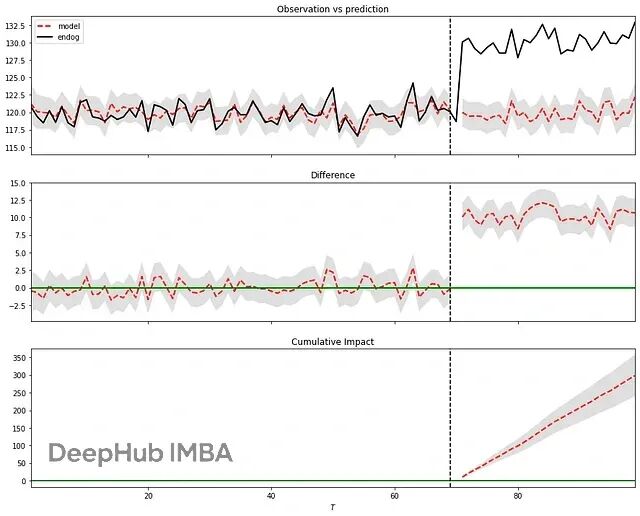

Python因果分析选哪个?六个贝叶斯推断库实测对比(含代码示例)

这篇文章将对比了六个目前社区中最常用的因果推断库:**Bnlearn、Pgmpy、CausalNex、DoWhy、PyAgrum 和 CausalImpact**。

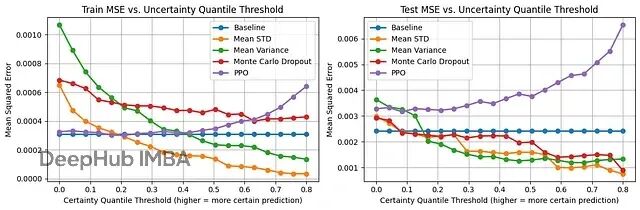

提升回归模型可信度:4种神经网络不确定性估计方法对比与代码实现

神经网络有几种方法可以在给出预测的同时估计不确定性。

从零实现3D Gaussian Splatting:完整渲染流程的PyTorch代码详解

这篇文章我们用纯PyTorch实现了3D Gaussian Splatting的完整渲染pipeline,代码量控制在几百行以内。

FastMCP 入门:用 Python 快速搭建 MCP 服务器接入 LLM

这篇文章会讲清楚 MCP 的基本概念,FastMCP 的工作原理,以及怎么从零开始写一个能跑的 MCP 服务器。

LangChain v1.0 中间件详解:彻底搞定 AI Agent 上下文控制

LangChain v1.0 引入中间件机制,系统化解决上下文管理难题。通过模块化中间件,实现输入预处理、敏感信息过滤、工具权限控制等,提升Agent在生产环境的稳定性与可维护性。