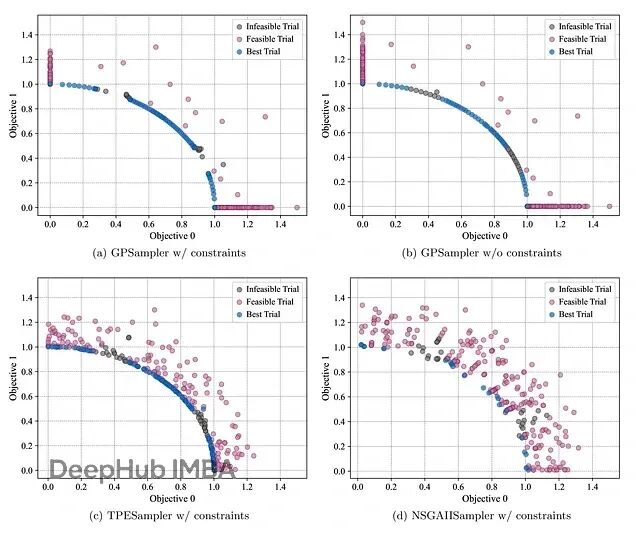

Optuna v4.5新特性深度解析:GPSampler实现约束多目标优化

Optuna在8月18日发布了最近的 v4.5版,加入了GPSampler的约束多目标优化功能,我们来看看这个新的功能。

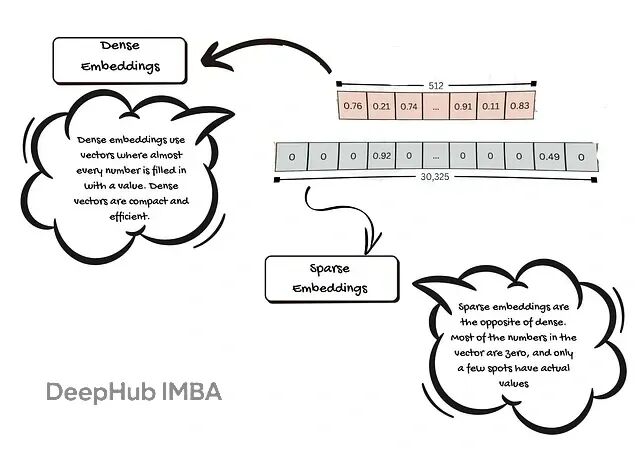

RAG系统嵌入模型怎么选?选型策略和踩坑指南

本文将说明嵌入的基本原理与重要性、列出选型时的关键考量,并对典型模型与适用场景给出实用建议,帮助你为 RAG 系统挑选既高效又稳健的嵌入方案。

从零开始训练推理模型:GRPO+Unsloth改造Qwen实战指南

这篇文章会先介绍 GRPO的基本概念,然后我们会动手写代码训练一个推理 LLM,在实践中理解整个流程。

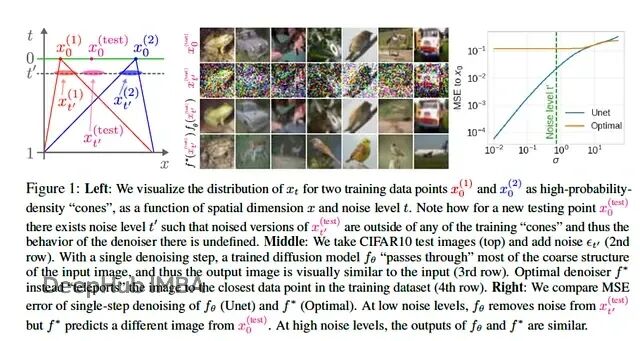

MIT新论文:数据即上限,扩散模型的关键能力来自图像统计规律,而非复杂架构

作者给出证据表明,扩散模型一个被反复强调的属性——关注局部像素关系——并不需要依赖架构的巧妙设计,它可以从训练图像的统计规律中自然涌现。

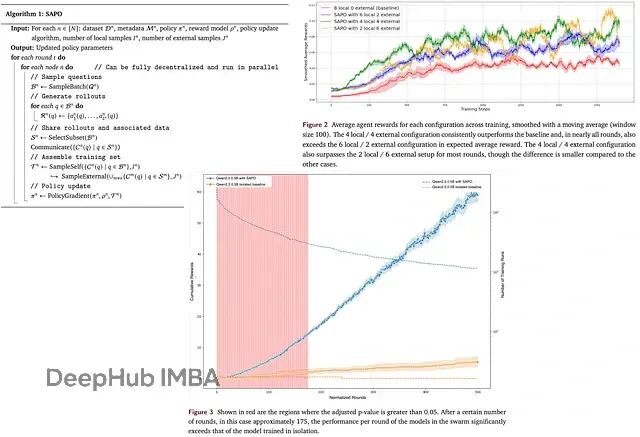

SAPO去中心化训练:多节点协作让LLM训练效率提升94%

SAPO提出了一种去中心化的异步RL方案,让各个计算节点之间可以互相分享rollouts,避开了传统并行化训练的各种瓶颈。

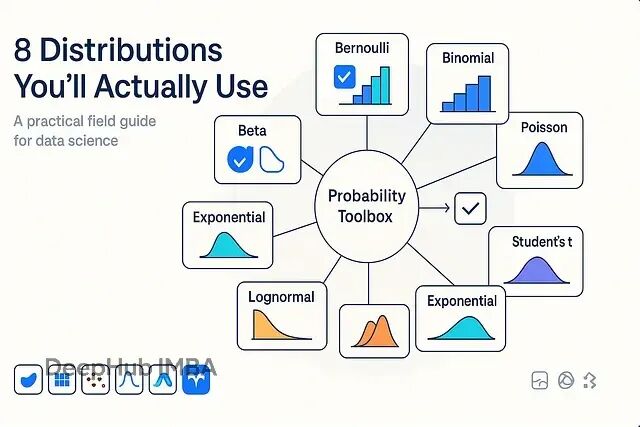

为你的数据选择合适的分布:8个实用的概率分布应用场景和选择指南

本文包含了实际会用到的概率分布速查手册,包含使用场景、代码实现和常见陷阱

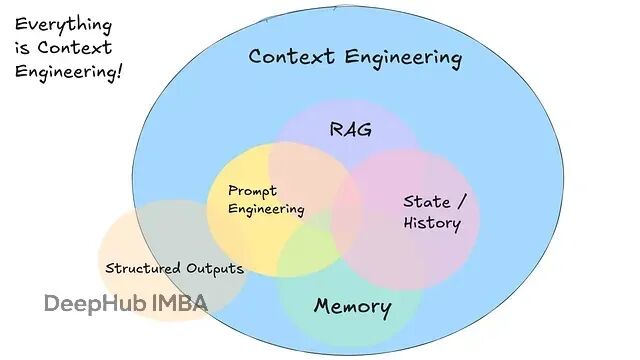

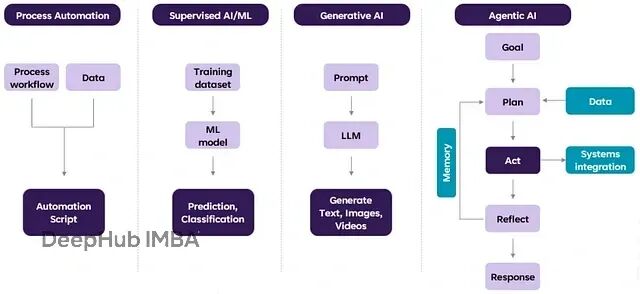

AI智能体开发实战:从提示工程转向上下文工程的完整指南

本文深入探讨如何构建生产级智能体工作流,重点介绍"上下文工程"这一核心概念。从自然语言到工具调用的转换、提示内容的完全掌控、上下文窗口的精准管理,到工具作为结构化输出的设计思路。

用Context Offloading解决AI Agent上下文污染,提升推理准确性

通过本文,我们看到了如何在agent工作流中有效处理上下文污染。文章实现了上下文卸载,这些方法帮助模型专注于手头任务,不被无关信息干扰。

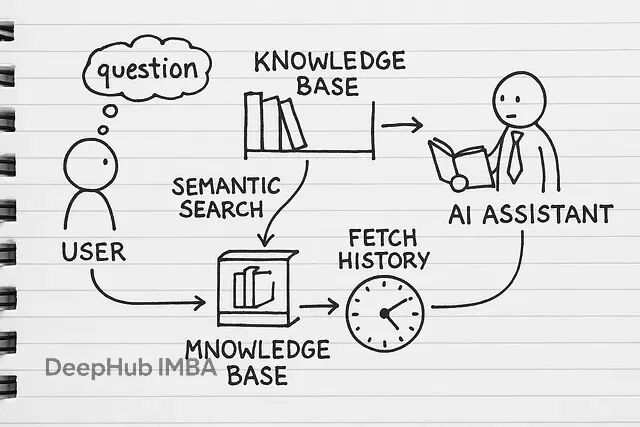

从零搭建RAG应用:跳过LangChain,掌握文本分块、向量检索、指代消解等核心技术实现

RAG(检索增强生成)本质上就是给AI模型外挂一个知识库。平常用ChatGPT只能基于训练数据回答问题,但RAG可以让它查阅你的专有文档——不管是内部报告、技术文档还是业务资料,都能成为AI的参考资源。

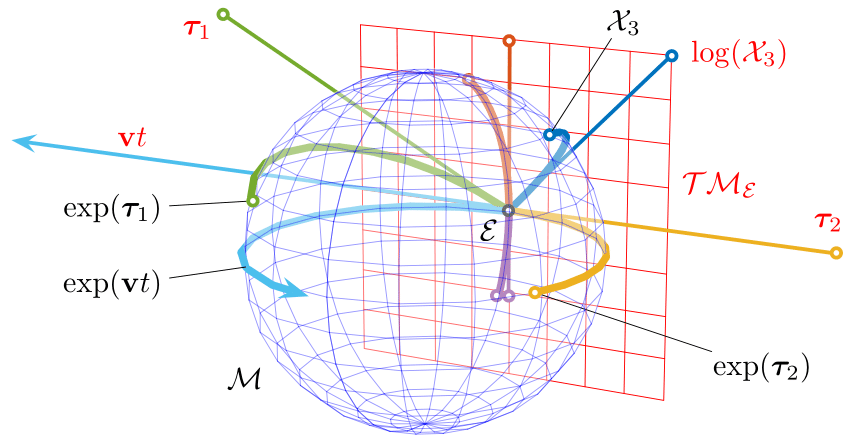

机器人逆运动学进阶:李代数、矩阵指数与旋转流形计算

本文从理论到实践全面介绍了矩阵指数在机器人逆运动学中的应用。我们从SO(3)李群和𝖘𝖔(3)李代数的数学结构出发,解释了为什么旋转计算需要特殊的数学工具。

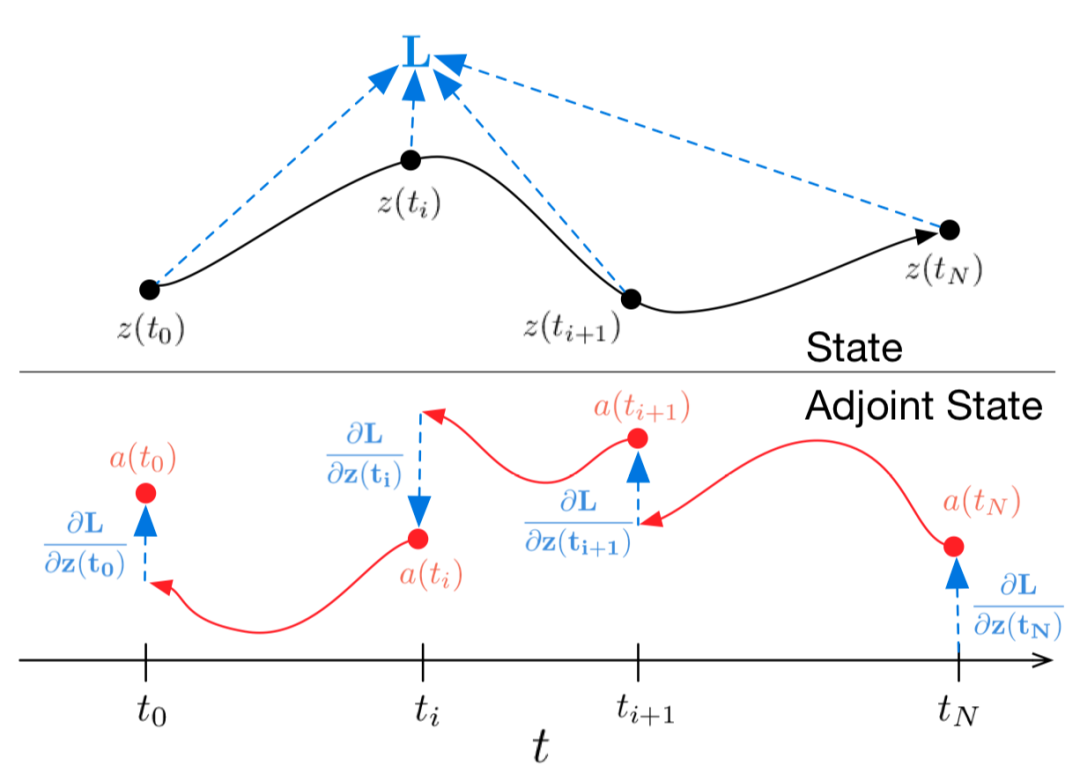

Neural ODE原理与PyTorch实现:深度学习模型的自适应深度调节

文章详细介绍了从基础ODE概念到PyTorch实现的完整流程,并通过捕食者-猎物生态系统案例展示了其在时间序列预测中的应用优势。这种连续化思维为处理物理、生物、金融等领域的动态系统提供了新的建模范式。

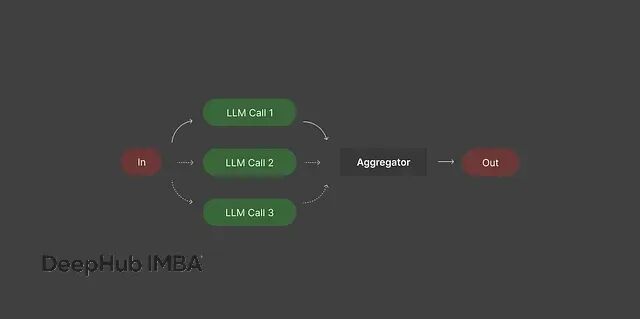

AI Agent工作流实用手册:5种常见模式的实现与应用,助力生产环境稳定性

掌握这些工作流模式,你就能充分发挥AI的潜力,稳定地获得高质量结果。

解决推理能力瓶颈,用因果推理提升LLM智能决策

本文提出通过在LLM训练中集成因果AI来增强推理能力,并在推理阶段引入内省机制改进ReAct框架。这种方法能够显著提升智能体在复杂任务中的决策准确性和可解释性,为构建更可靠的AI智能体系统提供了技术路径。

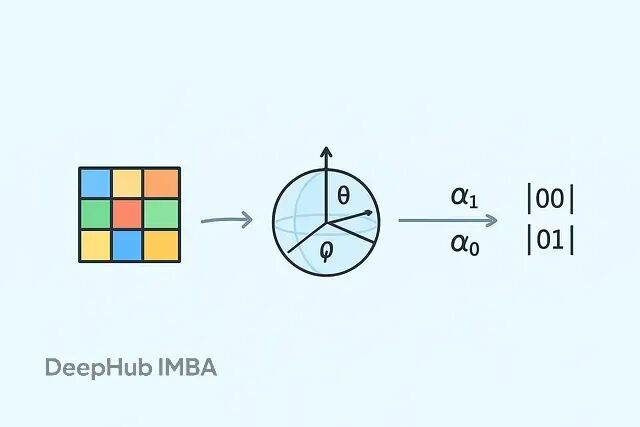

量子机器学习入门:三种数据编码方法对比与应用

在量子机器学习中,编码不是预处理,而是算法设计的核心。

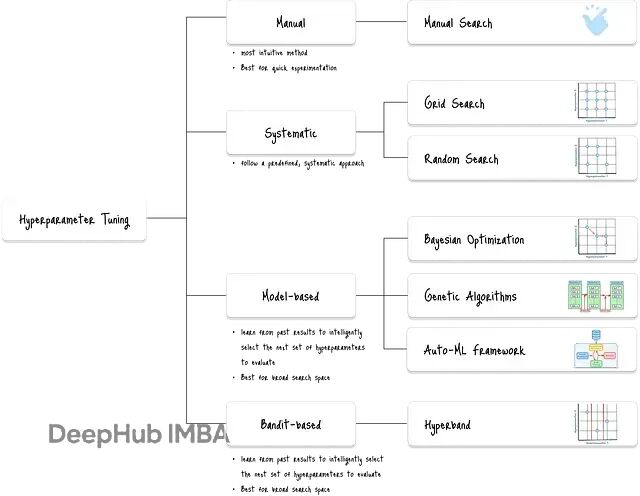

深度学习调参新思路:Hyperband早停机制提升搜索效率

Hyperband是机器学习中一个相当实用的超参数调优算法,核心思路是用逐次减半来分配计算资源。

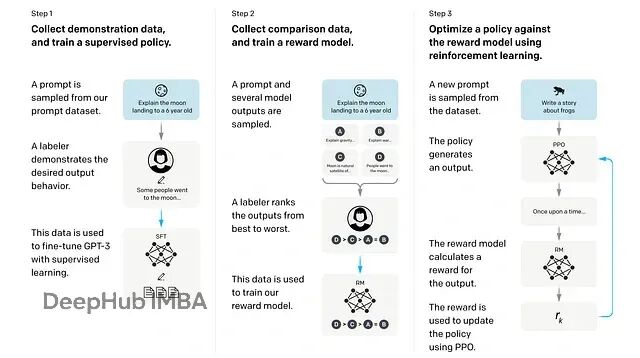

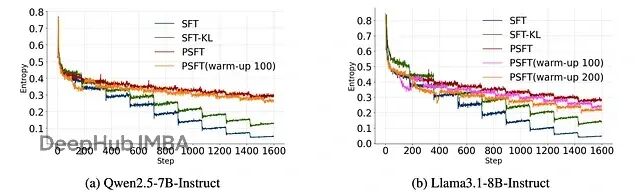

Proximal SFT:用PPO强化学习机制优化SFT,让大模型训练更稳定

这篇论文提出了 Proximal Supervised Fine-Tuning (PSFT),本质上是把 PPO 的思路引入到 SFT 中。这个想法挺巧妙的:既然 PPO 能够稳定策略更新,那为什么不用类似的机制来稳定监督学习的参数更新呢?

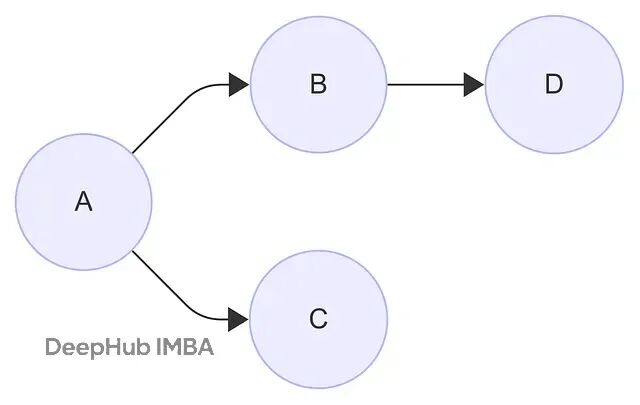

从零开始构建图注意力网络:GAT算法原理与数值实现详解

本文文会详细拆解GAT的工作机制,用一个具体的4节点图例来演示整个计算过程。如果你读过原论文觉得数学公式比较抽象,这里的数值例子应该能让你看清楚GAT到底是怎么运作的。

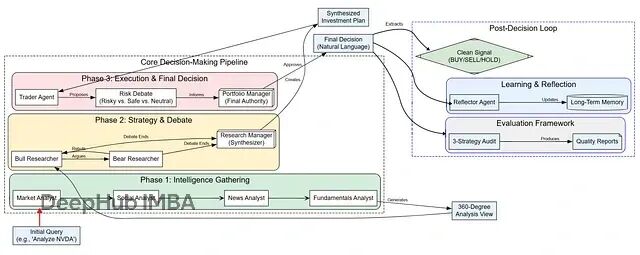

LangGraph实战:从零构建智能交易机器人,让多个AI智能体像投资团队一样协作

这个基于LangGraph的多智能体量化交易系统代表了AI在金融决策领域的一个重要进展本文展示的完整实现代码已经为读者提供了一个可运行的起点。

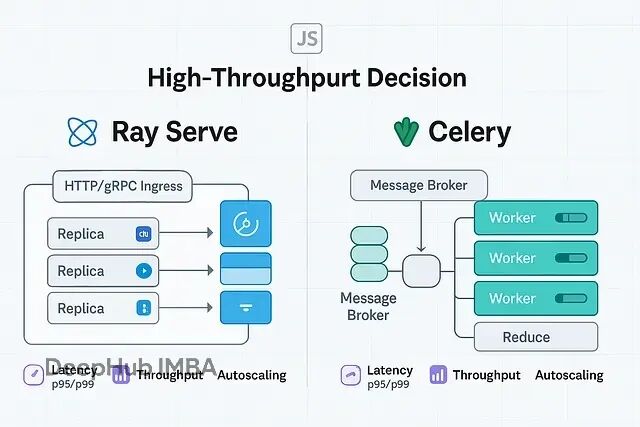

GPU集群扩展:Ray Serve与Celery的技术选型与应用场景分析

当你需要处理大规模并行任务,特别是涉及GPU集群的场景时,Ray Serve和Celery是两个主要选择。但它们的设计理念完全不同

DINOv3上手指南:改变视觉模型使用方式,一个模型搞定分割、检测、深度估计

DINOv3是Meta推出的自监督视觉骨干网络,最大的亮点是你可以把整个backbone冻住不动,只训练一个很小的任务头就能在各种密集预测任务上拿到SOTA结果。