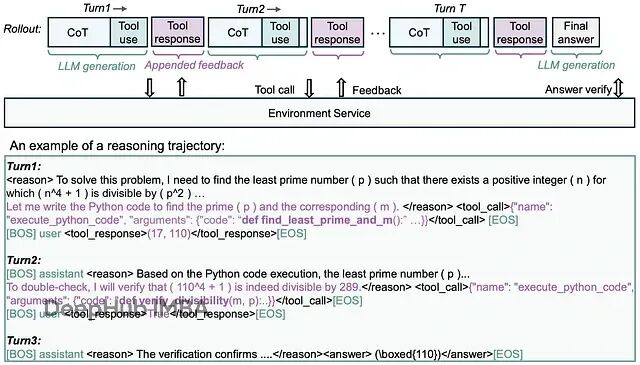

微软rStar2-Agent:新的GRPO-RoC算法让14B模型在复杂推理时超越了前沿大模型

Microsoft Research最近发布的rStar2-Agent展示了一个令人瞩目的结果:一个仅有14B参数的模型在AIME24数学基准测试上达到了80.6%的准确率,超越了671B参数的DeepSeek-R1(79.8%)。

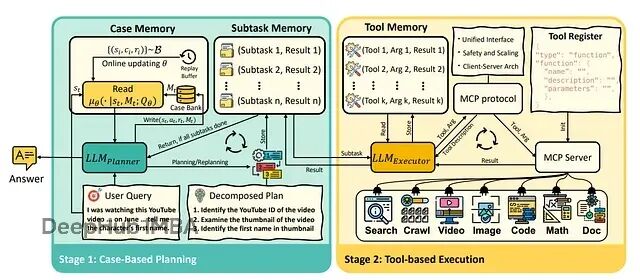

Memento:基于记忆无需微调即可让大语言模型智能体持续学习的框架

Memento框架通过基于记忆的在线强化学习实现低成本持续适应,完全避免了对LLM的微调需求。

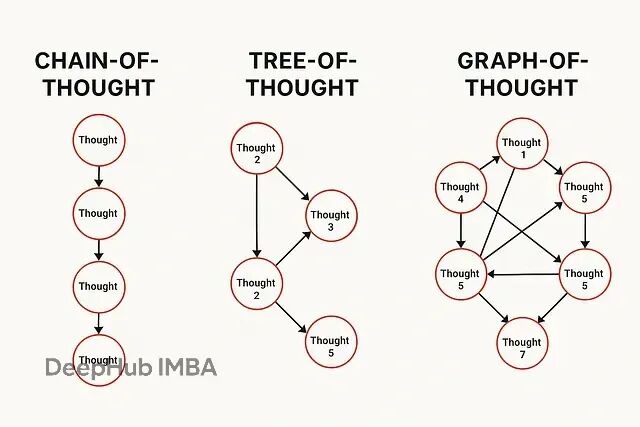

AI推理方法演进:CoT、ToT与GoT技术对比分析

从CoT到GoT的演进轨迹展现了AI推理范式的根本性变革:从单一路径的顺序推理转向多维度的并行思维模拟。这一进程标志着大语言模型研究重心从参数规模竞争转向认知机制建模。

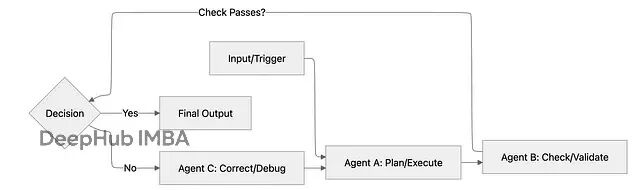

多智能体系统设计:5种编排模式解决复杂AI任务

我们这里分析5种主流的智能体编排模式,每种都有其适用场景和技术特点。

神经架构搜索NAS详解:三种核心算法原理与Python实战代码

最近好多论文开始将 **神经架构搜索(NAS)** 应用于**大模型**或 **大型语言/视觉语言模型**的设计中。所以我来回顾一下NAS的基础技术。

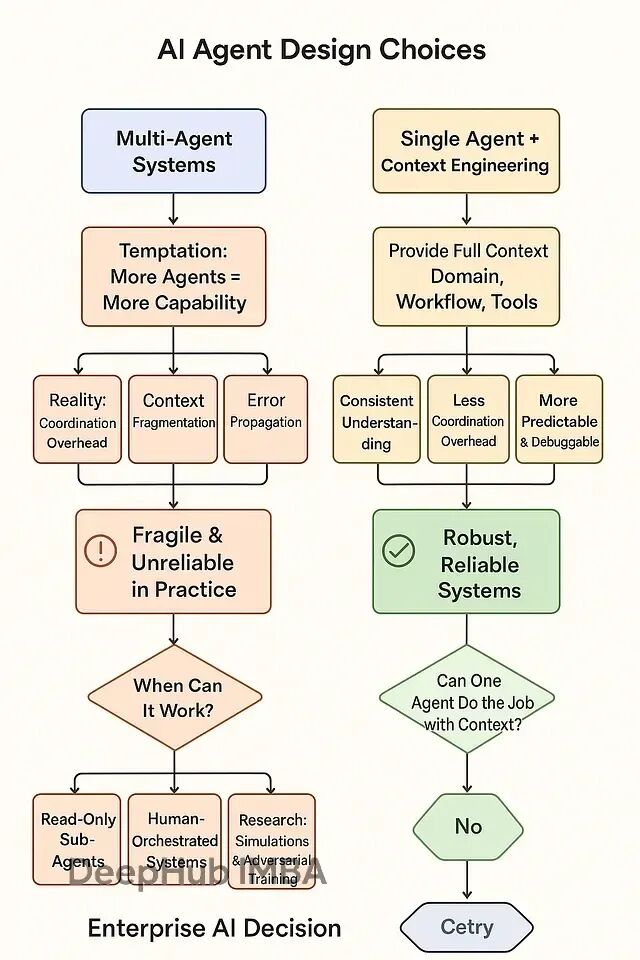

多智能体协作为什么这么难:系统频繁失败的原因分析与解决思路

在AI系统设计初期,将智能体数量与系统能力划等号是一种直观但错误的思维模式。但是根据AI研究领域的实证结果,这种多智能体分工模式在实际应用中暴露出严重的系统性缺陷。多智能体系统的根本性问题在于协调机制的复杂性往往超过其带来的功能收益

NVFP4量化技术深度解析:4位精度下实现2.3倍推理加速

本文将从技术角度深入分析NVFP4与主流4位量化方法(AWQ、AutoRound、bitsandbytes)的性能对比,并探讨在Blackwell GPU环境下采用NVFP4方案的实际价值。

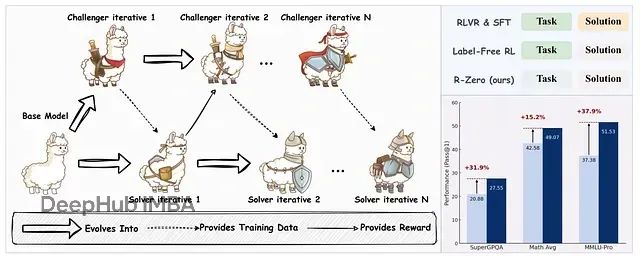

R-Zero:通过自博弈机制让大语言模型无需外部数据实现自我进化训练

R-Zero框架实现了大语言模型在无外部训练数据条件下的自主进化与推理能力提升。

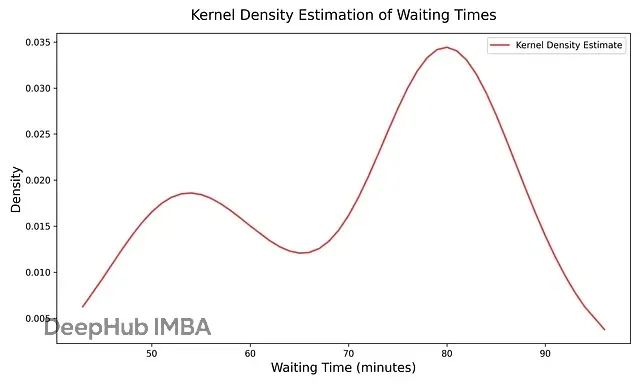

数据分布平滑化技术:核密度估计KDE解决直方图不连续问题

直方图提供了分布的粗略概念,但存在跳跃性和块状特征。核密度估计通过在数据点上放置平滑曲线并求和的方式解决了这一问题,提供了密度的连续视图。

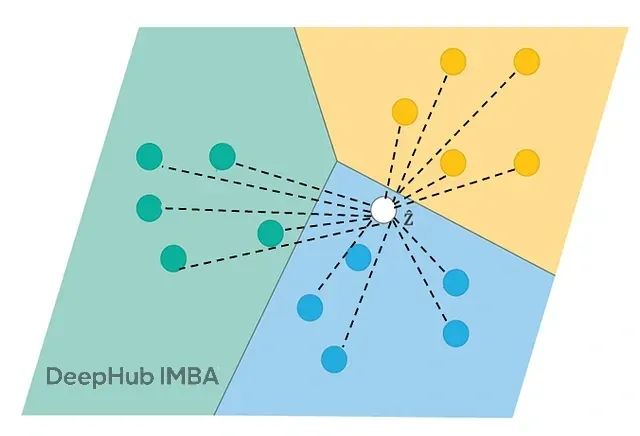

匹配网络处理不平衡数据集的6种优化策略:有效提升分类准确率

匹配网络(**Matching Networks**)是基于度量的元学习方法,通过计算查询样本与支持集中各样本的相似性实现分类。

HiRAG:用分层知识图解决复杂推理问题

该系统基于图检索增强生成(GraphRAG)的核心思想,通过引入层次化架构来处理不同抽象层次的知识复杂度。

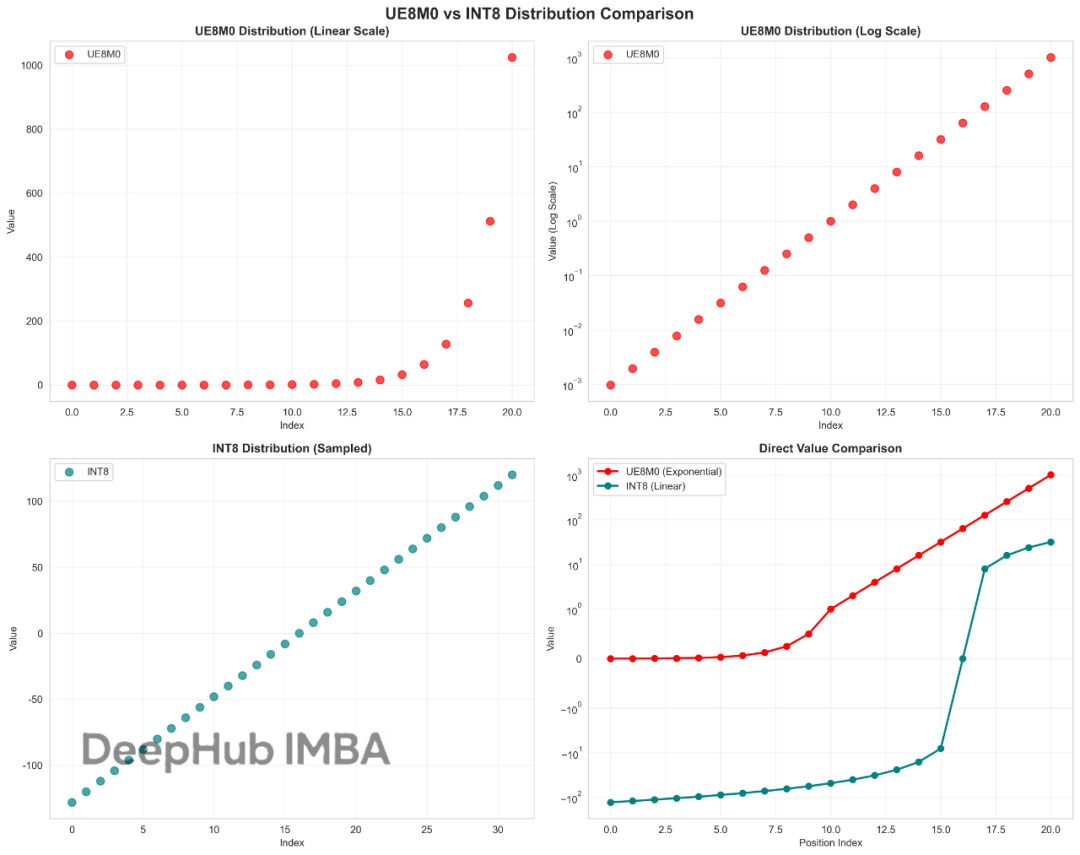

这也许就是DeepSeek V3.1性能提升的关键:UE8M0与INT8量化技术对比与优势分析

UE8M0作为FP8格式家族中的一个特殊变体,我们今天来看看这个UE8M0到底是什么。

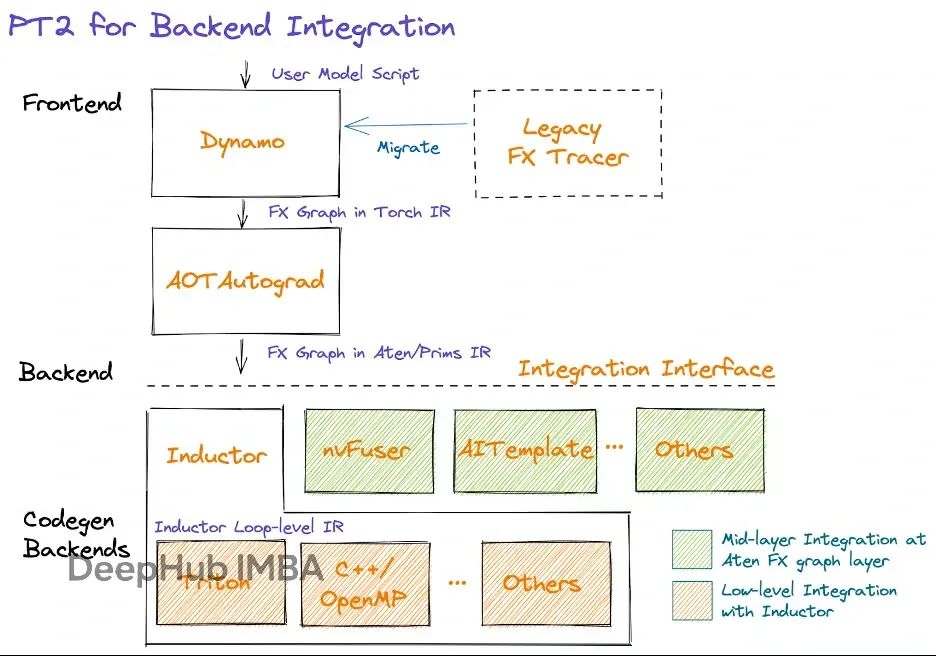

PyTorch 2.0性能优化实战:4种常见代码错误严重拖慢模型

我们将深入探讨图中断(graph breaks)和多图问题对性能的负面影响,并分析PyTorch模型开发中应当避免的常见错误模式。

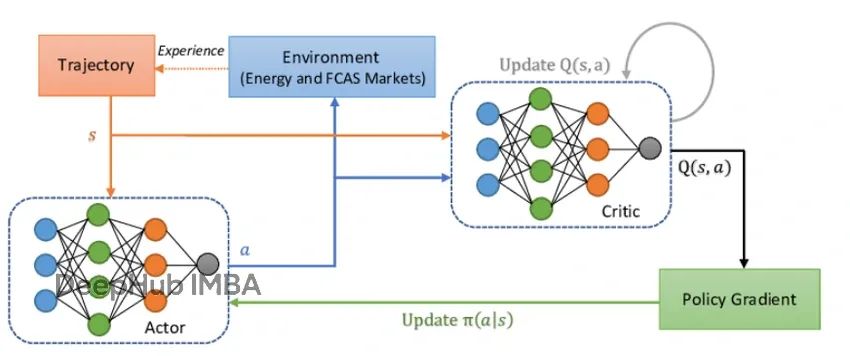

近端策略优化算法PPO的核心概念和PyTorch实现详解

本文提供了PPO算法的完整PyTorch实现方案,涵盖了从理论基础到实际应用的全流程。

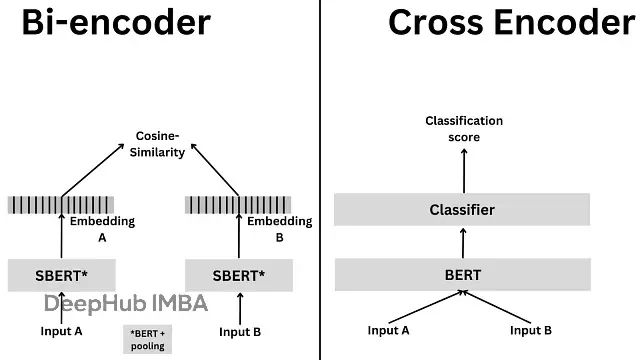

RAG系统文本检索优化:Cross-Encoder与Bi-Encoder架构技术对比与选择指南

本文将深入分析这两种编码架构的技术原理、数学基础、实现流程以及各自的优势与局限性,并探讨混合架构的应用策略。

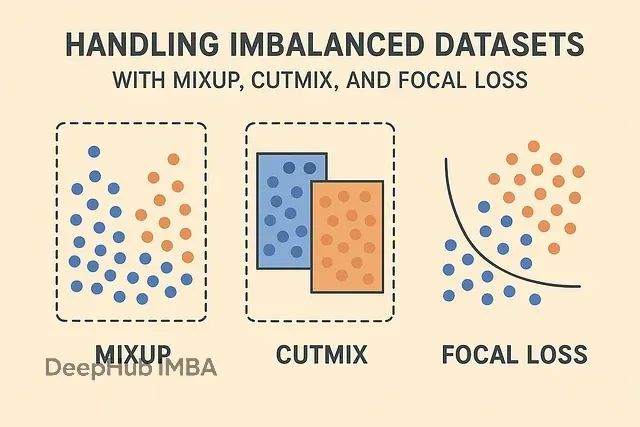

让模型不再忽视少数类:MixUp、CutMix、Focal Loss三种技术解决数据不平衡问题

针对不平衡数据集的挑战,研究界通常采用数据增强技术与损失函数优化相结合的策略。

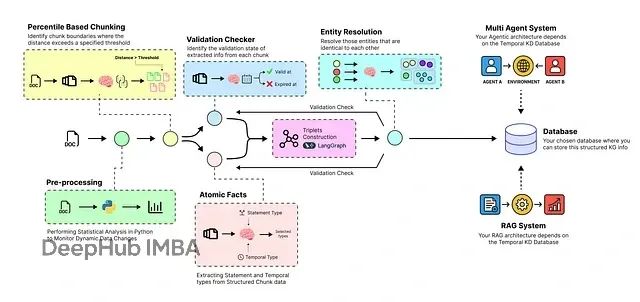

构建时序感知的智能RAG系统:让AI自动处理动态数据并实时更新知识库

本文将构建一个端到端的时序智能体管道,实现从原始数据到动态知识库的转换,并在此基础上构建多智能体系统以验证其性能表现。

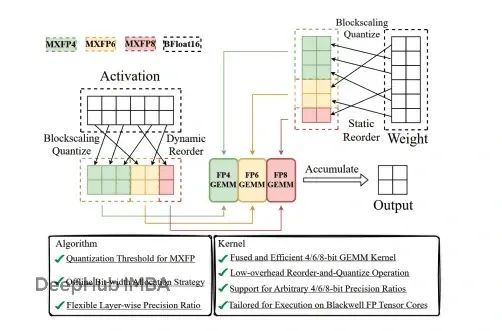

MXFP4量化:如何在80GB GPU上运行1200亿参数的GPT-OSS模型

GPT-OSS通过创新的量化技术实现了突破性进展。该系统能够在单个80GB GPU上运行1200亿参数模型,同时保持竞争性的基准测试性能。

AMD Ryzen AI Max+ 395四机并联:大语言模型集群推理深度测试

本文介绍使用四块Framework主板构建AI推理集群的完整过程,并对其在大语言模型推理任务中的性能表现进行了系统性评估。

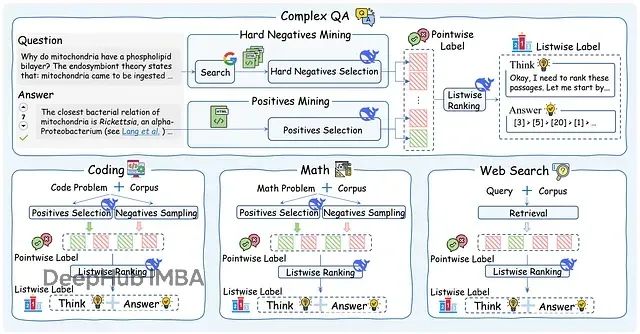

ReasonRank:从关键词匹配到逻辑推理,排序准确性大幅超越传统方法

本文深入分析ReasonRank,一个采用自动化数据合成框架和两阶段训练策略(监督微调+强化学习)的先进段落重排器,该系统在信息检索领域实现了突破性的推理能力