comfyui入门|超详细安装教程(汉化+管理器)

今天我给大家分享的是怎么安装comfyUI。网上安装comfyui的教程有很多,但是说的有点偏复杂了,特别是安装节点的时候,其实没那么难,这篇文章我就给大家分享下如何快速安装comfyui及各个节点的安装卸载。其实刚开始我也摸索了很久,遇到很多问题,我把遇到的问题都给大家整理好了,继续往下看;本次教

Yolo-World在基于自己的数据集训练后zero-shot能力显著下降甚至消失的问题

关于yolo-world的零样本检测能力问题

全球最强AI程序员 “Genie” 横空出世

Genie是迄今为止世界上最好的 AI 程序员。Genie启动。cosine.sh。

yolov5模型 9fps提升至27fps全过程

1. 安装ACLLite核心流程应该是怎么样的?3. NPU_HOST_LIB 的环境变量跟 /etc/profile中的不一样怎么办?9. videocapture.VideoCapture和cv2.VideoCapture的区别?11. mean_chn_i var_reci_chn 代表

推荐几款支持AI剪辑并可使用个人视频素材的软件!

点击编辑按钮,可以进入一键成片后的编辑状态,在这里你可以更换每段的视频素材、文案等,也可以编辑草稿,进行更多视频内容编辑,编辑完成后,点击右上角的“导出”按钮,就可以将编辑好的视频导出到本地!另一种是“输入和提取文案”,切换到“输入和提取文案”,自己输入视频脚本,或是点击“提取视频文案”功能键,选择

【大模型】 智谱 AI 的 GLM-4 来了,26 种语言支持,最高支持 1M 上下文长度(约 200 万中文字符)

智谱 AI 的 GLM-4 来了,26 种语言支持,最高支持 1M 上下文长度(约 200 万中文字符)

丹摩智算:如何在云端开发一个AI应用——基于UNet的眼底血管分割案例

丹摩智算低价狂欢节开始,4090、显示器等神秘好礼等待大家!

【AI大模型】-- 应用部署

这个数据可以有点偏大,我在实测过程中,部署llama3:14b的大模型,占用了仅16G内存,触发推理时会多一些,这个数据可作为参考。它特别适合大规模深度学习任务,通过高效的架构在性能和能源消耗上表现出色。:若需高速下载,尤其依赖于 GitHub 或 Docker 官方镜像,建议选择国外服务器。Goo

中介效应模型【STATA】

中介效应分析在社会科学研究中具有重要的地位,它有助于我们理解自变量如何通过中介变量影响因变量。在本文中,我们将详细介绍中介效应模型的理论原理,并结合 Stata 软件进行具体的操作步骤演示,同时考虑控制变量的影响。如果自变量 X 对因变量 Y 的总效应(c)可以分解为直接效应(c')和通过中介变量

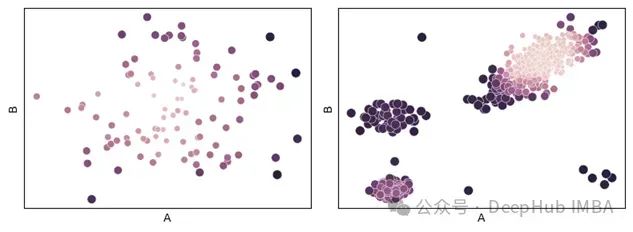

基于距离度量学习的异常检测:一种通过相关距离度量的异常检测方法

但在本文中,将一种非常通用且可能未被充分使用的方法,用于计算表格数据中两条记录之间的差异,这对异常检测非常有用,称为*距离度量学习* - 以及一种专门应用于异常检测的方法。

MaskRCNN 在 Windows 上的部署教程

在’train’模式下,主要关注dataset、weights和logs参数,确保它们正确指向了训练所需的数据集、权重文件和日志目录。在’splash’模式下,除了上述参数外,还需要关注image或video参数,确保它们正确指向了要检测的目标图像或视频文件。同时,weights参数应指向一个已训练

Transformer——逐步详解架构和完整代码搭建

Transformer是一个经典的编码解码结构,编码器decoder负责编码,解码器encoder负责解码。Transformer是基于seq2seq的架构,提出时被用在机器翻译任务上,后面变种Swin Transformer和Vision Transformer让其在CV领域也大放异彩。

使用imu_tools对IMU进行滤波可视化

本文是使用imu_tools对IMU数据进行滤波可视化。

从大模型到通用AI《智能计算系统》带你揭秘大模型背后的智能计算革命

全面贯穿人工智能整个软硬件技术栈以大模型为牵引,形成智能领域的系统思维前沿研究与技术实践结合,快速提升智能领域的系统能力第2版的更新内容包括如何构建大模型算法(第2、3章),如何让编程框架支撑海量处理器分布式训练大模型(第4、5章),如何在单个处理器层面实现算力提升(第6、7章),如何面向大模型进行

AI:230-YOLOv8与RT-DETR的完美结合 | 重塑目标检测技术的前沿【保姆级教程】

YOLOv8 继承了 YOLO 系列的轻量化和高效性,通过优化网络架构和训练策略,实现了在主流数据集上的领先表现。然而,YOLOv8 的检测头仍采用经典的 anchor-based 设计,这在处理高密度或多尺度目标时可能存在局限性。RT-DETR 是最近提出的一种基于 Transformer 的目标

如何创建和使用`.env`文件

env文件是一种用于存储环境变量的配置文件,它可以帮助你在不同的项目或应用中安全地管理敏感信息,如API密钥、数据库连接字符串等。本文将详细介绍如何创建.env文件,以及如何在项目中使用这些环境变量。.env。

Qwen2-57B-A14B预训练

Qwen2-57B-A14B作为一个强大的MoE模型,在保持较小激活参数规模的同时,实现了优秀的性能表现,为大规模语言模型的应用提供了新的可能性。任务中表现优异,超越了当前主流的MoE开源模型。SwiGLU激活函数。

ROS下进行深度相机标定及点云赋色(d2c)

深度相机的标定以及点云赋色(d2c)

从零开始微调阿里的qwen_vl_chat模型

通过这个重定向,标准错误输出和标准输出都会被写入 train.log 文件。这个脚本文件名为 finetune_lora_single_gpu.sh,通常用于单 GPU 上进行 LoRA(Low-Rank Adaptation)的微调。模型训练完会保存在output_qwen文件中,想要修改去fin

【AI工具】-GPU算力租赁平台介绍

目录1. AWS(亚马逊云服务)2. Google Cloud Platform (GCP)3. Microsoft Azure4. 阿里云5. 腾讯云6. 派欧算力云(PPIO)7. Lambda Labs8. 猿界算力9. AutoDL算力云(视拓云)10. 极链AI云注意事项