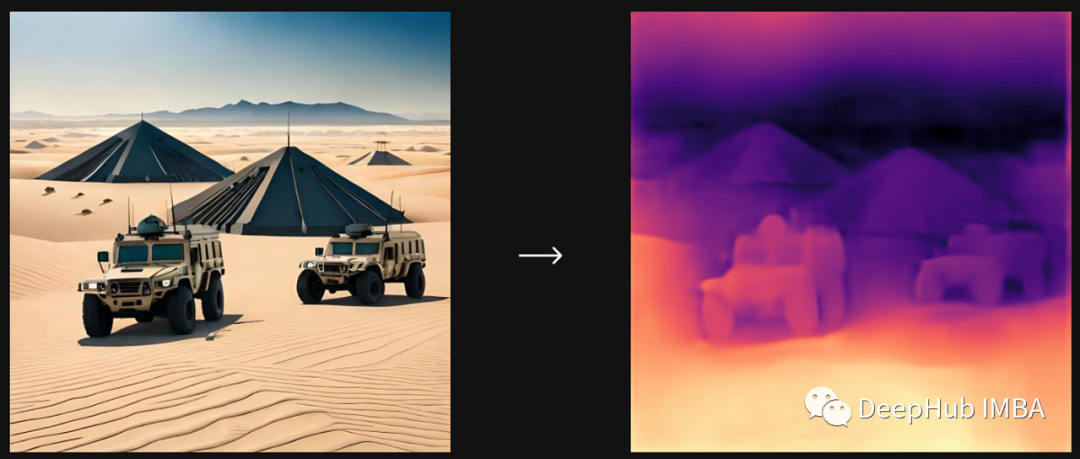

视觉大模型DINOv2:自我监督学习的新领域

本文将介绍DINOv2是如何改进的,以及这些进步可能对整个领域有什么影响。

Topsis算法实践:比较LSTM算法与BP神经网络算法,以chickenpox_dataset为例

本文用Topsis算法以chickenpox_dataset为例比较LSTM算法与BP神经网络算法,发现LSTM算法预测相比与BP神经网络预测结果并不理想,希望得到解释。

强化学习——多智能体强化学习

文章目录前言多智能体系统的设定合作关系设定下的多智能体系统策略学习的目标函数合作关系下的多智能体策略学习算法MAC-A2C前言本文总结《深度强化学习》中的多智能体强化学习相关章节,如有错误,欢迎指出。多智能体系统的设定多智能体系统包含有多个智能体,多个智能体共享环境,智能体之间相互影响。一个智能体的

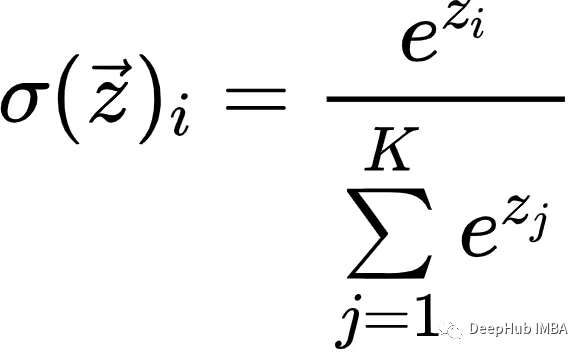

Softmax简介

Softmax是一种数学函数,通常用于将一组任意实数转换为表示概率分布的实数。

基于随机森林的特征选择-降维-回归预测——附代码

可以看到,使用两个特征进行预测的准确度为85.2077,与使用所有特征进行预测的准确度相差不大,这表明随机森林特征选择方法有效的选择出了最重要的特征,实现了从大量特征到少数重要特征的特征降维筛选,极大的降低了特征的冗余性。当随机森林评价完成特征的重要性后,还需要对各个特征变量之间的相关性进行评估,以

使用Actor-Critic的DDPG强化学习算法控制双关节机械臂

在本文中,我们将介绍在 Reacher 环境中训练智能代理控制双关节机械臂

语义分割系列15-UPerNet(pytorch实现)

本文介绍了UPerNet论文思想,介绍了UPerNet作者如何创建Multi-task数据集以及如何设计UPerNet网络和检测头来解决Multi-task任务。本文对于UPerNet语义分割部分的模型进行单独复现,所有代码基于pytorch框架,并在Camvid数据集上进行训练和测试。......

使用LSTM预测结果为一条直线原因总结

使用LSTM预测结果为一条直线原因总结

优化改进YOLOv5算法之添加SE、CBAM、CA模块(超详细)

本文主要是在YOLOv5算法中加入SE、CBAM和CA注意力机制模块,通过实验验证对比,加入CBAM和CA注意力机制后的效果均有所提升

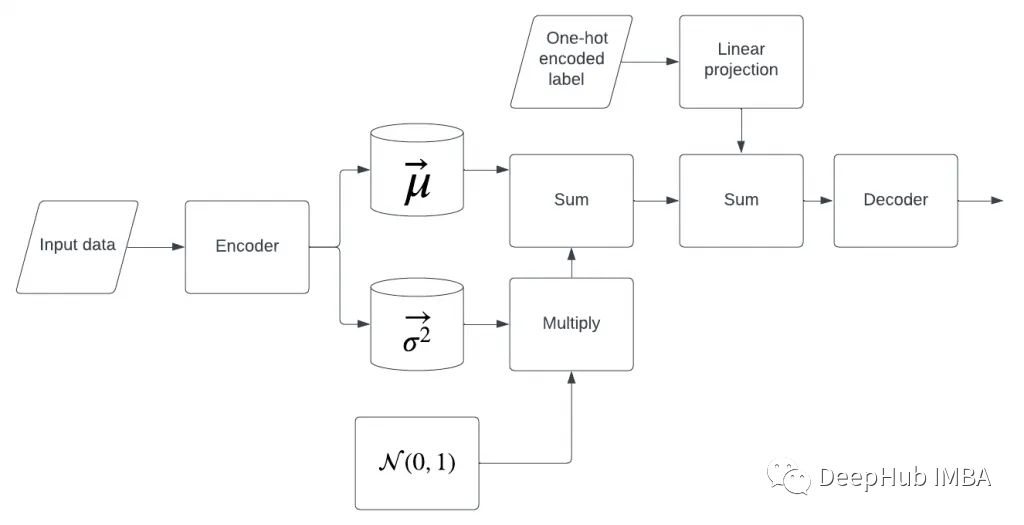

四种类型自编码器AutoEncoder理解及代码实现

慢慢的会设计自己的编码器和解码器。全部都将其搞定都行啦的回事与打算。慢慢的全部都将其搞定都行啦的回事与打算。

chatgpt3接口 国内版免费使用

目前OpenAI公司提供了GPT-3的API服务,允许开发者通过调用API接口,使用GPT-3的功能。总的来说,GPT-3的API接口是一个非常方便和高效的自然语言处理工具,可以帮助您快速解决自然语言处理问题,例如生成文本、回答问题等任务。但需要注意的是,API使用需要遵从OpenAI公司的相关规定

Torch 模型 onnx 文件的导出和调用

OpenNeuralNetworkExchange(ONNX,开放神经网络交换)格式,是一个用于表示深度学习模型的标准,可使模型在不同框架之间进行转移Torch所定义的模型为动态图,其前向传播是由类方法定义和实现的但是Python代码的效率是比较底下的,试想把动态图转化为静态图,模型的推理速度应当有

NLP自然语言处理简介

NLP自然语言处理简介

从零开始实现VAE和CVAE

扩散模型可以看作是一个层次很深的VAE(变分自编码器)本文将用python从头开始实现VAE和CVAE,来增加对于它们的理解。

yolov5源码解析(10)--损失计算与anchor

本文章基于yolov5-6.2版本。主要讲解的是yolov5在训练过程中是怎么由推理结果和标签来进行损失计算的。损失函数往往可以作为调优的一个切入点,所以我们首先要了解它。

深度学习:图像去雨网络实现Pytorch (二)一个简单实用的基准模型(PreNet)实现

详细介绍了一种简单实用的去雨模型PreNet在Pytorch框架下的搭建过程,供读者参考学习

注意力机制(含pytorch代码及各函数详解)

目录注意力机制非参注意力汇聚概述(不需要学习参数)参数化注意力机制概述正式系统学习1.平均汇聚(池化)2.非参数注意力汇聚(池化)3.带参数注意力汇聚注意力机制不随意线索:不需要有想法,一眼就看到的东西随意线索:想看书,所以去找了一本书1.卷积、全连接、池化层都只考虑不随意线索2.注意力机制则显示的

GAM注意力机制

GAM解析,使用Pytorch实现GAM attention

【使用Pytorch实现ResNet网络模型:ResNet50、ResNet101和ResNet152】

在深度学习和计算机视觉领域取得了一系列突破。尤其是随着非常深的卷积神经网络的引入,这些模型有助于在图像识别和图像分类等问题上取得最先进的结果。因此,多年来,深度学习架构变得越来越深(添加更多层)以解决越来越复杂的任务,这也有助于提高分类和识别任务的性能并使其变得健壮。但是当我们继续向神经网络添加更多