分享3个深度学习练手的小案例

最近有粉丝找到我问了三个关于深度学习的问题,也算是小作业吧,做完之后我便写下这篇文章分享给大家,我的答案仅供参考学习,如有疑问或建议欢迎提出!

PyTorch搭建LSTM神经网络实现文本情感分析实战(附源码和数据集)

PyTorch搭建LSTM神经网络实现文本情感分析实战(附源码和数据集)

卷积神经网络(CNN)详细介绍及其原理详解

本文总结了关于卷积神经网络(CNN)的一些基础的概念,并且对于其中的细节进行了详细的原理讲解,通过此文可以十分全面的了解卷积神经网络(CNN),非常适合于作为Deep Learning的入门学习。下面就是本篇博客的全部内容!

神经网络学习小记录73——Pytorch CA(Coordinate attention)注意力机制的解析与代码详解

神经网络学习小记录72——Pytorch CA(Coordinate attention)注意力机制的解析与代码详解学习前言代码下载CA注意力机制的概念与实现注意力机制的应用学习前言CA注意力机制是最近提出的一种注意力机制,全面关注特征层的空间信息和通道信息。代码下载Github源码下载地址为:ht

神经网络——Python实现BP神经网络算法(理论+例子+程序)

一、基于BP算法的多层感知器模型采用BP算法的多层感知器是至今为止应用最广泛的神经网络,在多层感知器的应用中,以图3-15所示的单隐层网络的应用最为普遍。一般习惯将单隐层前馈网称为三层感知器,所谓三层包括了输入层、隐层和输出层。算法最终结果采用梯度下降法,具体详细过程此处就省略了!二、BP算法的程序

更新版yolov5_deepsort_pytorch实现目标检测和跟踪

由于mikel-brostrom在github上发布的Yolov5_DeepSort_Pytorch更新,使整个代码封装性更好,进而允许采用多种REID特征识别模型,完善了deepsort在检测跟踪方面的性能。本博文记录如何使用此版本Yolov5_DeepSort_Pytorch的过程,同时给出ZQ

BP神经网络预测回归MATLAB代码(代码完整可直接用,注释详细,可供学习)

BP神经网络预测回归MATLAB代码(代码完整可用,复制后即可运行使用,不懂也可直接使用,操作简单)

卷积神经网络(convolutional neural network, CNN)

基本定义卷积神经网络(convolutional neural network, CNN),是一类包含卷积计算且具有深度结构的前馈神经网络。卷积神经网络是受生物学上感受野(Receptive Field)的机制而提出的。卷积神经网络专门用来处理具有类似网格结构的数据的神经网络。例如,时间序列数据(可

LSTM和双向LSTM讲解及实践

慢慢的将各种双向LSTM全部都将其搞定都行啦的回事与打算。

计算GMAC和GFLOPS

GMAC 代表“Giga Multiply-Add Operations per Second”(每秒千兆乘法累加运算),是用于衡量深度学习模型计算效率的指标。它表示每秒在模型中执行的乘法累加运算的数量,以每秒十亿 (giga) 表示。

NSFW 图片分类

NSFW指的是不适宜工作场所("Not Safe (or Suitable) For Work;")。在本文中,将介绍如何创建一个检测NSFW图像的图像分类模型。

【深度学习】常见的神经网络层(上)

在深度学习中常见的神经网络层的讲解

图灵奖得主、AI 教父、神经网络大师——谷歌副总裁 Hinton 离职——称其对毕生工作感到后悔和恐惧

杰弗里·辛顿(Geoffrey Hinton)生平杰弗里·辛顿(Geoffrey Hinton,1947年12月6日—)是一位英国出生的计算机科学家,现居加拿大。他是加拿大麦吉尔大学和多伦多大学的荣誉博士,威廉 · 门罗 · 勒默尔计算机科学教授。1980年获得爱丁堡大学人工智能领域博士学位。他是神

pytorch进阶学习(三):在数据集数量不够时如何进行数据增强

1. 尺寸放大缩小2. 旋转(任意角度,如45°,90°,180°,270°)3. 翻转(水平翻转,垂直翻转)4. 明亮度改变(变亮,变暗)5. 像素平移(往一个方向平移像素,空出部分自动填补黑色)6. 添加噪声(椒盐噪声,高斯噪声)

使用大语言模型集成工具 LangChain 创建自己的论文汇总和查询工具

Langchain可以帮助开发人员构建由大型语言模型(llm)支持的应用程序。所以本文将介绍如何使用LangChain来创建我们自己的论文汇总工具。

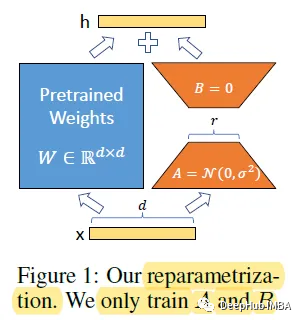

LoRA:大模型的低秩自适应微调模型

对于大型模型来说,重新训练所有模型参数的全微调变得不可行。Microsoft 提出了低秩自适应大大减少了下游任务的可训练参数数量。

如何计算神经网络参数的个数?

神经网络随着层数的加深,网络参数的个数会越来越多,小的网络有成千上万个参数,大的可以达到千万个网络参数。这里我们介绍一下如何计算神经网络参数的个数图像分类的神经网络,包含两个部分:特征提取层+ 分类层特征提取层就是将提取图像中的特征,这里的特征就是图像的细节,例如边缘、关键点等等。类似于人在识别物体

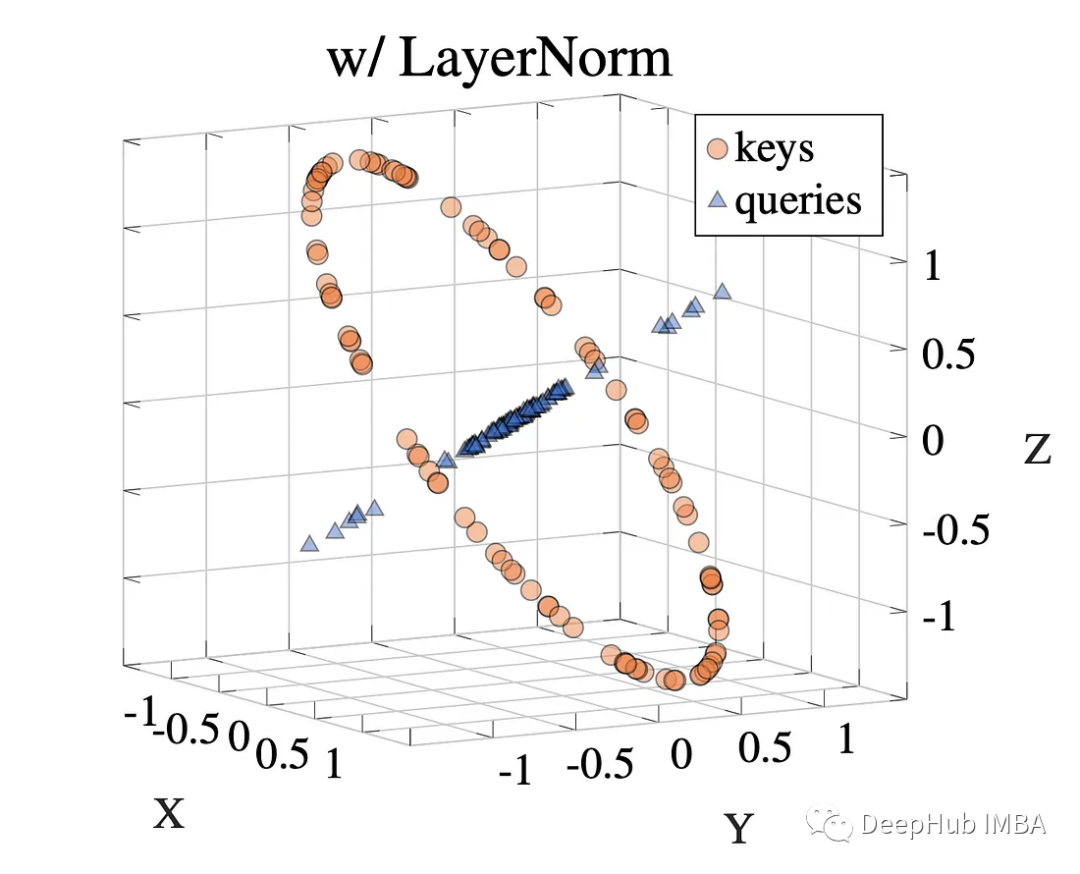

LayerNorm 在 Transformers 中对注意力的作用研究

LayerNorm 一直是 Transformer 架构的重要组成部分。如果问大多人为什么要 LayerNorm,一般的回答是:使用 LayerNorm 来归一化前向传播的激活和反向传播的梯度。

什么是预训练模型?

什么是预训练模型?

forward函数——浅学深度学习框架中的forward

forward函数是深度学习框架中常见的一个函数,用于定义神经网络的前向传播过程。在训练过程中,输入数据会被传入神经网络的forward函数,然后经过一系列的计算和变换,最终得到输出结果。具体来说,forward函数的作用是将输入数据经过网络中各个层的计算和变换后,得到输出结果。在forward函数