数据挖掘(6.1)--神经网络

神经网络是一种计算模型,它受到人脑处理信息的生物神经网络过程的启发。人工神经网络(ANN)一般也称为神经网络(Neural Network,NN)。神经网络是由多个神经元组成的,每个神经元都有一个输入和一个输出,它们之间通过权重进行连接。当输入数据经过多个神经元后,输出结果就是由这些神经元的输出加权

【模型+代码/保姆级教程】使用Pytorch实现手写汉字识别

保姆级教程,手把手用Pytorch搭建神经网络,识别3755类手写汉字,模型参数、项目完整源码、预处理数据集全部公开。

技术干货 | 一文弄懂差分隐私原理!

图1 随机算法在邻近数据集上的概率差分隐私有两个重要的优点:差分隐私假设攻击者能够获得除目标记录以外的所有其他记录信息,这些信息的总和可以理解为攻击者能够掌握的最大背景知识,在这个强大的假设下,差分隐私保护无需考虑攻击者所拥有的任何可能的背景知识。差分隐私建立在严格的数学定义上,提供了可量化评估的方

谷歌发布一个免费的生成式人工智能课程

谷歌推出了一个生成式人工智能学习课程,课程涵盖了生成式人工智能入门、大型语言模型、图像生成等主题。

【人工智能】期末复习 重点知识点总结

人工智能期末复习考点

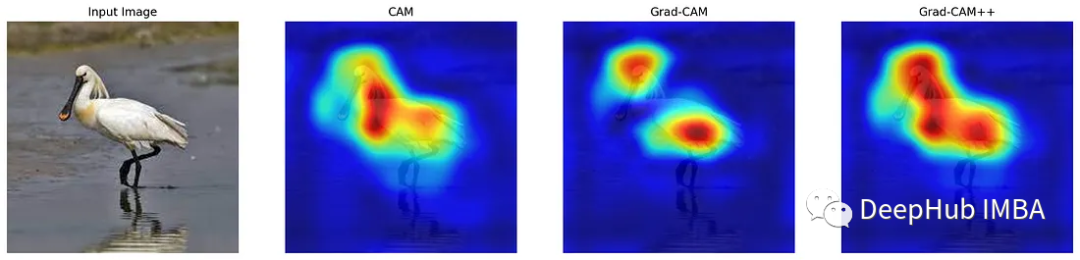

CAM, Grad-CAM, Grad-CAM++可视化CNN方式的代码实现和对比

理解CNN的方法主要有类激活图(Class Activation Maps, CAM)、梯度加权类激活图(Gradient Weighted Class Activation Mapping, Grad-CAM)和优化的 Grad-CAM( Grad-CAM++)。

煤炭行业生命周期分析,煤炭行业周期性特征

一、价值分析影响股价的长期走势产出和投入之比所形成的价值,即通过价值思维的分析,判断出的股价的产出与投入比,决定着股价的长期走势,二、基本面分析影响股价的中期走势基本面分析即宏观经济的分析,也就是经济形势的好坏,增长速度的高低、快慢,影响整个宏观经济发展的运行态势技术分析是对于股价的长期上涨和下跌所

【代码复现】5秒训练NeRF!英伟达instan-ngp在windows成功复现

主要介绍了在WINDOWS10下运行instant-ngp的方法,并且介绍了自定义数据集创建和运行的方法。

机器学习题目汇总

机器学习题目

卷积神经网络每一层输出的形状、通道数、特征图数量以及过滤器数量的理解与计算。

卷积神经网络中的一些易混淆概念

BP神经网络原理

BP神经网络(Back Propagation Neural Network)是一种基于误差反向传播算法(Back Propagation Algorithm)的人工神经网络,也是应用最广泛的神经网络之一。它可以用来解决分类、回归、模式识别、数据挖掘等多种问题。BP神经网络由输入层、隐层和输出层组成

七篇深入理解机器学习和深度学习的读物推荐

在这篇文章中将介绍7篇机器学习和深度学习的论文或者图书出版物,这些内容都论文极大地影响了我对该领域的理解,如果你想深入了解机器学习的内容,哪么推荐阅读。

人工智能神经网络概念股,神经网络芯片概念股

人工智能包含硬件智能、软件智能和其他。硬件智能包括:汉王科技、康力电梯、慈星股份、东方网力、高新兴、紫光股份。软件智能包括:金自天正、科大讯飞。其他类包括:中科曙光、京山轻机。谷歌人工智能写作项目:小发猫1、苏州科达:苏州科达科技股份有限公司是领先的视讯与安防产品及解决方案提供商,致力于以视频会议、

机器学习特征重要性分析

特征选择

基于MindSpore复现UNet—语义分割

U-Net: Convolutional Networks for Biomedical Image Segmentation

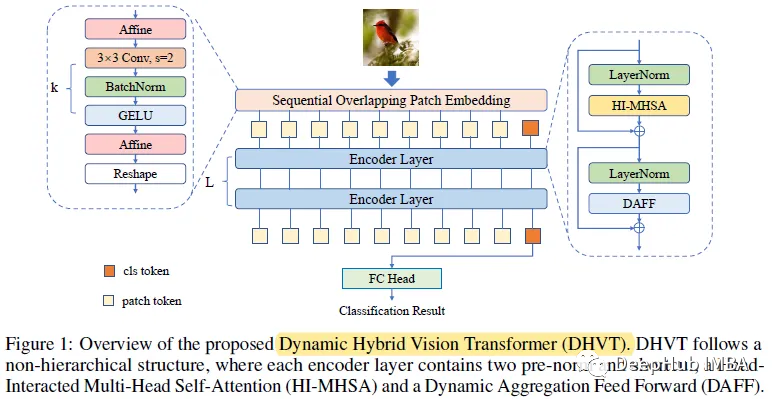

DHVT:在小数据集上降低VIT与卷积神经网络之间差距,解决从零开始训练的问题

VIT在归纳偏置方面存在空间相关性和信道表示的多样性两大缺陷。所以论文提出了动态混合视觉变压器(DHVT)来增强这两种感应偏差。

YOLOV5实战教程(超级详细图文教程)!!!

1.本文的目的在于帮助读者实现yolov5的训练,测试以及使用,偏重应用,将有较少代码讲解2.本文将首先示范使用coco128数据集进行训练,向读者展示整个模型的使用过程,之后介绍如何制作自己的数据集并进行训练3.本文使用的数据集coco128放在网盘里了,如果没有这个数据集的话可以去网盘上下载,y

PyTorch深度学习实战(1)——神经网络与模型训练过程详解

在本节中,我们将了解传统机器学习与人工神经网络间的差异,并了解如何在实现前向传播之前连接网络的各个层,以计算与网络当前权重对应的损失值;实现反向传播以优化权重达到最小化损失值的目标。并将实现网络的所有关键组成——前向传播、激活函数、损失函数、链式法则和梯度下降,从零开始构建并训练了一个简单的神经网络

【AI】AI 工具合集

ai 工具集合, 包括 AI文本、AI 视频、AI 音频、AI 绘画

过拟合解决

常见过拟合问题解决