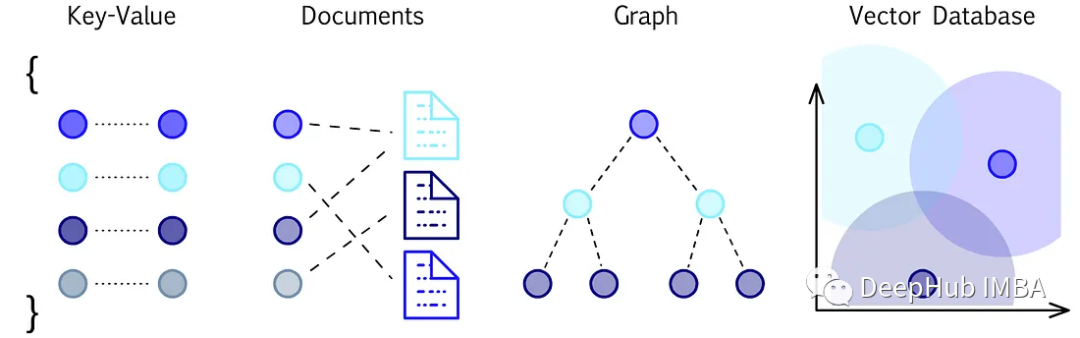

矢量数据库对比和选择指南

矢量数据库是为实现高维矢量数据的高效存储、检索和相似性搜索而设计的。使用一种称为嵌入的过程,将向量数据表示为一个连续的、有意义的高维向量。

模型加载至 cpu 和 gpu 的方式

模型加载至 cpu 和 gpu 的方式,只需改一句话

PANet(CVPR 2018)原理与代码解析

信息在神经网络中的传播方式是非常重要的。本文提出的路径聚合网络(Path Aggregation Network, PANet)旨在促进proposal-based实例分割框架中的信息流动。具体来说,通过自底向上的路径增强,利用底层中精确的定位信息来增强整个特征层次,缩短了下层与最上层之间的信息路径

AI实战营:MMPose开源算法库

【代码】AI实战营:MMPose开源算法库。

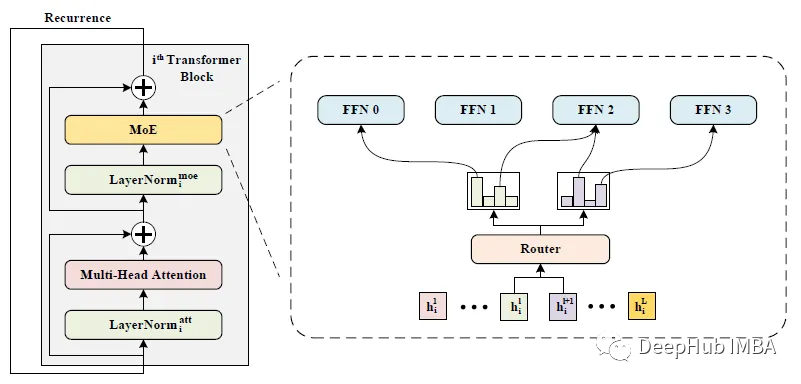

WideNet:让网络更宽而不是更深

这是新加坡国立大学在2022 aaai发布的一篇论文。WideNet是一种参数有效的框架,它的方向是更宽而不是更深。通过混合专家(MoE)代替前馈网络(FFN),使模型沿宽度缩放。使用单独LN用于转换各种语义表示,而不是共享权重。

基于 YOLOv8 的自定义数据集训练

图1.1:YOLOv8初始测试YOLOv8????于 2023年1月10日由Ultralytics发布。它在计算机视觉方面提供了进展,带来了对我们感知、分析和理解视觉世界的巨大创新。它将为各个领域带来前所未有的可能性。在速度、准确性和架构方面进行了相当大的改进。它是从头开始实现的,没有使用任何来自Y

LoRA模型是什么?

LoRA(Low-Rank Adaptation of Large Language Models,大型语言模型的低秩适应)是微软研究员提出的一种新颖技术,旨在解决微调大型语言模型的问题。研究人员发现,通过专注于大型语言模型的Transformer注意力块,LoRA的微调质量与完整模型的微调相当,同

pytorch 手动顺序搭建resnet18、附带训练代码、测试代码

文件名:mode_resnet18。

Simulink中传递函数transfer fcn中迟滞参数如何设置

simulink中传递函数transfer fcn中的参数设定,使其与原始信号更接近或按需平滑处理。

深度学习之FPN+PAN

FPN+PAN

芒果改进YOLOv8系列:改进特征融合网络 BiFPN 结构,融合更多有效特征

代码实践|YOLOv8 + BiFPN 高效结构

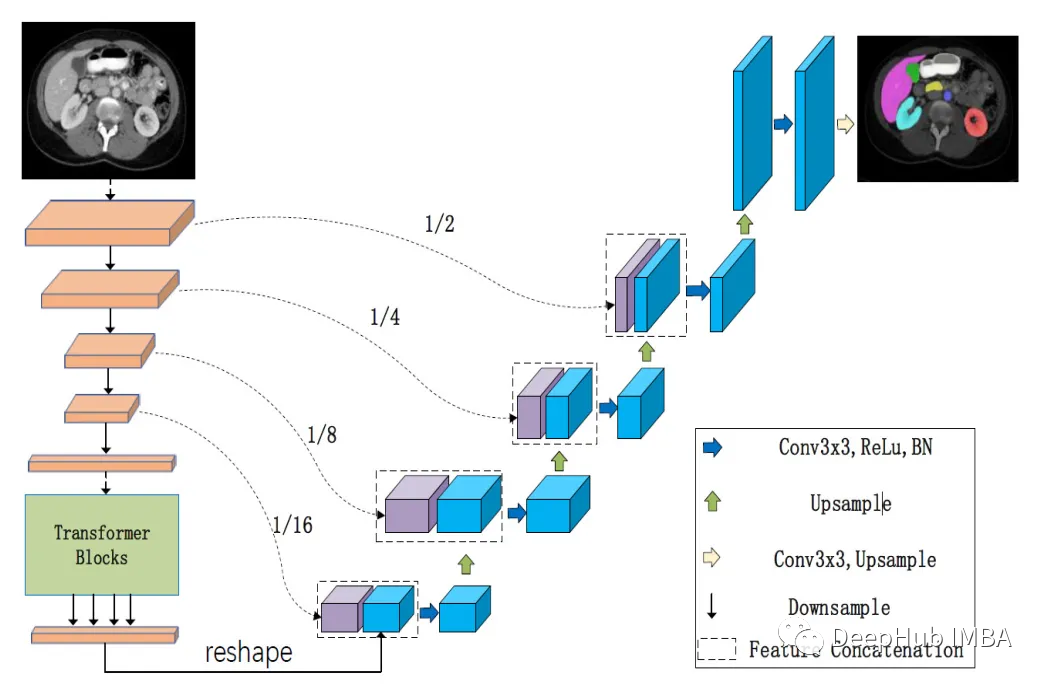

LeViT-UNet:transformer 编码器和CNN解码器的有效整合

levi - unet[2]是一种新的医学图像分割架构,它使用transformer 作为编码器,这使得它能够更有效地学习远程依赖关系。levi - unet[2]比传统的U-Nets更快,同时仍然实现了最先进的分割性能。

通用人工智能之路:什么是强化学习?如何结合深度学习?

【专栏订阅必读】ChatGPT强大魔力的关键因素之一是应用了强化学习模型,本文系统梳理强化学习中环境、智能体、奖赏、动作、状态等关键概念,并给出深度强化学习框架。

注意力机制之SK Attention

注意力机制

人工智能与大数据面试指南——自然语言处理(NLP)

人工智能与大数据面试指南》系列下的内容会,有需要的读者可以文章,以及时获取文章的最新内容。

【深度学习】优化器详解

深度学习中常见的优化器

【科研】ET-BERT代码分析

论文使用的TLS1.3数据集是从 2021 年 3 月到 2021 年 7 月在中国科技网 (CSTNET) 上收集的。【困惑点1】执行代码里使用的encryptd_vocab.txt不造从哪里生成的,,待我看看代码。:由于可能存在原始PCAP数据的复杂性,建议在报错时执行以下步骤检查代码执行情况。

深入浅出TensorFlow2函数——tf.random.normal

tf.random.normal

换脸ai的方法分享!这几个换脸APP巨好用。

换脸ai的方法分享!这种技术利用机器学习模型分析和学习大量的人脸数据,训练出一种“生成对抗网络”(GAN)模型,通过对待处理的图片进行编码,然后根据源图像和目标图像的相似度,自动生成合成图像,那么很多小伙伴可能没太听懂,也不知道该用什么进行操作,下面感兴趣的小伙伴快跟随小编一起来看看吧!这个网站是一

Pytorch模型如何查看每层输入维度输出维度

表示模型的输入维度,即 C = 3,H = 32,W = 32。运行后可以看到所有层输入、输出的维度以及参数数量等信息。库来实现对 PyTorch 模型的结构及参数统计的输出,其可以方便我们查看每层输入、输出的维度以及参数数量等信息。在 PyTorch 中,可以使用。