贝叶斯状态空间神经网络:融合概率推理和状态空间实现高精度预测和可解释性

本文将BSSNN扩展至反向推理任务,即预测*X∣y*,这种设计使得模型不仅能够预测结果,还能够探索特定结果对应的输入特征组合。

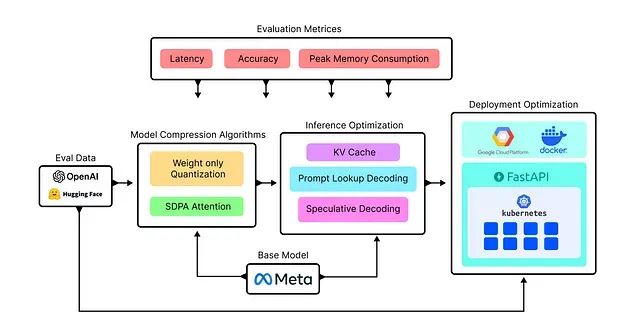

构建高性能LLM推理服务的完整方案:单GPU处理172个查询/秒、10万并发仅需15美元/小时

本文将通过系统性实验不同的优化技术来构建自定义LLaMA模型服务,目标是高效处理约102,000个并行查询请求,并通过对比分析确定最优解决方案。

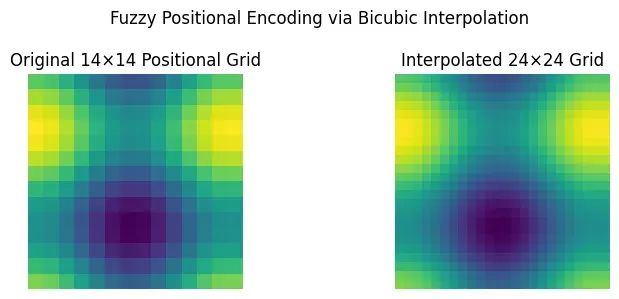

ViTAR:模糊位置编码让视觉Transformer适配任意分辨率图像

ViTAR代表了视觉Transformer技术的重要进步,特别是在处理多样化和高分辨率图像数据的应用场景中表现出显著优势。

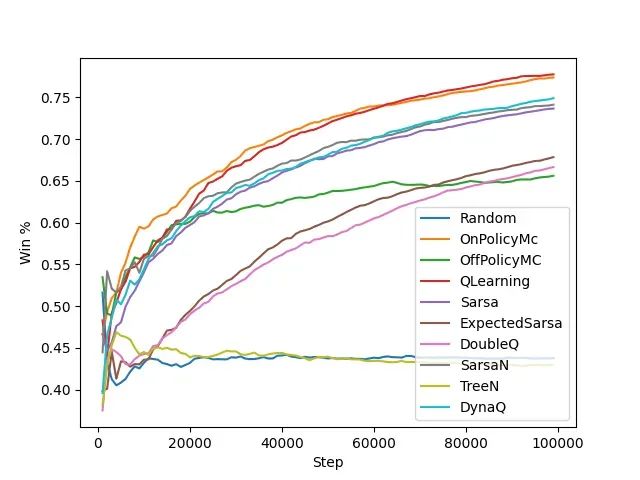

强化学习算法基准测试:6种算法在多智能体环境中的表现实测

本文构建了多智能体强化学习的系统性评估框架,选择井字棋和连珠四子这两个具有代表性的双人博弈游戏作为基准测试环境。通过引入模型动物园策略和自我对战机制,研究探索了各种表格方法在动态对抗环境中的学习能力和收敛特性。

刚发布的最新版本怎么用?YOLOv13新手教程带你快速上手

本文将详细介绍YOLOv13的完整实现流程,涵盖数据集准备、模型训练、验证评估以及实际应用等关键环节。

Flow Matching生成模型:从理论基础到Pytorch代码实现

本文将系统阐述Flow Matching的完整实现过程,包括数学理论推导、模型架构设计、训练流程构建以及速度场学习等关键组件。通过本文的学习,读者将掌握Flow Matching的核心原理,获得一个完整的PyTorch实现

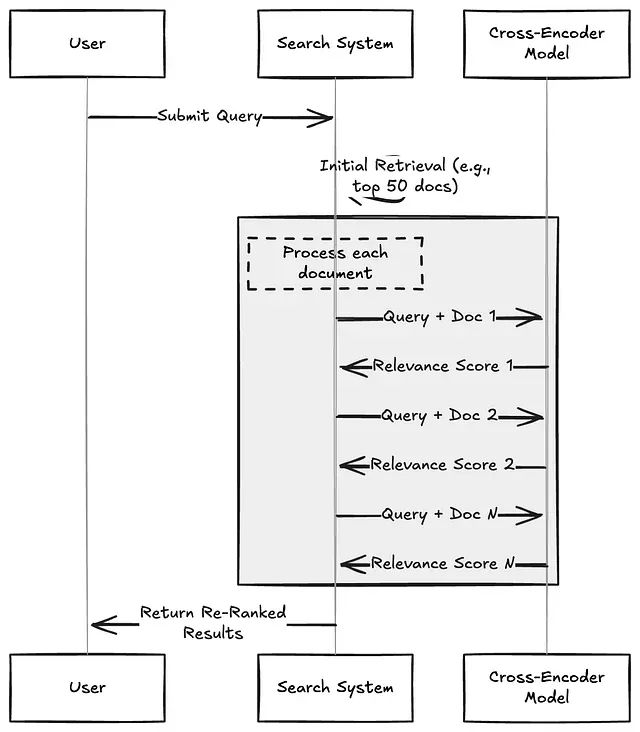

信息检索重排序技术深度解析:Cross-Encoders、ColBERT与大语言模型方法的实践对比

本文将深入分析三种主流的重排序技术:Cross-Encoders(交叉编码器)、ColBERT以及基于大语言模型的重排序器,并详细阐述各方案在实际应用中的性能表现、成本考量以及适用场景。

大语言模型也可以进行图像分割:使用Gemini实现工业异物检测完整代码示例

本文将通过一个实际应用场景——工业传送带异物检测,详细介绍如何利用Gemini的图像分割能力构建完整的解决方案。

CUDA性能优化实战:7个步骤让并行归约算法提升10倍效率

本文深入探讨了一个经典的并行计算算法——并行归约(Parallel Reduction)的性能优化过程,通过七个渐进式的优化步骤,展示了如何将算法性能提升至极致。

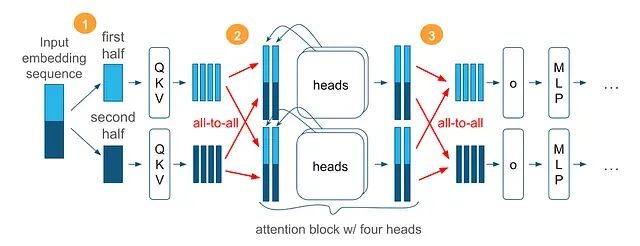

Arctic长序列训练技术:百万级Token序列的可扩展高效训练方法

Arctic长序列训练(Arctic Long Sequence Training, ALST)技术能够在4个H100节点上对Meta的Llama-8B模型进行高达1500万token序列的训练,使得长序列训练在标准GPU集群甚至单个GPU上都能实现快速、高效且易于部署的执行。

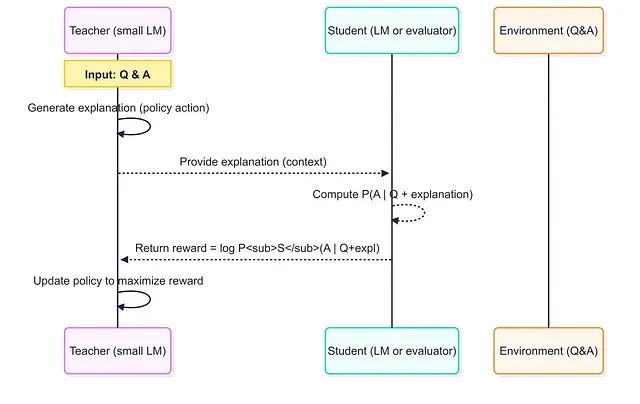

小模型当老师效果更好:借助RLTs方法7B参数击败671B,训练成本暴降99%

强化学习教师模型代表了训练推理语言模型的范式转变。通过从答案开始并专注于解释生成,RLT将训练过程转化为师生协作游戏,实现多方共赢:教师学会有效教学,学生从定制化课程中受益,工程师获得性能更好且成本更低的模型解决方案。

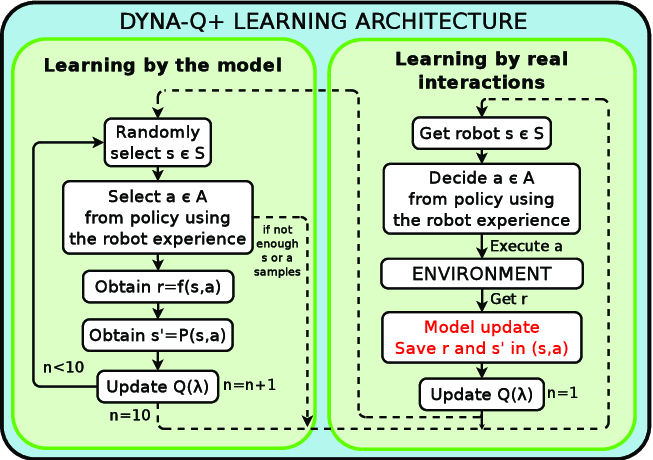

基于Dyna-Q强化学习的智能营销系统:融合贝叶斯生存模型与Transformer注意力机制的电商客户重参与策略优化

本文提出了一个集成三种核心技术的下一代智能优惠券分发系统:基于贝叶斯生存模型的重购概率预测、采用注意力机制的Transformer利润预测模型,以及用于策略持续优化的Dyna-Q强化学习代理。

解决语义搜索痛点,基于对比学习的领域特定文本嵌入模型微调实践

本文深入探讨了基于对比学习的嵌入模型微调技术,并通过AI职位匹配的实际案例验证了该方法的有效性。微调后的模型在测试集上实现了100%的准确率,充分证明了针对特定领域进行模型优化的必要性和可行性。

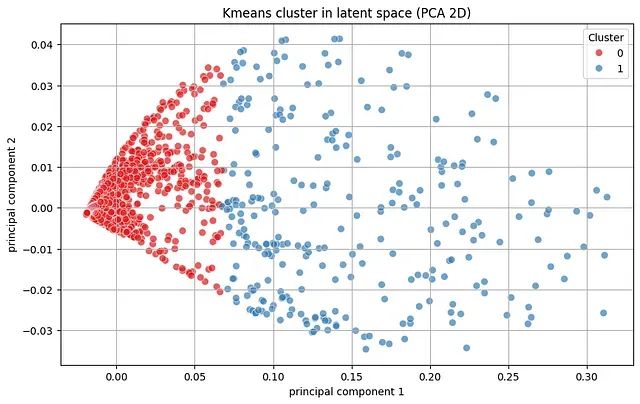

基于LSTM自编码器与KMeans聚类的时间序列无监督异常检测方法

本文提出的基于LSTM自编码器和KMeans聚类的组合方法,通过整合深度学习的序列建模能力与无监督聚类的模式分组优势,实现了对时间序列数据中异常模式的有效检测,且无需依赖标注的异常样本进行监督学习。

Chonkie:面向大语言模型的轻量级文本分块处理库

Chonkie作为一个专业的文本分块处理库,为大语言模型应用提供了全面而高效的解决方案。

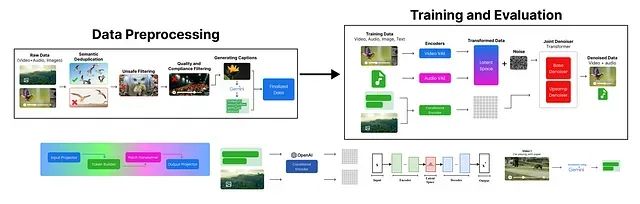

从零复现Google Veo 3:从数据预处理到视频生成的完整Python代码实现指南

本文详细介绍了一个简化版 Veo 3 文本到视频生成模型的构建过程。首先进行了数据预处理,涵盖了去重、不安全内容过滤、质量合规性检查以及数据标注等环节。

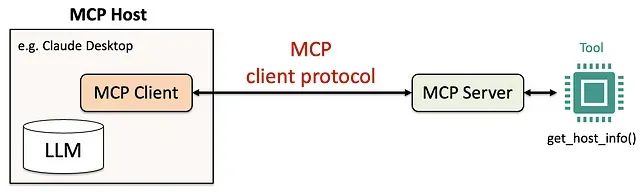

Python构建MCP服务器完整教程:5步打造专属AI工具调用系统

本文通过实际的代码示例和详细的配置步骤,展示了使用Python和Anthropic的mcp库构建MCP服务器的完整过程。我们从工具函数的设计开始,逐步介绍了MCP服务器的构建、AI代理的配置以及功能测试的验证方法。

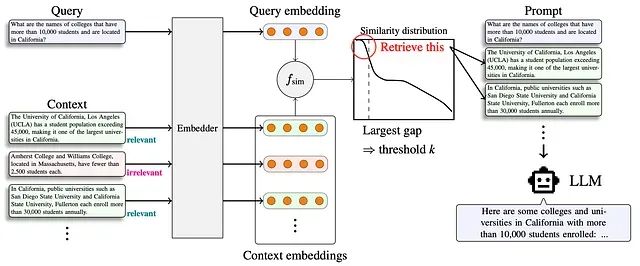

Adaptive-k 检索:RAG 系统中自适应上下文长度选择的新方法

Adaptive-k 代表了 RAG 系统从固定检索向智能化、查询感知检索的技术范式转变。该技术实现了显著的效率提升——在保持或提高准确性的同时,token 减少高达 99%。

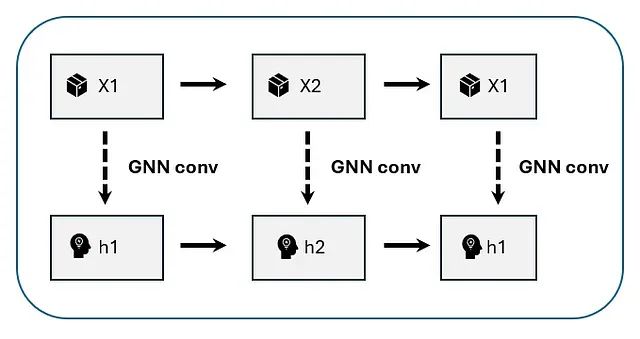

基于时间图神经网络多的产品需求预测:跨序列依赖性建模实战指南

本文展示了如何通过学习稀疏影响图、应用图卷积融合邻居节点信息,并结合时间卷积捕获演化模式的完整技术路径,深入分析每个步骤的机制原理和数学基础。

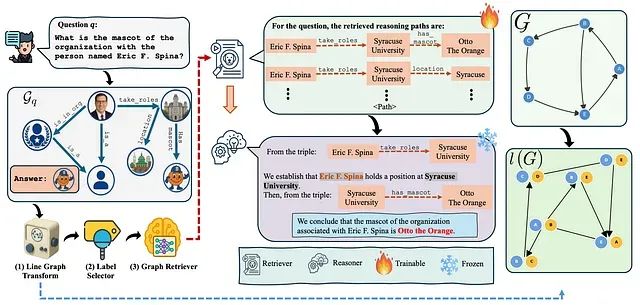

解决RAG检索瓶颈:RAPL线图转换让知识图谱检索准确率提升40%

本文深入探讨RAPL(Retrieval-Augmented Path Learning)框架,这是一个创新的人工智能架构,通过线图转换和合理化监督技术,从根本上改进了知识图谱环境下的检索增强生成系统。