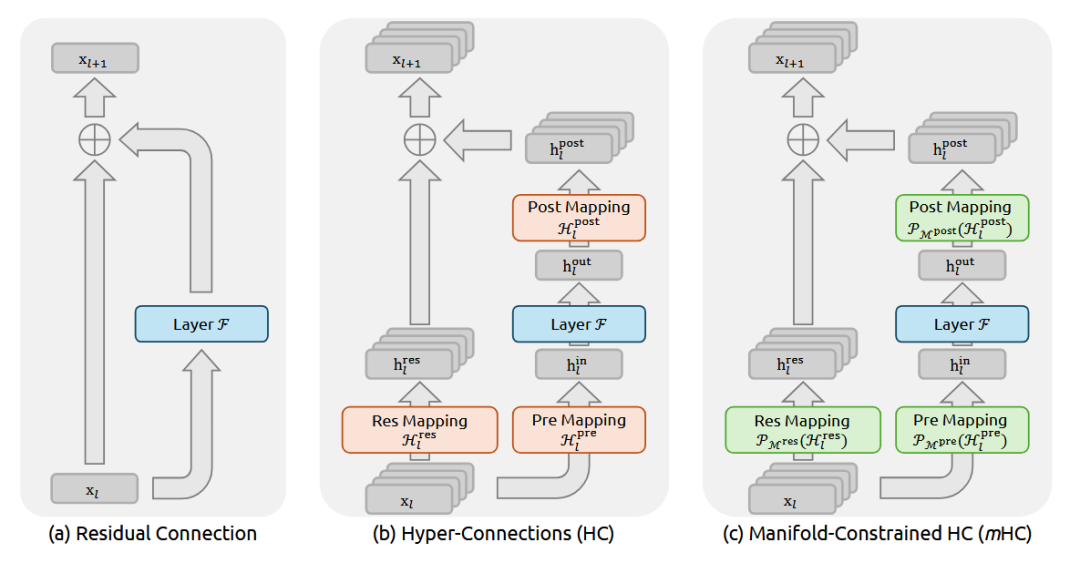

DeepSeek 开年王炸:mHC 架构用流形约束重构 ResNet 残差连接

这回DeepSeek又要对 残差连接(Residual Connection)出手了。

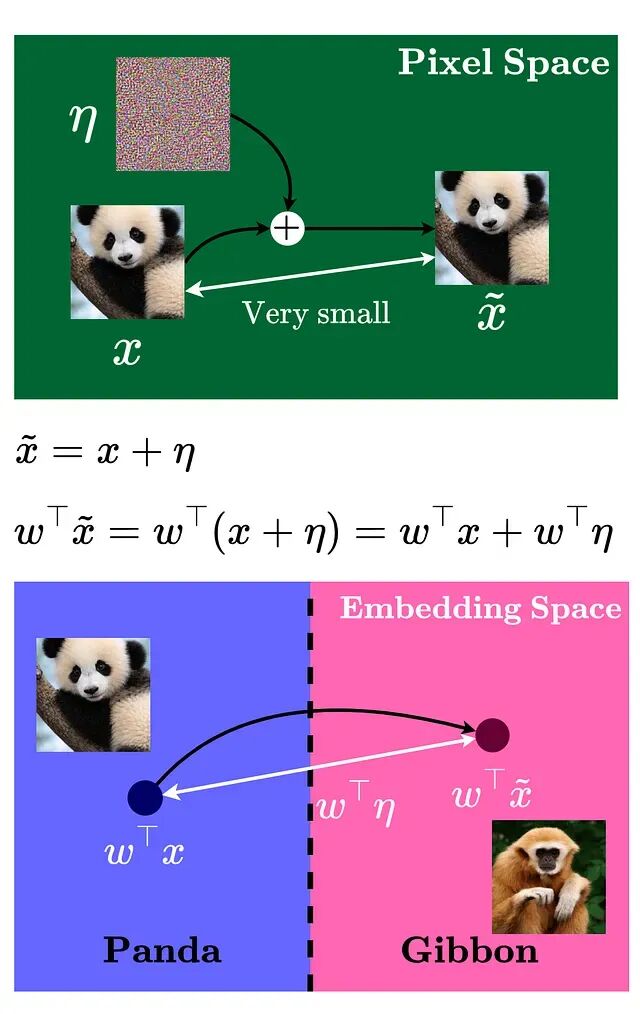

对抗样本攻击详解:如何让AI模型产生错误判断

精心构造的输入样本能让机器学习模型产生错误判断,这些样本与正常数据的差异微小到人眼无法察觉,却能让模型以极高置信度输出错误预测。

向量搜索升级指南:FAISS 到 Qdrant 迁移方案与代码实现

FAISS 在实验阶段确实好用,速度快、上手容易,notebook 里跑起来很顺手。但把它搬到生产环境还是有很多问题

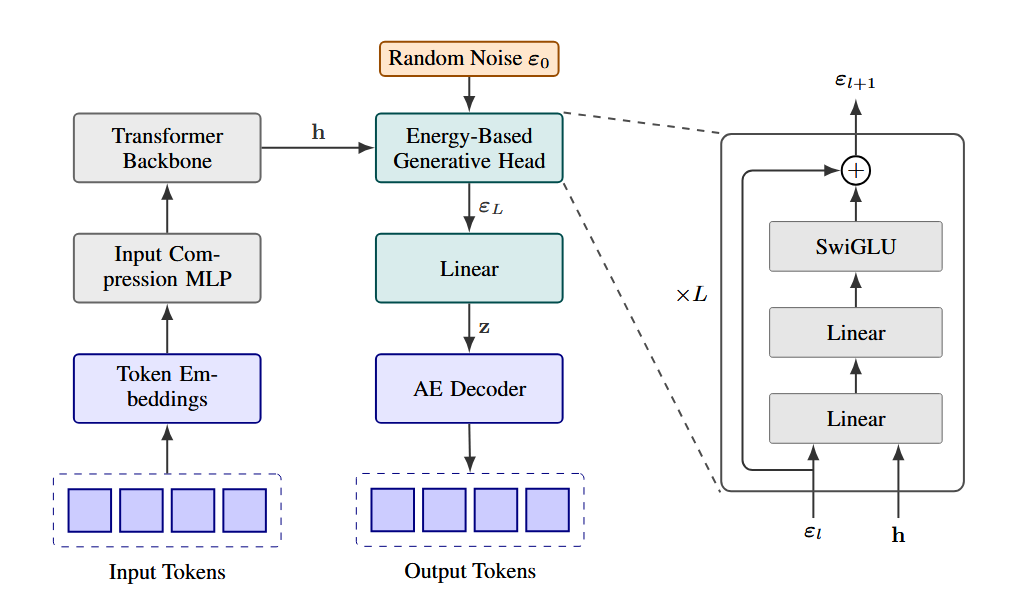

CALM自编码器:用连续向量替代离散token,生成效率提升4倍

近年来语言模型效率优化多聚焦参数规模与注意力机制,却忽视了自回归生成本身的高成本。CALM提出新思路:在token之上构建潜在空间,通过变分自编码器将多个token压缩为一个连续向量,实现“一次前向传播生成多个token”。

dLLM:复用自回归模型权重快速训练扩散语言模型

dLLM是一个开源的Python库,它把扩散语言模型的训练、微调、推理、评估这一整套流程都统一了起来,而且号称任何的自回归LLM都能通过dLLM转成扩散模型

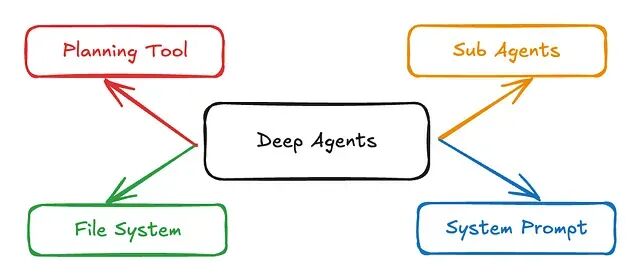

Pydantic-DeepAgents:基于 Pydantic-AI 的轻量级生产级 Agent 框架

有时候严格的类型安全加上一个干净的 Docker 容器,远比一张错综复杂的有向无环图(DAG)要好维护得多。

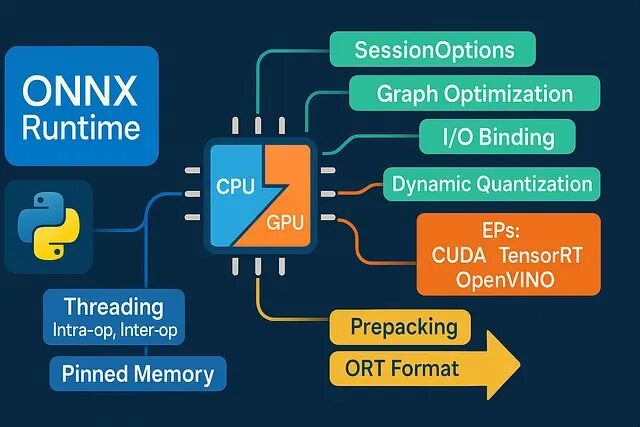

ONNX Runtime Python 推理性能优化:8 个低延迟工程实践

深度学习推理慢?未必是模型问题。本文揭示8大ONNX Runtime工程优化技巧:合理选择执行提供器、精准控制线程、规避内存拷贝、固定Shape分桶、启用图优化、CPU量化加速、预热与微批处理、向量化前后处理。不改模型也能显著提升性能,低延迟落地关键在于细节调优。

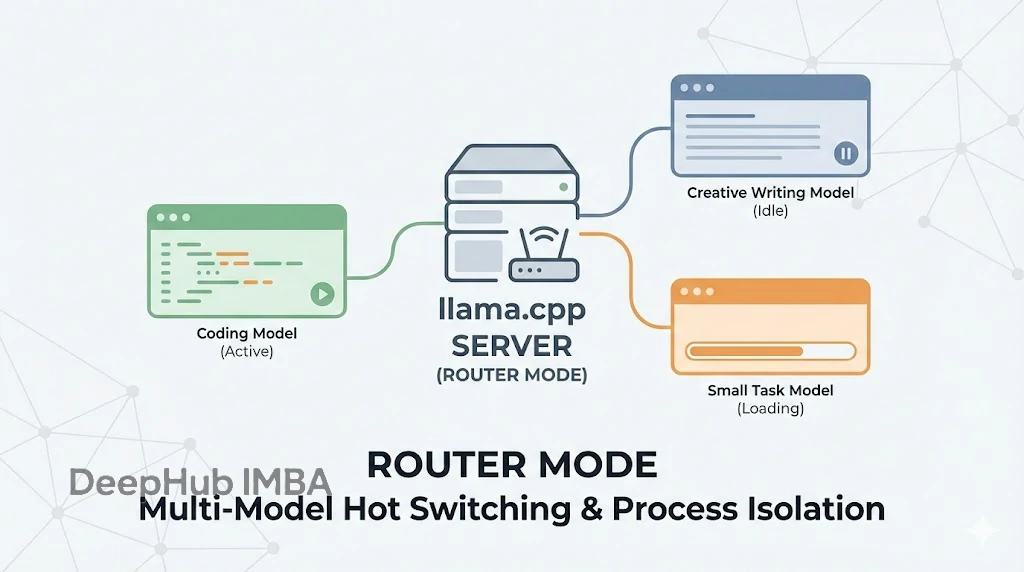

llama.cpp Server 引入路由模式:多模型热切换与进程隔离机制详解

Router mode 看似只是加了个多模型支持,实则是把 llama.cpp 从一个单纯的“推理工具”升级成了一个更成熟的“推理服务框架”。

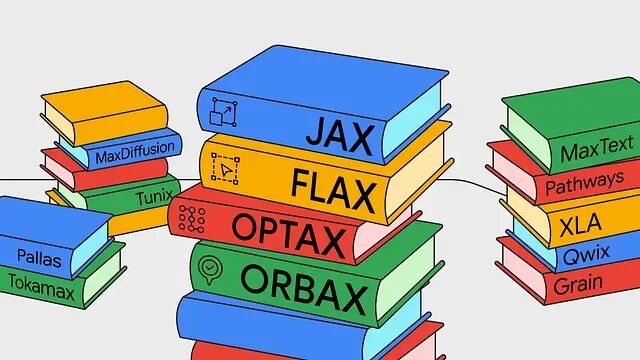

深度解析 Google JAX 全栈:带你上手开发,从零构建神经网络

JAX AI 栈是一套面向超大规模机器学习的端到端开源平台。

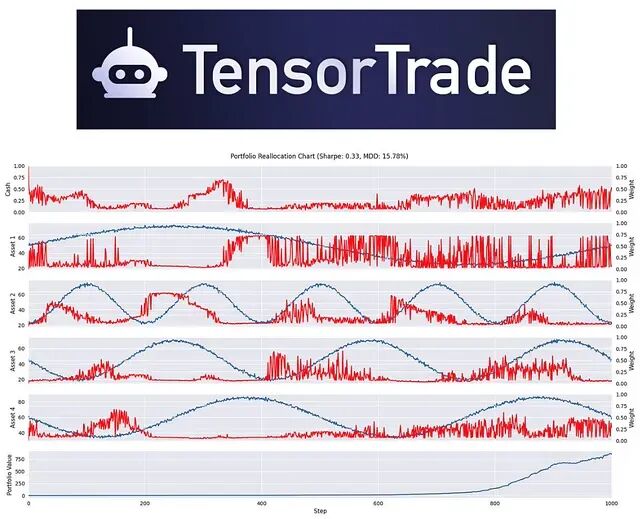

基于强化学习的量化交易框架 TensorTrade

TensorTrade 是一个专注于利用 **强化学习 (Reinforcement Learning, RL)** 构建和训练交易算法的开源 Python 框架。

DeepSeek-R1 与 OpenAI o3 的启示:Test-Time Compute 技术不再迷信参数堆叠

Test-Time Compute(测试时计算),继 Transformer 之后,数据科学领域最重要的一次架构级范式转移。

LMCache:基于KV缓存复用的LLM推理优化方案

LMCache针对TTFT提出了一套KV缓存持久化与复用的方案。项目开源,目前已经和vLLM深度集成。

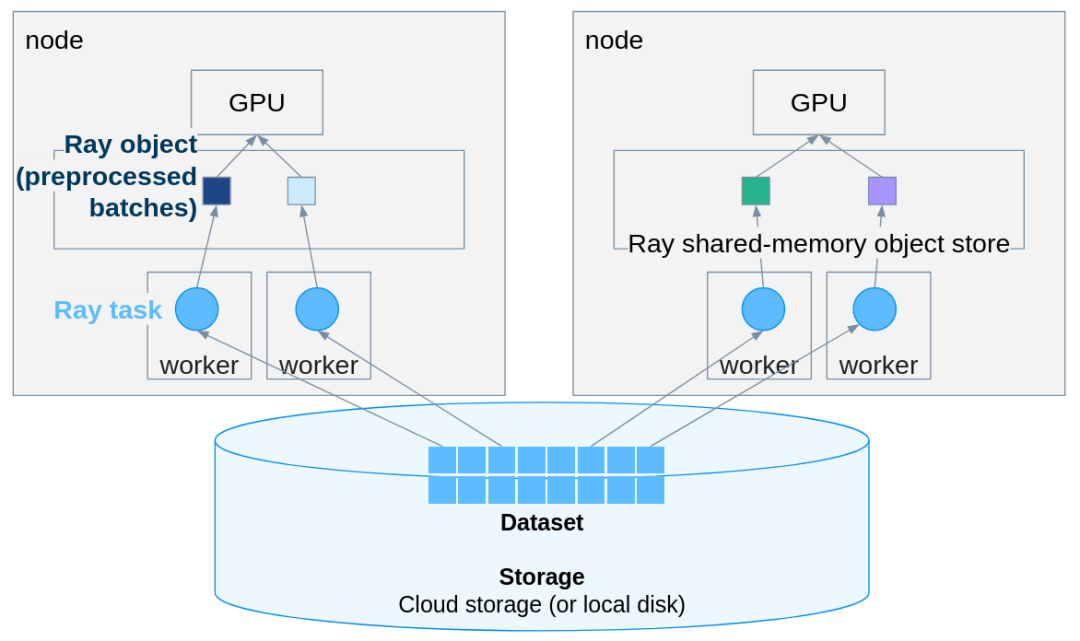

PyTorch推理扩展实战:用Ray Data轻松实现多机多卡并行

Ray Data 在几乎不改动原有 PyTorch 代码的前提下,把单机推理扩展成分布式 pipeline。

JAX核心设计解析:函数式编程让代码更可控

JAX是函数式编程而不是面向对象那套,想明白这点很多设计就都说得通了。

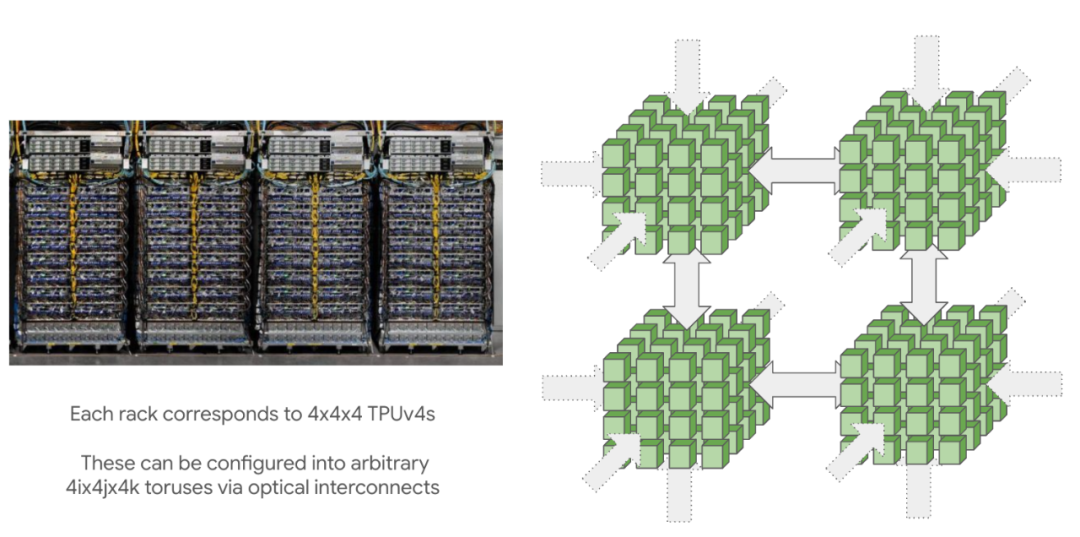

JAX 训练加速指南:8 个让 TPU 满跑的工程实战习惯

TPU 训练的真实效率往往取决于两个核心要素:**Shape 的稳定性**与**算子的融合度**。

JAX 核心特性详解:纯函数、JIT 编译、自动微分等十大必知概念

如果你用过 NumPy 或 PyTorch,但还没接触过 JAX,这篇文章能帮助你快速上手。

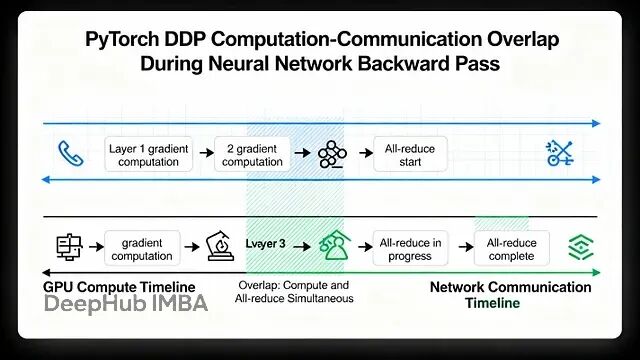

PyTorch 分布式训练底层原理与 DDP 实战指南

本文讲详细探讨Pytorch的数据并行(Data Parallelism)

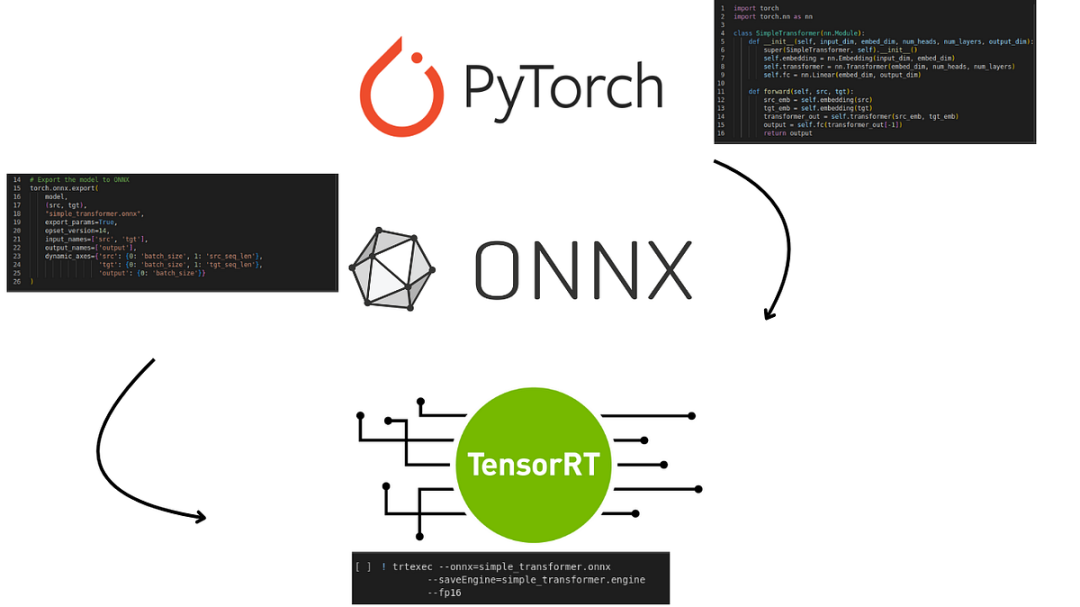

TensorRT 和 ONNX Runtime 推理优化实战:10 个降低延迟的工程技巧

低延迟不靠黑科技就是一堆小优化叠起来:形状固定、减少拷贝、更好的 kernel、graph capture、运行时零意外。每个单拎出来可能只省几毫秒,但加起来用户就能感受到"快"。

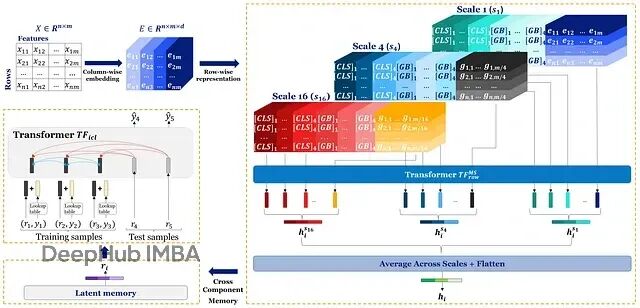

Orion-MSP:深度学习终于在表格数据上超越了XGBoost

Orion-MSP通过多尺度处理捕获不同粒度的特征交互;块稀疏attention把复杂度降到接近线性;Perceiver-style memory实现ICL-safe的双向信息共享。