粒子系统技术在AI去衣应用中的创新探索

粒子系统技术是一种模拟复杂物体运动的计算方法,它通过生成大量微小的粒子并赋予它们特定的属性(如位置、速度、颜色等),来模拟烟雾、火焰、水流等不规则物体的运动效果。而在AI去衣应用中,粒子系统技术主要用于模拟衣物的动态变化和去除过程,确保在去除衣物的同时,能够保留皮肤的质感和细节。粒子系统技术在AI去

人工智能视觉:基于OpenCV的人脸识别技术的深度解析

OpenCV 的全称是 Open Source Computer Vision Library,是一个跨平台的计算机视觉库。OpenCV 是由英特尔公司发起并参与开发,以 BSD 许可证授权发行,可以在商业和研究领域中免费使用。OpenCV 可用于开发实时的图像处理、计算机视觉以及模式识别程序。该程

我希望未来10年,人工智能可以帮我解决这4件小事

生活在一线大城市的我,现在几乎整天被大数据、人工智能、机器学习、智慧生活的词汇环绕立体包围着,让我时刻感觉到,再过10年,我们五一假期真的可以摆脱现在擦肩接踵的旅游盛况了。但我其实要求倒是没这么高,我真心希望人工智能再未来10年,要是能帮我解决了这几件小事就好了。

spring boot3整合spring AI组件

本文介绍了springboot开发后端服务中,AI组件(Spring AI)的整合与使用。坚持看完相信对你有帮助。同时欢迎订阅springboot系列专栏,持续分享spring boot的使用经验。先看官网介绍:翻译:Spring AI 是 AI 工程的应用框架。其目标是将 Spring 生态系统设

【机器学习】 人工智能和机器学习辅助决策在空战中的未来选择

人工智能和机器学习辅助决策在空战中的未来选择

NIVision-Vision Builder AI的应用简单示例

NI vision builder ai 的实例分享

Python赋能AI数据分析开启人工智能新时代

本书分为两大部分:第一部分(第1~7章)为Python数据分析基础篇,主要介绍Python的工作环境、编程基础、Excel数据文件的操作、Pandas数据包的应用等。对于编程菜鸟,这部分内容是必学内容,不仅可以帮助大家快速掌握Python编程的基础知识,还能快速入门数据操作和分析。学完这部分内容,读

AI大模型探索之路-训练篇2:大语言模型预训练基础认知

在人工智能的宏伟蓝图中,大语言模型(LLM)的预训练是构筑智慧之塔的基石。预训练过程通过调整庞大参数空间以吸纳数据中蕴含的知识,为模型赋予从语言理解到文本生成等多样化能力。本文将深入探讨预训练过程中的技术细节、所面临的挑战、通信机制、并行化策略以及如何通过这些技术的融合提升预训练的效率和性能。预训练

AI大模型探索之路-训练篇24:ChatGLM3微调实战-多卡方案微调步骤详解

在现代自然语言处理(NLP)任务中,随着模型规模的扩大和训练数据的增多,单张GPU的显存已经无法满足大模型的训练需求。为了充分利用多张GPU进行并行训练,我们需要了解不同的并行策略。本文将详细介绍ChatGLM3微调实战中的多卡方案及其步骤。这三篇论文共同构成了DeepSpeed项目的理论基础,它们

MambaOut:状态空间模型并不适合图像的分类任务

该论文探讨了Mamba架构(包含状态空间模型SSM)是否有必要用于视觉任务,如图像分类、目标检测和语义分割。通过实验证实了了Mamba在视觉识别任务中的效果,认为其不如传统的卷积和注意力模型。

整合LlamaIndex与LangChain构建高级的查询处理系统

本篇文章将介绍如何将LlamaIndex和LangChain整合使用,创建一个既可扩展又可定制的代理RAG(Retrieval-Augmented Generation)应用程序,利用两种技术的强大功能,开发出能够处理复杂查询并提供精准答案的高效应用程序。

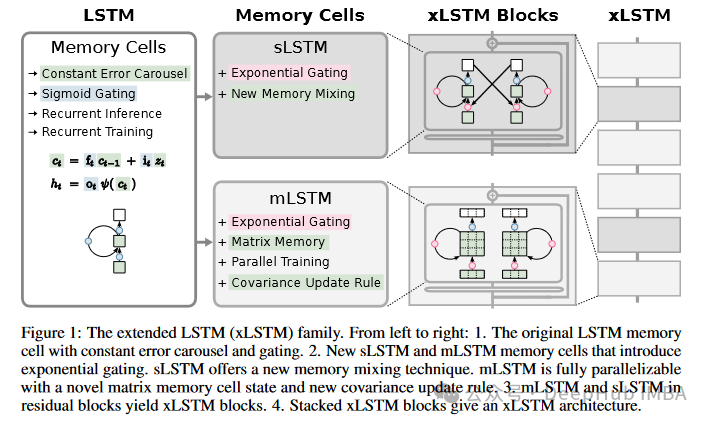

深入解析xLSTM:LSTM架构的演进及PyTorch代码实现详解

xLSTM的新闻大家可能前几天都已经看过了,原作者提出更强的xLSTM,可以将LSTM扩展到数十亿参数规模,我们今天就来将其与原始的lstm进行一个详细的对比,然后再使用Pytorch实现一个简单的xLSTM。

DeepSparse: 通过剪枝和稀疏预训练,在不损失精度的情况下减少70%的模型大小,提升三倍速度

这篇论文提出了一种高稀疏性基础大型语言模型(LLMs)的新方法,通过有效的预训练和部署,实现了模型在保持高准确度的同时,显著提升了处理速度。

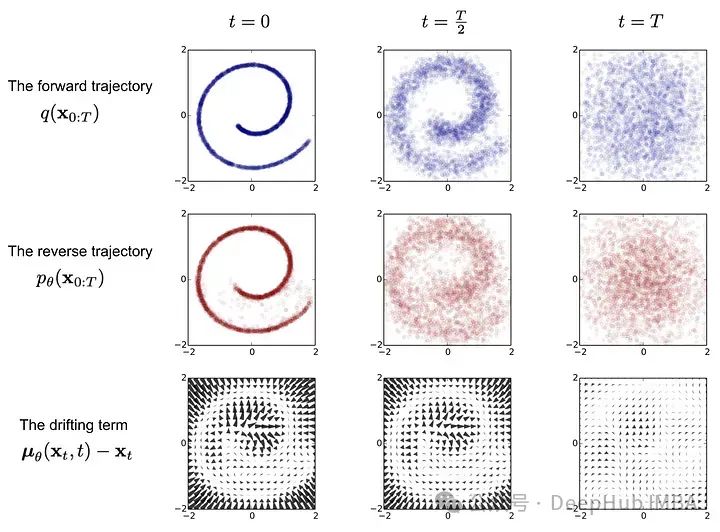

扩散模型的多元化应用:药物发现、文本生成、时间序列预测等

今天我们就来研究一下扩散模型的多元化应用。

图神经网络入门示例:使用PyTorch Geometric 进行节点分类

本文介绍的主要流程是我们训练图神经网络的基本流程,尤其是前期的数据处理和加载,通过扩展本文的基本流程可以应对几乎所有图神经网络问题。

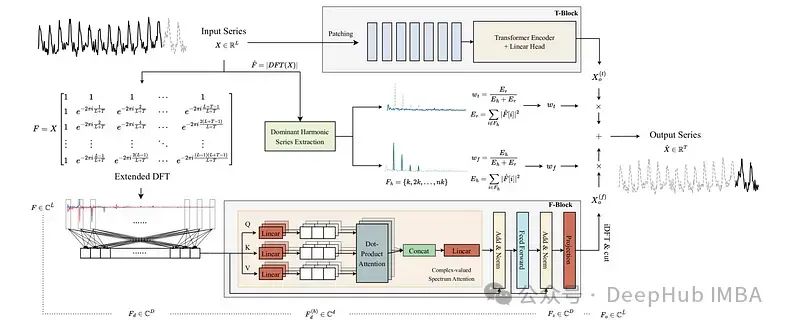

ATFNet:长时间序列预测的自适应时频集成网络

ATFNet是一个深度学习模型,它结合了时间域和频域模块来捕获时间序列数据中的依赖关系。这是4月发布在arxiv上的论文,还包含了源代码。

时间序列预测:探索性数据分析和特征工程的实用指南

我在本文中我们将EDA总结为六个步骤:描述性统计、时间图、季节图、箱形图、时间序列分解、滞后分析。

Transformers 加速的一些常用技巧

我们今天来总结以下一些常用的加速策略

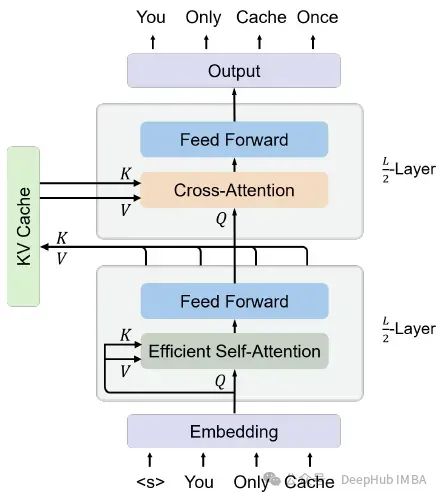

You Only Cache Once:YOCO 基于Decoder-Decoder 的一个新的大语言模型架构

这是微软再5月刚刚发布的一篇论文提出了一种解码器-解码器架构YOCO,因为只缓存一次KV对,所以可以大量的节省内存。

图机器学习入门:基本概念介绍

本篇文章将从基础开始介绍什么是图,我们如何描述和表示它们,以及它们的属性是什么。