GAN能进行股票预测吗?

在过去的研究中,出现了而很多的方式,但这些方式和方法并不是很成功,所以本文将这个领域的研究扩展到GANs。看看GANs这个领域是否能够进行预测。

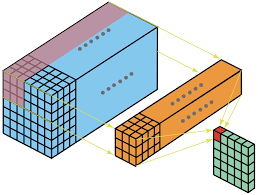

Residual, BottleNeck, Inverted Residual, MBConv的解释和Pytorch实现

上篇ConvNext的文章有小伙伴问BottleNeck,Inverted Residual的区别,所以找了这篇文章,详细的解释一些用到的卷积块,当作趁热打铁吧

使用PyTorch复现ConvNext:从Resnet到ConvNext的完整步骤详解

ConvNext论文提出了一种新的基于卷积的架构,不仅超越了基于 Transformer 的模型(如 Swin),而且可以随着数据量的增加而扩展!今天我们使用Pytorch来对其进行复现。

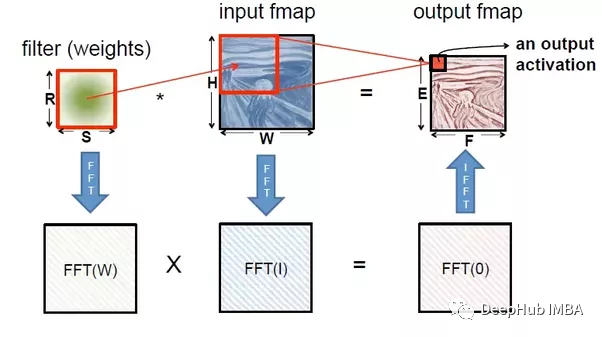

神经网络与傅立叶变换有关系吗?

傅里叶变换可以视为一种有助于逼近其他函数的函数,神经网络被也认为是一种函数逼近技术或通用函数逼近技术。 本文将讨论傅里叶变换,以及如何将其用于深度学习领域。

2022年关于损失函数的5篇最新论文推荐

2022年最新的损失函数论文总结

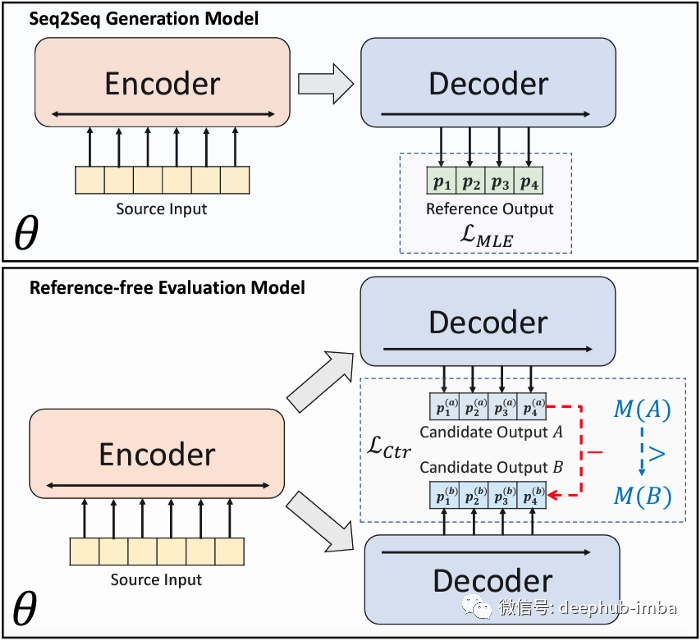

BRIO:抽象文本摘要任务新的SOTA模型

在 SimCLS [2]论文发布后不久,作者又发布了抽象文本摘要任务的SOTA结果 [1]。BRIO在上述论文的基础上结合了对比学习范式。

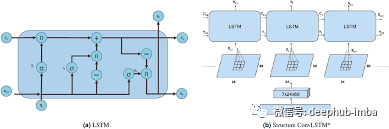

循环神经网络(RNN)

循环神经网络(RNN)文章目录循环神经网络(RNN)注意!!!!!!!RNN模型的作用为什么要使用RNN而不是用MLP?RNN输入与输出RNN模型简单RNN模型LSTM(Long Short-Term Memory)长短期记忆模型GRU(Gated Recurrent Units)参考视频注意!!!

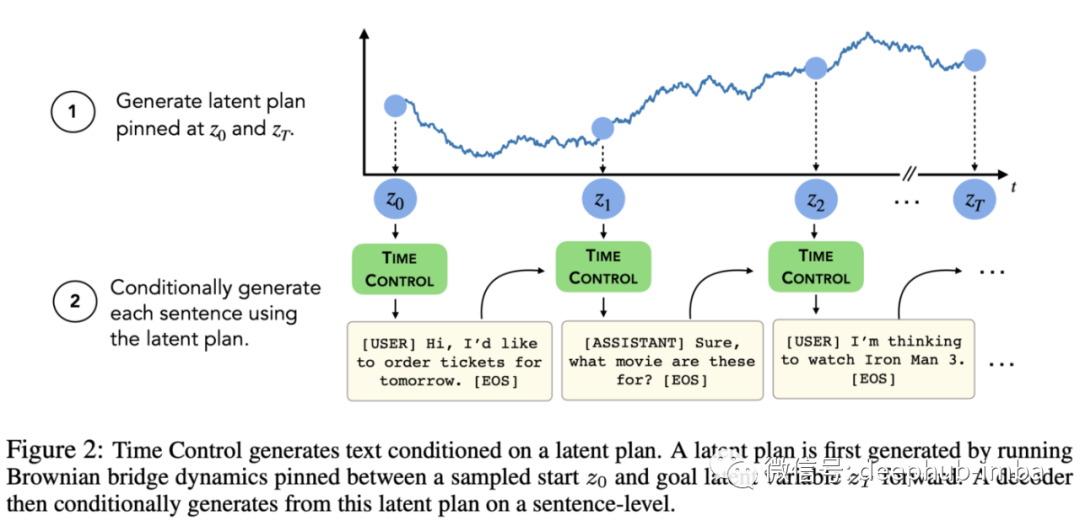

ICLR 2022的10篇论文推荐

一千多篇论文,19个研讨会和8次邀请演讲。 所以我整理了10篇论文作为推荐,希望对你有帮助

YOLOv5-6.0 源码解析 —— 卷积神经单元

YOLOv5 源码中,模型是依靠 yaml 文件建立的。而 yaml 文件中涉及到的卷积神经网络单元都是在 models 文件夹中的 common.py 声明的,所以自行设计网络结构之前有必要详解这个文件。这个文件很细节,就算不学 YOLOv5 也建议 copy 收藏通用参数c1 c2 c_

深度学习中的归一化技术全面总结

归一化是深度学习中的一个基本概念。它加快了计算速度并稳定了训练。多年来发展了许多不同的技术。本篇文章整理了目前与它相关的方法,希望对你有所帮助

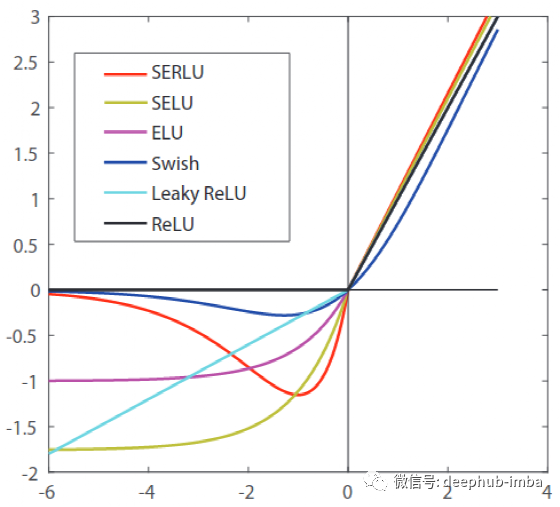

42个激活函数的全面总结

这个列表将包含 42 个激活函数,这里面肯定有没有见过的

在预测中使用LSTM架构的最新5篇论文推荐

本文总结了近半年来关于LSTM的5篇论文,推荐阅读

基于pytorch平台实现对MNIST数据集的分类分析(前馈神经网络、softmax)基础版

基于pytorch平台实现对MNIST数据集的分类分析(前馈神经网络、softmax)基础版

从零到一实现神经网络(六):误差反向传播算法更新网络权重

误差反向传播算法原理,误差反向传播更新权重参数,三层神经网络实现

5分钟NLP:Text-To-Text Transfer Transformer (T5)统一的文本到文本任务模型

本文将解释如下术语:T5,C4,Unified Text-to-Text Tasks

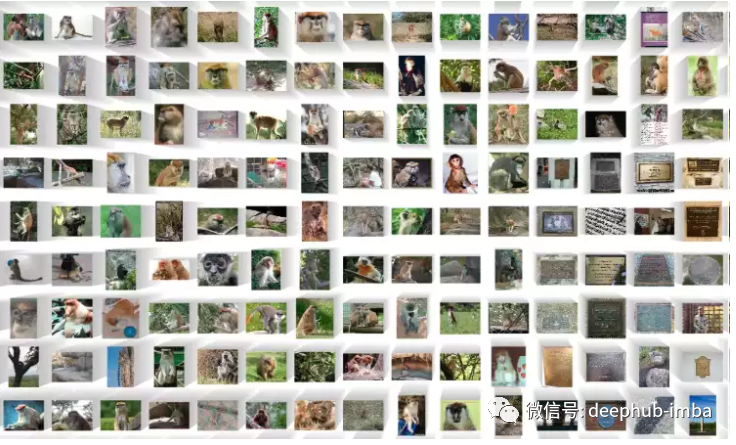

图像预训练模型的起源解说和使用示例

这篇文章简要介绍了图像预训练模型过去的演变,并总结了现在的一些热门话题。

Keras深度学习实战(2)——使用Keras构建神经网络

Keras 是用 Python 编写的高级神经网络 API,它的核心思想在于实现快速实验,该库提供了很多实用工具,可以简化构建复杂神经网络的过程。在本节中,我们将使用 Keras 库构建神经网络,感受 Keras 快速模型构建的特性。

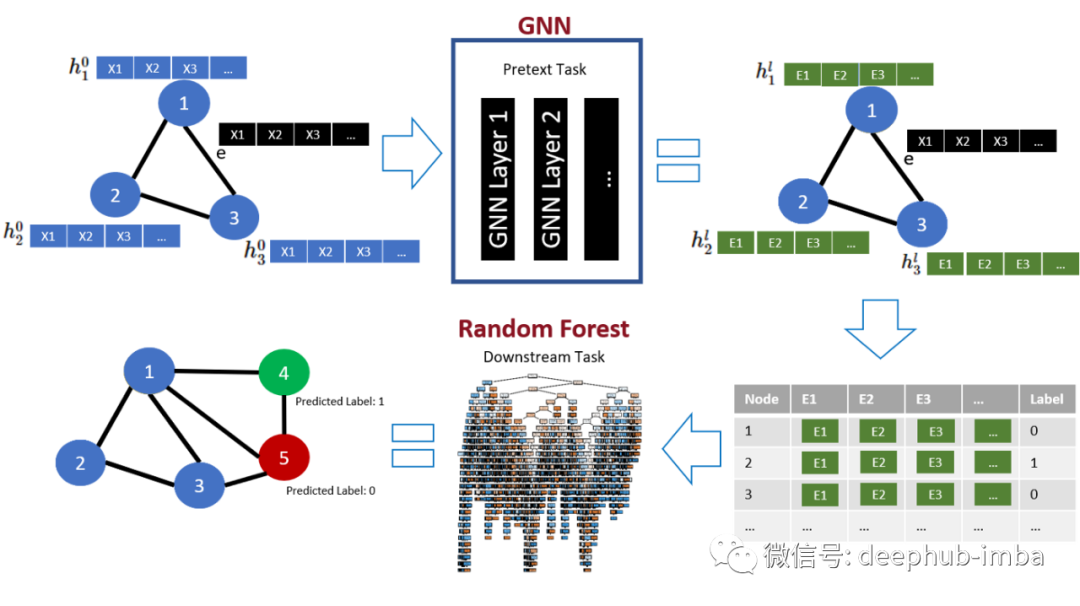

改善图形神经网络,提升GNN性能的三个技巧

本文总结了一些技巧来提高 GNN 模型的性能。

学习笔记:深度学习(4)——卷积神经网络(CNN)PyTorch实践篇

小白PyTorch超快上手,采用CNN做了一个手写数字识别,一个MINST手写数字预测,以及尝试了Kaggle的Spaceship Titanic案例。