1、Hybridised Loss Functions for Improved Neural Network Generalisation

Matthew C. Dickson, Anna S. Bosman, Katherine M. Malan

https://arxiv.org/pdf/2204.12244.pdf

损失函数在人工神经网络 (ANN) 的训练中发挥着重要作用,并且会影响 ANN 模型的泛化能力以及其他属性。已经有研究表明交叉熵和平方和误差损失函数会导致不同的训练结果,并表现出相互补充的不同属性。之前有人提出,熵和平方和误差损失函数的混合可以结合这两个函数的优点,同时限制它们的缺点。本论文研究了这种混合损失函数的有效性,结果表明,两种损失函数的混合提高了神经网络考虑问题上的泛化能力。以平方和误差损失函数开始训练然后切换到交叉熵损失函数的混合损失函数可以表现出最佳的性能,或者与最佳损失函数没有显着差异。这项研究表明,通过切换到交叉熵损失函数,可以进一步利用平方和误差损失函数发现的最小值。因此可以得出结论,两种损失函数的混合可以提高神经网络的性能。

2、Bias-Variance Decompositions for Margin Losses

Danny Wood, Tingting Mu, Gavin Brown

https://arxiv.org/pdf/2204.12155.pdf

论文引入了一种新颖的偏差方差分解,以及Margin Losses等新的损失函数。研究表明对于所有convex margin losses,预期风险分解为一个“中心”模型的风险和一个关于训练数据变化的功能边际量化变化的术语。这些分解为从我们理解模型过拟合/欠拟合提供了一种诊断工具。

3、The Multiscale Structure of Neural Network Loss Functions: The Effect on Optimization and Origin

Chao Ma, Lei Wu, Lexing Ying

https://arxiv.org/pdf/2204.11326.pdf

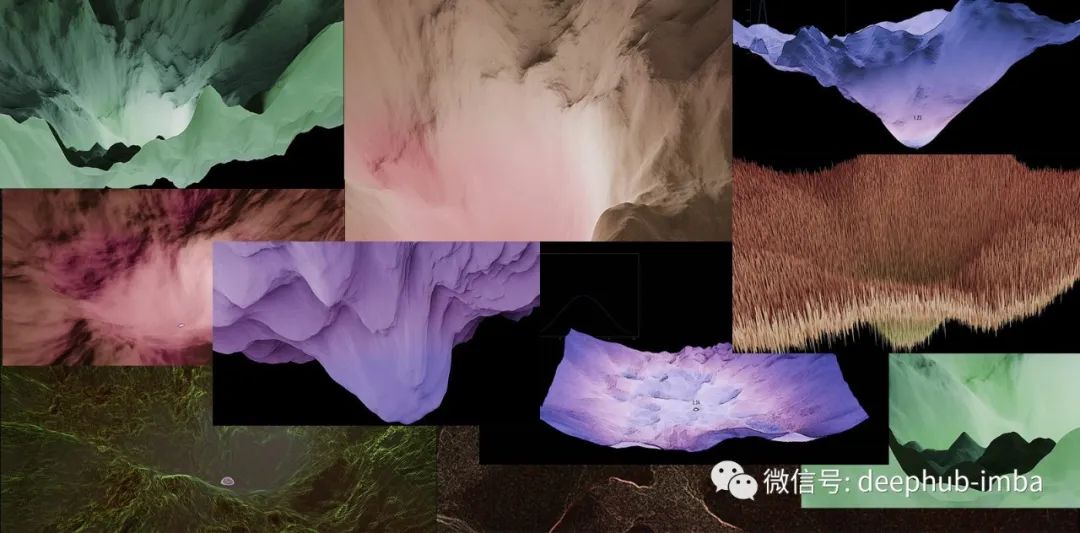

局部二次逼近已被广泛用于研究神经网络损失函数在最小值附近的优化。但是它通常在最小值的一个非常小的邻域内成立,并且无法解释在优化过程中观察到的许多现象。在这篇论文中,研究了神经网络损失函数的结构及其对超出良好二次逼近范围的区域的优化的影响。在数值上观察神经网络损失函数具有多尺度结构,表现为两种方式:(1)在最小值邻域中,损失混合了尺度的连续,并以次二次的方式增长;(2)在更大的区域中,损失清楚地显示了几个单独的比例尺度。使用次二次增长,我们能够解释梯度下降(GD)方法观察到的稳定边缘现象[4]。使用单独的尺度,可以通过简单的例子来解释学习率衰减的工作机制。最后,论文研究了多尺度结构的起源,并提出训练数据的不均匀性是其原因之一。通过构建一个两层神经网络问题,证明了不同大小的训练数据会产生不同尺度的损失函数,产生次二次增长或多个单独的尺度

4、Spherical Rotation Dimension Reduction with Geometric Loss Functions(arXiv)

Hengrui Luo, Didong Li

https://arxiv.org/pdf/2204.10975

现代的数据集一般都会包含高维空间和非平凡的几何形状。在数据分析中减少维数同时保留数据集的几何结构将很有帮助。受此观点的启发,论文提出了一种通过结合几何信息的通用降维方法。论文提出的的球面旋转分量分析 (SRCA) 是一种降维方法,它使用球体或椭球体来逼近低维流形。该方法不仅在理论和算法方面对球面分量分析(SPCA)方法进行了推广,而且对论文提出方法进行了全面的比较,既可以作为具有理论保证的优化问题,也可以作为数据的结构保持低秩表示。与最先进的竞争对手相关的结果显示,在使用更少的组件和更好的结构保留准确逼近子空间的能力方面取得了相当大的进步。此外论文指出,这种方法是在降维任务中使用几何诱导损失函数的宏大思想的具体体现。

5、Improving Few-Shot Part Segmentation using Coarse Supervision

Indrila Saha、Jizhu Cheng、Suvransu Maji

https://arxiv.org/pdf/2204.05393.pdf

获取详细标注的成本是训练用于语义分割模型一个重要瓶颈。论文提出了一个可以利用粗糙的标签框架,如背景掩码和关键点位置,可以用于一些类别以改善部分分割模型的性能。但是,这些标注是为不同的任务收集的,可能具有不同的标签风格,有时不能很容易地映射到目标的标签。因此,论文建议共同学习标签部分分割模型之间的依赖关系,这样可以允许模型利用来自不同标签的进行相互的监督。论文在加州理工大学-加州大学圣地亚哥分校的鸟类和OID Aircraft数据集上制定了一个基准。并且证明了改方法优于基于多任务学习、半监督学习和依赖于人工设计的利用稀疏监督的损失函数等方法的基线

作者:moondeep