医学图像分析,多任务学习,图像分类,图像分割,U-Net,后处理

该论文是18年发布的,提出了一种基于Deep U-Net的多任务学习框架,用于GE-MRI左心房分割,该框架同时执行心房分割和消融前后分类。虽然论文已经很老了,但是改论文提出的多任务和后处理方法到现在还是可以参考的。

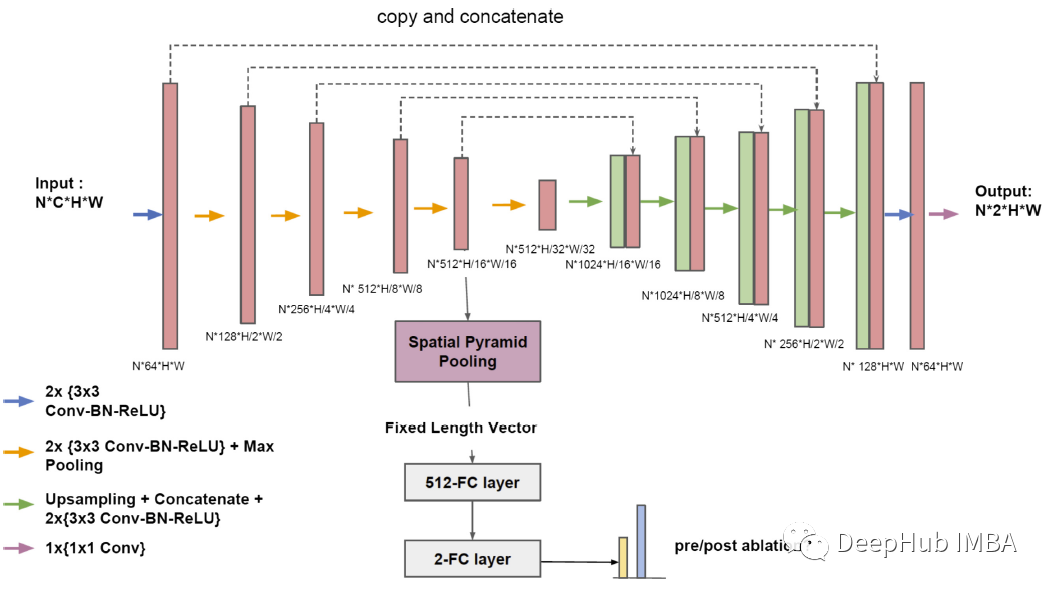

多任务U-Net

图像分割

多任务深度U-Net是在二维U-Net基础上发展而来的。数据集的图像在x-y平面上的最大尺寸为640 × 640,通过增加池化层来增加U-Net的接收域。它由5个下采样块和5个上采样块组成,使用BN和ReLU。通过聚合从下采样路径和上采样路径学到的不同尺度的粗和细特征,网络应比没有聚合操作的网络获得更好的分割性能。

分类

分类任务是利用从下采样路径学习到的图像特征来执行。通过提取第4个池化层之后的特征,从不同大小和尺度的输入图像中学习到固定长度的特征向量,应用了SPPNet中的空间金字塔技术,然后通过2个全连接的层处理向量,使用softmax计算每个图像的类概率(消融前/消融后)。在FC层上使用0.5的Dropout。

损失函数

多任务网络的损失函数L:

式中LS为分割损失,LC为分类损失,λ=1。对于分割部分,采用了像素级交叉熵损失。

分类部分采用sigmoid交叉熵。:分类损失作为正则化的作用,使网络能够学习在两个任务中都能很好概括的高级表示。

后处理

在推理过程中,将从三维图像中提取的轴向切片逐片输入网络,通过逐片拼接这些分割结果,每个患者的粗略3D掩膜就产生了。为了细化这些掩模的边界进行了三维形态扩张和侵蚀,每个体积保留了最大的连接分量。

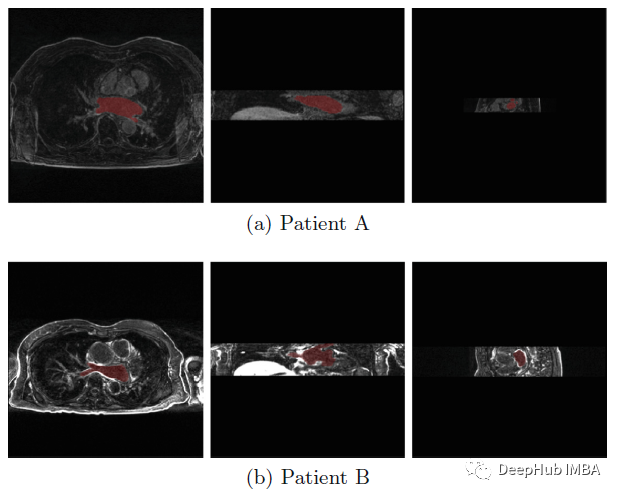

数据

数据集

论文使用2018年心房分割挑战数据集,包含100个3D的ge - mri图像的训练集,以及相应的LA手动分割掩膜和消融前/后标签,用于训练和验证。还有另外一组54张没有标签的图片供测试。对于模型训练和评价,将80:20训练集随机分割。数据集中有两种大小的图像:576×576和640×640。如上图所示,在图像大小和图像对比度上有很大的差异。

预处理和数据增广

图像的强度归一化为零均值和单位方差。随机水平/垂直翻转,概率为 50%。范围从 -10 到 +10 度进行随机旋转。在原始图像大小的 10% 范围内沿 X 和 Y 轴随机移动。缩放系数介于 0.7 和 1.3 之间。随机伽马校正作为对比度增强的一种方式:

其中F(x, y)是图像中每个像素的原始值,G(x, y)是每个像素的变换值。对于每个图像,γ从(0.8,2.0)的范围内随机化。在对比度增强的情况下,该网络不需要图像对比度增强作为预处理。

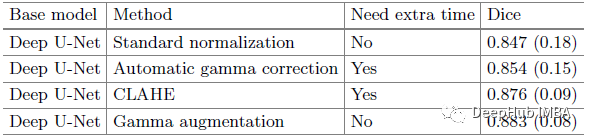

与AGC和CLAHE等其他预处理图像对比度增强相比,gamma增强代具有更高的Dice得分。

采用多尺度裁剪来增加数据的多样性,使网络能够分析不同背景下的图像。裁剪尺寸包括256×256, 384×384, 480×480, 512×512, 576×576, 640×640。首先用裁剪图像训练网络,然后逐渐增加图像的大小。网络学会了从简单的场景到困难的场景进行分割。

结果

定量结果

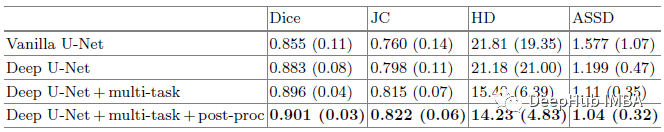

对于不同的网络和方法,基于不同测量值的分割精度结果如下

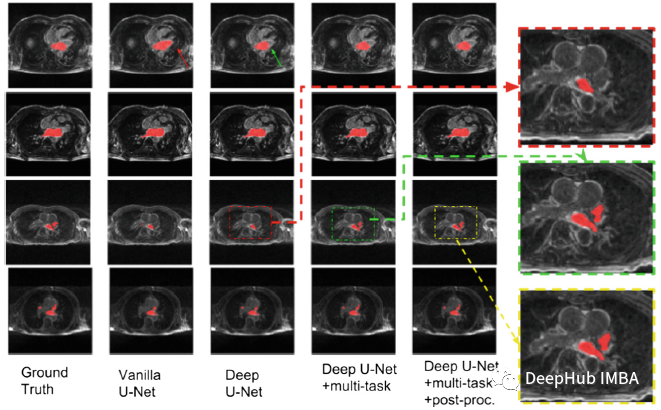

随着网络深度的增加,分割性能得到了显著提高,尤其是在二尖瓣平面上。通过多任务Deep U-Net和进行后期处理,得到的Dice分数为0.901。

这个多任务U-Net算法比其他两种算法具有更强的鲁棒性,通过与分割和相关的消融前后分类共享特征,网络被迫学习更好的表示,以获得更好的分割结果。

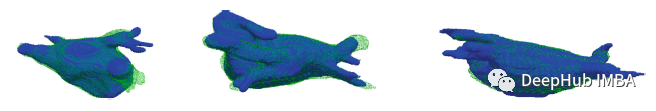

这是验证集中的三个样本的三维可视化。蓝色对象是真值,绿色对象是预测分割

该模型在不同主题的三维分割结果与真值之间具有较高的重叠率。然而,在肺静脉周围可以观察到一种显著的失效模式。一个可能的原因可能是肺静脉的数量和长度因人而异,这使得网络很难从有限的病例中学习。

训练时间

在一台Nvidia Titan Xp GPU上,总的处理过程平均大约需要10秒。

Atrial Segmentation Challenge 2018

论文作者使用了一种称为Boostrap aggreging (Bagging)的集成方法。在同一模型训练5次,每次随机子集,然后平均类概率。在主办方给出的54个测试用例中,DICE平均得分从0.9197提高到0.9206。

论文地址:

[2018 STACOM] [Multi-Task Deep U-Net] :https://arxiv.org/abs/1810.13205

作者:Sik-Ho Tsang