用自己网络添加注意力机制后画出热力图

用自己网络添加注意力机制后画出热力图

【人工智能】期末复习 重点知识点总结

人工智能期末复习考点

SAM 模型真的是强悍到可以“分割一切”了吗?

关注公众号,发现CV技术之美上周,Meta AI发布了 Segment Anything Model(SAM)—— 第一个图像分割基础模型。很多计算机视觉从业者惊呼“这下CV真的不存在了,快跑!”。但是SAM 模型真的是强悍到可以“分割一切”了吗?它在哪些场景或任务中还不能较好地驾驭呢?研究社区已经

chatGPT的API一次多少钱-怎么用chatGPT解决问题

使用ChatGPT解决问题一般需要以下几个步骤:确认问题类型:在使用ChatGPT解决问题前,需要明确问题的类型,如文本生成、文本分类、机器翻译、情感分析等。准备数据和模型:ChatGPT需要数据和模型来进行模型训练或模型 fine-tuning。在准备数据时,需要收集相关的数据,并对其进行清洗和处

【tph-yolov5】论文简读

论文名称: TPH-YOLOv5: Improved YOLOv5 Based on Transformer Prediction Head for Object Detection on Drone-captured Scenarios论文下载地址:https://arxiv.org/abs/21

深度学习训练文件批量制作——arcgis pro软件(傻瓜式操作)

想要批量制作深度学习训练文件(特别是遥感文件)在网上找了很久的代码或者方法,发现不怎么适用,或者是说太过复杂了(电脑环境、包的版本等一系列问题,博主的环境可以用,到我电脑上我就一堆版本问题,又不好去改代码),于是找了很久发现arcgis pro这个软件可以满足我的要求,批量且简单。

yolov5-7.0训练自己的VOC数据集

这个笔记可能只适用于7.0版本的,写这个笔记主要是给工作室伙伴参考的,大佬请绕行有错误之处欢迎指出。

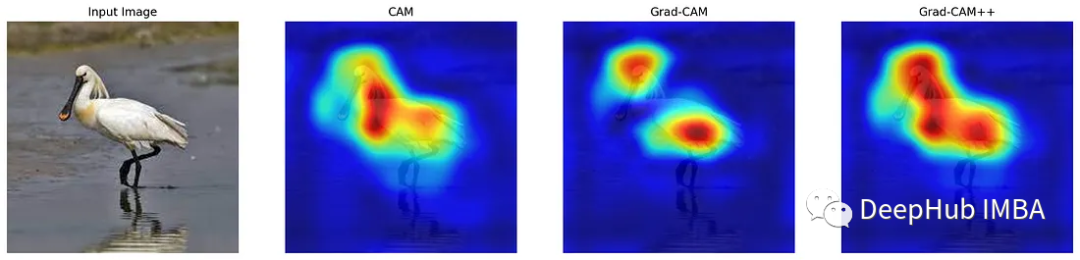

CAM, Grad-CAM, Grad-CAM++可视化CNN方式的代码实现和对比

理解CNN的方法主要有类激活图(Class Activation Maps, CAM)、梯度加权类激活图(Gradient Weighted Class Activation Mapping, Grad-CAM)和优化的 Grad-CAM( Grad-CAM++)。

【代码复现】5秒训练NeRF!英伟达instan-ngp在windows成功复现

主要介绍了在WINDOWS10下运行instant-ngp的方法,并且介绍了自定义数据集创建和运行的方法。

GPU版本的pytorch安装(显卡为3060ti,如何选择对应的cuda版本)

显卡为3060ti g6x,操作系统win10。

yolov8onnx的处理过程

此外,它还存储数据集的变换和大小。n是框的数量,然后对框进行排序(降序),选超参数中设置的max_nms个框,默认为300,最后x仍然是一个(48*6)的tensor,然后对着48个框进行对应类别的conf计算,max=wh表示加入框的大小时对score的影响,最后返回的c是一个(48*1)在xyw

【Call for papers】ICCV-2023(CCF-A/人工智能/2023年3月8日截稿)

ICCV is the premier international computer vision event comprising the main conference and several co-located workshops and tutorials.

torch.gather()使用解析

torch.gather使用解析

【阅读论文】基于VAE-LSTM混合模型的时间序列异常检测

在这项工作中,我们提出了一种VAE-LSTM混合模型,作为一种无监督的时间序列异常检测方法。我们的模型既利用VAE模块在短窗口上形成稳健的局部特征,又利用LSTM模块在从VAE模块推断的特征之上估计序列中的长期相关性。因此,我们的检测算法能够识别跨越多个时间尺度的异常。我们证明了我们的检测算法在五个

RuntimeError: Trying to resize storage that is not resizable

RuntimeError: Trying to resize storage that is not resizable

深入浅出Pytorch函数——torch.full

torch.full(size, fill_value, *, out=None, dtype=None, layout=torch.strided, device=None, requires_grad=False)

QQ plot 的解读

Q-Q plot的解读分位数-分位数图是通过比较两个概率分布的分位数对这两个概率分布进行比较的概率图方法。

深入浅出PaddlePaddle函数——paddle.ones

paddle.ones

深度学习-LeNet(第一个卷积神经网络)

LeNet模型是在1998年提出的一种图像分类模型,应用于支票或邮件编码上的手写数字的识别,也被认为是最早的卷积神经网络(CNN),为后续CNN的发展奠定了基础,作者LeCun Y也被誉为卷积神经网络之父。

YOLOv5算法详解

YOLOv5输入端、Backbone、Neck以及输出端的算法内容和主要改进