AI的IDE:Cursor配置虚拟python环境(conda)

Cursor是一个AI的IDE,是从VSCode源代码中fork出来的,专注于和AI一起Coding而生。https://www.cursor.com/是官方地址。最近开始逐渐的试用Cursor,之前一直是VSCode的重度用户,python技术栈,因此Anaconda使用也很频繁。试用中发现Cur

沉浸式体验Stability AI文生图、图生图、图片PS功能(中篇)

Amazon Bedrock 是一项完全托管的服务,通过统一的 API 提供来自 AI21 Labs、Anthropic、Cohere、Meta、Mistral AI、Stability AI 和 Amazon 等领先 AI 公司的高性能基础模型(FMs),同时提供广泛的功能,让开发者能够在确保安全

Linux环境下部署百度百川AI大模型-基于ModelScope

魔塔社区部署百川大模型

多模态大模型中的幻觉问题及其解决方案

人工智能咨询培训老师叶梓 转载标明出处多模态大模型在实际应用中面临着一个普遍的挑战——幻觉问题(hallucination),主要表现为模型在接收到用户提供的图像和提示时,可能会产生与图像内容不符的描述,例如错误地识别颜色、数量或位置等。这种误判可能对实际应用造成严重影响,如在自动驾驶场景中,错误的

长短期记忆网络(LSTM)预测模型及其Python和MATLAB实现

# LSTM预测模型背景长短期记忆网络(Long Short-Term Memory,LSTM)是一种特殊的递归神经网络(RNN),于1997年首次由Sepp Hochreiter和Jürgen Schmidhuber提出。LSTM主要用于处理和预测序列数据中的时间依赖关系,能够有效地解决传统RNN

《RMT: Retentive Networks Meet Vision Transformers》CVPR2024

这篇论文探讨了将Retentive Network(RetNet)的概念引入到计算机视觉领域,并与Vision Transformer结合,提出了一种新的模型RMT(Retentive Networks Meet Vision Transformers)。RetNet最初在自然语言处理(NLP)领域

【人工智能】AI盛行时代,程序员如何保持核心竞争力?

您是希望在不断发展的技术世界中保持领先地位的开发人员吗?随着人工智能 (AI) 继续彻底改变行业,适应并跟上最新趋势至关重要。在本文中,我们将探讨在 AI 时代作为开发人员保持领先地位所需的策略和技能。

关于自己部署AI大模型踩的坑(一)——硬件篇

如果不在意耗电的情况下(个人跑满的话,功率大概在250W-300W之间),选取退役服务器还是性价比非常高的。其他方面比如CPU,内存,硬盘位置方面,个人觉得应该不存在太大的限制空间,但GPU的可扩展要尤其注意。比如我选择了一张24G的GPU,可能一张就可以用了。但如果一张GPU算力不够,或者使用人数

超有性价比深度学习卡特斯拉 P100,16G大显存,Stable Diffusion AI 绘画利器

当然,在购买和使用之前,建议充分了解其特点和自身的需求,以确保能够充分发挥其优势,为你的创作之旅增添助力。因此,在选择显卡时,除了考虑当前的需求和性价比,也可以关注行业动态,以便在未来有更好的选择。在 AI 绘画领域,显卡的性能直接影响着创作的效率和质量。不过,需要注意的是,虽然其出图效率尚可,但与

AI:253-如何将MobileNetV1集成到YOLOv8中以实现轻量化 | Backbone替换与性能分析

高效的检测速度:能够实时处理高分辨率图像。强大的检测精度:在各种数据集上表现出色。可扩展性:支持多种模型变体,以满足不同需求。MobileNetV1是一种轻量级的卷积神经网络,设计用于在计算资源有限的设备上运行。深度可分离卷积:将标准卷积分解为逐通道卷积和逐点卷积,显著减少计算量。轻量化设计:减少参

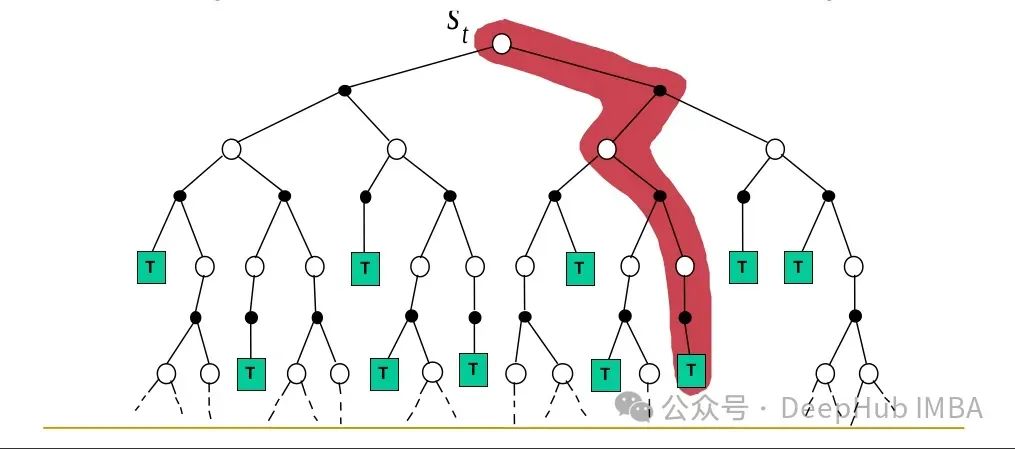

Monte Carlo方法解决强化学习问题

本文继续深入探讨蒙特卡罗 (MC)方法。这些方法的特点是能够仅从经验中学习,不需要任何环境模型,这与动态规划(DP)方法形成对比。

使用AI写WebSocket知识是一种怎么样的体验?

包懵逼的,这些对于没学过的人毫无意义,不用记啦,当做笑话随便看看,老老实实去学websocket基础知识吧,学完再去动手做比啥都强。

Datawhale AI夏令营——siRNA药物药效预测学习笔记

如处理生物问题,首先要分清当前是一个分类、回归或者生成问题,然后确定模型选择,接着考虑如何把数据处理到模型中,再从处理数据的过程中结合生物学知识构造特征,最后再用模型训练这些特征和预测结果,不断优化得到最优结果。

AI恶搞《黑神话:悟空》爆火!

AI恶搞《黑神话:悟空》爆火~

人工智能数据基础之线性代数入门-学习篇

标量是只有大小没有方向的量。在数学中,它通常是一个实数或复数。通俗理解:想象你有5个苹果。这个数字"5"就是一个标量。它只告诉你有多少苹果,但不告诉你这些苹果放在哪里。

AI模型应根据应用场景选择全能型或者专精型

AI模型的发展方向,在追求全能与专精之间并非简单的二选一,都取决于其应用场景、设计目标以及技术可行性等多个因素。这两种策略各有优势和局限性。综上所述,AI模型的发展策略应根据具体情况进行权衡和选择,既可以考虑追求专精以提高特定任务的性能,也可以考虑追求全能以提高模型的通用性和适应性。

AI模型:追求全能还是专精?

从技术发展的角度来看,全能型AI和专精型AI并非相互排斥的对立面,而是不同阶段、不同需求下的产物。首先,由于其处理多种任务的需求,全能型AI在单一任务上的精度和效率可能不如专精型AI。此外,为了保持其广泛的适应性,全能型AI往往需要消耗更多的计算资源和存储空间,这增加了其在实际应用中的成本和难度。全

【Cuda Runtime】dim3线程块与网格尺寸与核函数几种调用的方式

CUDA(Compute Unified Device Architecture)是NVIDIA开发的一种并行计算架构,使得开发人员可以利用GPU进行通用计算。为了有效地利用GPU的并行处理能力,CUDA引入了网格(Grid)和线程块(Block)的概念。这些概念帮助开发人员将复杂的计算任务分解成多

我的开源项目-AI自生成系统巡检报告项目简介

在介绍AutoGenInspection架构前,我想先简要提及基于规则的系统架构(Rule-Based System Architecture)。在软考系统架构师的学习内容中,包含有基于规则的系统架构的学习,于是我也简单对此架构风格拓展学习了下。基于规则的系统架构是一种以规则集为核心,通过规则引擎来

用 AI 来检测 AI 内容,靠谱吗?无限套娃 or 禁止套娃?

如何确保 AI 创作的原创性和真实性?用 AI 来检测 AI 内容,听起来似乎有些自相矛盾,听起来像是一场技术与技术的较量。