002-FFN(前馈神经网络)和MLP(多层感知器)的介绍及对比

FFN(前馈神经网络)与MLP(多层感知器)的介绍与对比

三元组损失Triplet loss 详解

在这篇文章中,我们将以简单的技术术语解析三元组损失及其变体批量三元组损失,并提供一个相关的例子来帮助你理解这些概念。

登顶GitHub Trending,开源工具MinerU助力复杂PDF高效解析提取

在7月4日举行的WAIC 2024科学前沿主论坛上,书生·浦语2.5正式发布,面向大模型研发与应用的全链条工具体系同时迎来升级。在数据处理环节,上海人工智能实验室(上海AI实验室)大模型数据基座OpenDataLab团队开源了全新的智能数据提取工具——MinerU。

数据缺失补全方法综述

数据缺失是数据分析和机器学习中的一个普遍问题,可能由于多种原因(如传感器故障、数据录入错误、系统故障等)导致。缺失数据不仅会影响模型的性能,还可能导致错误的推断和决策。为了应对这一挑战,研究者们提出了多种数据缺失补全方法。本文综述了几种常见的缺失数据补全技术,包括简单插补、基于模型的插补、机器学习方

【人工智能】人工智能的历史发展与机器学习和神经网络

人工智能是如何工作的?机器学习和神经网络又是什么?

大模型应用开发实例-调用闭源大模型API

本专栏着重于学习大模型应用相关知识,不会描述大模型整体框架、大模型微调等细节训练知识,主要语言是python,适合于有一定代码基础学习人员。本章节主要是通过一个简单应用了解大模型,调用大模型API创建对话。后面章节会进行本地部署大模型等应用内容。

GPT-4o mini:开启人工智能新篇章

GPT-4和GPT-4o不是早就出来了吗?为什么GPT-4o mini的出世引来这么大的轰动呢?因为它免费、因为它快、因为它接口便宜、因为它同步开启了GPT-4o-mini-2024-07-18的微调。因为你还没有点开文章,所以不知道啊~

Adam-mini:内存占用减半,性能更优的深度学习优化器

Adam-mini基于Hessian矩阵的结构,将模型参数划分为多个块,每个块使用单一的平均学习率,从而大幅减少了需要存储的学习率数量。在非LLM任务中的实验结果进一步验证了Adam-mini的广泛适用性。Adam-mini不仅在内存占用和计算效率方面具有优势,还能在多种任务中保持或提升模型性能,是

【初学人工智能原理】【11】卷积神经网络:图像识别实战

本文教程均来自b站【小白也能听懂的人工智能原理】,感兴趣的可自行到b站观看。

【轻量化神经网络的MCU部署/边缘计算:基于GD32H7】开源GD32AI-ModelZoo工具的完善与详细使用说明

本文档将对gd32ai-modelzoo中的使用方法进行更加细致的介绍。并对原博主提供的gd32ai-modelzoo部分代码进行了修改,使其可以更加顺利地运行。

AlphaGo 背后的人工智能:机器学习和神经网络

AlphaGo 的规则是学习而来的,而不是设计出来的,它运用机器学习以及多个神经网络来创建学习组件,使围棋水平更高。从与英国国家医疗服务体系的合作可以看出,AlphaGo 在其他领域也有着广阔的应用前景。

CNN卷积网络实现MNIST数据集手写数字识别

首先,通过MNIST类创建了train_data对象,指定了数据集的路径,并且将数据集标记为训练集train=True。表示不自动从网络上下载数据集,而是使用已经下载好的数据集。我是之前自己已经下载过该数据集所以这里填的是False,如果之前没有下载的话就要填True。下面测试集也是一样。将数据转换

人工智能、机器学习、神经网络、深度学习和卷积神经网络的概念和关系

深度学习通过组合低层特征形成更加抽象的高层表示属性类别或特征,以发现数据的有效表示,而这种使用相对较短、稠密的向量表示叫做分布式特征表示(也可以称为嵌入式表示)。研究深度学习的动机在于建立模拟人脑进行分析学习的神经网络,它模仿人脑的机制来解释数据,例如图像,声音和文本等。又称为机器智能,是研究、开发

【人工智能】深度学习:神经网络模型

神经网络(Neural Network)是一种模拟人脑神经元连接方式的计算模型。其基本组成部分是神经元(Neurons),通过加权连接和激活函数构成复杂的网络结构。神经网络广泛应用于模式识别、分类和回归等领域。

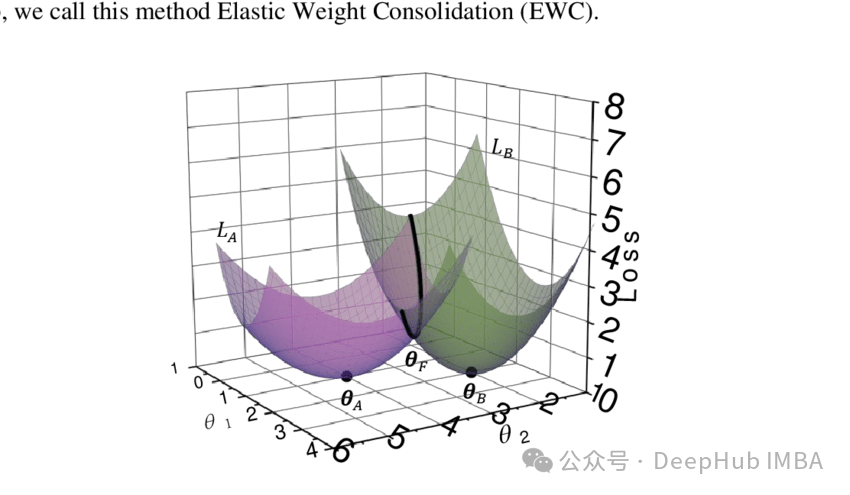

持续学习中避免灾难性遗忘的Elastic Weight Consolidation Loss数学原理及代码实现

Elastic Weight Consolidation。EWC提供了一种很有前途的方法来减轻灾难性遗忘,使神经网络在获得新技能的同时保留先前学习任务的知识。

AI集成工具平台一站式体验,零门槛使用国内外主流大模型

几十种AI大模型,欢迎体验

AI:184-神经网络应用与实战案例详解(AIGC技术方向)

AIGC(人工智能生成内容)依托于先进的神经网络技术,展现了极大的潜力和应用价值。本文介绍了AIGC的几种核心底层技术,包括循环神经网络(RNN)、长短期记忆网络(LSTM)、生成对抗网络(GAN)、变分自动编码器(VAE)和Transformer架构,并提供了相应的代码示例。循环神经网络(RNN)

RouteLLM:高效LLM路由框架,可以动态选择优化成本与响应质量的平衡

该论文提出了一个新的框架,用于在强模型和弱模型之间进行查询路由选择。通过学习用户偏好数据,预测强模型获胜的概率,并根据成本阈值来决定使用哪种模型处理查询 。该研究主要应用于大规模语言模型(LLMs)的实际部署中,通过智能路由在保证响应质量的前提下显著降低成本。

MLP多层感知器:AI人工智能神经网络的基石

MLP 是指多层感知器(Multilayer Perceptron),是一种基础人工神经网络模型(ANN,Artificial Neural Network)。MLP 能够将信息逐层重新组合,每层重组的信息经过激活函数的放大或抑制后进入下一层的数据重组,从而实现特征提取和知识获取。

【AI落地应用实战】如何让扫描工具更会思考——智能高清滤镜2.0实战测评

在这个信息爆炸的数字化时代,扫描工具已经成为我们日常工作和学习中不可或缺的助手。最近,扫描全能王推出了革命性的“智能高清滤镜2.0”,本次更新后,智能高清滤镜能够智能识别并优化扫描过程中的各种问题。无论是光线不均、背景杂乱,还是文档本身的折痕和污渍,它都能一一化解,呈现清晰、准确的扫描结果。在这篇实