1. 存内计算技术概述

存内计算技术作为一种新型的计算范式,将存储器与处理器紧密地集成在一起,实现了数据的高效处理和低延迟访问。这种技术有效地缓解了传统计算模式下存储器与处理器之间的带宽瓶颈问题,为大规模数据处理和人工智能应用提供了更高效的计算支持。

存内计算技术的核心思想是在存储器中实现简单的计算操作,以降低数据传输的功耗和延迟。它包括多种技术,如现场可编程门阵列(FPGA)、图形处理单元(GPU)、神经处理单元(NPU)等。这些技术通过硬件加速,可以大幅提高计算性能,满足AI大模型等应用场景对计算速度和效率的需求。

此外,存内计算技术还可以与传统的计算架构相结合,形成混合计算架构,以实现更高的计算性能和能效。存内计算技术在各种计算场景中的应用,如数据中心、边缘计算等,将有助于推动整个计算产业的发展,为未来人工智能、大数据等领域提供更强大的计算支持。

2. 存内计算技术原理

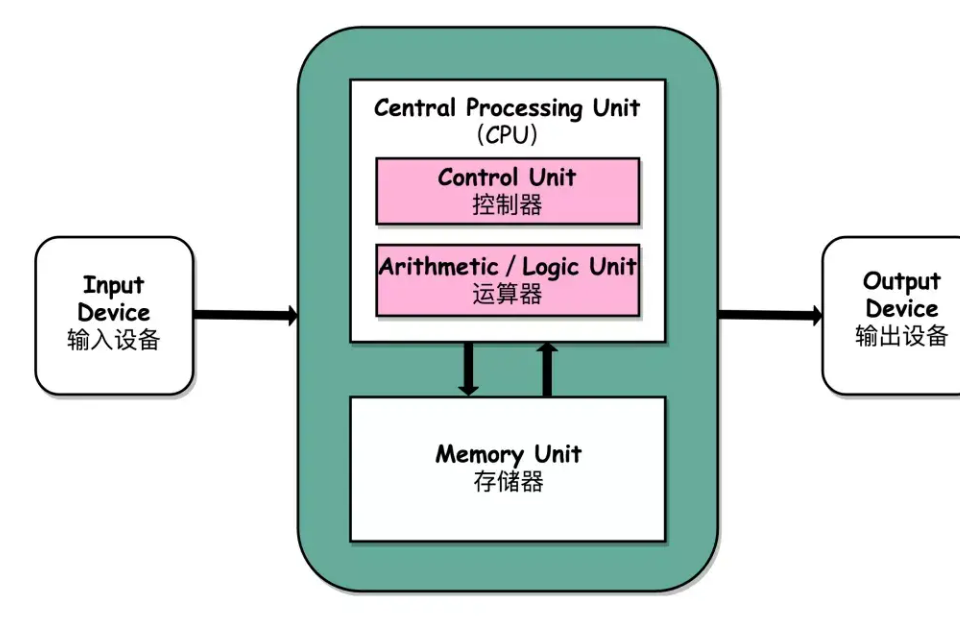

存内计算技术(Computing in Memory,CIM)是一种将计算逻辑直接嵌入到存储器中的新型计算范式。其核心原理是在存储器中实现简单的计算操作,以降低数据传输的功耗和延迟。存内计算技术通过将计算能力与存储器紧密集成,旨在克服冯·诺依曼瓶颈问题,提高计算性能和效率。

存内计算技术的原理可以分为以下几个方面:

- 存储器与计算单元的融合:存内计算技术将计算单元嵌入到存储器中,使得数据可以在存储器中直接进行计算操作,避免了数据在存储器和处理器之间的频繁传输,降低了功耗和延迟。

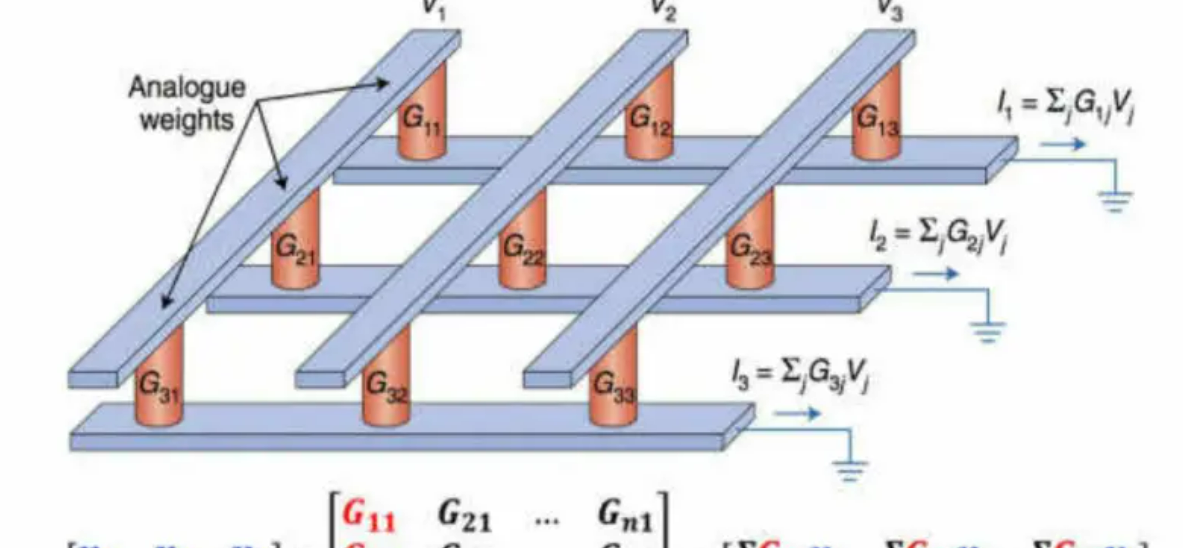

- 计算原语:存内计算技术中的计算原语是实现数据处理的基本操作。常见的计算原语包括逻辑门、乘积累加操作(MAC)等。这些操作可以直接在存储器中执行,从而减少了数据传输的次数和功耗。

- 存储器阵列:存内计算技术通常采用存储器阵列结构,将计算单元与存储单元相互连接。这样的结构使得数据可以在存储器阵列中进行高效地处理和访问。

- 硬件加速:存内计算技术通过硬件加速,可以大幅提高计算性能,满足大规模数据处理和人工智能应用场景对计算速度和效率的需求。

- 混合计算架构:存内计算技术可以与传统的计算架构相结合,形成混合计算架构,以实现更高的计算性能和能效。

3. 存内计算系统架构

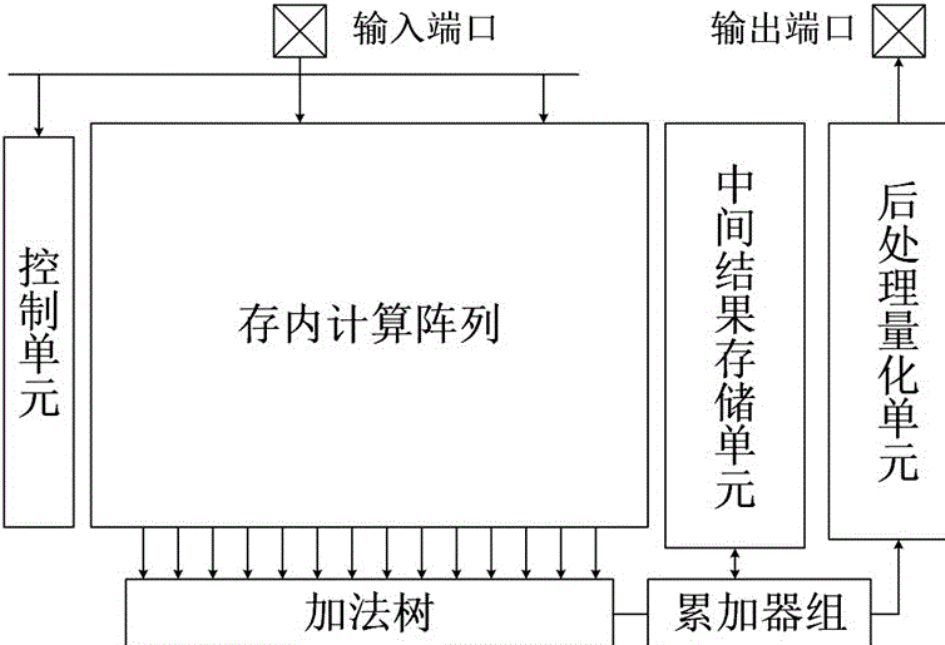

存内计算系统架构是指将存内计算技术实际应用到计算系统中的一种设计方法。它主要包括以下几个方面:

- 存储器层次结构:存内计算系统通常采用多层次的存储器结构,将计算单元嵌入到不同层次的存储器中,实现数据的直接计算。这样的结构可以降低数据传输的延迟和功耗,提高计算效率。

- 处理器与存储器的协同:在存内计算系统架构中,处理器和存储器之间需要进行紧密的协同,以实现高效的数据处理。这通常需要处理器和存储器之间采用一致的时钟和数据同步机制。

- 数据流处理:存内计算系统采用数据流处理的方式,使得数据可以在存储器中直接进行计算。这种方法可以降低数据处理的复杂度,提高计算效率。

- 并行计算:存内计算系统通常采用并行计算的方式,以实现高效的数据处理。这可以通过集成多个计算单元、利用存储器阵列的并行性等方式实现。

- 硬件管理:存内计算系统需要硬件层面对计算任务进行管理,包括计算任务的调度、数据访问控制等。这可以通过硬件控制器、存储器管理单元等方式实现。

- 软件支持:存内计算系统需要软件层面对计算任务进行支持,包括计算任务的编程模型、数据访问接口等。这可以通过修改现有编程语言、开发新的编程框架等方式实现。

4. 存内计算在AI大模型中的应用与优化

降低数据传输成本:

存内计算技术将计算单元直接嵌入到存储器中,实现数据的直接计算。这种架构可以减少数据在存储器和处理器之间的频繁传输,从而降低了数据传输成本。传统的计算架构中,数据需要从存储器传输到处理器进行计算,然后再将计算结果返回到存储器,这会消耗大量的能量和时间。而存内计算技术可以在存储器中直接进行计算,避免了这种数据传输的过程,降低了数据传输成本,提高了计算效率。

加速模型训练:

在AI大模型的训练过程中,大量的参数需要不断更新和计算,这需要大量的计算资源。存内计算技术可以加速参数更新的过程,减少了数据传输延迟,提高了训练速度。通过在存储器中直接进行计算,可以避免数据在存储器和处理器之间的频繁传输,加快参数更新的速度,从而缩短了训练时间,提高了训练效率。

优化模型推理:

在模型推理阶段,存内计算技术可以降低推理过程中的延迟,提高模型对实时数据的响应速度。通过在存储器中直接进行计算,可以加速推理过程,提高模型的推理能力。存内计算技术可以在存储器中实现对模型的快速推理,减少了数据传输的需求,提高了推理的效率和准确性。

节能环保:

存内计算技术可以降低AI大模型的能耗。由于存内计算减少了数据传输和数据的需求,降低了计算过程中的能耗。传统的计算架构中,数据存储器和处理器之间频繁传输,消耗大量的能量。而存内计算技术可以在存储器中直接进行计算,减少了数据传输的需求,降低了能耗,有助于节约能源,减少碳排放,符合节能环保的发展趋势。

硬件加速:

存内计算技术可以与现有的硬件加速器结合,如GPU、TPU等,进一步提高AI大模型的计算能力。通过在存储器层次结构中嵌入计算单元,可以实现对AI大模型的硬件加速,提高计算效率。存内计算技术与硬件加速器的结合可以实现更高效的计算过程,提高模型的计算性能和速度。

提高系统整体性能:

通过优化存内计算的算法和架构,可以实现更高效的计算过程,提高系统的整体性能和稳定性。存内计算技术的应用与优化可以提高系统的计算效率、减少能耗、加速模型训练和推理过程,从而提高系统的整体性能。通过不断优化存内计算技术,可以实现更高效的AI大模型计算,提高系统的整体性能和竞争力。

5. 存内计算在AI大模型训练中的关键作用

-存内计算可以提高训练速度和模型质量

存内计算是一种新型的计算方式,它可以在存储器中执行计算,从而减少数据传输和计算的时间,提高训练速度和模型质量。在AI大模型训练中,计算复杂度不断上升,需要大量的计算资源和时间。传统的计算方式需要将数据从存储器传输到处理器进行计算,将结果传输回存储器,这样的数据传输过程会占用大量的带宽和时间,限制了训练速度和模型质量。存内计算可以在存储器中执行计算,避免数据在存储器和处理器之间的传输,大大提高了训练速度和模型质量。

- 存内计算可以降低存储需求和成本

存内计算还可以降低存储需求和成本。在AI大模型训练中,需要存储大量的数据和模型参数,需要使用大量的存储器。传统的计算方式需要将数据从存储器传输到处理器进行计算,将结果传输回存储器,这样的数据传输过程会占用大量的存储器带宽和容量,需要使用更大、更贵的存储器芯片。存内计算可以在存储器中执行计算,减少数据在存储器和处理器之间的传输,降低存储需求。同时,存内计算可以使用更小的存储器芯片,从而降低存储成本。

- 存内计算可以提高数据传输效率和减少延迟

存内计算可以提高数据传输效率和减少延迟。在传统的计算方式中,数据需要从存储器传输到处理器进行计算,再将结果传输回存储器,这样的数据传输过程会占用大量的带宽和时间,导致数据传输效率低下。存内计算可以在存储器中执行计算,避免数据在存储器和处理器之间的传输,大大提高了数据传输效率。同时,存内计算可以减少数据传输的延迟,提高系统的响应速度和性能。

版权归原作者 存内计算开发者 所有, 如有侵权,请联系我们删除。