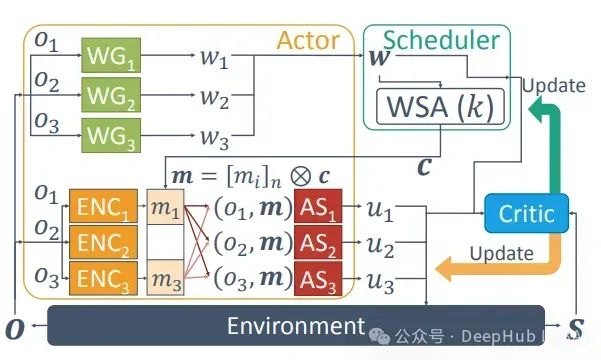

多代理强化学习综述:原理、算法与挑战

多代理强化学习是强化学习的一个子领域,专注于研究在共享环境中共存的多个学习代理的行为。每个代理都受其个体奖励驱动,采取行动以推进自身利益

神经网络与深度学习深入剖析

神经网络(Neural Networks, NN)是一种模仿人脑工作原理的计算模型,它由大量的节点(或称为神经元)组成,这些节点通过层次化的方式组织成输入层、隐藏层和输出层。每个节点都与其他节点通过权重连接,并且每个节点都有一个激活函数,用于决定该节点是否被激活。

【AI学习】了解OpenAI o1背后的self-play RL:开启新的智能道路

大模型的预训练,虽然还在继续,但是似乎有点快到智能顶点了,self-play RL,是开启了新的智能道路

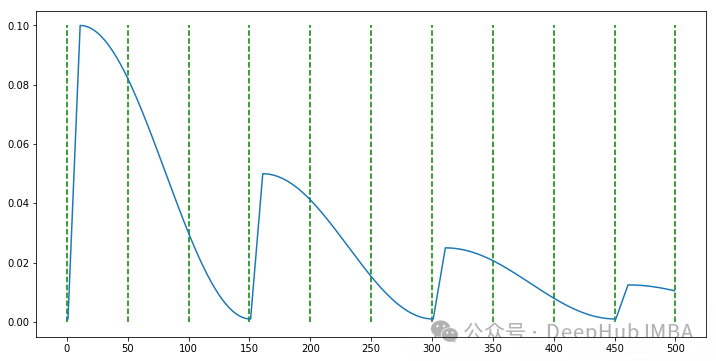

PyTorch自定义学习率调度器实现指南

本文将详细介绍如何通过扩展PyTorch的 ``` LRScheduler ``` 类来实现一个具有预热阶段的余弦衰减调度器。我们将分五个关键步骤来完成这个过程。

时间序列预测方法概述

时间序列预测是数据分析的一个重要领域,涉及对未来事件的预测,基于过去的数据点。以下是几种常用的时间序列预测方法,包括其原理、优缺点。

AI人工智能 卷积神经网络(CNN)

在架构上,普通的神经网络接收输入并通过一系列隐藏层转换它。在神经元的帮助下,每层都连接到另一层。普通神经网络的主要缺点是它们不能很好地扩展到完整的图像。CNN 的体系结构具有三维排列的神经元,称为宽度,高度和深度。当前图层中的每个神经元都连接到前一图层的一小部分输出。它类似于在输入图像上叠加一个。

讲解基于图神经网络的情绪识别深度学习模型DGCNN(附基础原理讲解和代码讲解)

频谱图理论 (Spectral Graph Theory)是用线性代数概念(如特征向量和特征值理论)研究图的性质。(想要简单了解频谱图理论可以参考这个视频。DGCNN的基础是Chebynet。Chebynet是一种频谱图神经网络(Spectral GNNs)在频谱域中操作,具体指的是在图的拉普拉斯矩

【人工智能】九种神经网络模型

人工神经网络 (ANN) 是人工智能深度学习的一个基本概念。它们在处理传统机器学习算法难以处理的复杂应用场景方面至关重要。神经网络是解决复杂问题的强大工具。它们可以学习和适应数据,并且在各个行业都有广泛的应用。对于任何想要深化人工智能和深度学习技能的人来说,它们都是必不可少的。

秃姐学AI系列之:残差网络 ResNet

假如你只想在卷积神经网络了解一个网络,那一定是ResNet!!!

欧洲杯赛事预测:人工智能算法如何预测足球结果

人工智能已成为足球预测领域的强大引擎,它通过大数据分析、高级算法和持续的学习优化,提升了预测的精度和深度。对于足球爱好者而言,人工智能提供了更科学的观赛视角,增强了比赛的观赏性和参与感。接下来,我将这款人工智能系统分享给大家,欢迎大家共同探讨。提取码:76un。

什么是贝叶斯优化(Bayesian Optimization)?

贝叶斯最优化(Bayesian Optimization)是一种用于函数全局最优化的策略,特别适用于那些计算代价昂贵的黑箱函数(如机器学习模型的超参数调优)。其核心思想是通过构建一个代理模型(通常是高斯过程或随机森林),逐步选择最优的参数,从而有效地找到全局最优解。贝叶斯最优化能够在不需要大量计算资

ai工具推荐系列:文生图,图生图工具liblibAi

介绍一款比较专业的文生图工具

torch.nn.Linear的维度变换过程详解(有图有公式有代码)

当初在学习nn.Linear时了解到的博客都是关于一维变换的,比如输入3通道,输出6通道;又比如得到(3,4,4)的特征图,需要进行拉平为(48,)的向量,然后通过nn.Linear(48,10)得到10个输出(分类任务很常见)。nn.Linear除了可以进行分类,主要的作用就是改变维度便于下一个卷

AI模型应根据应用场景选择全能型或者专精型

AI模型的发展方向,在追求全能与专精之间并非简单的二选一,都取决于其应用场景、设计目标以及技术可行性等多个因素。这两种策略各有优势和局限性。综上所述,AI模型的发展策略应根据具体情况进行权衡和选择,既可以考虑追求专精以提高特定任务的性能,也可以考虑追求全能以提高模型的通用性和适应性。

第三届人工智能、物联网和云计算技术国际会议(AIoTC 2024)

第三届人工智能、物联网和云计算技术国际会议(AIoTC 2024)

神经网络之lstm

长短期记忆网络(Long Short-Term Memory, LSTM)是一种特殊类型的循环神经网络(RNN),由 Hochreiter 和 Schmidhuber 于 1997 年提出。LSTM 旨在解决传统 RNN 在处理长序列数据时遇到的梯度消失或梯度爆炸问题。LSTM 网络的核心是三个门的

混合策略改进的蜣螂算法(IDBO)优化BP神经网络

针对DBO算法全局探索能力不足、易陷入局部最优以及收敛精度不理想等问题,多为学者提出了混合多策略改进的蜣螂优化算法(IDBO)。主要混合策略改进首先是采用混沌映射结合随机反向学习策略初始化种群提高多样性,扩大解空间 搜索范围,增强全局寻优能力;其次通过黄金正弦策略实现个体动态搜索,提高算法遍历性;在

MATLAB神经网络拟合工具的使用

使用MATLAB神经网络拟合工具箱的流程。

详解归一化、标准化、正则化以及batch normalization

一文详解归一化、标准化、正则化以及batch normalization

图像相关的基础知识【RGB和RGBA】—附python代码实现

图像处理基础知识,了解RGB和RGBA