华为昇腾310P AI 智能计算模组规格书

PCIe Gen4.0 ,兼容 3.0/2.0/1.0 XGE、SATA、USB 等接口。基于昇腾310P 模组设计的 AI 智能产品,可根据实际应用需求,可应用于机器人、无人机、无人。领域,有着极高的性价比,具有超强算力、 超高能效、高性能特征检索、安全启动等优势。支持 I2C、 UART、 CA

可解释人工智能(XAI)领域的全面概述

本文提供一份关于 XAI 的全面综述,涵盖常见的术语和定义、XAI 的需求、XAI 的受益者、XAI 方法分类以及 XAI 方法在不同应用领域的应用。

什么是AI神经网络?

在当今的科技时代,人工智能(AI)已经深入到我们生活的各个方面,而神经网络则是推动这一发展的重要技术之一。总之,AI神经网络是人工智能领域的重要组成部分,它的强大能力正在改变我们的生活方式。无论你是技术爱好者,还是普通用户,了解神经网络的基本原理都能帮助你更好地理解这个快速发展的科技世界。随着计算能

深度学习工程实践:PyTorch Lightning与Ignite框架的技术特性对比分析

在深度学习框架的选择上,PyTorch Lightning和Ignite代表了两种不同的技术路线。本文将从技术实现的角度,深入分析这两个框架在实际应用中的差异,为开发者提供客观的技术参考。

时间序列-插补-顶会顶刊论文汇总【论文/源码链接】

这是一篇关于时间序列插补的纯干货分享,原文链接[github](https://github.com/wenjiedu/awesome_imputation?tab=readme-ov-file),【搬运 侵删】

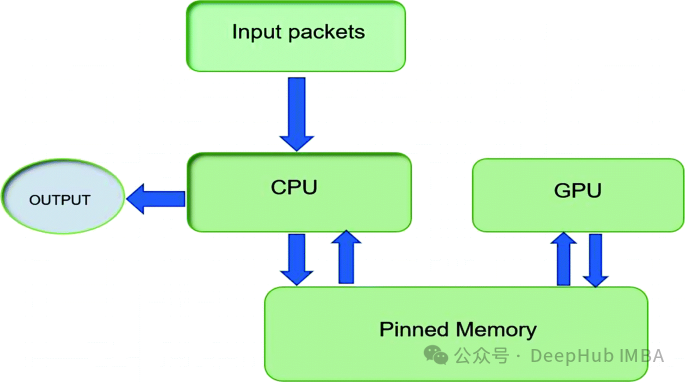

通过pin_memory 优化 PyTorch 数据加载和传输:工作原理、使用场景与性能分析

本文将深入探讨何时以及为何启用这一设置,帮助你优化 PyTorch 中的内存管理和数据吞吐量。

生成对抗网络在AI艺术展览中的创新与挑战【附保姆级代码】

AI艺术作为一个新兴的领域,正以其独特的方式改变着我们对艺术的认知与创造。通过技术的不断进步与应用,AI艺术将在未来继续蓬勃发展,为人类的文化生活带来新的可能性。在接下来的岁月中,我们期待着更多跨学科的合作、技术的创新以及更深层次的艺术探讨,AI艺术将在这个过程中不断演变,展现出更加丰富的内涵和形式

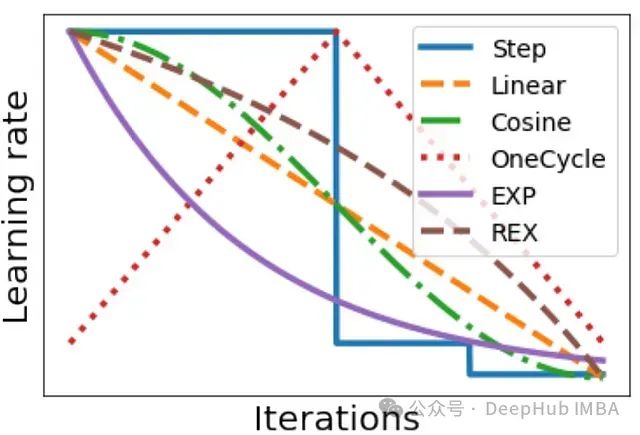

深度学习中的学习率调度:循环学习率、SGDR、1cycle 等方法介绍及实践策略研究

深度学习实践者都知道,在训练神经网络时,正确设置学习率是使模型达到良好性能的关键因素之一。学习率通常会在训练过程中根据某种调度策略进行动态调整。调度策略的选择对训练质量也有很大影响。

【人工智能】AI人工智能的重要组成部分,深入解析CNN与RNN两种神经网络的异同与应用场景和区别

通过对CNN与RNN的深入分析,我们可以看到这两种神经网络在结构、功能和应用场景上的显著区别。

用ai写论文查重率高吗?分享4款ai智能写论文软件

其次,AI生成的论文查重率受多种因素影响,包括论文的主题、内容的独特性、所使用的AI工具的能力以及查重系统的特点。通过合理使用这些AI写作工具,并结合个人的研究和观点进行编辑和优化,可以有效降低论文的查重率,提高论文的质量和可信度。3. 文通AI:文通AI是一款专业的AI论文写作工具,覆盖多个学科领

PRCV2024:可信AI向善发展与智能文档加速构建

在PRCV2024中,合合信息图像算法研发总监郭丰俊老师针对生成式人工智能时代下图像内容安全和智能文档加速的相关技术,分享了自己的独到见解,并介绍了合合信息在这两个方向上取得的进步。接下来,让我们深入了解一下GAI在智能文档领域带来的挑战与机遇。

Liquid AI与液态神经网络:超越Transformer的大模型架构探索

自2017年谷歌发表了开创性的论文《Attention Is All You Need》以来,基于Transformer架构的模型迅速成为深度学习领域的主流选择。然而,随着技术的发展,挑战Transformer主导地位的呼声也逐渐高涨。最近,由麻省理工学院(MIT)计算机科学与人工智能实验室(CSA

AI换人脸facefusion项目口型同步API化改造及部署

FaceFusion是一款强大的AI换脸软件,它支持图片、视频以及直播换脸,官方将其称为“下一代脸部交换器和增强器”。FaceFusion的最新版本为2.6.1,这个版本在原有基础上增加了更多的模型和高清算法,显著提升了图片和视频的换脸效果。此外,FaceFusion还新增了三种遮罩功能,有效解

扩散引导语言建模(DGLM):一种可控且高效的AI对齐方法

随着大型语言模型(LLMs)的迅速普及,如何有效地引导它们生成安全、适合特定应用和目标受众的内容成为一个关键挑战。例如,我们可能希望语言模型在与幼儿园孩子互动时使用不同的语言,或在撰写喜剧小品、提供法律支持或总结新闻文章时采用不同的风格。目前,最成功的LLM范式是训练一个可用于多种任务的大型自回归模

人工智能 | BP神经网络

到这里已经可以重新描述BP神经网络的定义了,官方的说法是“按照误差逆向传播算法训练的。

物理 + 人工智能 = 2024年诺贝尔物理学奖

近日,2024年诺贝尔物理学奖颁发给了机器学习与神经网络领域的研究者,这是历史上首次出现这样的情况。这项奖项原本只授予对自然现象和物质的物理学研究作出重大贡献的科学家,如今却将全球范围内对机器学习和神经网络的研究和开发作为了一种能够深刻影响我们生活和未来的突出成果。机器学习和神经网络凭借其高效、准确

多尺度卷积神经网络(MSCNN)的底层原理及使用环境是如何的?Ai人工智能目前已经发展到第二阶段

多尺度卷积神经网络(MSCNN)是一种用于处理不同尺度特征的深度学习模型。

人工智能发展简史 | 梦开始的地方:M-P模型

追溯人工神经网络的源头,是由神经生理学家麦卡洛克(Warren S. McCulloch)与自学成才的数学家皮茨(Walter Pitts)提出的神经网络逻辑演算模型。1943年,McCulloch 和 Pitts 一同发表论文《神经活动内在思想的逻辑演算》(A logical calculus o

深入探讨生成对抗网络(GANs):颠覆传统的AI创作方式

生成对抗网络(GANs)作为一种创新的生成模型,正在不断推动人工智能的发展。通过对抗训练的机制,GANs不仅在图像生成领域取得了显著的进展,也在其他多个领域展现出巨大的潜力。随着技术的不断进步,GANs将在未来的智能创作中发挥更加重要的作用。