经典分类模型回顾4-Resnet实现图像分类(matlab)

ResNet(Residual Network)是由Microsoft Research团队提出的一种深度卷积神经网络结构,它在ImageNet图像分类比赛中获得了第一名的成绩。ResNet的主要特点是引入了残差块(Residual Block)的概念,使得网络可以更深,并且训练效果更好。在ResN

计算机视觉之姿态识别(原理+代码实操)

计算机视觉中的姿态识别原理+模型介绍,同时通过代码实操简单的演示基于mediapipe的单人姿态识别。

Tensorflow1 搭建Cuda11

Tensorflow1中默认支持cuda10及以下的,最高的版本Tensorflow1.15默认使用cuda10;但是一些高性能的显卡,比如A100、3090等,它们只支持Cuda11的,这就不太友善了,毕竟不少项目依赖Tensorflow1搭建的。本文整理2种方法,一种是基于Conda搭建的,一种

Pytorch对预训练好的VGG16模型进行微调

对于一个复杂的卷积神经网络来说,通常网络的层数非常大,网络的深度非常深、网络的参数非常多,单单设计一个卷积网络就需要颇费心思,何况网络还需要大量的数据集进行漫长时间的训练,若没有一个好的算力平台也很难迅速训练出模型。可见,从头到尾搭建一个中等规模的卷积神经网络对于我们来说绝非易事。幸运的是PyTor

基于PyTorch+CNN一维卷积实现短期电力负荷预测

本项目使用了一种基于一维卷积CNN短期电力负荷预测方法,该方法将历史负荷数据作为输入,将输入向量构造为时间序列形式作为 Conv1D 网络的输入,建模学习特征内部动态变化规律,最后完成短期负荷预测。

BERT模型基本理念、工作原理、配置讲解(图文解释)

BERT模型基本理念、工作原理、配置讲解(图文解释)

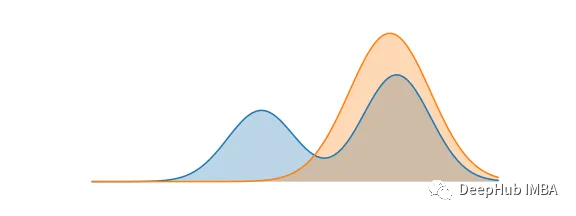

KL散度和交叉熵的对比介绍

KL散度(Kullback-Leibler Divergence)和交叉熵(Cross Entropy)是在机器学习中广泛使用的概念。这两者都用于比较两个概率分布之间的相似性,但在一些方面,它们也有所不同。本文将对KL散度和交叉熵的详细解释和比较。

优化器SGD、Adam和AdamW的区别和联系

优化器是用来更新和计算影响模型训练和模型输出的网络参数,使其逼近或达到最优值,从而最小化(或最大化)损失函数。

ResNet 训练CIFAR10数据集,并做图片分类

超深的网络结构,可以突破1000层提出residual 模块使用Batch Normalization 抑制过拟合,丢弃Dropout方法针对第一点,我们知道加深网络层对于提升网络性能至关重要。然而实际情况中,网络层的加深会导致学习无法进行,性能会更差。因为网络的深度会导致梯度消失或者梯度爆炸的问题

CNN(一维卷积Conv1D)实现时间序列预测(PyTorch版)

本专栏整理了《深度学习时间序列预测案例》,内包含了各种不同的基于深度学习模型的时间序列预测方法,例如LSTM、GRU、CNN(一维卷积、二维卷积)、LSTM-CNN、BiLSTM、Self-Attention、LSTM-Attention、Transformer等经典模型,包含项目原理以及源码,每一

深度学习之CSPNet网络分析

一、简介CSPNet:Cross Stage Partial Network,跨阶段局部网络作用:从网络设计角度来缓解以前推理时需要很大计算量的问题推理计算过高的原因:由于网络优化中的梯度信息重复导致的!cspnet解决方式:通过将梯度的变化从头到尾地集成到特征图中,在减少了计算量的同时可以保证准确

图解cross attention

交叉注意力与自我注意力。

ChatGPT相关核心算法

ChatGPT 的卓越表现得益于其背后多项核心算法的支持和配合。本文将分别介绍作为其实现基础的 Transformer 模型、激发出其所蕴含知识的Prompt/Instruction Tuning 算法、其涌现出的思维链能力、以及确保其与人类意图对齐的基于人类反馈的强化学习算法。

os.environ[‘CUDA_VISIBLE_DEVICES‘] 和torch.cuda.set_device()

在使用 PyTorch 进行训练之前,需要确保已经正确设置了可见的 GPU 设备,并且已经初始化了 CUDA 环境。是一个环境变量,可以通过设置它来限制程序所能看到的可用 GPU 设备列表,从而确保程序只使用指定的 GPU 设备。设置该环境变量可以使用。则是一个 PyTorch 提供的函数,用于将程

深度学习|论文中常用的注意力模块合集(下)

注意力机制可以增加少量参数的情况下来提升计算精度和模型性能,在论文中常用的注意力模块合集(上)中介绍了三种注意力机制,它们分别是CA、CBAM和SE,均在目标检测和语义分割领域内能够提升模型的性能,废话不多说,直接开始讲解剩下的论文中常用的注意力模型。1、有效通道注意力(Efficient Chan

语义分割的常用指标详解

1 混淆矩阵假设有6个类别,L为10个真实标签的取值,P为对应的预测的标签值,先计算对应的n(类别数,这里假设为6)xL+P:bin的值一定是分类数的平方。混淆矩阵先将真实标签和预测标签抻成一维向量,做一个对应关系(nxL+P),再将这个对应的一维向量抻成二维矩阵,如下图,很奇妙地将真实值与预测值之

yolov5-runs文件中对train结果的说明

yolov5中train结果说明

AutoGPT、AgentGPT、BabyAGI、HuggingGPT、CAMEL:各种基于GPT-4自治系统总结

本文将整理一些开源的类似AutoGPT的工具系统

ChatGPT类模型汇总

当今的自然语言处理领域,基于Transformer架构的大型语言模型(LLM)成为了研究的热点,其中ChatGPT类模型更是备受关注。这类模型以OpenAI GPT系列模型为代表,具有无监督预训练和有监督微调的能力,可以为对话系统、问答系统等任务提供强大的语言生成和理解能力。本篇博客将对当前较为知名