这是一篇ICLR 2022的会议论文,ICLR由Lecun,Hinton和Bengio三位神经网络的元老联手发起。近年来随着深度学习在工程实践中的成功,ICLR会议也在短短的几年中发展成为了神经网络的顶会。哎,我也想发这样的文章,今天我们就来看看这篇文章的成功之处,虽然论文给了代码但是现在打不开或者无法访问到,裂开了! 但是这篇文章的实验做得还是挺充分的,可视化也挺好,属于比较不错的一类,自己达不到的水平,哈哈!

微小物体由于分辨率低、体积小,很难被探测到。网络的局限性和训练数据集的不平衡是导致微小目标检测性能不佳的主要原因该文提出了一种**复合结构的FPN**,它包含一个**上下文扩展模块**和一**个特征细化模块**。上下文增强模块利用扩展卷积提取不同接收域的上下文信息,并将其集成到FPN中,对微小物体的上下文信息进行改进。特征细化模块结合了**空间自适应融合**和**信道自适应融**合,从信道和空间维度抑制冲突特征,突出有用特征。此外,为了防止训练不平衡,提出了一种微小对象的复制-减少-粘贴数据增强方法。

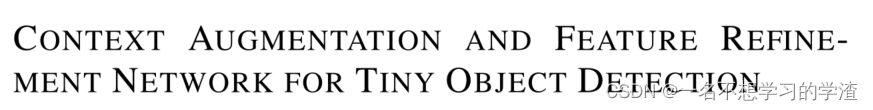

金字塔结构FPN可以在一定程度上缓解信息扩散问题,通过水平融合低分辨率特征图和高分辨率特征图。但是,直接融合不同密度的信息会导致语义冲突,限制了多尺度特征的表达,容易使**微小的物体淹没在冲突的信息中**。同时,在当前的经典公共数据集中,微小对象的注释数量远远少于较大目标的注释数量(Chen et al, 2020)。因此,在训练过程中,网络的收敛方向**不断向较大的目标倾斜,导致对微小目标的性**能较差。因此作者从这两方面作为突破口进行改进来提升小目标检测。**为解决微小物体特征分散(意思就是小物体分布的非常散,并不是聚集在一起的)和层间语义差异(不同的层所代表的语义信息会产生混乱,比如说深层特征中包含的小目标信息较少,但是有时候影响到大目标的预测结果)的问题,提出了一种结合上下文增强和特征细化的特征金字塔复合神经网络结构。提出的算法框架如下图所示。在**整体网络结构。CAM和FRM是该网络的主要组成部分。CAM向FPN注入上下文信息,FRM对FPN的冲突信息进行过滤。

一、上下文增强模块(CAM,CONTEXT AUGMENTATION MODULE)

一、上下文增强模块(CAM,CONTEXT AUGMENTATION MODULE)

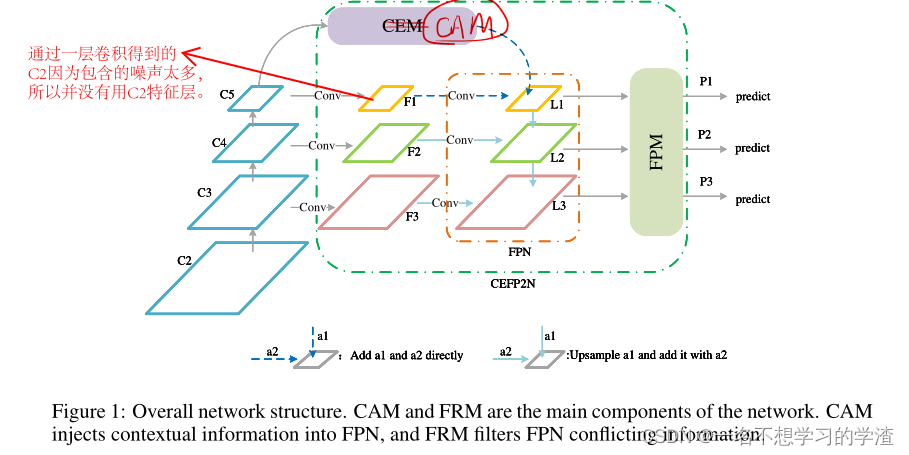

微小目标检测需要上下文信息。我们提出使用具有不同扩张卷积率的扩张卷积来获取不同接受域的上下文信息,以丰富FPN的上下文信息。如下图所示,这就是常用的ASPP,当然如果只是这样引用肯定是不行的,所以作者做了下面的事情。

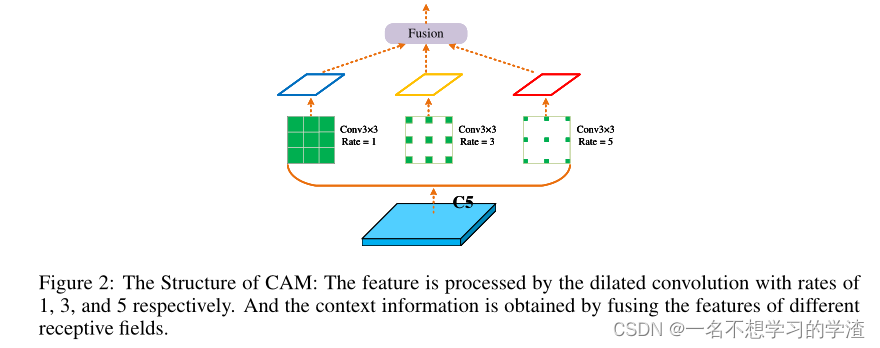

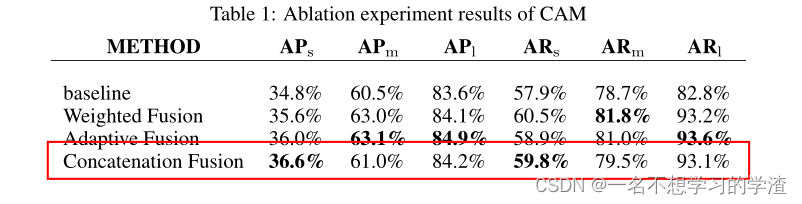

作者又将这样的ASPP模块的融合方式通过下面三种方式进行实验,其中(a)和(c)方式就是一般的进行相加和拼接,几种不同的特征的权重是相同的,而对于(b)方式就是将最终结果再通过一个注意力机制进行重要性分析。一般来说第二种方式是比较不错的,因为这种方法我是在其他论文上见过的,在那篇小目标检测论文中,(b)的方式是一个创新点部分。但是在这篇文章中,作者通过实验直接得到(c)的融合方式对小目标的检测是最好的。如下表所示。

不同的融合方式

不同的融合方式的实验结果

二、功能模块细化(FRM,FEATURE REFINEMENT MODULE)

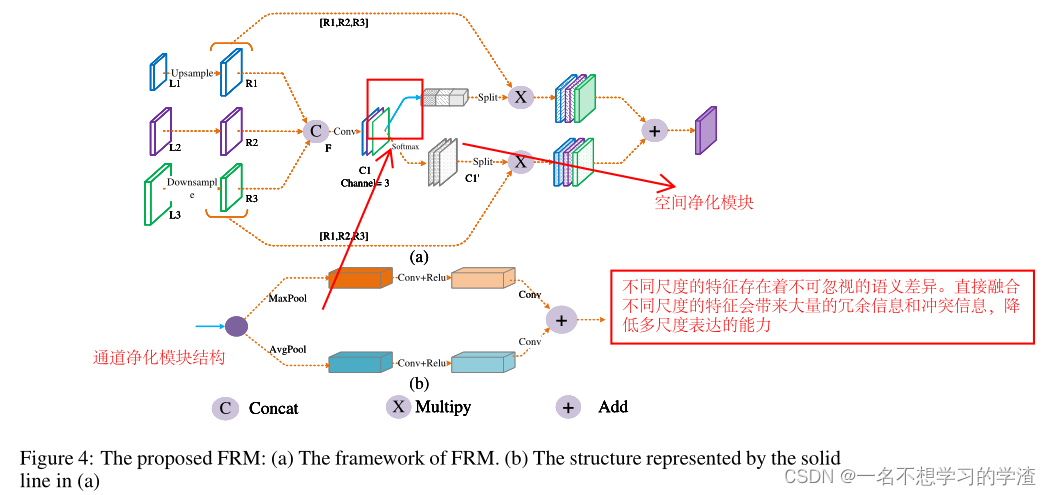

这一部分的内容就是用来过滤冲突信息,防止微小物体的特征直接被淹没在冲突信息中,因为在FPN中对不同尺度进行融合,容易产生大量的冗余信息和冲突信息,从而降低了多尺度表达能力。具体结构如下图所示:

该结构分为两种模块,分别是通道上的过滤模块以及空间上的过滤模块,对于通道净化模块,作者首先使用两种池化方法,然后将自适应平均池和自适应最大池相结合,获得更精细的图像全局特征。空间过滤模块 通过softmax生成各位置相对于通道的相对权重。至于一些公式,其实还是得看源码。当然其实也并不是特别的难,就是对不同的特征层自适应的赋予不同的权重。

该结构分为两种模块,分别是通道上的过滤模块以及空间上的过滤模块,对于通道净化模块,作者首先使用两种池化方法,然后将自适应平均池和自适应最大池相结合,获得更精细的图像全局特征。空间过滤模块 通过softmax生成各位置相对于通道的相对权重。至于一些公式,其实还是得看源码。当然其实也并不是特别的难,就是对不同的特征层自适应的赋予不同的权重。

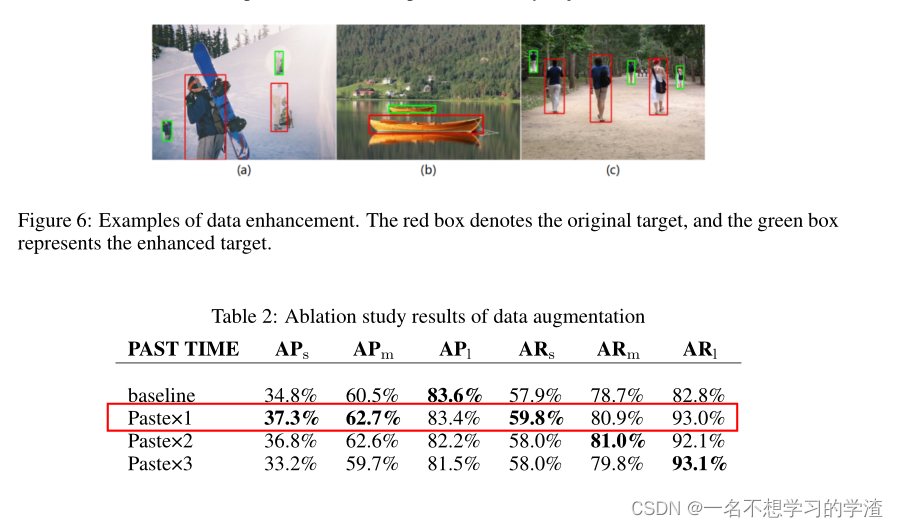

三、COPY-REDUCE-PASTE数据增强

在目前的主流公共数据集中,小目标产生的正样本数量和对小目标损失的贡献都远远小于大目标,使得收敛方向向大目标倾斜。为了缓解这一问题,我们在训练过程中对目标进行复制、缩小和粘贴。通过增加图像中微小物体的数量和包含微小物体的图像数量,增加了对微小物体丢失的贡献,使训练更加平衡。下图是每个目标在不同位置粘贴一次的结果。通过这种方法,极大地丰富了微小物体的数量和上下文信息。从下表可以看出,随着粘贴次数的增加,微小物体的检测性能逐渐下降,甚至可能低于基线。这可能是因为随着粘贴次数的增加,数据集的分布逐渐被破坏,使得测试集中的性能变差。实验结果表明,涂一次为最佳凝固时间。

后面就是一些可视化实验结果以及数据结果的内容了,感兴趣的效果伴可以自行学习哈!

版权归原作者 一名不想学习的学渣 所有, 如有侵权,请联系我们删除。