深度学习——卷积层的输入输出多通道(笔记)+代码

每组卷积核提取的特征不一样。我的猜测是,比如有一个图片,加上一个滤镜(一组卷积核),是朦胧的。通过一组卷积核,把输入的三个通道的信息对应像素进行加权和,得到一个输出通道。不管输入的是多个通道,每个通道都有对应的卷积核,输出通道的结果是所有卷积核的和。②把输出的6个通道传入,此刻的输入通道识别并组合输

激活函数ReLU和SiLU的区别

在这里,我就简单写一下两个激活函数的概念以及区别,详细的过程可以看看其他优秀的博主,他们写的已经非常好了,我就不必再啰嗦了

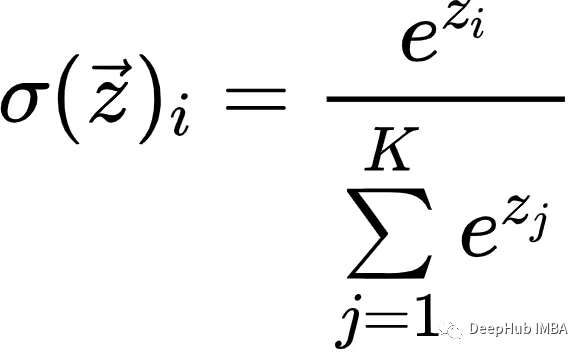

Softmax简介

Softmax是一种数学函数,通常用于将一组任意实数转换为表示概率分布的实数。

gpt模型训练-gpt3模型详解

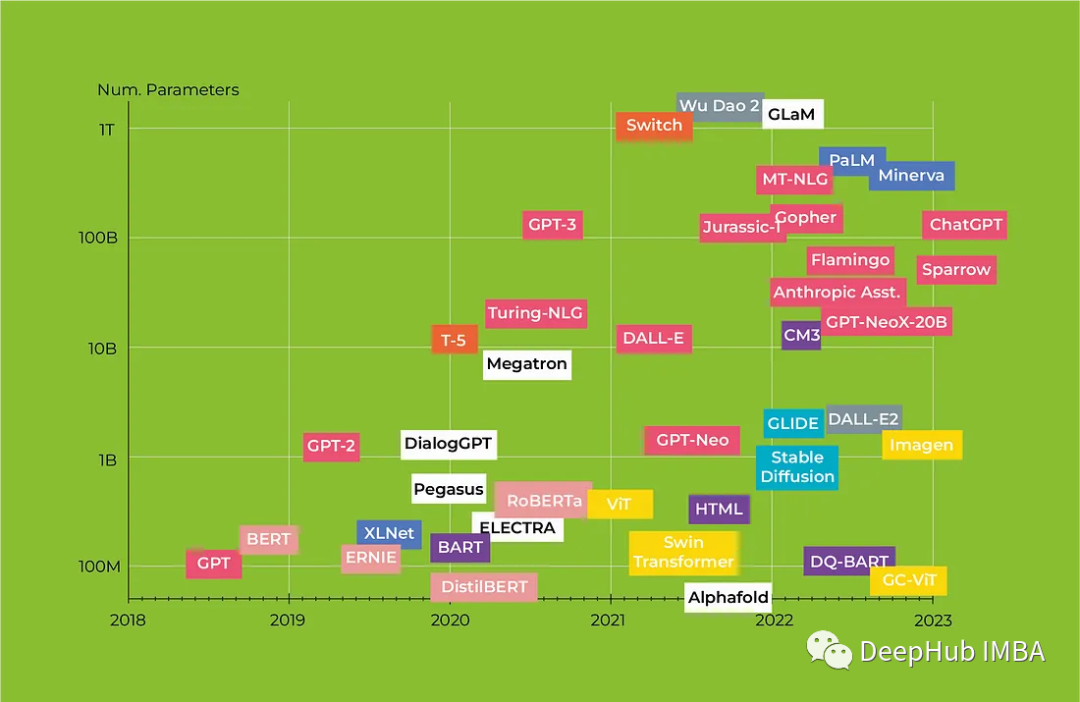

目前,GPT-3已经成为最流行、最常用的GPT模型,它集成了1750亿个参数,能够执行一系列的自然语言处理任务,包括翻译、问答、文本摘要、对话生成等。具体而言,GPT模型将Transformer中的编码器部分作为自己的网络架构,实现了一个多层的、自回归的语言模型。总之,GPT模型是一种强大的、通用的

2022.07.25 C++下使用opencv部署yolov7模型(五)

opencv下部署yolov7

卷积神经网络CNN-全连接层

卷积神经网络CNN-全连接层,特点、作用、复杂度,全连接层的操作过程详解

2022年度强化学习领域19个重要进展汇总

为了创造更安全的对话智能体,DeepMind在最新论文中提出了Sparrow(麻雀)模型,探索了训练对话智能体的新方法,即从人类的反馈中学习,使用基于研究参与者输入的强化学习,能够减少生成不安全和不适当答案的风险。最近,AlphaZero 的作者 Demis Hassabis 与 DeepMind

一文看懂多模态大型语言模型GPT-4

GPT-4是OpenAI公司3月推出的新一代人工智能预训练AI模型,是一个多模态大型语言模型,使用了1.5万亿个参数,是GPT-3.5的10倍之多,当然它也是世界上最大的人工智能模型。

win10 cuda11.8 和torch2.0 安装

win10 cuda11.8 和torch2.0 安装,pytorch 新版本

PyTorch 实现CycleGAN 风格迁移

一、前言 pix2pix对训练样本要求较高,需要成对的数据集,而这种样本的获取往往需要耗费很大精力。CycleGAN恰巧解决了该问题,实现两个domain之间的转换,即只需要准备两种风格的数据集,让GAN去学习将domain X中的图片转换成domain Y的风格(不改变domain X原图中

“ChatGPT们”的淘金时代

语言(即读写能力)是人类最重要的发明,也是人类与其它物种的最大区别。语言使我们掌握了抽象推理,发展出了复杂思维,学会了与他人沟通交流。可以说,没有语言就不会有现代文明。因此,未来几年大型语言模型(LLM)将极大地影响生成式AI的发展,ChatGPT的迅速普及就是很好的例证。此外,LLM还在多种场景得

语义分割系列15-UPerNet(pytorch实现)

本文介绍了UPerNet论文思想,介绍了UPerNet作者如何创建Multi-task数据集以及如何设计UPerNet网络和检测头来解决Multi-task任务。本文对于UPerNet语义分割部分的模型进行单独复现,所有代码基于pytorch框架,并在Camvid数据集上进行训练和测试。......

字节跳动CVPR 2023论文精选来啦(内含一批图像生成新研究)

计算机视觉领域三大顶会之一的 CVPR 今年已经开奖啦。今年的 CVPR 将于六月在加拿大温哥华举办,和往年一样,字节跳动技术团队的同学们收获了不少中选论文,覆盖文本生成图像、语义分割、目标检测、自监督学习等多个领域,其中不少成果在所属领域达到了 SOTA(当前最高水平)。一起来看看这些成果吧~

手把手教你搭建自己本地的ChatGLM

如果能够本地自己搭建一个ChatGPT的话,训练一个属于自己知识库体系的人工智能AI对话系统,那么能够高效的处理应对所属领域的专业知识,甚至加入职业思维的意识,训练出能够结合行业领域知识高效产出的AI。这必定是十分高效的生产力工具,且本地部署能够保护个人数据隐私,能够内网搭建办公使用也十分的方便。而

Transformers回顾 :从BERT到GPT4

在本文中,我们将研究革命性的Transformers架构以及它如何改变NLP,我们还将全面回顾从BERT到Alpaca的Transformers模型,重点介绍每种模型的主要特征及其潜在应用。

RealSense D435i深度相机介绍

D435i硬件结构及各个组件原理详解

使用LSTM预测结果为一条直线原因总结

使用LSTM预测结果为一条直线原因总结

深入浅出Pytorch函数——torch.ones

torch.ones

yolov7目标检测:基于自定义数据集完成检测、训练、测试

主要分三步:(1)环境配置与文件配置(2)检测(3)训练。其中,检测和训练都是可以独立进行的。检测是依赖于权重文件即可运行,而训练是基于自定义训练数据集和超参数生成权重文件。

基于SadTalker的AI主播,Stable Diffusion也可用

基于之前的AI主播的的学习基础和,这次尝试一下VideoRetalking生成效果。总体来说,面部处理效果要好于Wav2Lip,而且速度相对于Wav2Lip+GFPGAN也提升很多,也支持自由旋转角度,但是如果不修改源码的情况下,视频的部分截取稍微有点问题。这个训练图片还好,如果是做视频的话还是比较