概述:隐式神经表示(Implicit Neural Representations,INRs)

本文主要概述了隐式神经表示的相关内容,主要倾向于三维重建的应用。同时对隐式表示做了一个展开阐述。

使用思维链(Chain-of-thoughts)提示在大型语言模型中引出推理

“思维链提示”的方法,通过生成一系列中间推理步骤或思维链来提高法LLM 的复杂推理能力。

毕业设计-基于深度学习的图像去噪方法研究

毕业设计-基于深度学习的图像去噪方法研究:图像去噪是利用图像序列的上下文信息去除噪声,从而恢复出清晰图像的一种技术,是计算机视觉领域重要研究内容之一。随着机器学习的发展,深度学习在图像去噪领域得到广泛应用,成为处理图像去噪的有效解决方法。图像的去噪研究是计算机视觉领域的重要组成部分。近年来,基于深度

【YOLO系列】YOLOv4论文超详细解读2(网络详解)

YOLOv4包含的tricks超级详细介绍,更深一步的解读。

李宏毅_机器学习_作业4(详解)_HW4 Classify the speakers

李宏毅_机器学习_作业4(详解)_HW4 Classify the speakers

Python :MNIST手写数据集识别 + 手写板程序 最详细,直接放心,大胆地抄!跑不通找我,我包教!

利用Python语言编写和调试一个识别手写数字图像的三层深度前馈网络,包括数据预处理,网络模型构建,模型参数初始化和正向推理,反向梯度下降参数寻优,最后模型预测的功能。目的是学会基本的深度网络模型建立、训练和推理过程,理解深度网络的实现原理。

优化改进YOLOv5算法之添加SE、CBAM、CA模块(超详细)

本文主要是在YOLOv5算法中加入SE、CBAM和CA注意力机制模块,通过实验验证对比,加入CBAM和CA注意力机制后的效果均有所提升

激活函数(Relu,sigmoid,Tanh,softmax)详解

总结了常用的激活函数,如何在工程实践中合理选择激活函数。

文本匹配SimCSE模型代码详解以及训练自己的中文数据集

这个模型的定义其实很简单,就是用bert作为特征提取的基础模型,然后再bert模型输出的基础上加上一个dropout操作,就是代码中的pooling层,核心代码就是下面几行outputs . append(output) count += 1 except : break output = bert

LSTM+注意力机制(Attention)实现时间序列预测(PyTorch版)

本专栏整理了《深度学习时间序列预测案例》,内包含了各种不同的基于深度学习模型的时间序列预测方法,例如LSTM、GRU、CNN(一维卷积、二维卷积)、LSTM-CNN、BiLSTM、Self-Attention、LSTM-Attention、Transformer等经典模型,包含项目原理以及源码,每一

什么是注意力机制及其应用(self attention)?

注意力机制是自深度学习快速发展后广泛应用于自然语言处理、统计学习、图像检测、语音识别等领域的核心技术,例如将注意力机制与RNN结合进行图像分类,将注意力机制运用在自然语言处理中提高翻译精度,注意力机制本质上说就是实现信息处理资源的高效分配,例如先关注场景中的一些重点,剩下的不重要的场景可能会被暂时性

YOLOv5 backbone(一)

yolov5中Backbone部分

ChatGPT+Midjourney实现儿童绘本故事及其插图(数字1~10的故事)

近期AI对话技术与AI绘画技术突飞猛进。本文尝试结合AI对话与AI绘画进行儿童绘本内容的创作,发现AI对话技术已经超越大部分人类水平。但是AI绘画在精细的主体个数以及主体动作语义的理解上还远未达到人类水平。

预测任务评价指标acc,auc

1、分别表示什么TP(true positive):表示样本的真实类别为正,最后预测得到的结果也为正;FP(false positive):表示样本的真实类别为负,最后预测得到的结果却为正;FN(false negative):表示样本的真实类别为正,最后预测得到的结果却为负;TN(true neg

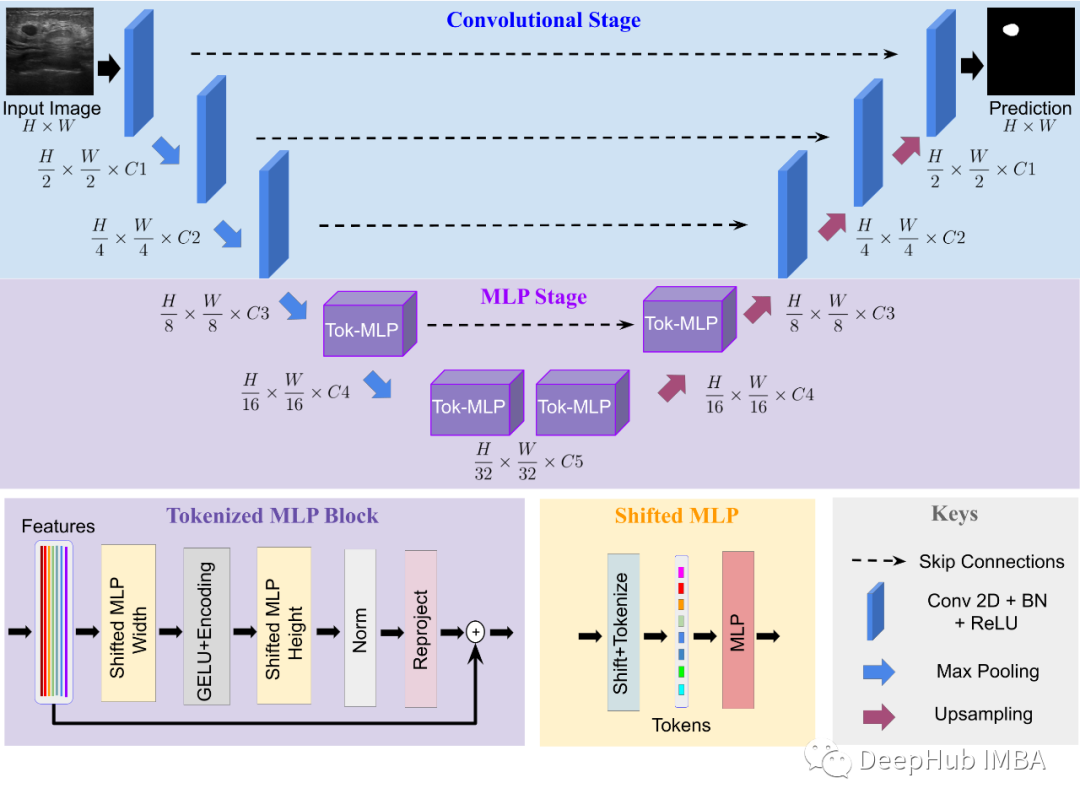

UNeXt:基于 MLP 的快速医学图像分割网络

UNeXt是约翰霍普金斯大学在2022年发布的论文。它在早期阶段使用卷积,在潜在空间阶段使用 MLP。通过一个标记化的 MLP 块来标记和投影卷积特征,并使用 MLP 对表示进行建模。对输入通道进行移位,可以专注于学习局部依赖性。

gpt4人工智能怎么下载-chatgpt哪里下载

通常,您需要训练GPT模型,采用有意义的对话数据和有意义的提示和激活响应函数,才能获得高质量和自然的响应。在生成文本时,我们可以使用带有模板的文本提示,以便GPT-2模型了解预期的生成文本类型。但请注意,这只是一个示例,在生产环境中,您可能需要更多的定制和调整,以获得更高质量的中文文本。Happy

SGD,Adam,AdamW,LAMB优化器

BERT 预训练包括两个阶段:1)前 9/10 的训练 epoch 使用 128 的序列长度,2)最后 1/10 的训练 epoch 使用 512 的序列长度。优化器是用来更新和计算影响模型训练和模型输出的网络参数,使其逼近或达到最优值,从而最小化(或最大化)损失函数。优点: 简单性,在优化算法中没

四种类型自编码器AutoEncoder理解及代码实现

慢慢的会设计自己的编码器和解码器。全部都将其搞定都行啦的回事与打算。慢慢的全部都将其搞定都行啦的回事与打算。

YOLOv5车辆测距实践:利用目标检测技术实现车辆距离估算

YOLOv5目标检测技术进行车辆测距。相信大家对YOLOv5已经有所了解,它是一种快速且准确的目标检测算法。接下来,让我们一起探讨如何通过YOLOv5实现车辆距离估算。

YOLOv7保姆级教程!(个人踩坑无数)----环境配置

深度学习,yolo环境详细配置讲解