【人工智能的数学基础】圆周率(Ratio of Circumference to Diameter)的计算

圆周率π,在几何学中定义为圆的周长与直径之比,在分析学中定义为满足sinx0的最小正实数,其数值约为3.1415926。1988年3月14日,旧金山科学博物馆的物理学家组织博物馆的员工围绕博物馆纪念碑371722圈,并一起吃水果派。之后每年旧金山科学博物馆会在当天举办庆祝活动。2019年11月2

机器学习中的分类问题:如何选择和理解性能衡量标准

对于这些问题,我们需要一种方式来评估模型的性能,以便选择最合适的模型、调整参数,并最终在实际应用中做出可靠的决策。不同的问题可能需要不同的度量标准。绘制这两种曲线的过程相似,通常需要使用模型的预测概率来确定不同的阈值,并计算相应的性能指标。ROC曲线是另一种用于评估分类模型性能的工具,它关注的是模型

前向传播(Forward Propagation)与反向传播(Back Propagation)举例

前向传播(Forward Propagation)与反向传播(Back Propagation)

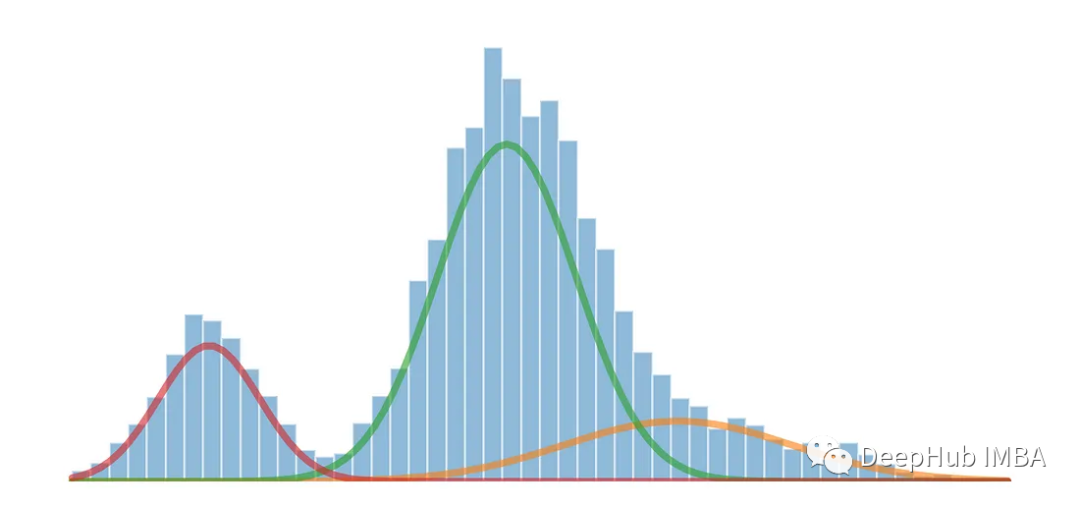

使用高斯混合模型拆分多模态分布

本文介绍如何使用高斯混合模型将一维多模态分布拆分为多个分布。

从AI 大模型到 AGI 通用人工智能 “世界模型”的演进路径

从AI人工智能到通用人工智能的演进,是一个不断探索和拓展智慧边界的过程。大型语言模型作为当前AI技术的代表,为我们提供了一个理解和生成语言的强大工具。然而,要实现通用人工智能,我们还需要构建更为复杂和完善的世界模型,模拟人类的认知和行为能力。通过研究和实践,我们相信通用人工智能终将成为现实,为人类带

【人工智能的数学基础】二进制乘法的Mitchell近似

使用Mitchell近似构造加法神经网络.本文通过近似算法将乘法运算转变为加法运算,从而降低了神经网络中的乘法的运算量。

9月人工智能论文和项目推荐

因为LLM的火爆,所以最近的论文都是和LLM相关的

人工智能中的数学基础

人工智能(AI)是一项涉及多个领域的技术,其中数学基础是其中一个重要的组成部分。数学在AI中扮演了重要的角色,它提供了AI算法的核心思想和理论基础。在谈论数学在AI中的应用之前,我们需要先了解一些基本概念。数学是一种用符号、公式和算法描述自然现象和抽象概念的语言。数学的应用非常广泛,包括自然科学、社

AquilaChat-7B: 国产开源大模型新成员——AI领域的创新型研发机构智源人工智能研究院出品

Aquila语言大模型在技术上继承了GPT-3、LLaMA等的架构设计优点,替换了一批更高效的底层算子实现、重新设计实现了中英双语的tokenizer,升级了BMTrain并行训练方法,在Aquila的训练过程中实现了比Magtron+DeepSpeed zero-2将近8倍的训练效率。Aquila

【人工智能】AGI 通用人工智能基础概念、实现原理、挑战和发展前景

随着计算机技术、机器学习和神经网络等技术的发展,人工智能(Artificial Intelligence, AI)已经成为当今计算机科学和工程领域的热门话题之一。强人工智能(Strong AI)或通用人工智能(英语:Artificial General Intelligence)是具备与人类同等智慧

人类智能的本质、模型和原理——看了这么多AI人工智能,你有没有思考过到底什么才是 HI 人类智能?

人类智力是一种复杂的现象,涉及到许多不同的领域,包括心理学、神经科学、计算机科学等。数学模型和物理模型是研究人类智力的两个重要工具,可以帮助我们更好地理解人类智力的本质和机制。本文将分别介绍人类智能的本质和背后的数学模型和物理模型,探讨它们在研究人类智力中的作用和应用。

d2l的一些理论知识的整理【1】

我们可以通过基本层类设计自定义层。这允许我们定义灵活的新层,其行为与深度学习框架中的任何现有层不同。在自定义层定义完成后,我们就可以在任意环境和网络架构中调用该自定义层。层可以有局部参数,这些参数可以通过内置函数创建。

常用的19道人工智能面试题,作为人工智能工程师,你知道多少?

答案:人工智能(Artificial Intelligence,简称AI)是一种模拟人类智能的技术和科学。它涉及到各种领域,包括机器学习、自然语言处理、计算机视觉、语音识别、决策树等。人工智能的目标是让计算机具备类似于人类的智能,能够自主地思考、学习、推理和决策。人工智能的应用范围非常广泛,包括智能

智能算法系列之基于粒子群优化的模拟退火算法

本篇是[智能算法(Python复现)]专栏的第四篇文章,主要介绍粒子群优化算法与模拟退火算法的结合,以弥补各自算法之间的不足。

【人工智能】基础模型(Foundation Models)的机遇与风险

近几年,预训练模型受到了学术界及工业界的广泛关注,对预训练语言模型的大量研究和应用也推动了自然语言处理新范式的产生和发展,进而影响到整个人工智能的研究和应用。近期,由斯坦福大学众多学者联合撰写的文章《On the Opportunities and Risks of Foundation Model

DataWhale 机器学习夏令营第二期——AI量化模型预测挑战赛 学习记录

DataWhale 机器学习夏令营第二期——AI量化模型预测挑战赛

【人工智能】Softmax 函数基础介绍、应用场景、优缺点、代码实现

在机器学习中,softmax函数是一种用于多项式分类问题的激活函数,它将一个K维向量转换为K个范围在[0,1]之间且总和为1的概率分布。它通常被用于将最后一层的输出映射到一个概率分布上,从而使得分类器可以预测每一类的概率。Softmax函数是一个非常有用的激活函数,它可以将实数向量转换为概率分布,并

人工智能中数学基础:线性代数,解析几何和微积分

在人工智能领域,线性代数、解析几何和微积分是最基础的数学知识。这些数学知识不仅在人工智能领域中被广泛应用,也是其他领域的重要基础。本文将介绍人工智能中的线性代数、解析几何和微积分的基础知识和应用。

快速找到离群值的三种方法

本文将介绍3个在数据集中查找离群值的Python方法