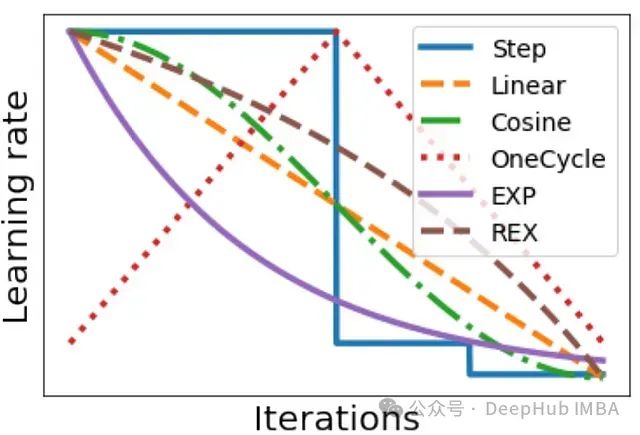

深度学习中的学习率调度:循环学习率、SGDR、1cycle 等方法介绍及实践策略研究

深度学习实践者都知道,在训练神经网络时,正确设置学习率是使模型达到良好性能的关键因素之一。学习率通常会在训练过程中根据某种调度策略进行动态调整。调度策略的选择对训练质量也有很大影响。

过采样与欠采样技术原理图解:基于二维数据的常见方法效果对比

本文详细探讨了在不平衡数据集上进行分类任务时常用的过采样和欠采样技术。通过二维数据可视化示例,直观展现了各类采样方法的原理和效果差异。

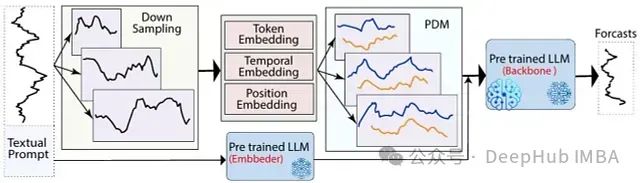

LLM-Mixer: 融合多尺度时间序列分解与预训练模型,可以精准捕捉短期波动与长期趋势

LLM-Mixer通过结合多尺度时间序列分解和预训练的LLMs,提高了时间序列预测的准确性。它利用多个时间分辨率有效地捕捉短期和长期模式,增强了模型的预测能力

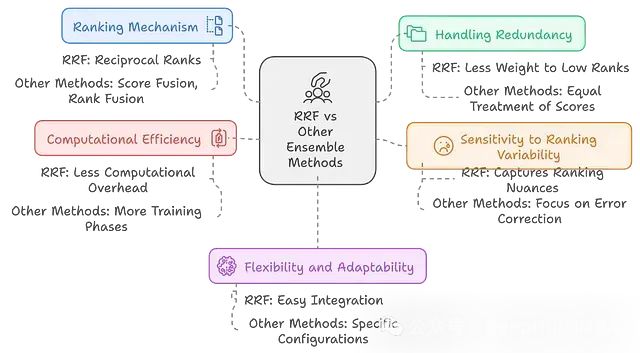

RAPTOR:多模型融合+层次结构 = 检索性能提升20%,结果还更稳健

RAPTOR通过结合多个检索模型,构建层次化的信息组织结构,并采用递归摘要等技术,显著提升了检索系统的性能和适应性。

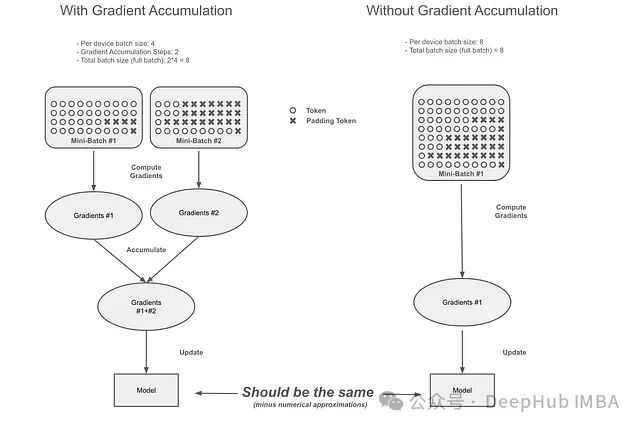

梯度累积的隐藏陷阱:Transformer库中梯度累积机制的缺陷与修正

本文将从以下几个方面展开讨论:首先阐述梯度累积的基本原理,通过实例说明问题的具体表现和错误累积过程;其次分析不同训练场景下该问题的影响程度;最后评估Unsloth提出并已被Hugging Face在Transformers框架中实现的修正方案的有效性。

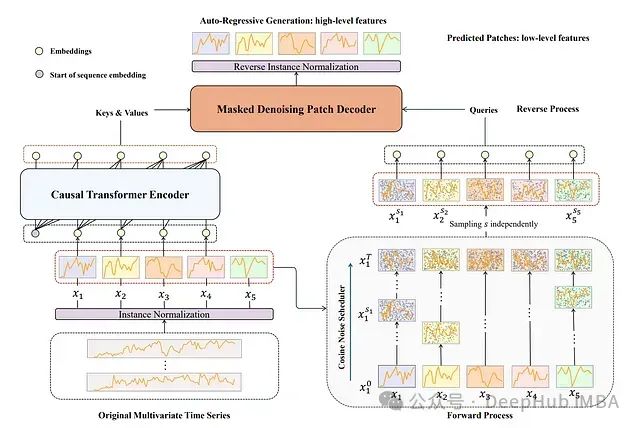

TimeDART:基于扩散自回归Transformer 的自监督时间序列预测方法

TimeDART是一种专为**时间序列预测**设计的自**监督学习**方法。它的核心思想是通过从时间序列历史数据中学习模式来改进未来数据点的预测。

11种经典时间序列预测方法:理论、Python实现与应用

本文将总结11种经典的时间序列预测方法,并提供它们在Python中的实现示例。

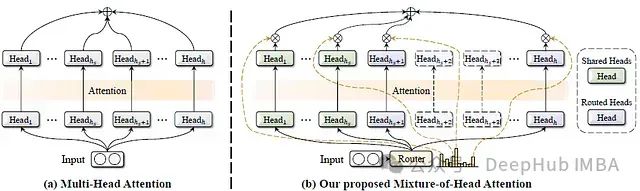

MoH:融合混合专家机制的高效多头注意力模型及其在视觉语言任务中的应用

这篇论文提出了一种名为混合头注意力(Mixture-of-Head attention, MoH)的新架构,旨在提高注意力机制的效率,同时保持或超越先前的准确性水平。

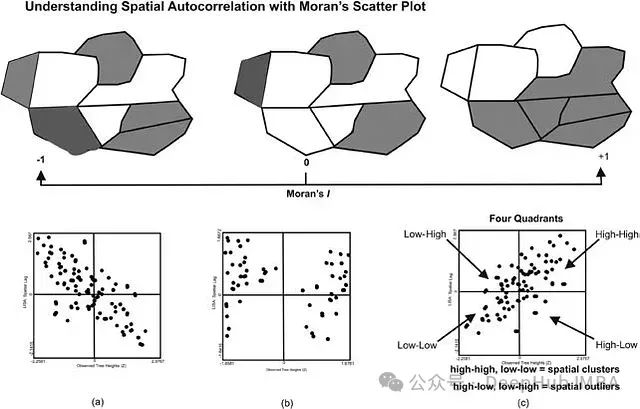

机器学习中空间和时间自相关的分析:从理论基础到实践应用

空间和时间自相关是数据分析中的两个基本概念,它们揭示了现象在空间和时间维度上的相互依赖关系。

特征工程在营销组合建模中的应用:基于因果推断的机器学习方法优化渠道效应估计

因果推断方法为特征工程提供了一个更深层次的框架,使我们能够区分真正的因果关系和简单的统计相关性。

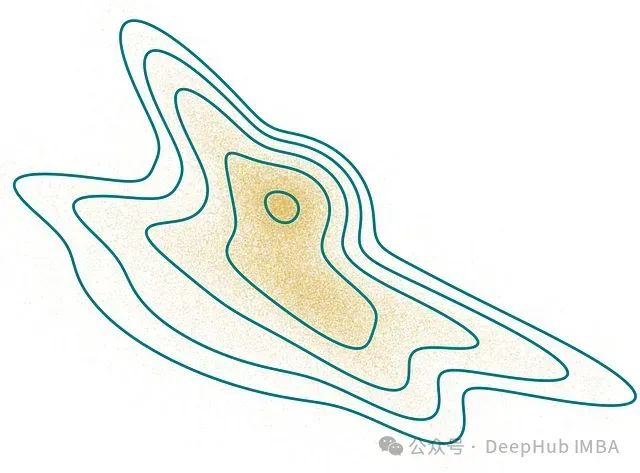

lintsampler:高效从任意概率分布生成随机样本的新方法

``` lintsampler ``` 是一个纯Python实现的库,能够高效地从任意概率分布中生成随机样本。

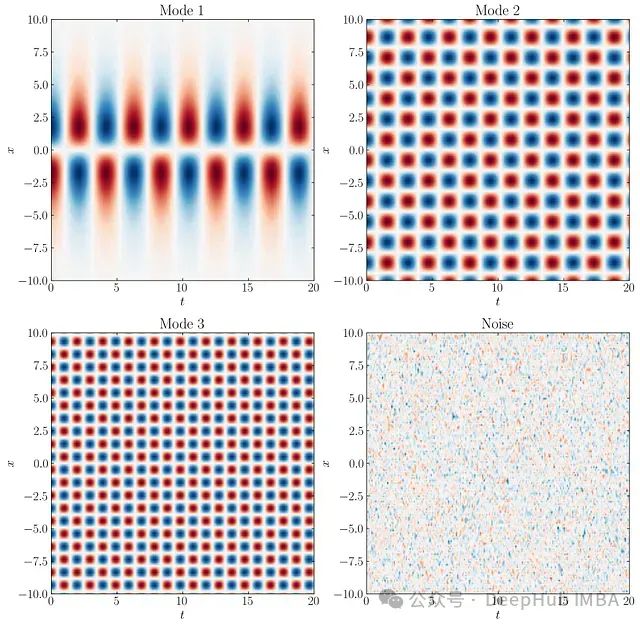

基于OpenFOAM和Python的流场动态模态分解:从数据提取到POD-DMD分析

本文探讨了Python脚本与动态模态分解(DMD)的结合应用。我们将利用Python对从OpenFOAM模拟中提取的二维切片数据进行DMD计算。这种方法能够有效地提取隐藏的流动模式,深化对流体动力学现象的理解。

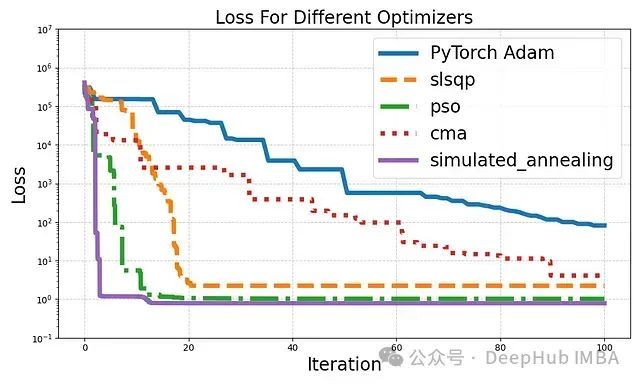

如果你的PyTorch优化器效果欠佳,试试这4种深度学习中的高级优化技术吧

在深度学习领域,优化器的选择对模型性能至关重要。

信息论、机器学习的核心概念:熵、KL散度、JS散度和Renyi散度的深度解析及应用

本文深入探讨了信息论、机器学习和统计学中的几个核心概念:熵、KL散度、Jensen-Shannon散度和Renyi散度。这些概念不仅是理论研究的基石,也是现代数据分析和机器学习应用的重要工具。

数据准备指南:10种基础特征工程方法的实战教程

特征工程是将原始数据转化为更具信息量的特征的过程。本文将详细介绍十种基础特征工程技术,包括其基本原理和实现示例。

三种Transformer模型中的注意力机制介绍及Pytorch实现:从自注意力到因果自注意力

本文深入探讨Transformer模型中三种关键的注意力机制:自注意力、交叉注意力和因果自注意力。我们不仅会讨论理论概念,还将使用Python和PyTorch从零开始实现这些注意力机制。

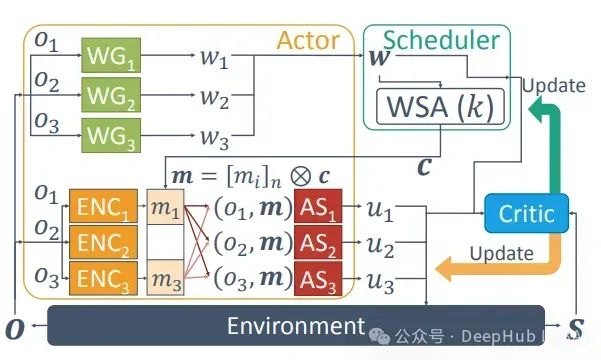

多代理强化学习综述:原理、算法与挑战

多代理强化学习是强化学习的一个子领域,专注于研究在共享环境中共存的多个学习代理的行为。每个代理都受其个体奖励驱动,采取行动以推进自身利益

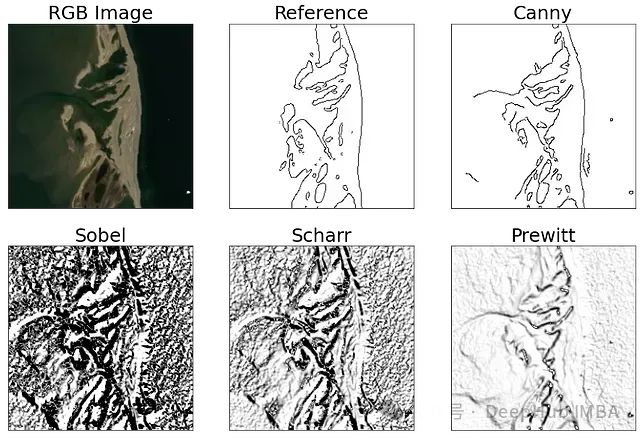

边缘检测评估方法:FOM、RMSE、PSNR和SSIM对比实验和理论研究

本文通过理论分析和实证实验,明确展示了FOM在边缘检测评估中的优越性。相比之下,RMSE、PSNR和SSIM在这一任务中表现出明显的局限性。

稀疏促进动态模态分解(SPDMD)详细介绍以及应用

在机器学习和人工智能领域,SPDMD的应用场景广泛。它可用于图像处理和计算机视觉中的特征提取和降维.在时间序列分析中,SPDMD可以识别复杂数据中的主要趋势和周期性模式

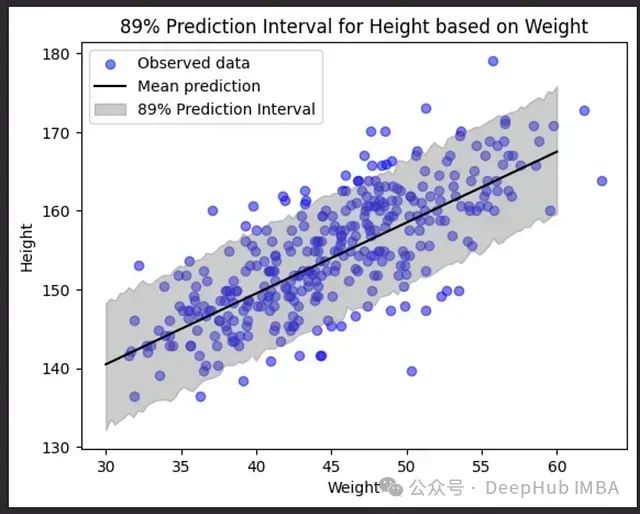

贝叶斯线性回归:概率与预测建模的融合

贝叶斯线性回归提供了一个强大的框架,用于理解和量化变量之间的关系。通过引入先验分布和考虑参数的不确定性,这种方法不仅能给出点估计,还能提供完整的后验分布,从而更全面地描述我们的知识状态。