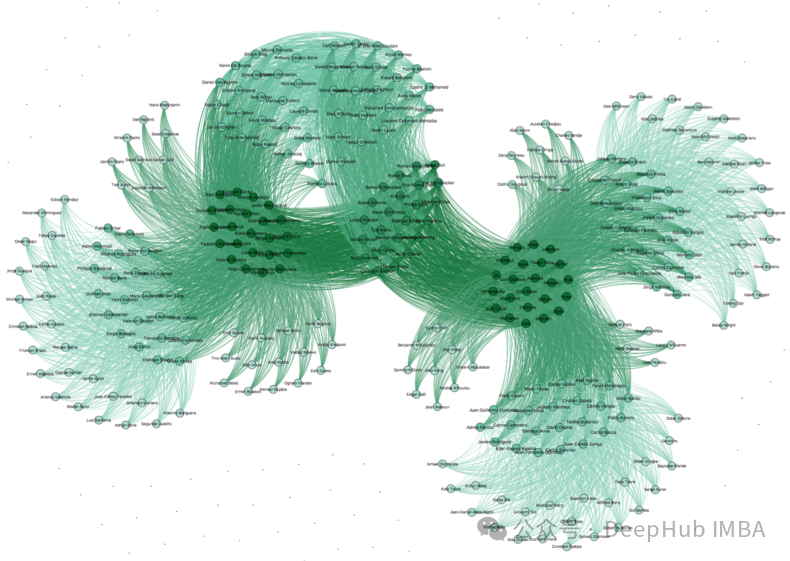

使用 PyTorch-BigGraph 构建和部署大规模图嵌入的完整教程

本文深入探讨了使用 PyTorch-BigGraph (PBG) 构建和部署大规模图嵌入的完整流程,涵盖了从环境设置、数据准备、模型配置与训练,到高级优化技术、评估指标、部署策略以及实际案例研究等各个方面。

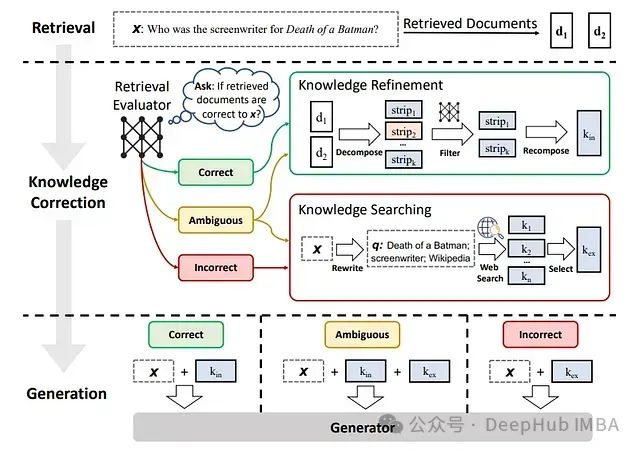

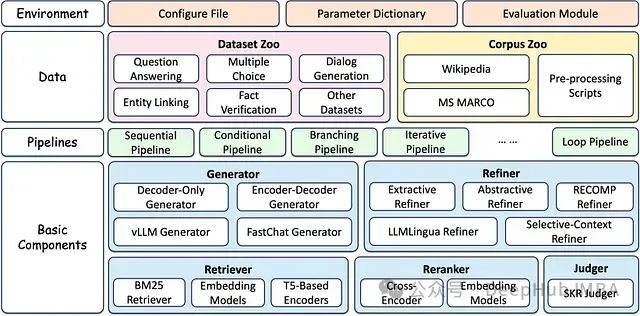

25 个值得关注的检索增强生成 (RAG) 模型和框架

本文深入探讨 25 种先进的 RAG 变体,每一种都旨在优化检索和生成过程的特定方面。从标准实现到专用框架,这些变体涵盖了成本限制、实时交互和多模态数据集成等问题,展示了 RAG 在提升 NLP 能力方面的多功能性和潜力。

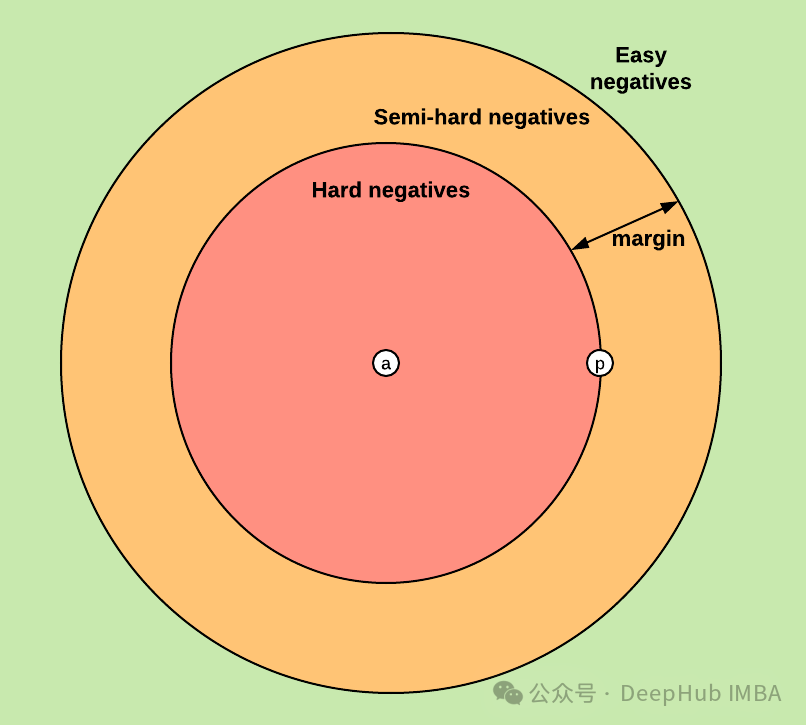

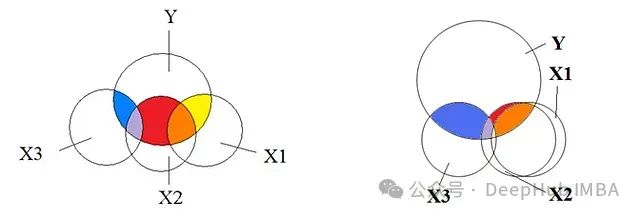

利用PyTorch的三元组损失Hard Triplet Loss进行嵌入模型微调

本文介绍如何使用 PyTorch 和三元组边缘损失 (Triplet Margin Loss) 微调嵌入模型,并重点阐述实现细节和代码示例

告别Print,使用IceCream进行高效的Python调试

本文将介绍**IceCream**库,这个专门用于调试的工具显著提升了调试效率,使整个过程更加系统化和规范化。

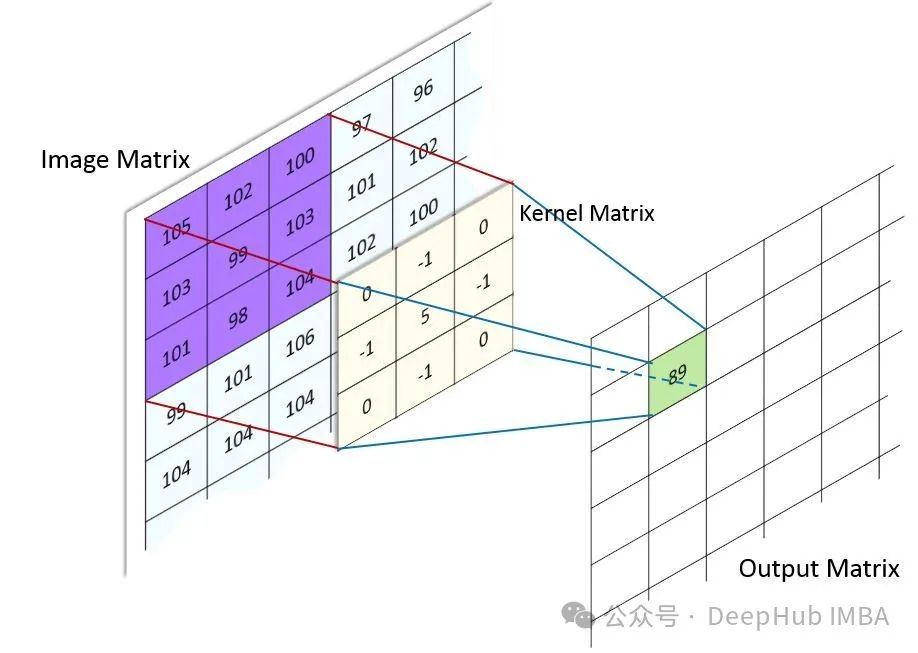

为什么卷积现在不火了:CNN研究热度降温的深层原因分析

纵观近年的顶会论文和研究热点,我们不得不承认一个现实:CNN相关的研究论文正在减少,曾经的"主角"似乎正逐渐淡出研究者的视野。

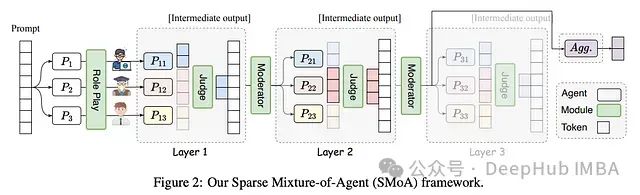

SMoA: 基于稀疏混合架构的大语言模型协同优化框架

通过引入稀疏化和角色多样性,SMoA为大语言模型多代理系统的发展开辟了新的方向。

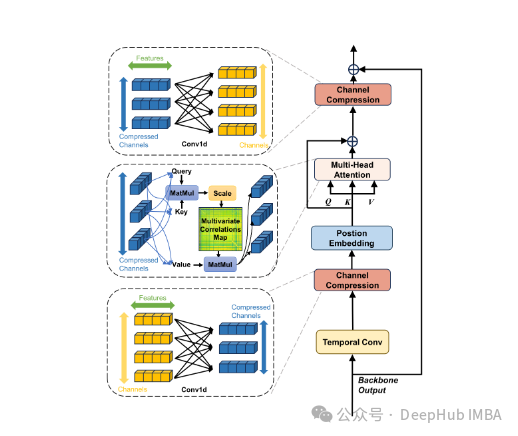

TSMamba:基于Mamba架构的高效时间序列预测基础模型

TSMamba通过其创新的架构设计和训练策略,成功解决了传统时间序列预测模型面临的多个关键问题。

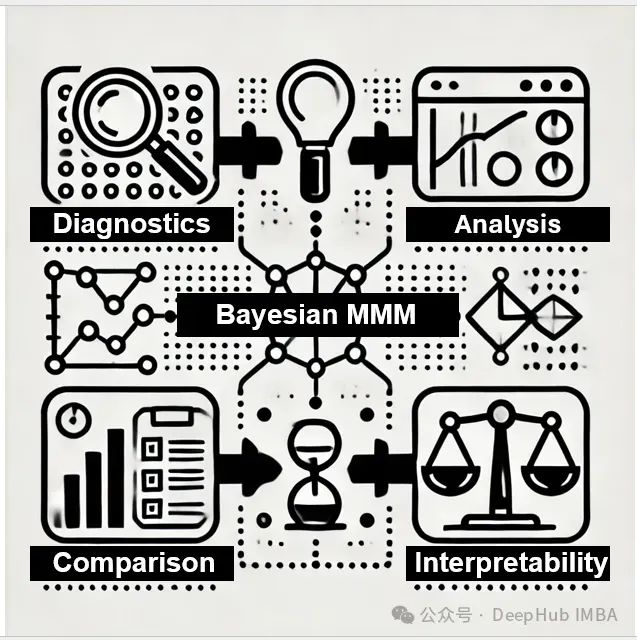

基于MCMC的贝叶斯营销组合模型评估方法论: 系统化诊断、校准及选择的理论框架

贝叶斯营销组合建模(Bayesian Marketing Mix Modeling,MMM)作为一种先进的营销效果评估方法,其核心在于通过贝叶斯框架对营销投资的影响进行量化分析。

深度学习工程实践:PyTorch Lightning与Ignite框架的技术特性对比分析

在深度学习框架的选择上,PyTorch Lightning和Ignite代表了两种不同的技术路线。本文将从技术实现的角度,深入分析这两个框架在实际应用中的差异,为开发者提供客观的技术参考。

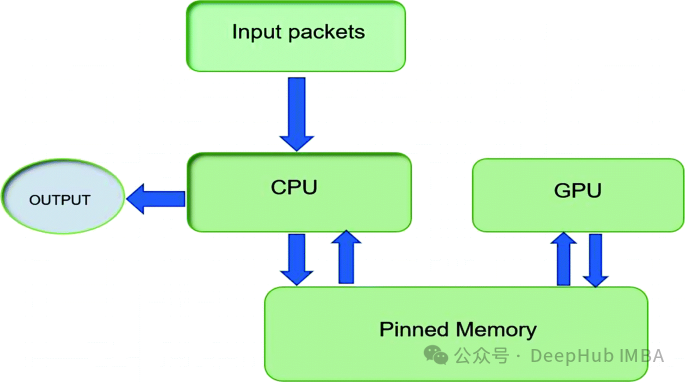

通过pin_memory 优化 PyTorch 数据加载和传输:工作原理、使用场景与性能分析

本文将深入探讨何时以及为何启用这一设置,帮助你优化 PyTorch 中的内存管理和数据吞吐量。

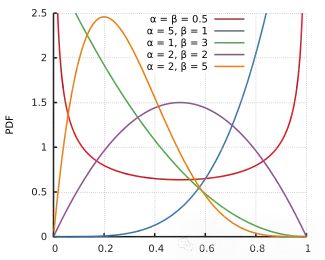

贝叶斯统计中常见先验分布选择方法总结

本文详细介绍了贝叶斯统计中三种常见的先验分布选择方法:经验贝叶斯方法、信息先验和无信息/弱信息先验。

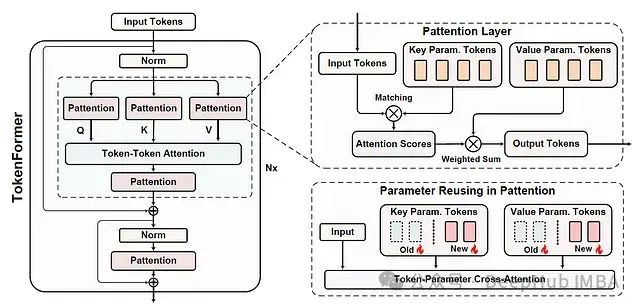

Tokenformer:基于参数标记化的高效可扩展Transformer架构

本文是对发表于arXiv的论文 "TOKENFORMER: RETHINKING TRANSFORMER SCALING WITH TOKENIZED MODEL PARAMETERS" 的深入解读与扩展分析。

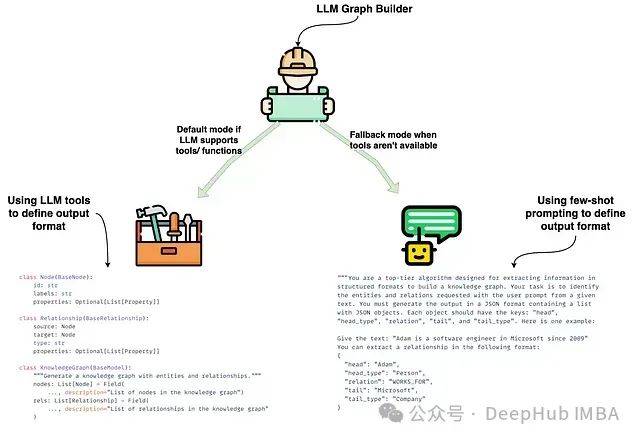

基于LLM Graph Transformer的知识图谱构建技术研究:LangChain框架下转换机制实践

本文是LangChain的一个代码贡献者编写的文章,将对这些内容进行详细介绍,文章最后还包含了作者提供的源代码

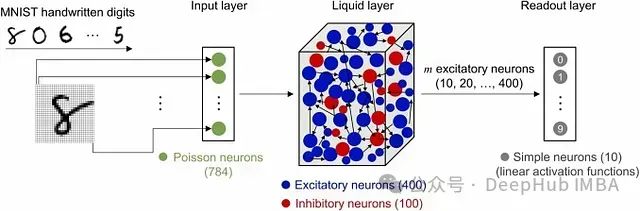

基于Liquid State Machine的时间序列预测:利用储备池计算实现高效建模

**Liquid State Machine (LSM)** 是一种 **脉冲神经网络 (Spiking Neural Network, SNN)** ,在计算神经科学和机器学习领域中得到广泛应用,特别适用于处理 **时变或动态数据**。

深入理解多重共线性:基本原理、影响、检验与修正策略

本文将深入探讨多重共线性的本质,阐述其重要性,并提供有效处理多重共线性的方法,同时避免数据科学家常犯的陷阱。

基于PyTorch的大语言模型微调指南:Torchtune完整教程与代码示例

**Torchtune**是由PyTorch团队开发的一个专门用于LLM微调的库。它旨在简化LLM的微调流程,提供了一系列高级API和预置的最佳实践,使得研究人员和开发者能够更加便捷地对LLM进行调试、训练和部署。

10种数据预处理中的数据泄露模式解析:识别与避免策略

当测试数据在数据准备阶段无意中泄露(渗透)到训练数据时,就会发生数据泄露。这种情况经常出现在常规数据处理任务中,而你可能并未察觉。当泄露发生时,模型会从本不应看到的测试数据中学习,导致测试结果失真。

随机性、熵与随机数生成器:解析伪随机数生成器(PRNG)和真随机数生成器(TRNG)

本文将探讨随机性、熵的概念以及不同类型随机数生成器(random number generator, RNG)的原理,重点介绍伪随机数生成器(PRNG)和真随机数生成器(TRNG)。

Github上的十大RAG(信息检索增强生成)框架

随着对先进人工智能解决方案需求的不断增长,GitHub上涌现出众多开源RAG框架,每一个都提供了独特的功能和特性。

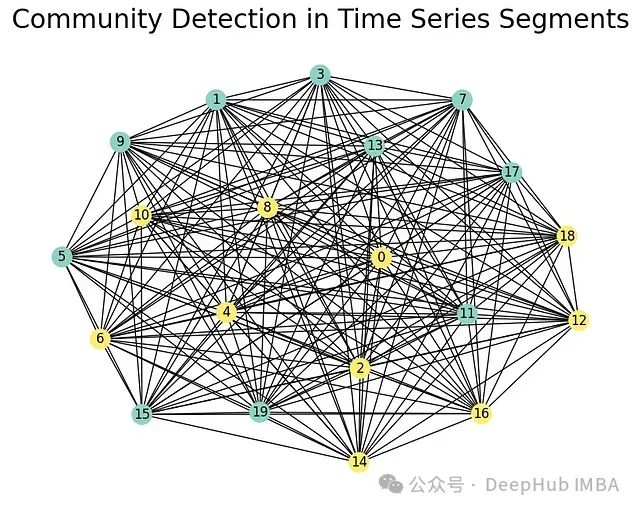

基于图论的时间序列数据平稳性与连通性分析:利用图形、数学和 Python 揭示时间序列数据中的隐藏模式

在本文中,我们将探讨图论如何洞察时间关系和平稳性,将介绍基于图的变换的基本概念,讨论时间序列数据的平稳性,并展示如何应用这些概念。