使用 Python TorchRL 进行多代理强化学习

本文将深入探讨如何使用 TorchRL 解决 MARL 问题,重点关注多代理环境中的近端策略优化(PPO)。

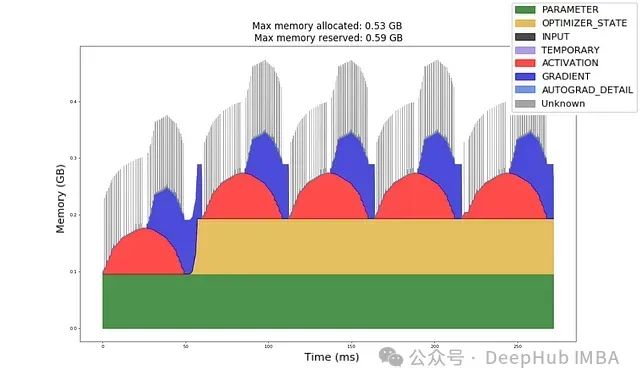

深入理解GPU内存分配:机器学习工程师的实用指南与实验

给定一个模型架构、数据类型、输入形状和优化器,你能否计算出前向传播和反向传播所需的GPU内存量?

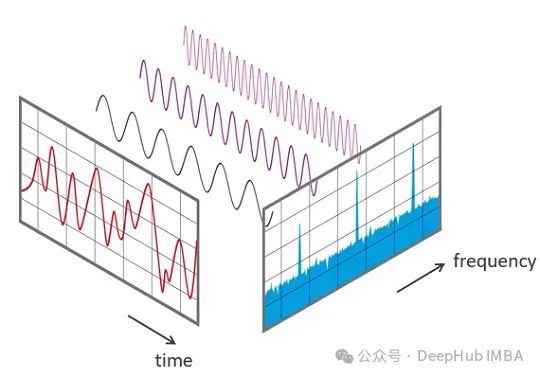

时间序列特征提取:从理论到Python代码实践

**时间序列**是一种特殊的存在。这意味着你对表格数据或图像进行的许多转换/操作/处理技术对于时间序列来说可能根本不起作用。

高效的时间序列可视化:减少认知负荷获得更清晰的洞察

在本文中,我们将探讨使真实世界的**疫苗接种数据**来可视化单个时间序列和多个时间序列。

XGBoost中正则化的9个超参数

正则化是一种强大的技术,通过防止过拟合来提高模型性能。本文将探索各种XGBoost中的正则化方法及其优势。

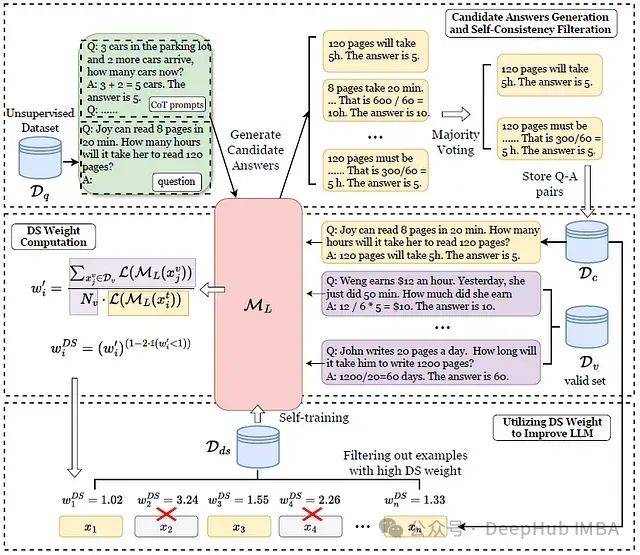

基于重要性加权的LLM自我改进:考虑分布偏移的新框架

在这篇论文中,证明过滤掉正确但具有高分布偏移程度(DSE)的样本也可以有利于自我改进的结果。

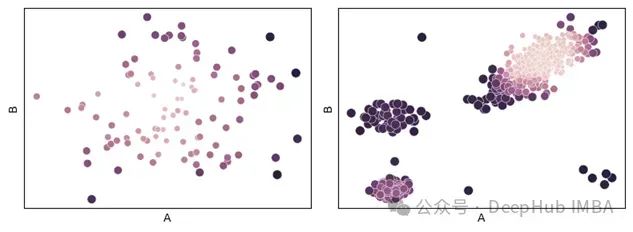

基于距离度量学习的异常检测:一种通过相关距离度量的异常检测方法

但在本文中,将一种非常通用且可能未被充分使用的方法,用于计算表格数据中两条记录之间的差异,这对异常检测非常有用,称为*距离度量学习* - 以及一种专门应用于异常检测的方法。

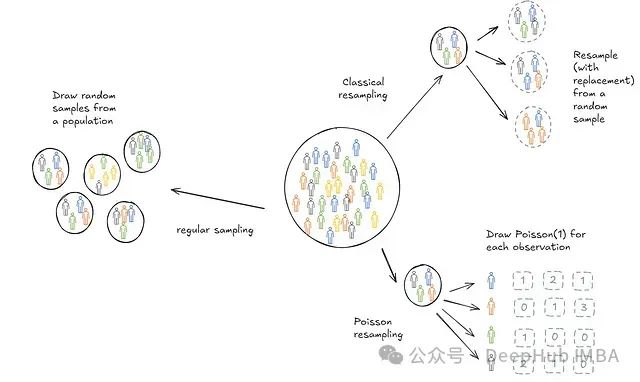

泊松自助法(Poisson Bootstrap Sampling):大型数据集上的自助抽样

泊松自助抽样(Poisson Bootstrap Sampling)是一种用于统计分析中的重采样技术,特别是在机器学习和数据科学中用于模型评估和误差估计。

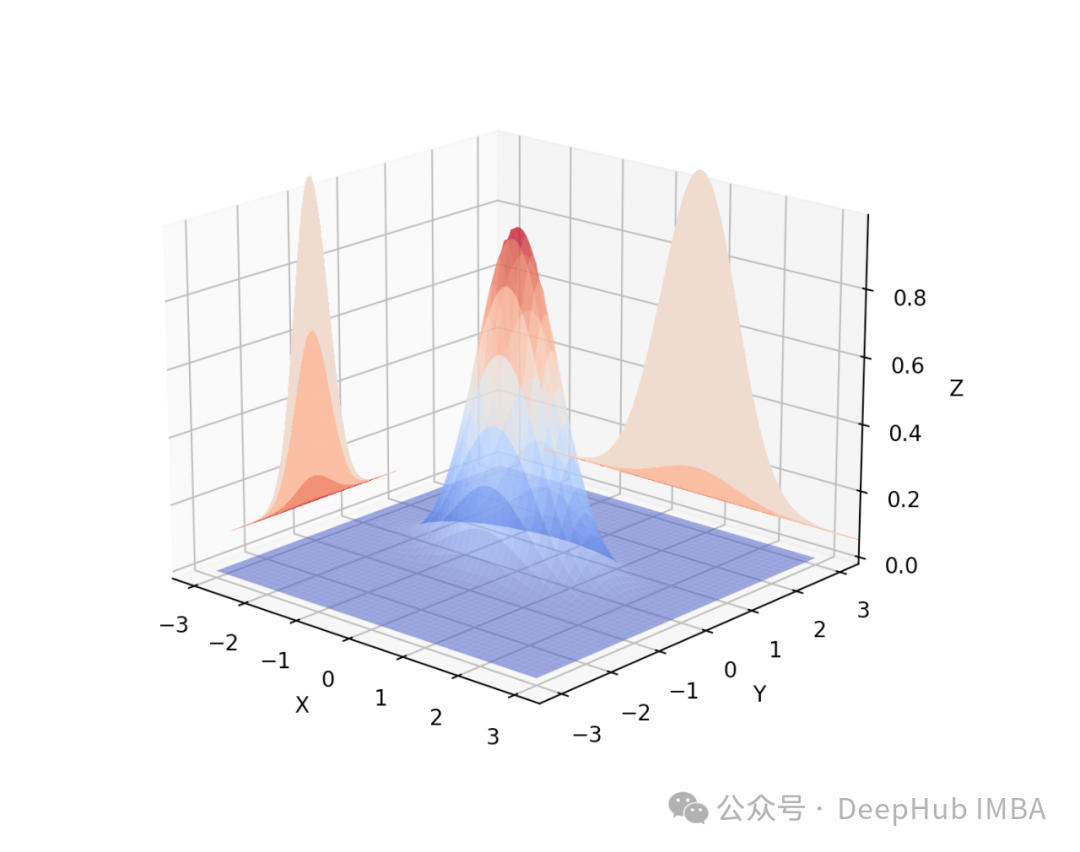

深入理解双变量(二元)正态投影:理论基础、直观解释与应用实例

二元投影有助于确定在给定另一个变量的特定值时的一个随机变量的期望值。例如,在线性回归中,投影有助于估计因变量如何随自变量变化而变化。

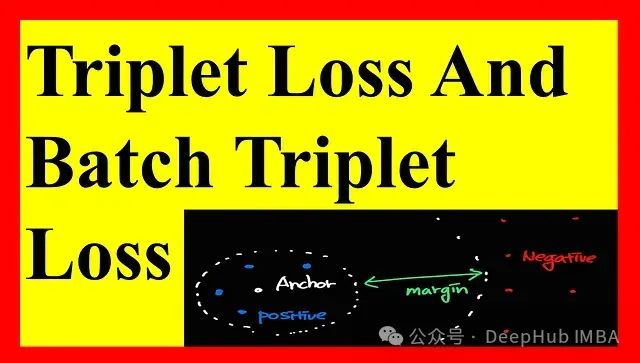

三元组损失Triplet loss 详解

在这篇文章中,我们将以简单的技术术语解析三元组损失及其变体批量三元组损失,并提供一个相关的例子来帮助你理解这些概念。

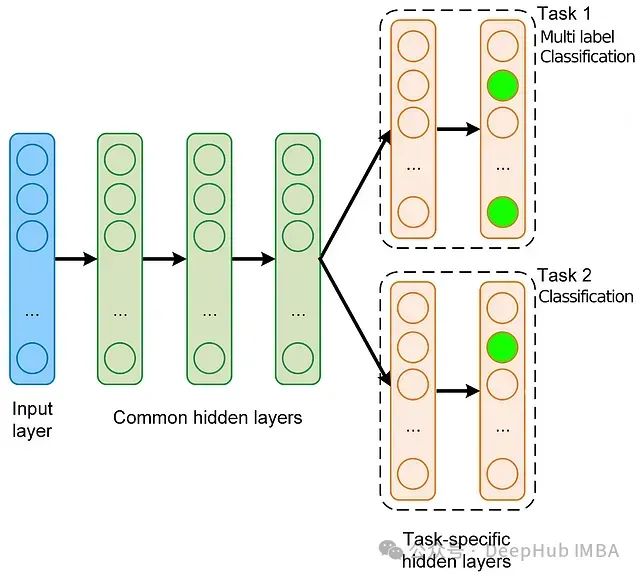

深度学习实战:手把手教你构建多任务、多标签模型

在本文中,我们将基于流行的 MovieLens 数据集,使用稀疏特征来创建一个多任务多标签模型,并逐步介绍整个过程。所以本文将涵盖数据准备、模型构建、训练循环、模型诊断,最后使用 Ray Serve 部署模型的全部流程。

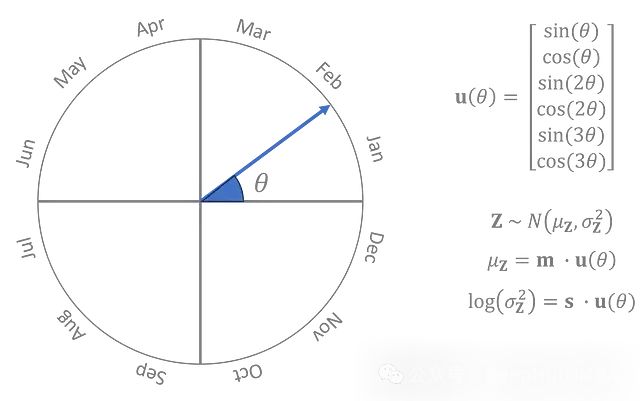

将VAE用于时间序列:生成时间序列的合成数据

本文将使用**一维卷积层**、**策略性的步幅选择**、**灵活的时间维度**和**季节性依赖的先验**来模拟温度数据。

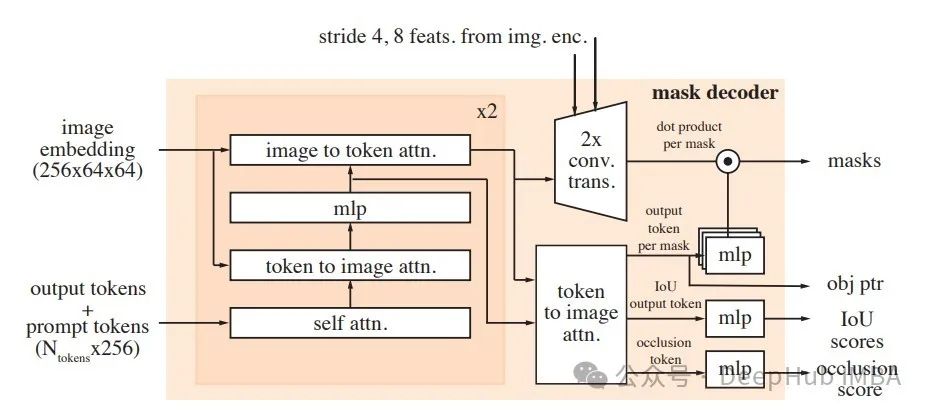

60行代码就可以训练/微调 Segment Anything 2 (SAM 2)

本文演示了如何在仅60行代码内(不包括标注和导入)对SAM2进行微调。

音频去噪:使用Python和FFT增强音质

声音去噪目标是改善聆听体验以及音频分析和处理的准确性。过滤掉噪音对于高保真音频来说非常重要,不仅是为了聆听,也是为了创建某些机器学习任务的数据集。

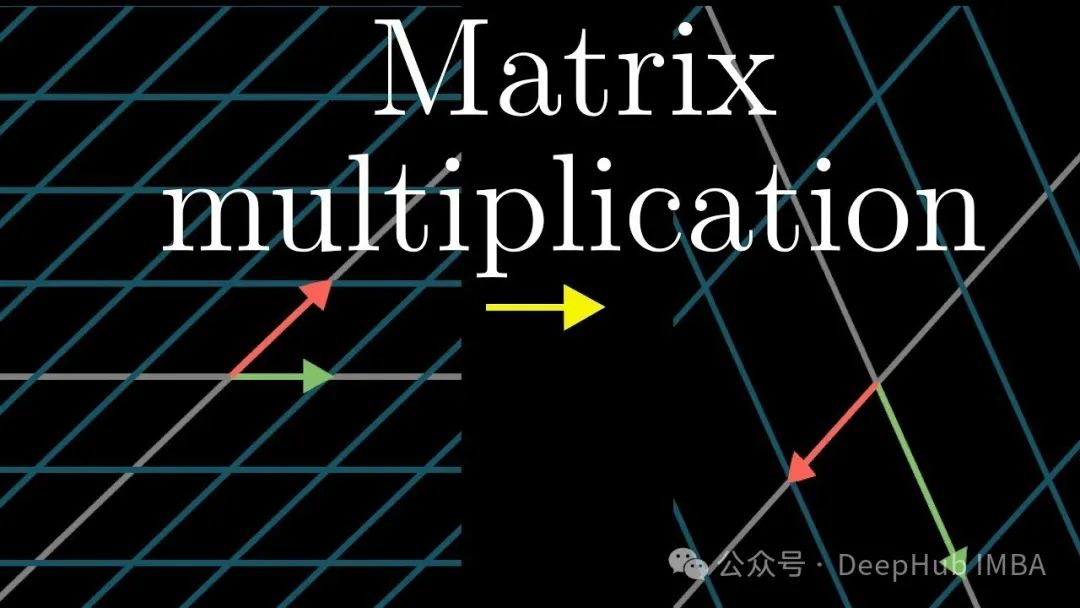

掌握 PyTorch 张量乘法:八个关键函数与应用场景对比解析

PyTorch提供了几种张量乘法的方法,每种方法都是不同的,并且有不同的应用。我们来详细介绍每个方法,并且详细解释这些函数有什么区别:

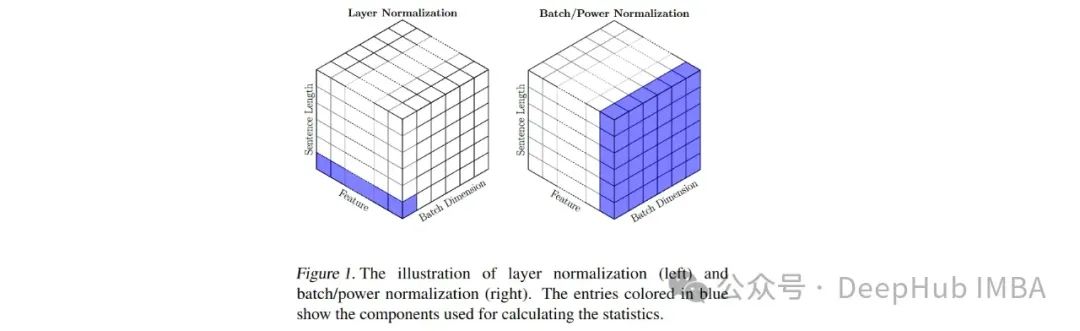

使用BatchNorm替代LayerNorm可以减少Vision Transformer训练时间和推理时间

本文我们将详细探讨ViT的一种修改,这将涉及用批量归一化(BatchNorm)替换层归一化(LayerNorm) - transformer的默认归一化技术。

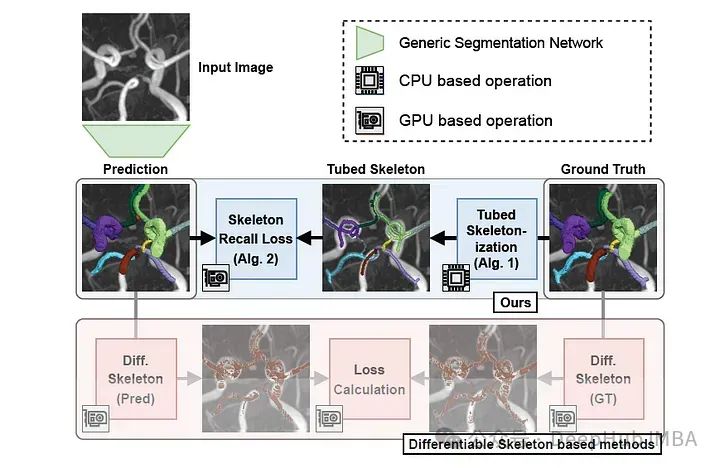

Skeleton Recall Loss 分割领域的新突破:极大的减少了资源消耗,还能提高性能

这篇论文则介绍了一个新的损失:Skeleton Recall Loss,我把它翻译成骨架召回损失.这个损失目前获得了最先进的整体性能,并且通过取代密集的计算**他的计算开销减少超过90% !**

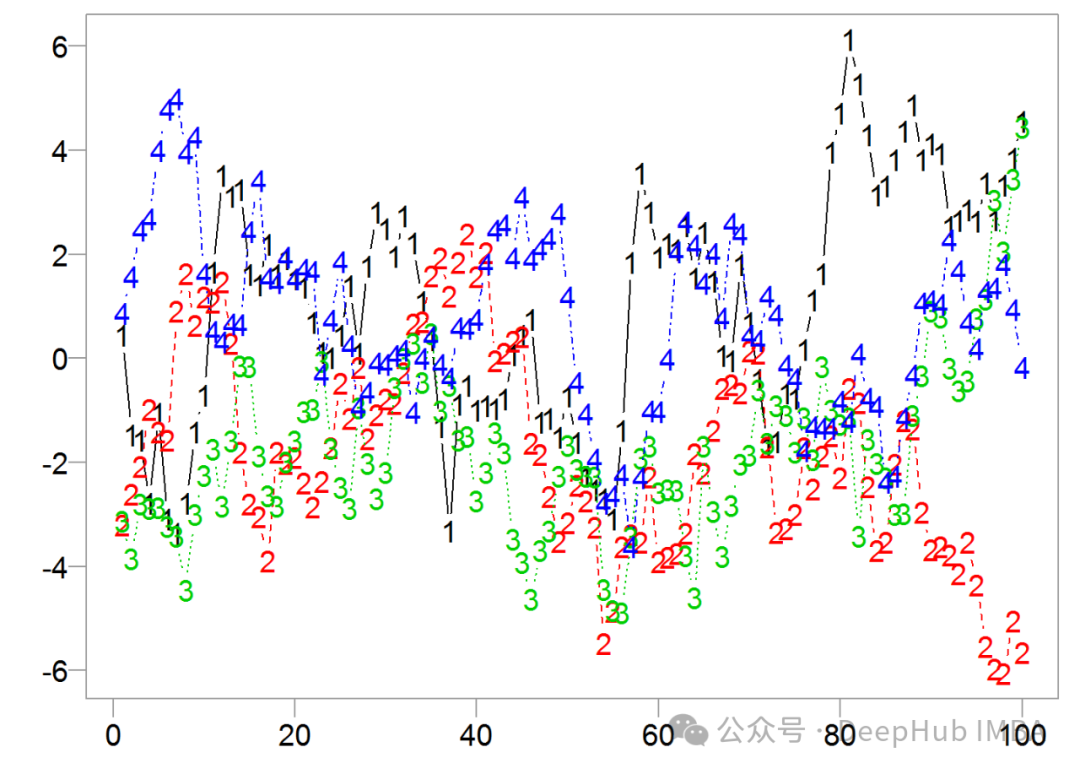

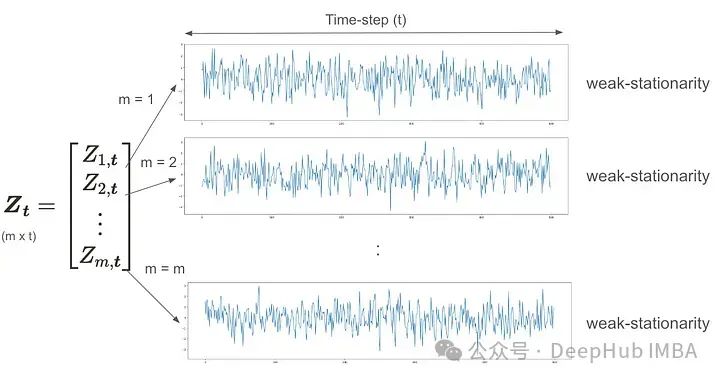

多元时间序列分析统计学基础:基本概念、VMA、VAR和VARMA

在这文章我们将通过可视化和Python实现来学习多元时间序列概念。这里假设读者已经了解单变量时间序列分析。

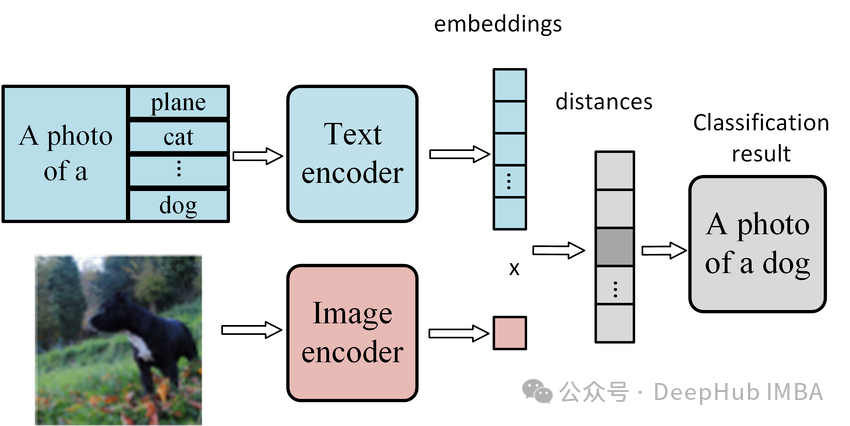

使用CLIP模型进行零样本图像分类的分步指南

我们首先介绍零样本学习的概念及其在现代AI应用中的重要性