DeepSeek × 时间序列 :DeepSeek-TS,基于状态空间增强MLA与GRPO的时序预测新框架

本文介绍 DeepSeek-TS,该框架受到 DeepSeek 中高效的多头潜在注意力(MLA)和群组相对策略优化(GRPO)技术的启发,并将其应用于多产品时间序列预测。

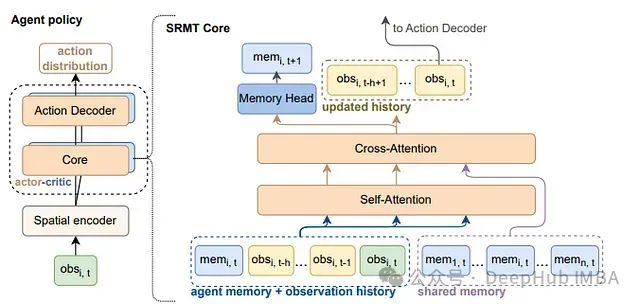

SRMT:一种融合共享记忆与稀疏注意力的多智能体强化学习框架

本研究将系统阐述**SRMT的技术架构、核心功能、应用场景及实验数据**,深入分析其在**多智能体强化学习(MARL)**领域的技术优势。

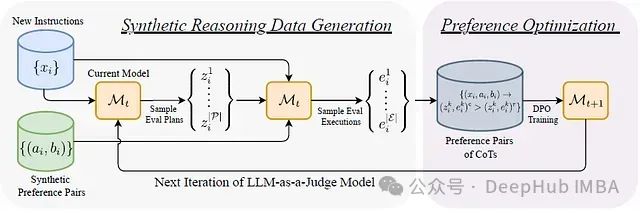

EvalPlanner:基于“计划-执行”双阶段的大语言模型评估框架

EvalPlanner[1],这是一种创新的LLM评估算法。该算法采用计划-执行的双阶段范式,首先生成无约束的评估计划,随后执行该计划并做出最终判断。这种方法显著提升了评估过程的系统性和可靠性。

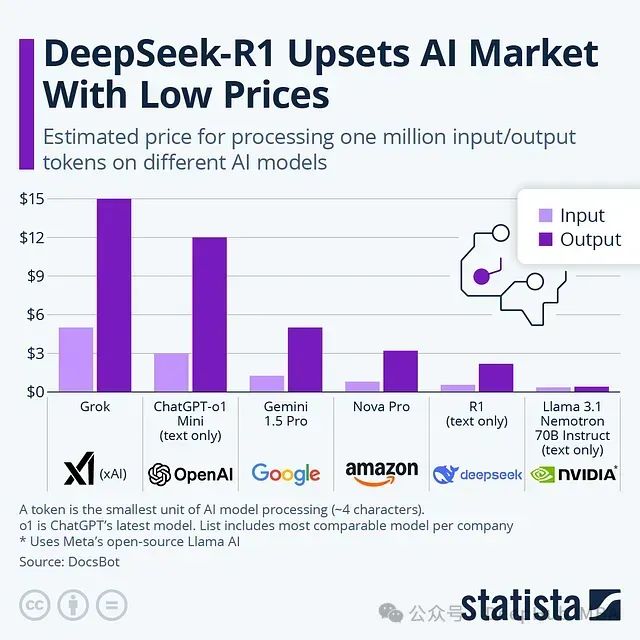

DeepSeek技术报告解析:为什么DeepSeek-R1 可以用低成本训练出高效的模型

DeepSeek-R1 通过创新的训练策略实现了显著的成本降低,同时保持了卓越的模型性能。本文将详细分析其核心训练方法。

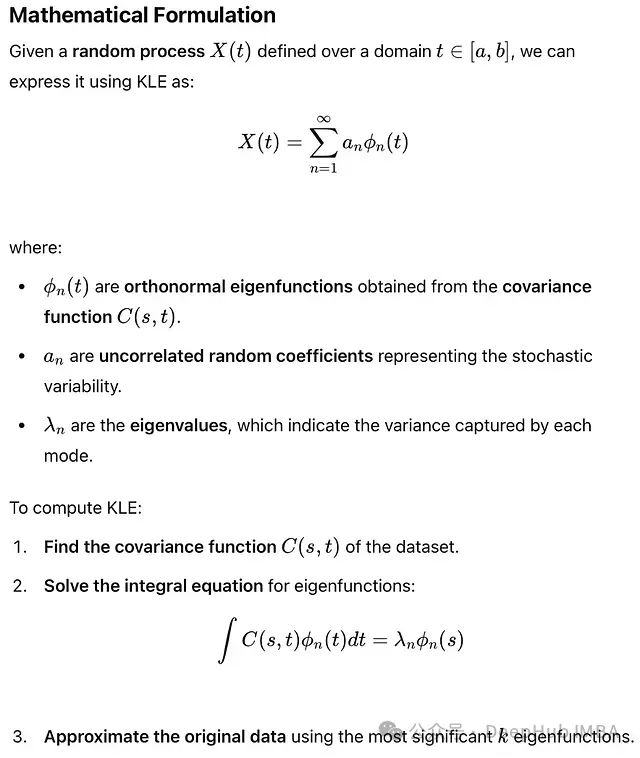

数据降维技术研究:Karhunen-Loève展开与快速傅里叶变换的理论基础及应用

在现代科学计算和数据分析领域,数据降维与压缩技术对于处理高维数据具有重要意义。

PyTorch生态系统中的连续深度学习:使用Torchdyn实现连续时间神经网络

神经常微分方程(Neural ODEs)是深度学习领域的创新性模型架构,它将神经网络的离散变换扩展为连续时间动力系统

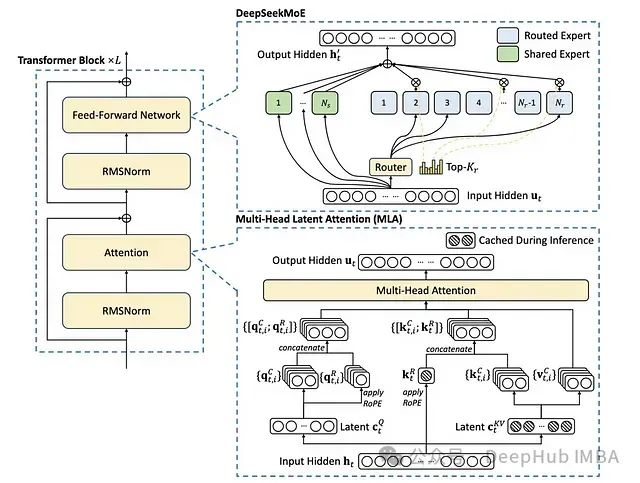

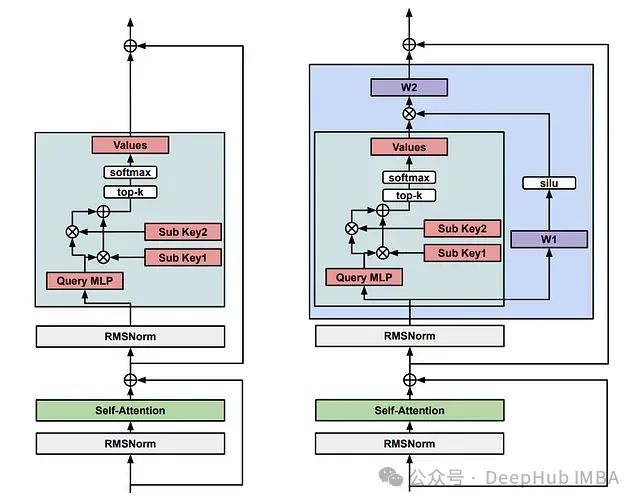

DeepSeek背后的技术基石:DeepSeekMoE基于专家混合系统的大规模语言模型架构

DeepSeekMoE是一种创新的大规模语言模型架构,通过整合专家混合系统(Mixture of Experts, MoE)、改进的注意力机制和优化的归一化策略,在模型效率与计算能力之间实现了新的平衡。

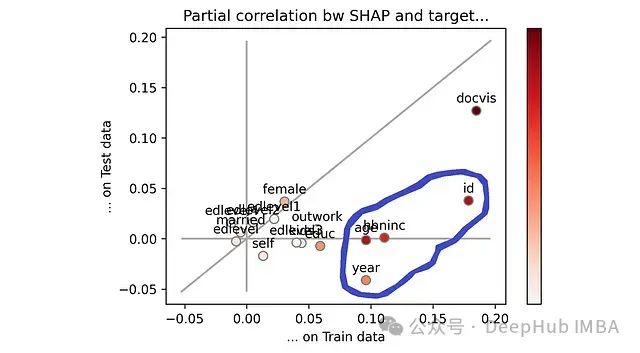

哪些特征导致过拟合?使用ParShap 方法精准定位导致模型泛化能力下降的关键特征

当模型在训练数据上表现良好,但在测试数据上表现不佳时,即出现“**过拟合**”。这意味着模型从训练数据中学习了过多的噪声模式,从而丧失了在新数据上的泛化能力。

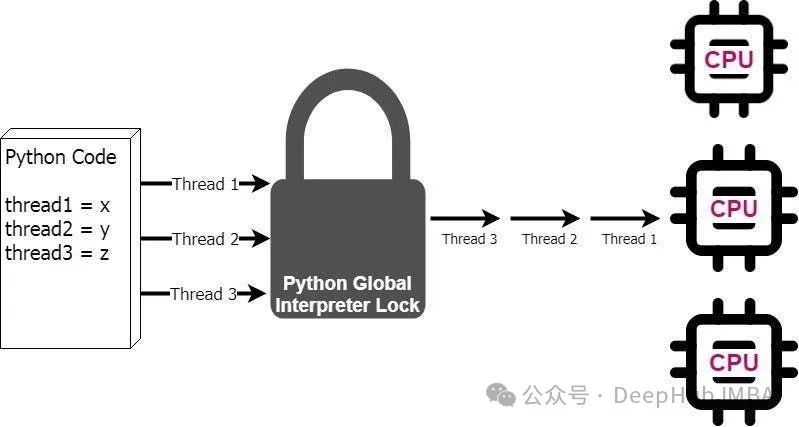

Python GIL(全局解释器锁)机制对多线程性能影响的深度分析

本文将主要基于CPython(用C语言实现的Python解释器,也是目前应用最广泛的Python解释器)展开讨论。

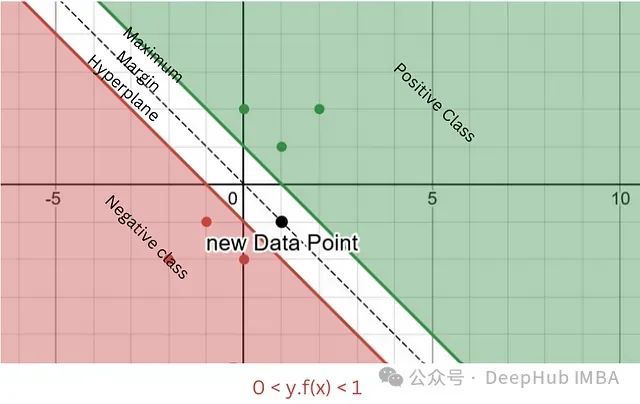

深入剖析SVM核心机制:铰链损失函数的原理与代码实现

铰链损失(Hinge Loss)是支持向量机(Support Vector Machine, SVM)中最为核心的损失函数之一。该损失函数不仅在SVM中发挥着关键作用,也被广泛应用于其他机器学习模型的训练过程中。

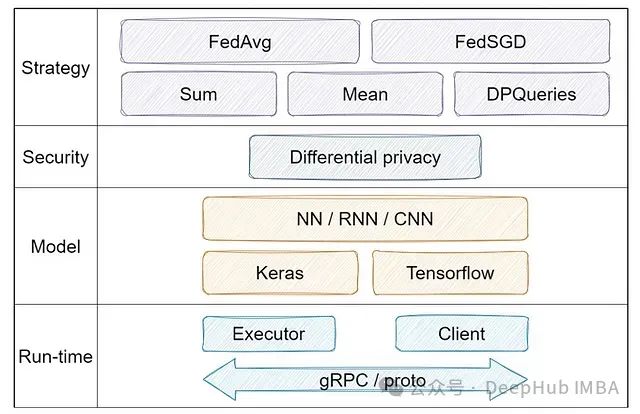

十大主流联邦学习框架:技术特性、架构分析与对比研究

联邦学习领域已发展出多个针对不同技术需求和应用场景的框架工具。这些工具在框架灵活性、使用便捷性和安全特性等方面各具特色。我们这里总结了10个联邦学习具有代表性框架

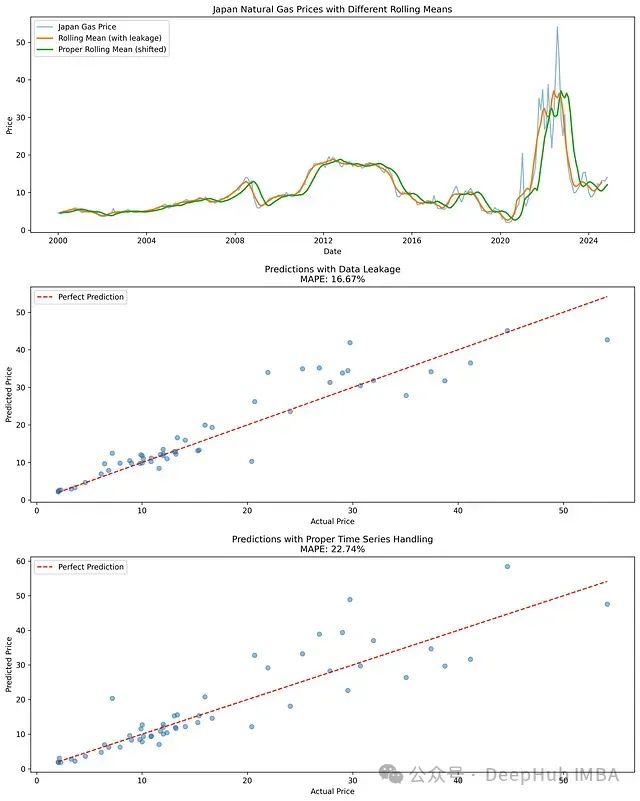

构建可靠的时间序列预测模型:数据泄露检测、前瞻性偏差消除与因果关系验证

在时间序列分析领域中,存在多种可能影响分析结果有效性的技术挑战。其中,数据泄露、前瞻性偏差和因果关系违反是最为常见且具有显著影响的问题。

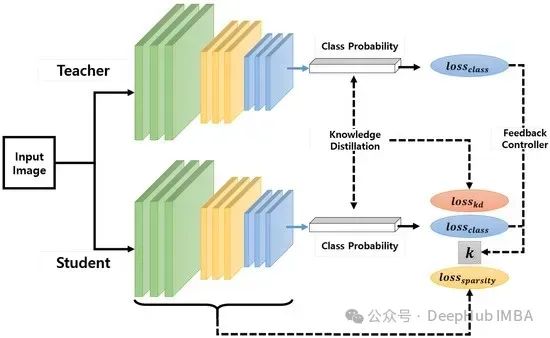

知识蒸馏技术原理详解:从软标签到模型压缩的实现机制

**知识蒸馏**是一种通过性能与模型规模的权衡来实现模型压缩的技术。其核心思想是将较大规模模型(称为教师模型)中的知识迁移到规模较小的模型(称为学生模型)中。本文将深入探讨知识迁移的具体实现机制。

Python高性能编程:五种核心优化技术的原理与Python代码

在性能要求较高的应用场景中,Python常因其执行速度不及C、C++或Rust等编译型语言而受到质疑。然而通过合理运用Python标准库提供的优化特性,我们可以显著提升Python代码的执行效率。

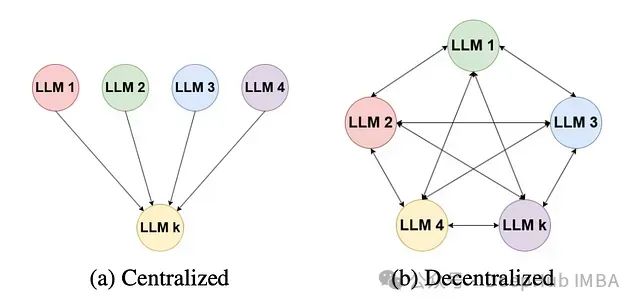

面向长文本的多模型协作摘要架构:多LLM文本摘要方法

论文提出的方法旨在处理长文本文档输入,这类文档可能包含数万字,通常超出大多数标准LLM的上下文窗口限制,论文建立了一个两阶段处理流程

Meta-CoT:通过元链式思考增强大型语言模型的推理能力

Meta-CoT 基于链式思考(CoT)方法,使 LLMs 不仅能够建模推理步骤,还能够模拟“思考”过程。这种转变类似于人类在面对难题时的探索、评估和迭代方式。

记忆层增强的 Transformer 架构:通过可训练键值存储提升 LLM 性能的创新方法

Meta 研究团队通过开发**记忆层**技术,成功实现了对现有大语言模型的性能提升。该技术通过替换一个或多个 Transformer 层中的前馈网络(FFN)来实现功能。

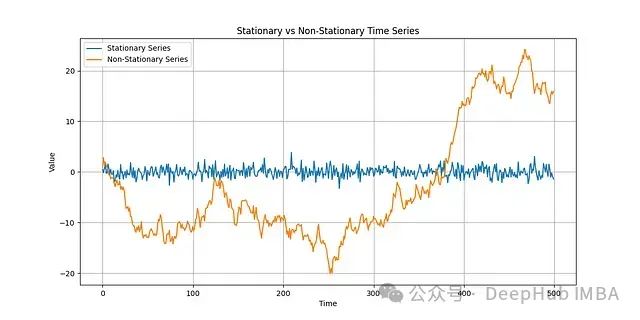

时间序列平稳性的双重假设检验:KPSS与ADF方法比较研究

本文将详细介绍如何运用 **KPSS 检验**和 **Dickey-Fuller 检验**来验证序列的平稳性。这两种检验方法基于不同的统计假设:KPSS 检验的原假设是数据非平稳,而 Dickey-Fuller 检验则假设数据平稳。

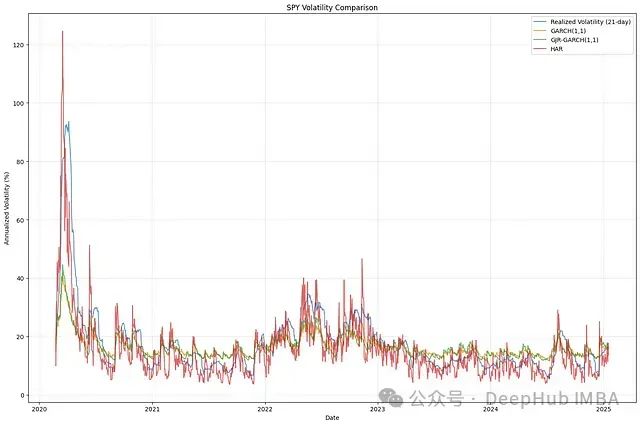

金融波动率的多模型建模研究:GARCH族与HAR模型的Python实现与对比分析

本文着重探讨三种主流波动率建模方法:广义自回归条件异方差模型(GARCH)、Glosten-Jagannathan-Runkle-GARCH模型(GJR-GARCH)以及异质自回归模型(HAR)

时间序列分析中的状态估计:状态空间模型与卡尔曼滤波的隐状态估计

状态空间模型通过构建生成可观测数据的潜在未观测状态模型来进行时间序列分析。作为该方法论的核心,卡尔曼滤波为实时估计这些隐状态提供了一个理论完备的解决方案。本文深入探讨这些方法的理论基础和实践应用,阐述其在多领域的适用性。