图像数据增强库综述:10个强大图像增强工具对比与分析

本文旨在全面介绍当前广泛使用的图像数据增强库,分析其特点和适用场景,以辅助研究人员和开发者选择最适合其需求的工具。

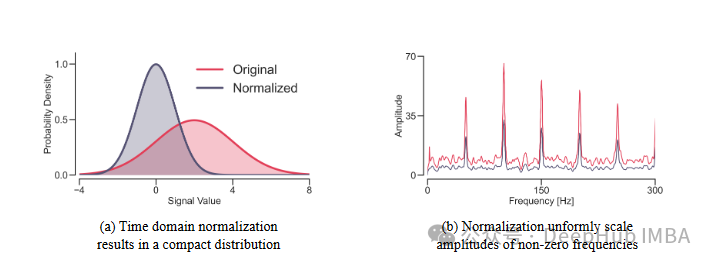

FredNormer: 非平稳时间序列预测的频域正则化方法

FredNormer的核心思想是从频率角度观察数据集,并自适应地增加关键频率分量的权重。

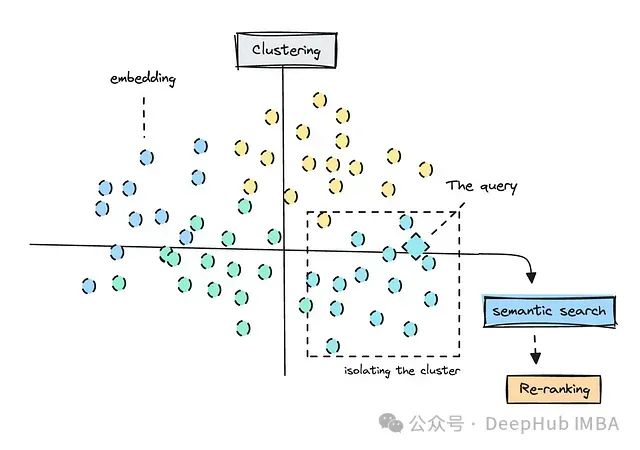

PAIRDISTILL: 用于密集检索的成对相关性蒸馏方法

成对相关性蒸馏(Pairwise Relevance Distillation, PAIRDISTILL)。

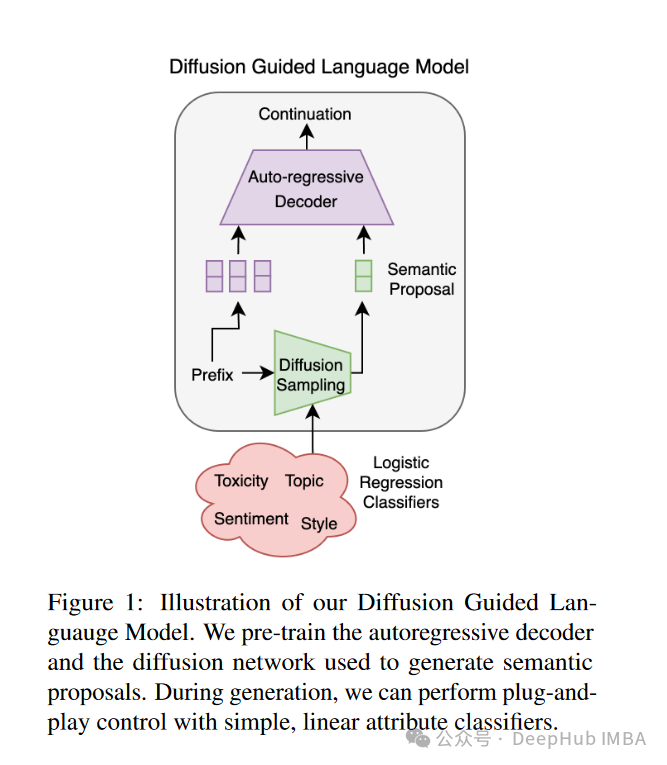

扩散引导语言建模(DGLM):一种可控且高效的AI对齐方法

扩散引导语言建模(Diffusion Guided Language Modeling, DGLM)。DGLM旨在结合自回归生成的流畅性和连续扩散的灵活性,为可控文本生成提供一种更有效的方法。

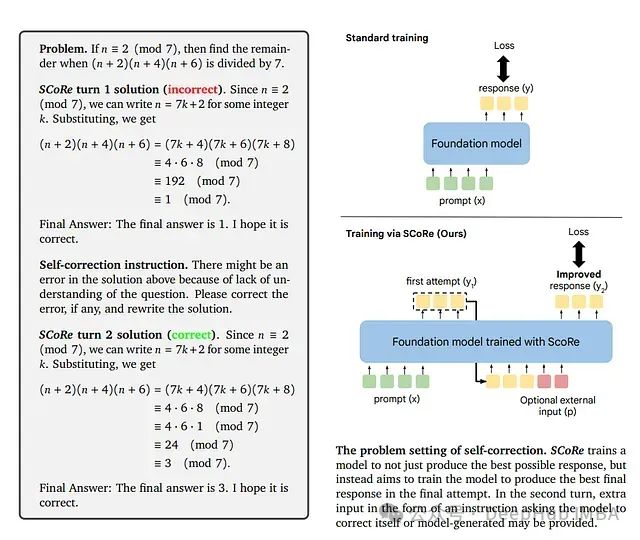

SCoRe: 通过强化学习教导大语言模型进行自我纠错

这是谷歌9月发布在arxiv上的论文,研究者们提出了一种新方法**自我纠错强化学习(SCoRe)**,旨在使大语言模型能够在没有任何外部反馈或评判的情况下"即时"纠正自己的错误。

VisionTS:基于时间序列的图形构建高性能时间序列预测模型,利用图像信息进行时间序列预测

本文将讨论以下几个方面: - 图像如何在内部编码序列信息? - 利用预训练计算机视觉模型进行时间序列分析的概念 - ***VisionTS***:一种适用于时间序列数据的预训练Vision Transformer模型。

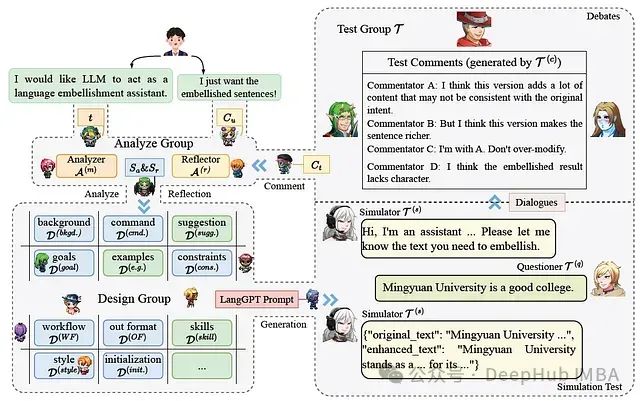

Minstrel自动生成结构化提示,让AI为AI写提示词的多代理提示生成框架

在人工智能快速发展的今天,如何有效利用大型语言模型(LLMs)成为了一个普遍关注的话题。这是9月份的一篇论文,提出了LangGPT结构化提示框架和Minstrel多代理提示生成系统,为非AI专家使用LLMs提供了强大支持。

在Pytorch中为不同层设置不同学习率来提升性能,优化深度学习模型

为网络的不同层设置不同的学习率可能会带来显著的性能提升。本文将详细探讨这一策略的实施方法及其在PyTorch框架中的具体应用

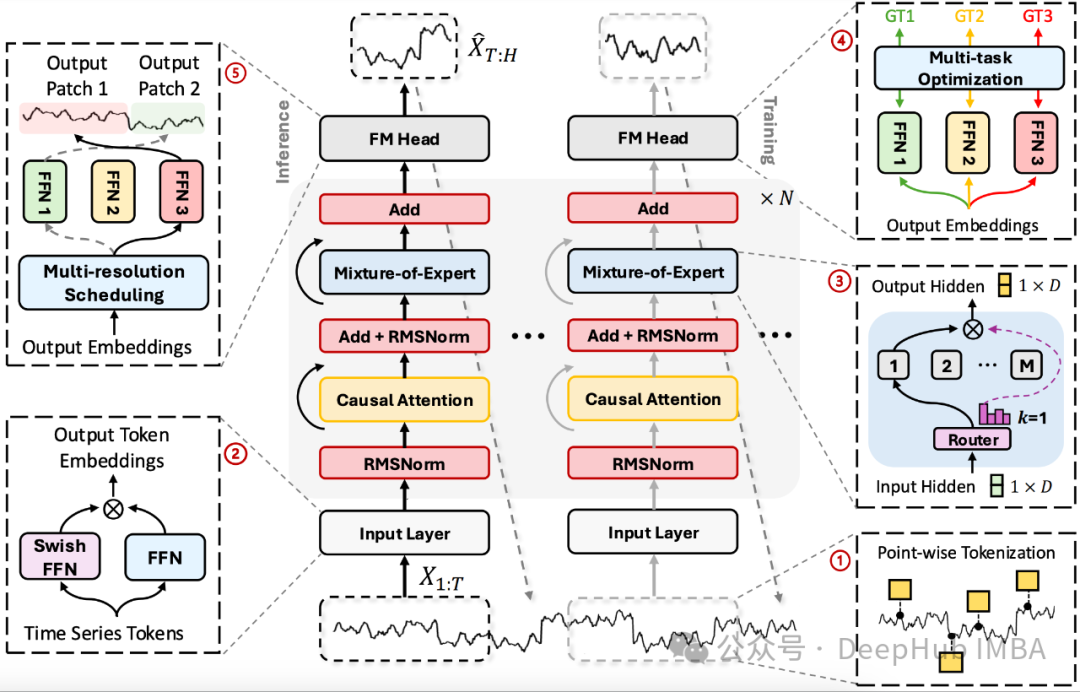

TimeMOE: 使用稀疏模型实现更大更好的时间序列预测

这是9月份刚刚发布的论文TimeMOE。它是一种新型的时间序列预测基础模型,"专家混合"(Mixture of Experts, MOE)在大语言模型中已经有了很大的发展,现在它已经来到了时间序列。

8种数值变量的特征工程技术:利用Sklearn、Numpy和Python将数值转化为预测模型的有效特征

特征工程通常涉及对现有数据应用转换,以生成或修改数据,这些转换后的数据在机器学习和数据科学的语境下用于训练模型,从而提高模型性能。

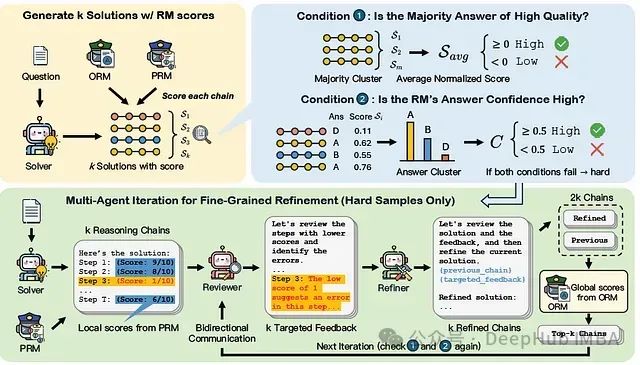

MAGICORE:基于多代理迭代的粗到细精炼框架,提升大语言模型推理质量

论文提出了MAGICORE,一个用于粗到细精炼的多代理迭代框架。MAGICORE旨在通过将问题分类为简单或困难,为简单问题使用粗粒度聚合,为困难问题使用细粒度和迭代多代理精炼,从而避免过度精炼。

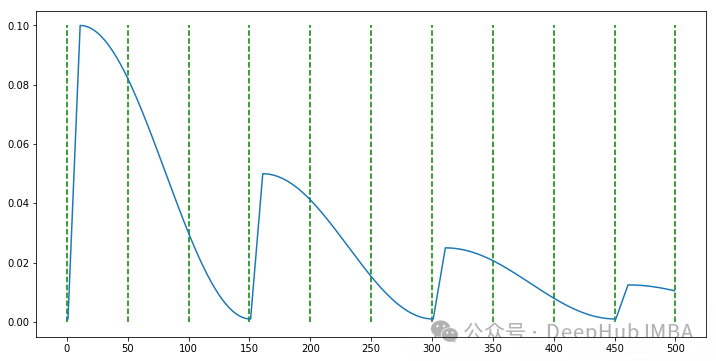

PyTorch自定义学习率调度器实现指南

本文将详细介绍如何通过扩展PyTorch的 ``` LRScheduler ``` 类来实现一个具有预热阶段的余弦衰减调度器。我们将分五个关键步骤来完成这个过程。

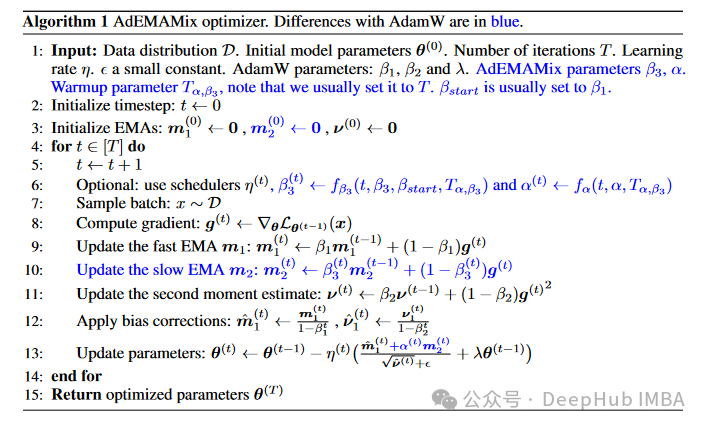

AdEMAMix: 一种创新的神经网络优化器

这种算法旨在解决当前广泛使用的Adam及其变体(如AdamW)在利用长期梯度信息方面的局限性。研究者们通过巧妙地结合两个不同衰减率的指数移动平均(EMA),设计出了这种新的优化器,以更有效地利用历史梯度信息。

PyTorch 模型调试与故障排除指南

本文旨在为 PyTorch 开发者提供一个全面的调试指南,涵盖从基础概念到高级技术的广泛内容。

使用GPU 加速 Polars:高效解决大规模数据问题

本文将详细讨论 Polars 中DF的概念、GPU 加速如何与 Polars DF协同工作,以及使用新的 CUDA 驱动执行引擎可能带来的性能提升。

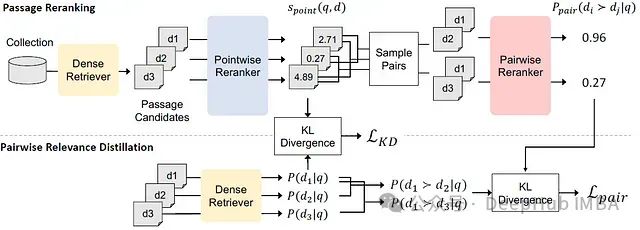

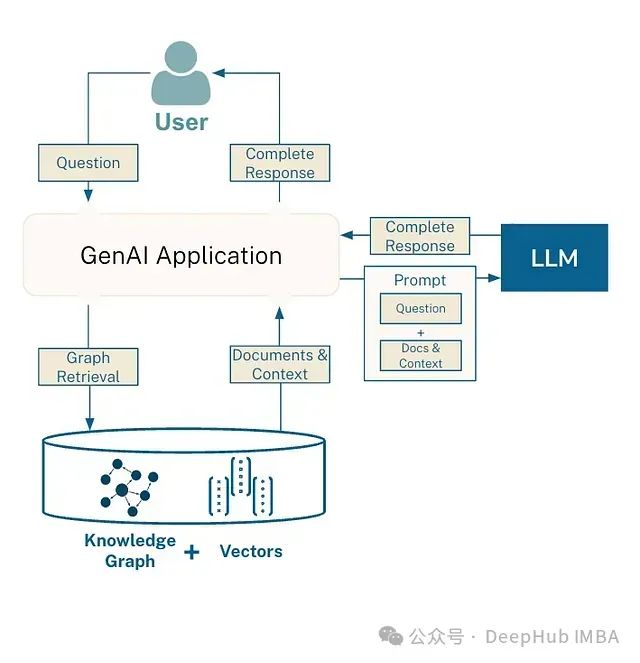

GraphRAG 与 RAG 的比较分析

Graph RAG 技术通过引入图结构化的知识表示和处理方法,显著增强了传统 RAG 系统的能力。它不仅提高了信息检索的准确性和完整性,还为复杂查询和多步推理提供了更强大的支持。

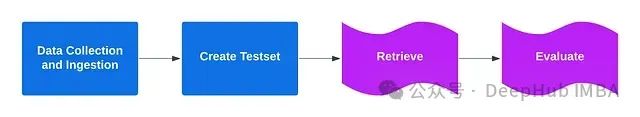

让模型评估模型:构建双代理RAG评估系统的步骤解析

我们将介绍一个基于双代理的RAG(检索增强生成)评估系统。该系统使用生成代理和反馈代理,基于预定义的测试集对输出进行评估。或者更简单的说,我们使用一个模型来评估另外一个模型的输出。

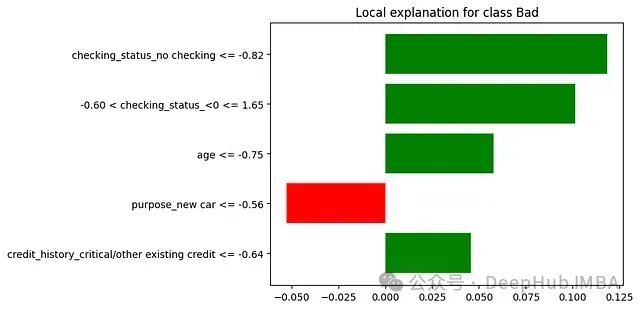

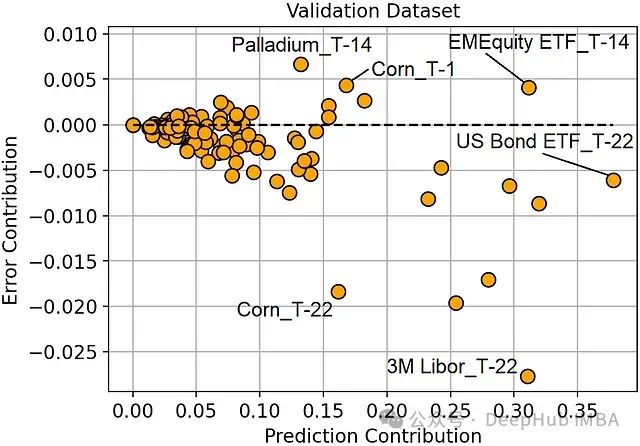

机器学习模型中特征贡献度分析:预测贡献与错误贡献

本文将探讨特征重要性与特征有效性之间的关系,并引入两个关键概念:预测贡献度和错误贡献度。