深度学习之语义分割算法(入门学习)

深度学习之语义分割算法(入门学习)。小海带近期对语义分割算法比较感兴趣,今后会不断学习以及更新深度学习图像分割领域的知识,感兴趣的小伙伴可以一起讨论交流哇!关于计算机视觉以及YOLO算法改进方面也会偶尔更新一下下,需要代码咨询的小伙伴可以随时给小海带留言喔 ~ 🤞 💕

【Google语音转文字】Speech to Text 超级好用的语音转文本API

Google speech to text api 语音转文本

DynaSLAM超详细安装配置运行ubantu20.0.4+opencv2.4.11+tensorflow1.4.0

DynaSLAM超详细安装配置运行ubantu20.0.4+opencv2.4.11+tensorflow1.4.0

Pointnet/Pointnet++学习

Pointnet++学习

R数据分析:临床预测模型中校准曲线和DCA曲线的意义与做法

之前给大家写过一个临床预测模型:R数据分析:跟随top期刊手把手教你做一个临床预测模型,里面其实都是比较基础的模型判别能力discrimination的一些指标,那么今天就再进一步,给大家分享一些和临床决策实际相关的指标,主要是校准calibration和决策曲线Decision curve ana

Pytorch深度学习实战3-7:详解数据加载DataLoader与模型处理

本文以MNIST手写数据集为例,图文讲解Pytorch中操作数据的核心类Dataset和DataLoader,介绍其基本原理和主要的数据预处理方法

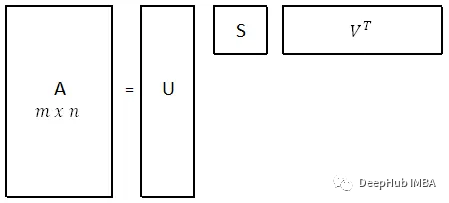

奇异值分解(SVD)和图像压缩

在本文中,我将尝试解释 SVD 背后的数学及其几何意义,还有它在数据科学中的最常见的用法,图像压缩。

【计算机视觉】目标检测—yolov5自定义模型的训练以及加载

yolov5如何自定义训练模型?如何加载模型并进行解读

HuggingFace——Accelerate的使用

HuggingFace----Accelerate的使用

目标检测算法——YOLOv5/YOLOv7改进之结合特征提取网络RFBNet(涨点明显)

计算机视觉——致力于目标检测领域科研Tricks改进与推荐 | 主要包括Backbone、Neck、Head、普通注意力机制、自注意力机制Transformer,各种IoU Loss损失函数、NMS及各类激活函数替换、轻量化网络改进、数据增强策略以及其他视觉顶会创新点改进等等。

paddlepaddle模型的保存和加载

主要介绍了动态图和静态图模型的保存以及模型的加载预测

深度学习:可视化方法(模型可视化,训练过程可视化,特征提取可视化)

深度学习可视化,pytorch(tensorboard/netron)

【Unet系列】(三)Unet++网络

Unet++主要是探索encoder和decoder需要多大的问题,以此为基础,提出了融合不同尺寸Unet结构的网络。创新点就是把不同尺寸的Uent结构融入到了一个网络里。

Instruction Tuning(FLAN、instructGPT、chatGPT)

首页最近被chatGPT刷屏,但翔二博主左看右看发现很多想法似乎都是一脉相通的,于是连夜从存档中找了一些文章尝试理一理它的理论路线。博主个人理解,它以更为embodied AI形式的指令作为输入,以训练/微调大规模的信息模型,并基于强化学习与真实世界做持续交互,已经很接近此处所提到的“数字超人”了。

stable-diffusion-webui教程(AI绘画真人教程)

stable-diffusion-webui教程(AI绘画真人教程)

Opencv学习之:将图片的值进行范围调整 cv2.normalize()

cv2.normalize()指定将图片的值放缩到 0-255 之间array = cv2.normalize(array,None,0,255,cv2.NORM_MINMAX)cv2.NORM_MINMAX :使用的放缩方式是 min_max 的方式其对应的原理是:x^=x−minmax−min∗

用Pytorch搭建一个房价预测模型

在此项目中,目的是预测爱荷华州Ames的房价,给定81个特征,描述了房子、面积、土地、基础设施、公共设施等。埃姆斯数据集具有分类和连续特征的良好组合,大小适中,也许最重要的是,它不像其他类似的数据集(如波士顿住房)那样存在潜在的红线或数据输入问题。在这里我将主要讨论PyTorch建模的相关方面,作为

基于OpenVINO在C++中部署YOLOv5-Seg实例分割模型

YOLOv5兼具速度和精度,工程化做的特别好,Git clone到本地即可在自己的数据集上实现目标检测任务的训练和推理,在产业界中应用广泛。开源社区对YOLOv5支持实例分割的呼声高涨,YOLOv5在v7.0中正式官宣支持实例分割。

YOLOV5-网络结构和组件介绍

总的来说在基本网络结构中,会对CSP网络的参数进行确定,而我们将用公式吧参数和给出的深度,宽度参数进行计算,从而算出残差次数的使用次数,也就控制了深度。采用上,下采样灵活的构造特征金字塔。在Yolov5中也是通过这样的方式 ,当时Yolov5采用了一个更好的方式,可以使得加灰边的大小尽可能的小,可以

神经网络中的常用算法-BN算法

但是当一张图片输入到神经网络经过卷积计算之后,这个分布就不会满足刚才经过image normalization操作之后的分布了,可能适应了新的数据分布规律,这个时候将数据接入激活函数中,很可能一些新的数据会落入激活函数的饱和区,导致神经网络训练的梯度消失,如下图所示当feature map的数据为1