目录

🍉引言

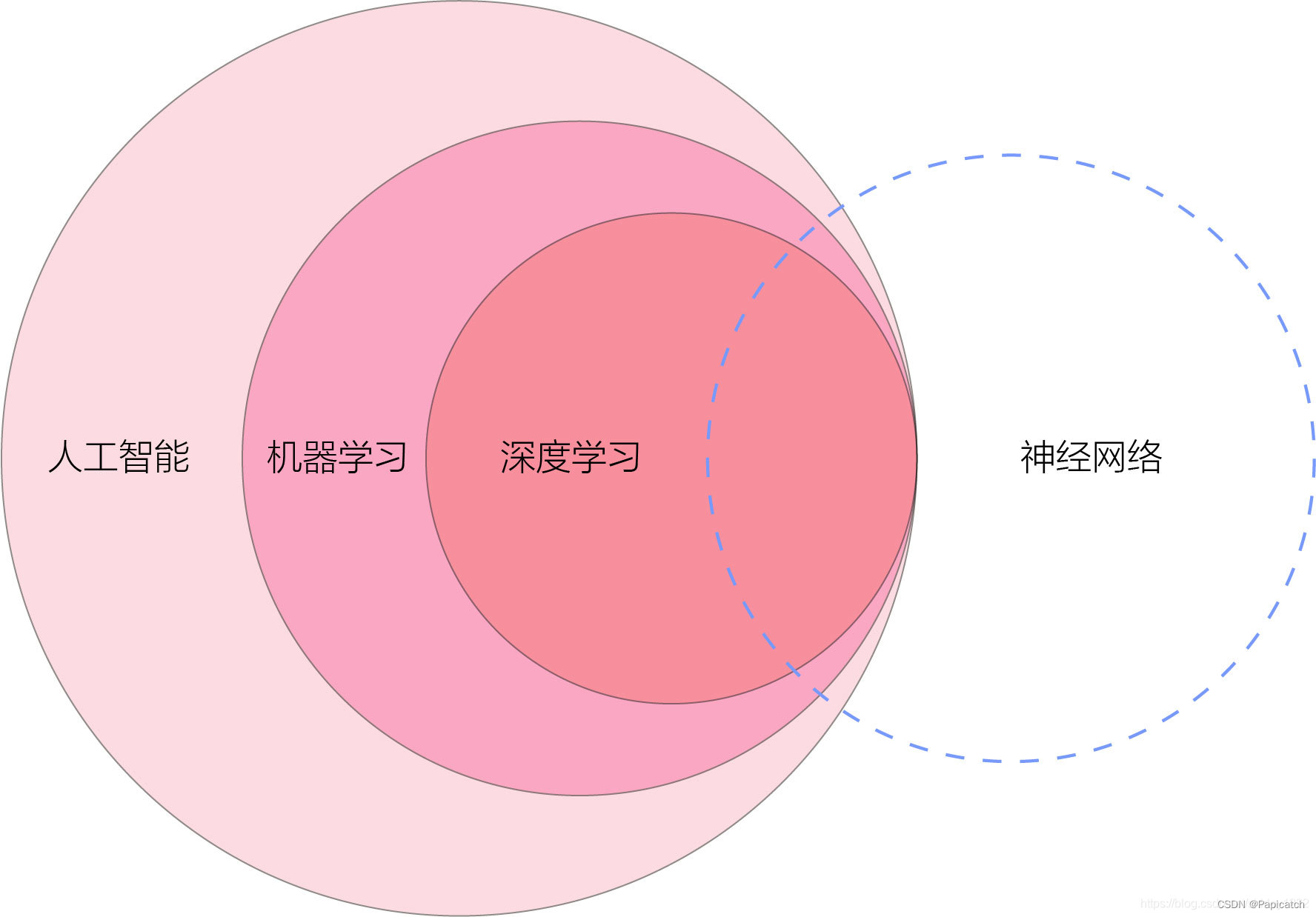

人工智能(AI)是计算机科学的一个分支,旨在模拟或仿效人类智能。深度神经网(DNN)是AI的一个子领域,因其在图像识别、语音识别、自然语言处理等方面的卓越表现而备受瞩目。本文将详细探讨深度神经网络的基本概念、结构、训练过程、应用领域及其面临的挑战,并结合现实示例进行分析。

🍉深度神经网络的基本概念

🍈神经网络的起源

- 神经网络的灵感来自于人脑的工作方式。人脑由大量的神经元组成,这些神经元通过突触连接,相互传递信息。人工神经网络(ANN)通过模拟这种结构,实现了对信息的处理和学习。

🍍** 神经网络的基本结构 **

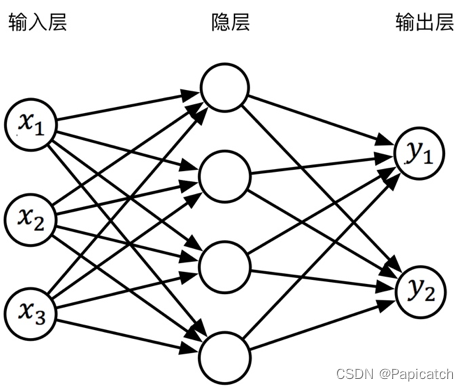

一个典型的神经网络由以下几个部分组成:

- 输入层:接收原始数据。

- 隐藏层:进行数据的特征提取和转换。

- 输出层:产生最终的预测结果。

- 每一层由多个神经元组成,神经元之间通过权重和偏置连接。网络的复杂性和能力与隐藏层的数量和神经元的数量密切相关。

🍉深度神经网络的结构

- 深度神经网络是指拥有多个隐藏层的神经网络。其复杂的层次结构使其能够提取和学习数据的多层次特征。

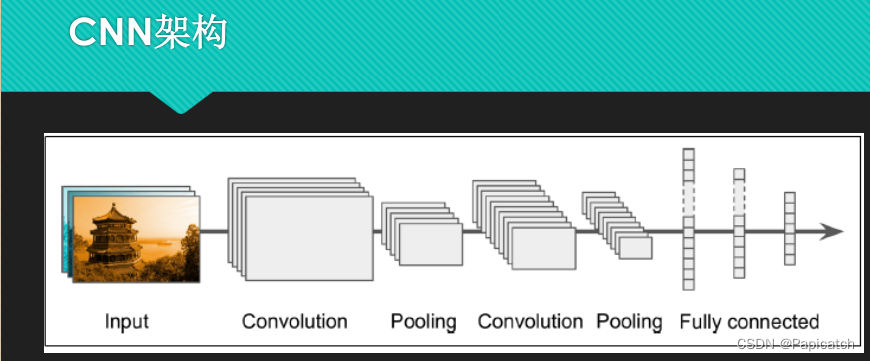

🍈 卷积神经网络(CNN)

CNN是用于处理图像数据的深度神经网络。其核心组件包括卷积层、池化层和全连接层。

- 卷积层:通过卷积核提取图像的局部特征。

- 池化层:进行下采样,减少数据量,同时保持主要特征。

- 全连接层:将提取的特征进行分类或回归。

CNN在图像识别、目标检测等领域表现卓越。例如,AlexNet在2012年的ImageNet竞赛中取得了突破性胜利,使得CNN在计算机视觉领域迅速普及。

🍈循环神经网络(RNN)

RNN用于处理序列数据,如时间序列和自然语言。其特点是具有记忆功能,能够处理前后相关的信息。

- 基本RNN:具有简单的循环结构,但容易出现梯度消失问题。

- 长短期记忆网络(LSTM)和门控循环单元(GRU):通过引入门控机制,有效缓解了梯度消失问题,显著提升了性能。

例如,Google翻译采用的序列到序列模型正是基于LSTM,实现了高质量的机器翻译。

🍉深度神经网络的训练过程

深度神经网络的训练过程包括以下几个步骤:

🍈数据准备

- 数据的质量和数量是影响神经网络性能的关键因素。通常需要进行数据预处理、数据增强等步骤,以提高训练效果。例如,在训练图像分类模型时,常用的数据增强技术包括旋转、缩放、裁剪等,以增加数据的多样性。

🍈前向传播

- 在前向传播过程中,输入数据经过每一层的神经元,逐层进行计算,最终输出预测结果。每个神经元的输出是输入的加权和加上偏置,再经过激活函数得到的。

🍈误差计算

- 通过损失函数计算预测结果与真实值之间的误差。常用的损失函数包括均方误差(MSE)、交叉熵损失等。

🍈反向传播

- 反向传播通过链式法则计算损失函数相对于每个权重和偏置的梯度,然后使用梯度下降算法更新参数。反向传播是训练深度神经网络的核心算法。

🍈优化算法

- 除了基本的梯度下降算法,还有许多优化算法,如随机梯度下降(SGD)、动量法、Adam优化器等,这些算法能够加速收敛,提升训练效果。例如,Adam优化器在训练大型深度神经网络时表现出色,广泛应用于各类深度学习任务中。

🍉深度神经网络的应用领域

深度神经网络因其强大的特征提取和学习能力,在多个领域得到了广泛应用。

🍈计算机视觉

- 计算机视觉是深度神经网络的一个重要应用领域。CNN在图像分类、目标检测、图像分割等任务中表现突出。例如,自动驾驶汽车依赖于CNN进行实时的道路场景分析和障碍物检测。

🍈自然语言处理

- RNN及其变种LSTM和GRU在自然语言处理(NLP)领域表现优异。它们被广泛应用于机器翻译、情感分析、文本生成等任务中。例如,OpenAI的GPT模型在生成自然语言文本方面表现出色,广泛应用于聊天机器人和文本生成工具中。

🍈 语音识别

- 深度神经网络在语音识别领域也取得了显著成果。卷积神经网络和循环神经网络被用于处理语音信号,实现了高精度的语音识别。例如,Apple的Siri、Google的Google Assistant等语音助手都是基于深度学习技术的。

🍈医疗诊断

- 深度神经网络在医疗诊断中被用于图像识别和疾病预测。例如,通过分析医学影像(如X光片、CT图像),深度学习算法可以辅助医生进行癌症检测和其他疾病的诊断。Google的DeepMind曾利用深度学习技术在糖尿病视网膜病变的检测中达到了与人类医生相当的准确率。

🍉深度神经网络面临的挑战

尽管深度神经网络在许多领域取得了成功,但其发展和应用仍面临诸多挑战。

🍈数据需求

- 深度神经网络的训练需要大量的高质量数据。然而,在许多实际应用中,数据的获取和标注成本高昂,且数据的数量和质量难以保证。比如,医疗领域的数据通常涉及隐私问题,难以大规模获取和共享。

🍈计算资源

- 训练深度神经网络需要大量的计算资源,特别是对大规模网络和大数据集的训练。这对计算设备的性能和能耗提出了高要求。例如,训练一个大型的语言模型可能需要数周时间和大量的GPU资源。

🍈模型解释性

- 深度神经网络通常被视为“黑箱”模型,其内部机制难以解释。这在一些需要高解释性的应用(如医疗诊断、金融预测)中,成为一个重大问题。例如,医生在使用AI辅助诊断时,常常需要理解模型的决策依据,而不仅仅是接受其结果。

🍈超参数调优

- 深度神经网络的训练涉及大量的超参数,如学习率、批量大小、网络层数等。这些超参数对模型性能有重大影响,但其选择往往依赖于经验和试错。例如,自动化机器学习(AutoML)技术正是为了解决这一问题,自动搜索最佳超参数组合。

🍈过拟合问题

- 深度神经网络容易发生过拟合,即在训练数据上表现良好,但在测试数据上表现不佳。解决过拟合问题需要采用正则化技术、数据增强等方法。例如,Dropout是一种常用的正则化技术,通过随机丢弃部分神经元来防止过拟合。

🍉未来发展方向

随着技术的发展,深度神经网络在未来有望在以下几个方面取得突破:

🍈小样本学习

- 通过少量的数据进行有效训练,是深度学习的一个重要研究方向。迁移学习、生成对抗网络(GAN)等技术在这方面显示出了潜力。例如,利用预训练模型进行迁移学习,可以在少量数据的情况下实现较好的性能。

🍈模型压缩与加速

- 在保持模型性能的前提下,进行模型的压缩与加速,以适应资源受限的应用场景。例如,模型剪枝、量化、蒸馏等技术正是为了解决这一问题。在移动设备上部署深度学习模型时,这些技术尤为重要。

🍈解释性与透明性

- 提高深度神经网络的解释性,使其内部机制更加透明。可解释AI(XAI)和可视化技术在这方面具有重要意义。例如,LIME和SHAP等技术可以帮助解释深度学习模型的决策过程,增强用户对模型的信任。

🍈跨模态学习

- 结合多种模态的数据(如图像、文本、语音)进行联合学习,将为深度学习带来新的发展机遇。跨模态学习可以增强模型的鲁棒性和泛化能力。例如,融合视觉和语言信息的多模态模型在视觉问答(VQA)等任务中表现出色。

🍉结论

- 深度神经网络作为人工智能的一个重要分支,展示了强大的特征提取和学习能力,在多个领域取得了显著成果。然而,其发展仍面临数据需求、计算资源、模型解释性等诸多挑战。未来,随着技术的不断进步,深度神经网络有望在小样本学习、模型压缩与加速、解释性与透明性、跨模态学习等方面取得新的突破,为人类社会带来更多的应用和价值。

希望这些可以对大家提供些帮助哦!!!

版权归原作者 Papicatch 所有, 如有侵权,请联系我们删除。